DINO ViT-S/16による視覚特徴抽出とK-meansクラスタリング Colab プログラムによる実験・研究スキルの基礎

【概要】DINO ViT-S/16モデルを用いて画像から視覚特徴を抽出し、K-meansクラスタリングにより自動的にグループ化するプログラムです。ラベル付けなしで画像の視覚的類似性に基づいた分類を実現し、結果を3次元散布図とグリッド表示で視覚化します。

Colabのページ(ソースコードと説明): https://colab.research.google.com/drive/134FIOIpkp2vVQi8WdBW-fMshoyLh6IIQ?usp=sharing

【目次】

プログラム利用ガイド

1. このプログラムの利用シーン

大量の画像を視覚的な類似性に基づいて自動的に分類したい場合に有用です。写真コレクションの整理、類似画像の検索、画像データセットの構造分析などに活用できます。ラベル付けの手間なく、画像の内容に基づいた自動グループ化を実現します。

2. 主な機能

- 画像特徴の自動抽出: アップロードした画像から、DINO ViT-S/16モデルを用いて視覚特徴を自動的に抽出します。

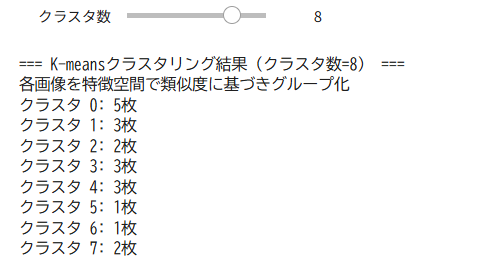

- クラスタリング: K-meansアルゴリズムにより、画像を指定した数のグループに分類します。クラスタ数は2から10(または画像枚数まで)の範囲で調整可能です。

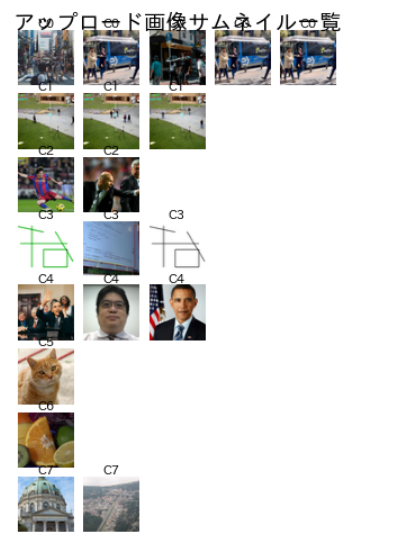

- 視覚化: クラスタリング結果をサムネイル画像のグリッド表示と3次元散布図の2つの形式で確認できます。

- インタラクティブな調整: スライダーを使ってクラスタ数を変更すると、即座に結果が更新されます。

3. 基本的な使い方

- Google Colabでコードセルを実行.必要なライブラリがインストールされる。

- デモの実行: プログラムを最初から実行すると、サンプル画像が自動的にダウンロードされ、クラスタリングのデモが表示されます。

- 画像のアップロード: ファイル選択画面が表示されたら、分類したい画像を複数選択してアップロードします。

- クラスタ数の調整: 画面に表示されるスライダーを操作して、クラスタ数を変更します。変更すると、グリッド表示と3次元散布図が自動的に更新されます。

- 結果の確認: グリッド表示で各クラスタに属する画像を確認し、3次元散布図で特徴空間における画像の配置を確認します。

Colabのページ(ソースコードと説明): https://colab.research.google.com/drive/134FIOIpkp2vVQi8WdBW-fMshoyLh6IIQ?usp=sharing

4. 便利な機能

- GPU加速: CUDAが利用可能な環境では自動的にGPUを使用し、処理を高速化します。

- 累積寄与率の表示: PCAによる次元削減後、どの程度の情報が保持されているかを数値で確認できます。

- クラスタサイズの表示: 各クラスタに属する画像の枚数がテキストとグラフの両方で表示されます。

- インタラクティブな3次元プロット: Plotlyにより、3次元散布図を回転・拡大して多角的に観察できます。各点にマウスカーソルを合わせると画像ファイル名が表示されます。

- クラスタ中心の可視化: 3次元散布図上にクラスタの中心点が黒いダイヤモンド形状で表示され、各グループの代表的な特徴位置を把握できます。

プログラムコードの説明

1. 概要

このプログラムは、DINO(Self-Distillation with NO labels)で訓練されたVision Transformer(ViT-S/16)を用いて画像から視覚特徴を抽出し、K-meansクラスタリングにより画像を自動的にグループ化します。ラベル付けを必要とせず、画像の視覚的類似性に基づいて分類を行います。

2. 主要技術

DINO(Self-Distillation with NO labels)

DINOは、Caron et al.(2021)が開発した自己教師あり学習手法です[1]。教師ネットワークと学生ネットワークの2つを用い、ラベルなしで視覚特徴を学習します。画像の異なる変換に対して同じ表現を予測するように訓練され、セマンティックセグメンテーション情報を明示的に含む特徴を獲得します。モーメンタムエンコーダを用いた教師ネットワークの更新、マルチクロップ訓練、出力の中心化とシャープ化によって訓練の崩壊を防ぐといった技術的工夫により、ImageNetにおいて80.1%のtop-1精度を達成しています。

Vision Transformer(ViT)

Vision Transformerは、Dosovitskiy et al.(2021)が提案した画像認識のためのTransformerアーキテクチャです[2]。画像を固定サイズのパッチ(本プログラムでは16×16ピクセル)に分割し、各パッチを線形変換して埋め込みベクトルに変換します。これらのパッチ埋め込みに位置埋め込みを加え、Transformerエンコーダに入力することで、畳み込みニューラルネットワークに依存せずに画像の特徴を抽出します。自己注意機構により、画像の局所的特徴とグローバルな特徴の両方を学習できます。

3. 技術的特徴

- 自己教師あり学習による特徴抽出: DINOで事前訓練されたViT-S/16モデルを使用し、人手によるラベル付けなしで学習された視覚特徴を活用します。このモデルは384次元の特徴ベクトルを出力します。

- 主成分分析による次元削減: 抽出された384次元の特徴ベクトルに対してPCA(主成分分析)を適用し、最大50次元まで次元を削減します。これにより、計算コストを削減しながら、累積寄与率により情報量の保持率を確認できます。

- K-meansクラスタリング: 次元削減後の特徴ベクトルに対してK-meansアルゴリズムを適用し、画像を指定されたクラスタ数にグループ化します。特徴空間における類似度に基づいて画像を分類します。

- 3次元可視化: PCAで得られた主成分のうち上位3次元を用いて、画像の特徴空間を3次元散布図として可視化します。各軸の寄与率も表示され、次元削減による情報損失を把握できます。

4. 実装の特色

Google Colab環境での実行を想定した実装であり、以下の特徴を備えます。

- デモ用サンプル画像の自動ダウンロード機能

- ユーザーによる複数画像のアップロード機能

- インタラクティブなクラスタ数調整(ipywidgetsを使用)

- サムネイル画像のグリッド表示によるクラスタリング結果の視覚化

- Plotlyを用いた3次元インタラクティブ散布図

- GPU/CPU自動選択による処理の柔軟性

- 日本語による説明とグラフ表示(japanize-matplotlibを使用)

5. 参考文献

[1] Caron, M., Touvron, H., Misra, I., Jégou, H., Mairal, J., Bojanowski, P., & Joulin, A. (2021). Emerging Properties in Self-Supervised Vision Transformers. Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV), 9650-9660. https://arxiv.org/abs/2104.14294

[2] Dosovitskiy, A., Beyer, L., Kolesnikov, A., Weissenborn, D., Zhai, X., Unterthiner, T., Dehghani, M., Minderer, M., Heigold, G., Gelly, S., Uszkoreit, J., & Houlsby, N. (2021). An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale. International Conference on Learning Representations (ICLR). https://arxiv.org/abs/2010.11929

実験・研究スキルの基礎:Google Colabで学ぶ画像クラスタリング実験

1. 実験・研究のスキル構成要素

実験や研究を行うには、以下の5つの構成要素を理解する必要がある。

1.1 実験用データ

このプログラムでは画像ファイルが実験用データである。プログラムはサンプル画像とユーザーがアップロードした画像の両方を処理できる。

1.2 実験計画

何を明らかにするために実験を行うのかを定める。

計画例:

- クラスタ数が画像のグループ化に与える影響を確認する

- 視覚的に類似した画像が同じクラスタに分類されるか検証する

- 特徴空間における画像の分布パターンを観察する

- 異なる種類の画像(動物、食品、乗り物など)の分離状況を調べる

- クラスタ中心と各画像の距離関係を分析する

1.3 プログラム

実験を実施するためのツールである。このプログラムはDINO ViT-S/16モデルによる特徴抽出、主成分分析による次元削減、K-meansアルゴリズムによるクラスタリング、ipywidgetsのinteract関数による対話的な可視化を使用している。

- プログラムの機能を理解して活用することが基本である

- 基本となるプログラムを出発点として、将来、様々な機能を自分で追加することができる

1.4 プログラムの機能

このプログラムは画像を特徴ベクトルに変換し、類似度に基づいてグループ化する。

入力パラメータ:

- クラスタ数:画像を分類するグループの数(2~10または画像枚数の少ない方)

処理の流れ:

- 画像を224×224ピクセルにリサイズし、正規化を適用

- DINO ViT-S/16モデルで各画像を384次元の特徴ベクトルに変換

- 主成分分析で特徴ベクトルを削減(最大50次元、画像枚数により変動)

- 削減された特徴空間においてK-meansアルゴリズムでクラスタリングを実行

- 可視化のため上位3次元の主成分を使用

出力情報:

- 各クラスタに含まれる画像枚数の統計

- クラスタごとに整列されたサムネイル画像の一覧

- 特徴空間の3次元可視化(各軸は主成分とその寄与率)

- クラスタ中心の位置

スライダーの動作:

- クラスタ数スライダーを動かすと即座にクラスタリングが再実行され、結果が更新される

1.5 検証(結果の確認と考察)

プログラムの実行結果を観察し、クラスタ数の影響を考察する。

基本認識:

- クラスタ数を変えると画像のグループ化が変わる。その変化を観察することが実験である

- 「良い結果」「悪い結果」は目的によって異なる。画像の内容や分析の目的に応じて適切なクラスタ数は変化する

観察のポイント:

- 視覚的に類似した画像が同じクラスタに分類されているか

- 各クラスタ内の画像枚数のバランスは適切か(極端に偏っていないか)

- クラスタ数を増やすと分類の細分化はどのように進むか

- 3次元プロット上でクラスタ間の距離は十分に離れているか

- 主成分の累積寄与率は十分に高いか(情報の保持度)

- クラスタ中心の位置は各クラスタの画像分布を適切に代表しているか

2. 間違いの原因と対処方法

2.1 プログラムのミス(人為的エラー)

プログラムがエラーで停止する

- 原因:必要なライブラリがインストールされていない、または構文エラーがある

- 対処方法:エラーメッセージを確認し、提供されたコードと比較する。特にライブラリのインストールコマンドが正しく実行されたか確認する

モデルのダウンロードに時間がかかる

- 原因:初回実行時にDINO ViT-S/16モデルをダウンロードしている

- 対処方法:これは正常な動作である。ダウンロードが完了するまで待つ(通常数分程度)

画像のアップロードに失敗する

- 原因:ファイル形式が対応していない、またはファイルサイズが大きすぎる

- 対処方法:JPEG、PNG形式の画像を使用する。極端に大きい画像は事前にリサイズする

2.2 期待と異なる結果が出る場合

クラスタ数を変えても分類結果がほとんど変化しない

- 原因:画像が視覚的に非常に類似している、または画像枚数が少なすぎる

- 対処方法:より多様な画像を追加する。異なる種類の画像を十分な枚数用意することが望ましい

視覚的に異なる画像が同じクラスタに分類される

- 原因:クラスタ数が少なすぎる、または画像が特徴空間では類似している

- 対処方法:クラスタ数を増やして観察する。人間の視覚的判断と機械学習モデルの特徴抽出は必ずしも一致しない。これは正常な動作であり、モデルの特性を理解する機会である

視覚的に類似した画像が異なるクラスタに分類される

- 原因:クラスタ数が多すぎる、またはK-meansの初期値配置によるランダム性の影響

- 対処方法:クラスタ数を減らして観察する。K-meansの初期値配置にはランダム性があるが、本プログラムではrandom_stateを固定しているため再現性は保証されている

特定のクラスタに画像が集中する

- 原因:画像の多様性が不足している、またはクラスタ数が多すぎる

- 対処方法:これは正常な動作である。実データでは画像の分布が均等でないことが多い。クラスタ数を調整して最適なバランスを探る

3次元プロットでクラスタが重なって見える

- 原因:3次元への次元削減により情報が失われている、または画像が本質的に類似している

- 対処方法:これは次元削減による情報損失である。累積寄与率を確認し、3次元でどの程度の情報が保持されているか把握する。累積寄与率が高ければ傾向の把握には十分である

3. 実験レポートのサンプル

注:以下の実験結果の数値はすべて架空の値である。実際の実験では自分で取得したデータを記載する。

画像の種類による最適クラスタ数の調査

実験目的:

動物、食品、乗り物の3種類の画像を含むデータセットにおいて、各種類を適切に分離できる最適なクラスタ数を見つける。

実験計画:

各種類からxxxx枚ずつ、合計xxxx枚の画像を用意し、クラスタ数をxxxxからxxxxまで変化させて分類結果を評価する。

実験方法:

プログラムを実行し、スライダーを操作しながら以下の基準で評価する:

- 純度:各クラスタ内で最も多い画像種類の割合

- 分離度:異なる種類の画像が異なるクラスタに分類された割合

- バランス:各クラスタの画像枚数の均等性

実験結果:

| クラスタ数 | 動物画像の分布 | 食品画像の分布 | 乗り物画像の分布 | 平均純度 | 総合評価 |

|---|---|---|---|---|---|

| xxxx | クラスタ0: xxxx枚、クラスタ1: xxxx枚 | クラスタ0: xxxx枚、クラスタ1: xxxx枚 | クラスタ0: xxxx枚、クラスタ1: xxxx枚 | xxxx% | 不十分な分離 |

| xxxx | クラスタ0: xxxx枚、クラスタ1: xxxx枚、クラスタ2: xxxx枚 | クラスタ0: xxxx枚、クラスタ1: xxxx枚、クラスタ2: xxxx枚 | クラスタ0: xxxx枚、クラスタ1: xxxx枚、クラスタ2: xxxx枚 | xxxx% | 良好な分離 |

| xxxx | クラスタ0: xxxx枚、クラスタ1: xxxx枚、クラスタ2: xxxx枚、クラスタ3: xxxx枚 | クラスタ0: xxxx枚、クラスタ1: xxxx枚、クラスタ2: xxxx枚、クラスタ3: xxxx枚 | クラスタ0: xxxx枚、クラスタ1: xxxx枚、クラスタ2: xxxx枚、クラスタ3: xxxx枚 | xxxx% | 過剰な細分化 |

| xxxx | クラスタ0: xxxx枚、クラスタ1: xxxx枚、クラスタ2: xxxx枚、クラスタ3: xxxx枚、クラスタ4: xxxx枚 | クラスタ0: xxxx枚、クラスタ1: xxxx枚、クラスタ2: xxxx枚、クラスタ3: xxxx枚、クラスタ4: xxxx枚 | クラスタ0: xxxx枚、クラスタ1: xxxx枚、クラスタ2: xxxx枚、クラスタ3: xxxx枚、クラスタ4: xxxx枚 | xxxx% | 過剰な細分化 |

考察:

- (例文)クラスタ数xxxxでは画像種類の数(xxxx種類)よりも少ないため、複数の種類が同じクラスタに混在した。特に動物と食品の分離が不十分であった

- (例文)クラスタ数xxxxでは各画像種類がほぼ完全に異なるクラスタに分類された。高い平均純度は良好な分離性能を示している。3次元プロット上でもxxxx個のクラスタが明確に分離していることが確認できた

- (例文)クラスタ数xxxx以上では動物画像がさらに細分化されたが、これは画像種類の分類という目的には不要な細分化である。クラスタ間の距離が近くなり、分類の意味が不明瞭になった

- (例文)クラスタ数を増やすほど各クラスタの画像枚数が減少し、統計的な安定性が低下する傾向が見られた

結論:

(例文)本実験のデータセットにおいては、クラスタ数xxxxが最も適切な設定であった。これは画像の種類数と一致しており、各種類を高い純度で分離できた。クラスタ数は分類対象のカテゴリ数に合わせて設定することが重要である。ただし、実際の応用では事前にカテゴリ数が不明な場合も多いため、複数のクラスタ数で実験を行い、クラスタ内の純度とクラスタ間の分離度のバランスから最適値を決定する必要がある。

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)