Gaze-LLE 注視点推定 Colab プログラムによる実験・研究スキルの基礎

【概要】画像内の人物の視線方向を自動検出し、注視点をヒートマップと矢印で可視化するプログラムである。Gaze-LLEモデルとDINOv2エンコーダを用いて、複数人物の視線を高精度に推定し、フレーム内スコアによる信頼性評価と統合可視化機能を提供する。

Colabのページ(ソースコードと説明): https://colab.research.google.com/drive/1pOd8ZHB9sP2Ld8v1Ce10qpbPBAYmlIMa?usp=sharing

【目次】

プログラム利用ガイド

1. このプログラムの利用シーン

画像内の人物がどこを見ているかを自動的に検出し、視線方向を可視化するためのプログラムである。複数人物が写った写真において、各人物の注意が向いている対象や領域を分析する際に利用できる。

2. 主な機能

- 顔検出:画像内の人物の顔を自動検出する。

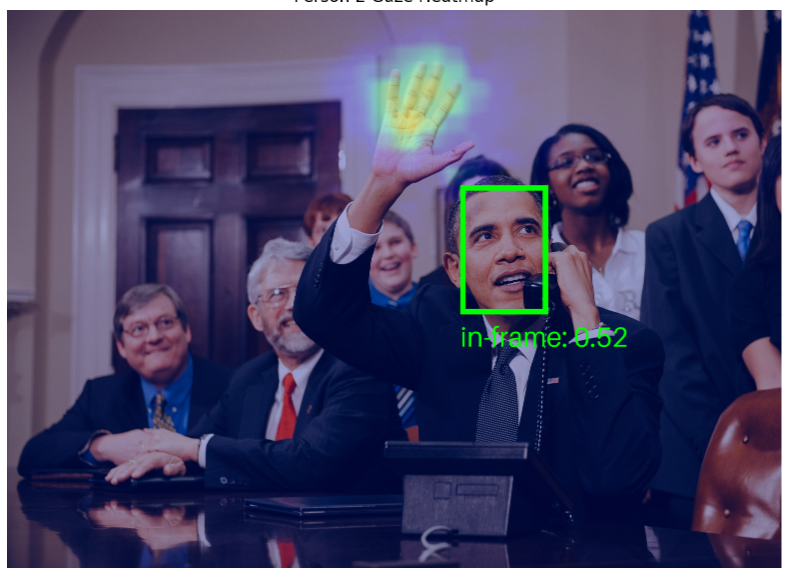

- 視線ヒートマップ生成:各人物が見ている可能性が高い領域を色で表示する(赤色が最も確率が高い領域)。

- フレーム内スコアの算出:視線がフレーム内を向いている確率を0から1の数値で表示する。

- 注視点の表示:視線がフレーム内を向いている場合(スコア0.5以上)、顔の中心から注視点への矢印を描画する。

- 複数人物の統合表示:複数人物を異なる色で区別しながら、すべての視線方向を1つの画像に表示する。

3. 基本的な使い方

- プログラムの実行:Google Colabでコードセルを実行

Colabのページ(ソースコードと説明): https://colab.research.google.com/drive/1pOd8ZHB9sP2Ld8v1Ce10qpbPBAYmlIMa?usp=sharing

- まず公式サンプル画像での処理結果が表示される。

- 画像のアップロード:「画像ファイルを1つアップロードしてください」というメッセージが表示されたら、分析したい画像ファイルを選択する。

- 結果の確認:アップロードした画像について、以下の情報が表示される。

- 検出された顔の数

- 各人物のフレーム内スコア(0から1の数値)

- 各人物の視線ヒートマップ(個別表示)

- 全人物の視線を統合した可視化画像

4. 便利な機能

- 色分け表示:統合可視化では、人物ごとに異なる色(緑、赤、シアン、マゼンタ、黄色)で顔の枠と視線方向が表示される。

- スコアの確認:各人物の顔枠の下に「in-frame」スコアが表示され、視線がフレーム内を向いている確率を数値で確認できる。

- 矢印による視線方向表示:フレーム内スコアが0.5以上の人物については、顔の中心から注視点への矢印が描画され、視線方向が直感的に理解できる。

- 注視点マーク:各人物が見ている可能性が最も高い位置に、人物ごとの色で小さな円が表示される。

プログラムコードの説明

1. 概要

このプログラムは、画像内の人物の視線を推定し、注視点をヒートマップと矢印で可視化する。顔検出により人物の顔領域を特定し、各人物について視線がフレーム内を向いているかの判定と、注視点の確率分布を算出する。

2. 主要技術

Gaze-LLE (Gaze estimation via Large-scale Learned Encoders)

Ryan et al.が提案した視線推定モデル[1]。事前学習済みのDINOv2エンコーダを凍結したまま利用し、軽量な視線デコーダのみを学習する構造を持つ。従来手法と比較して1から2桁少ないパラメータ数で視線推定を実現する。

DINOv2 (self-DIstillation with NO labels v2)

Oquab et al.がMeta AIで開発した自己教師あり学習による視覚特徴抽出モデル[2]。1億4,200万枚の画像から学習したVision Transformerであり、ラベルなしで汎用的な視覚特徴を獲得する。

3. 技術的特徴

- 凍結したバックボーンを用いるアーキテクチャ:DINOv2エンコーダを凍結し、軽量デコーダのみを学習する設計により、深度や姿勢などの補助入力を必要としない。

- ヘッドプロンプティング:各人物の頭部位置に対応する位置埋め込みをシーン特徴に加えることで、複数人物が存在する画像で個別の視線推定を実現する。

- 単一ストリーム設計:シーン全体から1つの特徴表現を抽出し、複数人物の視線を推定する。従来の多分岐アーキテクチャと異なり、シーンエンコーダと頭部エンコーダを統合する。

- フレーム内外判定機能:視線がフレーム内を向いているか否かを0から1のスコアで出力する補助タスクを備える。

4. 実装の特色

プログラムは以下の処理フローで動作する。

- RetinaFace[3]による顔領域検出と顔座標の正規化

- 検出された各顔領域に対するヒートマップ生成(64×64の解像度)

- ヒートマップの最大値位置から注視点座標を算出

- 視線方向を顔中心から注視点への矢印として描画(フレーム内スコアが0.5以上の場合)

- 複数人物を色分けして同時表示する統合可視化機能

5. 参考文献

[1] Ryan, F., Bati, A., Lee, S., Bolya, D., Hoffman, J., & Rehg, J. M. (2025). Gaze-LLE: Gaze Target Estimation via Large-Scale Learned Encoders. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. https://arxiv.org/abs/2412.09586

[2] Oquab, M., Darcet, T., Moutakanni, T., Vo, H., Szafraniec, M., Khalidov, V., ... & Bojanowski, P. (2023). DINOv2: Learning Robust Visual Features without Supervision. arXiv preprint arXiv:2304.07193. https://arxiv.org/abs/2304.07193

[3] Deng, J., Guo, J., Ververas, E., Kotsia, I., & Zafeiriou, S. (2020). RetinaFace: Single-shot multi-level face localisation in the wild. Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition, 5203-5212. https://arxiv.org/abs/1905.00641

実験・研究スキルの基礎:Google Colabで学ぶ視線推定実験

1. 実験・研究のスキル構成要素

実験や研究を行うには、以下の5つの構成要素を理解する必要がある。

1.1 実験用データ

このプログラムでは人物が写った画像ファイルが実験用データである。

1.2 実験計画

何を明らかにするために実験を行うのかを定める。

計画例:

- 複数人物が存在する画像において、各人物の視線方向が正しく推定されるか確認する

- フレーム内スコアの閾値(0.5)が視線方向表示の有無に与える影響を確認する

- 人物の顔の向きや角度が視線推定の精度に与える影響を調べる

- 画像内の人物配置(距離、重なり)が推定結果に与える影響を観察する

- ヒートマップの分布パターンと実際の注視対象の関係を分析する

1.3 プログラム

実験を実施するためのツールである。このプログラムはGaze-LLEモデルとRetinaFace顔検出を使用している。

- プログラムの機能を理解して活用することが基本である

- 基本となるプログラムを出発点として、将来、様々な機能を自分で追加することができる

1.4 プログラムの機能

このプログラムは画像内の人物の視線を自動的に推定し、可視化する。

入力データ:

- 人物が写った画像ファイル(JPG、PNG等)

出力情報:

- 検出された顔の数

- 各人物のフレーム内スコア(0から1の数値、視線がフレーム内を向いている確率)

- 各人物の視線ヒートマップ(個別表示、赤色が注視確率の高い領域)

- 全人物の視線を統合した可視化画像(矢印と注視点マーク付き)

処理の流れ:

- RetinaFaceによる顔検出が実行される

- 検出された各顔に対してGaze-LLEモデルが視線ヒートマップを生成する

- フレーム内スコアが0.5以上の人物について、顔中心から注視点への矢印が描画される

1.5 検証(結果の確認と考察)

プログラムの実行結果を観察し、視線推定の特性を考察する。

基本認識:

- 異なる画像を使用すると結果が変わる。その変化を観察することが実験である

- 「正しい視線推定」は実際の注視対象と一致することを意味する

観察のポイント:

- 検出された顔の数は画像内の人物数と一致しているか

- フレーム内スコアは妥当か(人物が明らかにフレーム内を見ている場合に高い値になっているか)

- ヒートマップの赤色領域は実際の注視対象付近に集中しているか

- 矢印の方向は人物の視線方向と一致しているか

- 複数人物が同じ対象を見ている場合、注視点が近い位置に表示されているか

- 顔の向きや角度が極端な場合、推定精度はどう変化するか

2. 間違いの原因と対処方法

2.1 プログラムのミス(人為的エラー)

プログラムがエラーで停止する場合:

- 原因:必要なライブラリがインストールされていない、または構文エラー

- 対処方法:エラーメッセージを確認し、提供されたコードと比較する。特に「!pip install -q retina-face」の実行を確認する

モデルの読み込みに時間がかかる場合:

- 原因:初回実行時にGaze-LLEモデルとDINOv2バックボーンをダウンロードしている

- 対処方法:これは正常な動作である。ダウンロードが完了するまで待つ(数分程度)

画像のアップロードができない場合:

- 原因:ファイル選択ダイアログが表示されていない、または対応していない画像形式

- 対処方法:JPGまたはPNG形式の画像を使用する。ブラウザを更新して再実行する

2.2 期待と異なる結果が出る場合

顔が検出されない場合:

- 原因:画像内の顔が小さすぎる、横顔や俯瞰角度が極端、または顔が一部隠れている

- 対処方法:正面に近い角度で顔が写っている画像を使用する。顔が画像内で十分な大きさを占めていることが望ましい

フレーム内スコアが常に低い値になる場合:

- 原因:人物が実際にフレーム外を見ている、または顔の向きが極端

- 対処方法:これは正常な動作である。人物が明らかにフレーム内の対象を見ている画像で再確認する

矢印が表示されない場合:

- 原因:フレーム内スコアが0.5未満である

- 対処方法:これは正常な動作である。モデルは視線がフレーム外を向いていると判定している。個別ヒートマップで視線方向の傾向を確認できる

視線方向が実際と異なる場合:

- 原因:顔の角度が極端、画像の解像度が低い、または人物の目が閉じている・隠れている

- 対処方法:これはモデルの推定限界である。複数の画像で実験し、どのような条件で推定精度が低下するかを記録する

複数人物の視線が混同される場合:

- 原因:人物同士が非常に近接している、または顔の一部が重なっている

- 対処方法:統合可視化画像の色分けを確認し、各人物に対応する矢印と注視点を識別する。RetinaFaceの顔検出が正しく行われているか確認する

3. 実験レポートのサンプル

以下の実験レポートは記入例であり、表内の数値および考察・結論中の具体的な数値はすべて架空の値である。

複数人物における視線方向の一致性検証

実験目的:

複数の人物が同一対象を見ている画像において、推定された注視点がどの程度一致するかを確認する。

実験計画:

複数人物が同じ対象(例:スクリーン、商品、人物)を見ている画像を用意し、各人物の注視点座標を記録する。

実験方法:

プログラムを実行し、以下の項目を記録する。

- 検出された顔の数と実際の人物数の一致

- 各人物のフレーム内スコア

- 推定された注視点の画像上の座標位置

- 実際の注視対象の位置との距離(ピクセル単位)

実験結果:

| 人物ID | フレーム内スコア | 注視点座標 | 実際の対象座標 | 誤差(ピクセル) | 評価 |

|---|---|---|---|---|---|

| 人物1 | xxxx | (xxxx, xxxx) | (xxxx, xxxx) | xxxx | 良好/不良 |

| 人物2 | xxxx | (xxxx, xxxx) | (xxxx, xxxx) | xxxx | 良好/不良 |

| 人物3 | xxxx | (xxxx, xxxx) | (xxxx, xxxx) | xxxx | 良好/不良 |

| 平均 | xxxx | - | - | xxxx | - |

考察:

- (例文)全ての人物のフレーム内スコアが0.5以上であり、視線がフレーム内を向いていることをモデルが正しく判定できた

- (例文)人物1と人物2の注視点は実際の対象位置から平均xxxxピクセル以内に収まっており、推定精度は良好であった

- (例文)人物3は横顔に近い角度であったため、フレーム内スコアがやや低く、注視点の誤差も大きくなった。顔の角度が推定精度に影響することが確認できた

- (例文)複数人物の注視点が互いに近い位置に表示され、同一対象を見ているという状況をモデルが捉えられていることが示唆された

- (例文)ヒートマップを観察すると、正面を向いた人物ほど注視領域が集中し、横顔の人物は分布が広がる傾向が見られた

結論:

(例文)本実験により、Gaze-LLEモデルは複数人物の視線方向を概ね正確に推定できることが確認された。フレーム内スコアは視線方向の信頼性指標として有効であり、0.5という閾値は妥当である。ただし、顔の角度が正面からxxxx度以上外れると推定精度が低下する傾向が見られた。実用化においては、顔検出の成功率と顔の角度を事前評価することで、より信頼性の高い視線推定システムを構築できると考えられる。

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)