MediaPipe BlazePose 人体セグメンテーションプログラムによる実験・研究スキルの基礎

【概要】MediaPipe BlazePoseを用いた静止画像からの人物領域抽出システムである。Google Colab環境で動作し、アップロードした画像から人物の輪郭を検出して背景を除去する。パラメータ調整により抽出精度を最適化でき、実験・研究の基礎スキルを学習できる。

Colab のページ(ソースコードと説明): https://colab.research.google.com/drive/12omaU0G52at_FT6EKk2NHJ58meR-Vykg?usp=sharing

【目次】

プログラムの使用法

1. このプログラムの利用シーン

静止画像から人物領域を自動的に抽出し、背景を除去するツールである。人物写真の背景差し替え、商品撮影の背景処理、プレゼンテーション用画像の作成、画像編集の前処理、人物にフォーカスした画像分析などに活用できる。

2. 主な機能

- 高精度な人物領域検出:MediaPipe BlazePoseを用いて人物の輪郭を正確に検出する。

- 背景除去:検出した人物領域以外を指定色(白色)の背景に置き換える。

- パラメータ調整機能:検出信頼度(0.0から1.0、0.05刻み)とモデル複雑度(0、1、2の3段階)をスライダーで調整できる。

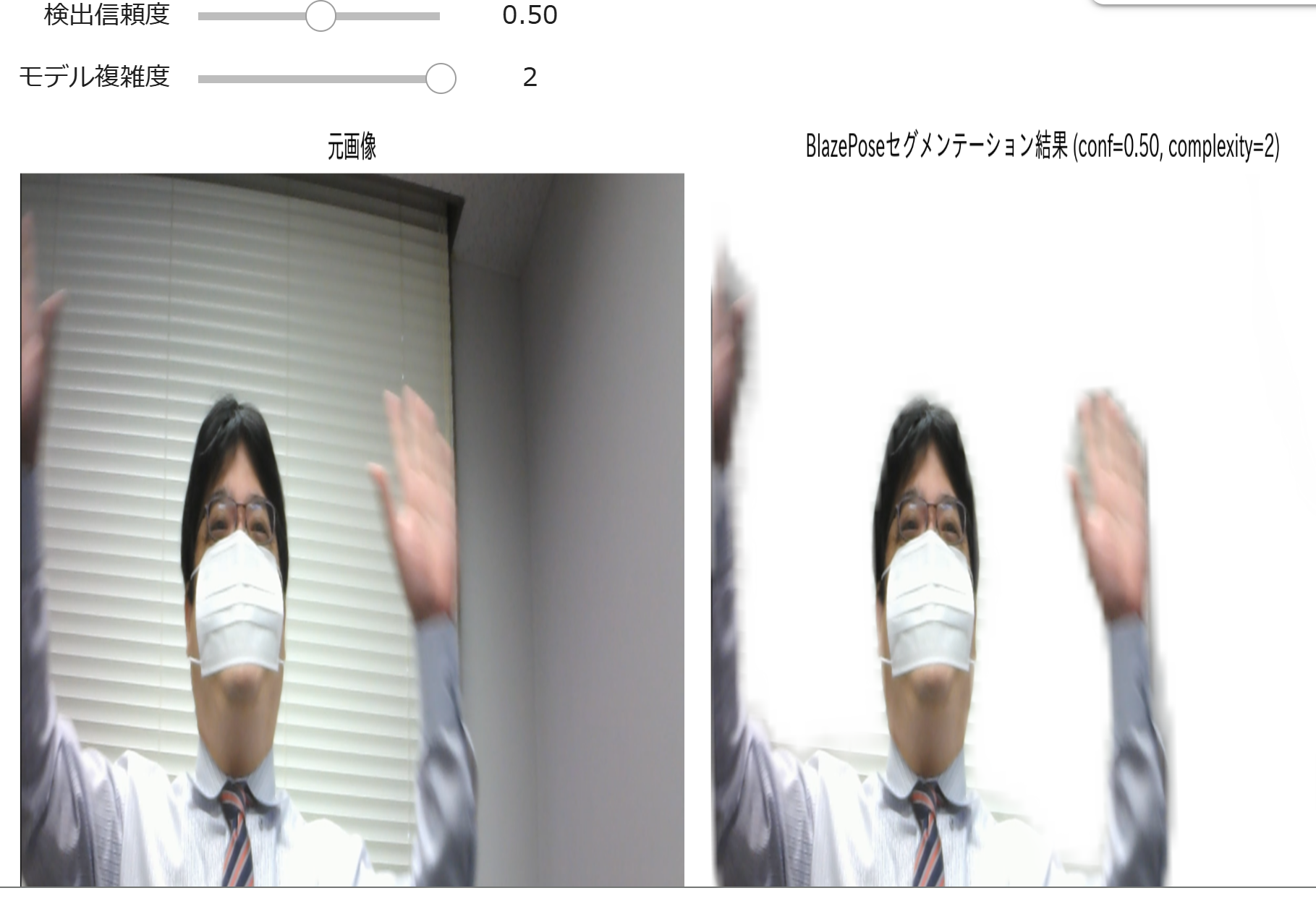

- リアルタイムプレビュー:元画像とセグメンテーション結果を1行2列で並べて表示する。パラメータを変更すると即座に結果が更新される。

- 簡単な操作:Google Colab上で画像をアップロードし、スライダーを調整するだけで処理が完了する。

3. 基本的な使い方

- 処理画像を準備しておく

- Colabのページを開く

Colab のページ(ソースコードと説明): https://colab.research.google.com/drive/12omaU0G52at_FT6EKk2NHJ58meR-Vykg?usp=sharing - Google Colabでプログラムを実行する。

- 初回実行時、MediaPipeが自動的にインストールされ、ランタイムが再起動される。

- 再起動後、再度プログラムを実行する。

- BlazePoseモデルが読み込まれる(初回は時間がかかる場合がある)。

- 「ファイルを選択」ボタンが表示されるので、処理したい画像をアップロードする。

- 画像がアップロードされると、ファイル名とサイズが表示される。

- 「検出信頼度」と「モデル複雑度」のスライダーを調整し、セグメンテーション結果を確認する。

4. 便利な機能

- 検出信頼度の調整:0.0から1.0の範囲で0.05刻みで調整できる。閾値を上げると、より確実に人物と判断された領域のみが抽出される。曖昧な領域を除外したい場合に有用である。デフォルト値は0.5である。

- モデル複雑度の選択:0、1、2の3段階から選択できる。複雑度0は処理が速く、複雑度2は精度が向上する。画像の難易度(複雑な背景、複雑なポーズなど)に応じて選択する。デフォルト値は2である。

- リアルタイムプレビュー:パラメータを変更すると即座に結果が更新されるため、最適な設定を見つけやすい。スライダーを動かすだけで再処理が自動実行される。

- シンプルな出力:人物領域が抽出され、背景が白色に置き換えられた画像が得られる。背景色はプログラムのBACKGROUND_COLOR変数を変更することでカスタマイズ可能である。

- 処理状況の可視化:画像読み込み時にファイル名とサイズが表示され、処理完了後にはパラメータ値が数値で表示される。

プログラムの説明

概要

このプログラムは、MediaPipe BlazePoseのセグメンテーション機能を用いた静止画像からの人物領域抽出システムである。Google Colab環境で動作し、アップロードした画像から人物の輪郭を検出し、背景を除去する。セグメンテーション結果は元画像と並べて可視化され、パラメータ調整により抽出精度を最適化できる。

主要技術

MediaPipe BlazePose

Googleが2020年のCVPR Workshop (CV4ARVR)で発表した姿勢推定モデルである[1][2]。従来のCOCOトポロジー(17キーポイント)を拡張し、33個の3次元キーポイントを検出する。モバイルデバイス上でリアルタイム推論が可能であり、フィットネスや手話認識などの用途に適している[1]。検出器とトラッカーの二段階パイプラインを採用し、顔検出に基づいて人体の位置を特定した後、全キーポイントを予測する[2]。

セグメンテーション機能

BlazePoseは姿勢推定に加えて、人物領域のセグメンテーションマスクを生成する機能を持つ。このマスクは各ピクセルが人物領域に属する確率を0から1の値で表現しており、高精度な背景除去を実現する。

技術的特徴

- 静止画像モードでの処理

static_image_mode=True により、動画ではなく静止画像に特化した設定で処理する。各画像を独立して処理し、時系列情報を利用しない単一画像からのセグメンテーションを実現する。

- モデル複雑度の選択

model_complexity パラメータ(0、1、2の3段階)により、推論速度と精度のバランスを調整できる[3]。値が大きいほど精度が向上するが、計算コストも増加する。デフォルト値は2である。

- セグメンテーション機能の有効化

enable_segmentation=True により、人物領域のセグメンテーションマスクが生成される。このマスクは results.segmentation_mask として取得され、各ピクセルが人物領域に属する確率を0から1の値で表現する。

- セグメンテーションマスクの適用

検出された人物領域マスク(results.segmentation_mask)を3チャンネルに拡張(np.repeat)し、元画像とBACKGROUND_COLOR画像を合成する。数式では次のようになる。

$$\text{segmented\_image} = \text{img} \times \text{segm\_mask} + \text{bg\_img} \times (1 - \text{segm\_mask})$$

この式により、人物部分は元画像を保持し、背景部分は指定色に置き換える。

- 信頼度に基づく処理制御

min_detection_confidence パラメータ(デフォルト0.5)により、人物検出の信頼度閾値を設定できる。姿勢が検出されない場合(results.pose_landmarks が None)は、「姿勢を検出できませんでした」と表示して処理をスキップする。

- カラー空間変換

OpenCVで読み込んだBGR画像をRGBに変換(cv2.cvtColor(img, cv2.COLOR_BGR2RGB))してMediaPipeで処理し、表示時も再度RGB変換を行うことで、正確な色再現を実現する。

実装の特色

- Google Colab最適化

Google Colab環境に特化した設計であり、files.upload()による画像アップロード機能と、MediaPipeの自動インストール・ランタイム再起動機能を備える。画像読み込み時にはファイル名とサイズが表示され、処理状況を把握できる。

- 2画面比較表示

1行2列のレイアウトで、元画像(左)とセグメンテーション結果(右)を横並びで表示することで、処理前後の比較が容易になる。表示サイズは14×6インチに固定され、見やすさが確保されている。パラメータの影響を視覚的に確認できる。

- 背景色のカスタマイズ

BACKGROUND_COLOR変数(デフォルト: (255, 255, 255) = 白色)を変更することで、背景の色を自由に設定できる。この変数はプログラムの上部で定義されており、容易にカスタマイズが可能である。

- インタラクティブな実験環境

ipywidgetsのinteractデコレータを用いることで、パラメータを変更するたびに自動的に再処理と再描画が実行される。検出信頼度は0.0から1.0の範囲で0.05刻みで調整でき、モデル複雑度は0、1、2の3段階から選択できる。試行錯誤を通じた調整が容易になる。

- 詳細な処理状況表示

プログラム実行中には、「mediapipeは既にインストールされています」「BlazePoseモデルを読み込んでいます...」「モデルの読み込み完了」などの状況メッセージが表示される。処理完了後には、適用された検出信頼度とモデル複雑度の数値が表示される。

- エラーハンドリング

画像が読み込めない場合は「エラー: 画像を読み込めませんでした」と表示される。姿勢が検出できない場合は「姿勢を検出できませんでした」と表示され、プログラムのクラッシュを防ぐ。

- 効率的な画像処理

NumPyの配列操作を用いて、セグメンテーションマスクを3チャンネルに拡張し、効率的に人物領域と背景を合成する。OpenCVのカラー空間変換(BGR⇔RGB)により、正確な色再現を実現する。

参考文献

[1] Bazarevsky, V., Grishchenko, I., Raveendran, K., Zhu, T., Zhang, F., & Grundmann, M. (2020). BlazePose: On-device Real-time Body Pose tracking. arXiv preprint arXiv:2006.10204. https://arxiv.org/abs/2006.10204

[2] Google Research Blog. (2020). On-device, Real-time Body Pose Tracking with MediaPipe BlazePose. https://research.google/blog/on-device-real-time-body-pose-tracking-with-mediapipe-blazepose/

[3] Google AI for Developers. MediaPipe Pose Landmark Detection Guide. https://ai.google.dev/edge/mediapipe/solutions/vision/pose_landmarker

実験・研究スキルの基礎:Google Colabで学ぶセグメンテーション実験

1. 実験・研究のスキル構成要素

実験や研究を行うには、以下の5つの構成要素を理解する必要がある。

1.1 実験用データ

このプログラムでは人物が写っている静止画像ファイルが実験用データである。様々な背景や姿勢の画像を使用することで、セグメンテーション性能を評価できる。

1.2 実験計画

何を明らかにするために実験を行うのかを定める。

計画例:

- パラメータ(検出信頼度、モデル複雑度)を変更して、セグメンテーション結果の変化を観察する

- シンプルな背景の画像と複雑な背景の画像で、必要なパラメータ設定を比較する

- 様々な姿勢(正面、横向き、座位、立位など)での抽出精度を評価する

1.3 プログラム

実験を実施するためのツールである。このプログラムはMediaPipe BlazePoseのセグメンテーション機能を使用している。

- プログラムの機能を理解して活用することが基本である

- 基本となるプログラムを出発点として、将来、機能を自分で追加することができる

1.4 プログラムの機能

このプログラムは静止画像から人物領域を検出し、背景を除去する。

使用する技術:

- MediaPipe BlazePose:Googleが開発した姿勢推定モデルである[1][2]。従来のCOCOトポロジー(17キーポイント)を拡張し、33個の3次元キーポイントを検出する。検出器とトラッカーの二段階パイプラインを採用し、顔検出に基づいて人体の位置を特定した後、全キーポイントを予測する

- セグメンテーション機能:人物領域を示すマスクを生成し、ピクセル単位で人物と背景を分離する

- ipywidgets:パラメータのリアルタイム調整用UI

実験手順:

- 処理画像を準備しておく

- Colabのページを開く

Colab のページ(ソースコードと説明): https://colab.research.google.com/drive/13nOMSW0Dzx_LjN9XEG99jtvgMACl4m9V?usp=sharing - Google Colabでプログラムを実行する

- 初回実行時、MediaPipeが自動インストールされ、ランタイムが再起動される

- 再起動後、プログラムを再実行する

- 「ファイルを選択」ボタンから画像を選択する

- 「検出信頼度」(0.0から1.0)と「モデル複雑度」(0から2)のスライダーが表示される

- パラメータを変更すると、自動的に再処理と可視化が実行される

パラメータの機能:

- 検出信頼度:人物検出の信頼性を制御する。信頼度0.3では検出条件が緩く、多くの場合で人物が検出される。信頼度0.5ではバランスの取れた結果が得られる(デフォルト値)。信頼度0.8では明確に人物と判断できる場合のみ検出される

- モデル複雑度:推論速度と精度のトレードオフを制御する[3]。複雑度0は処理が速く精度は低い。複雑度1は速度と精度のバランスが取れている。複雑度2は処理時間は長いが精度が向上する(デフォルト値)

出力情報:

- 可視化結果:1行2列のレイアウトで表示される。左側(axes[0])に元画像、右側(axes[1])にセグメンテーション結果が表示される。人物領域は元画像が保持され、背景は白色(BACKGROUND_COLOR)に置き換えられる。表示サイズはxxx×xxxインチに固定されている

- タイトル情報:元画像には「元画像」というタイトルが表示される。セグメンテーション結果には「BlazePoseセグメンテーション結果 (conf=X.XX, complexity=X)」という形式で、現在適用されているパラメータが表示される

- 処理パラメータの数値表示:可視化の後に、「検出信頼度: X.XX, モデル複雑度: X」という形式で、適用されたパラメータが数値で表示される

- エラーメッセージ:画像読み込みに失敗した場合は「エラー: 画像を読み込めませんでした」と表示される。姿勢が検出できない場合は「姿勢を検出できませんでした」と表示される

1.5 検証(結果の確認と考察)

プログラムの実行結果を観察し、セグメンテーションの動作を考察する。

基本認識:

- 入力画像を変えると結果が変わる。その変化を観察することが実験である

- パラメータを変えると結果が変わる。その変化を観察することが実験である

- 「良い結果」「悪い結果」は目的によって異なる

観察のポイント:

- 人物領域は正確に抽出されているか

- 背景との境界線は滑らかか、それとも粗いか

- 髪の毛や指など細かい部分は正しく抽出されているか

- パラメータを変更したとき、抽出精度はどう変化するか

- シンプルな背景では低い複雑度でも良好な結果が得られるか

- 複雑な背景では高い複雑度が必要となるか

2. 間違いの原因と対処方法

2.1 プログラムのミス(人為的エラー)

初回実行でランタイムが再起動される

- 原因:MediaPipeが未インストールの場合、自動インストール後にランタイムが再起動される

- 対処方法:これは正常な動作である。再起動後に「再起動後に、セルを再実行して下さい。」と表示されるので、プログラムを再実行する

モデルの読み込みに時間がかかる

- 原因:初回実行時にMediaPipeモデルをダウンロードしている。「BlazePoseモデルを読み込んでいます...」と表示される

- 対処方法:これは正常な動作である。「モデルの読み込み完了」と表示されるまで待つ

画像を読み込めない

- 原因:画像ファイルの形式が対応していない、またはファイルが破損している

- 対処方法:「エラー: 画像を読み込めませんでした」と表示される。JPEG、PNGなどの一般的な画像形式を使用する

2.2 期待と異なる結果が出る場合

人物が検出されない

- 原因:画像内の人物が小さすぎる、大きく遮蔽されている、画像の品質が低い

- 対処方法:人物がはっきり写っている画像を使用する。人物のサイズが十分大きい画像を選ぶ。検出信頼度を下げてみる

背景の一部が残る、または人物の一部が欠ける

- 原因:モデル複雑度が低い、または背景と人物の色が似ている

- 対処方法:モデル複雑度を上げる。検出信頼度を調整する

境界線が粗い

- 原因:セグメンテーションマスクの解像度による制限

- 対処方法:モデル複雑度を上げることで改善する場合がある。完璧な境界線が必要な場合は、専門的な画像編集ツールと併用する

3. 実験レポートのサンプル

背景の複雑さがセグメンテーション精度に与える影響

実験目的:

背景の複雑さ(シンプル/複雑)とモデル複雑度のパラメータが、人物領域抽出の精度に与える影響を評価する。

実験計画:

異なる背景条件の画像に対して、モデル複雑度を変化させ、セグメンテーション結果の視覚的品質を評価する。

実験方法:

以下の条件で実験する:

- 画像条件:シンプルな背景(単色壁)、複雑な背景(屋外の風景)

- モデル複雑度:xxx、xxx、xxx

- 検出信頼度:xxx(固定)

評価基準:

- 人物領域の完全性(欠けている部分はないか)

- 背景除去の完全性(背景の残存はないか)

- 境界線の品質(滑らかさ、細部の再現性)

実験結果:

| 画像条件 | モデル複雑度 | 人物領域の完全性 | 背景除去の完全性 | 境界線の品質 |

|---|---|---|---|---|

| シンプル | xxx | 優秀/良好/一部欠けた | 優秀/良好/わずかに残存/残存 | 優秀/良好/普通/粗い |

| シンプル | xxx | xxx | xxx | xxx |

| シンプル | xxx | xxx | xxx | xxx |

| 複雑 | xxx | xxx | xxx | xxx |

| 複雑 | xxx | xxx | xxx | xxx |

| 複雑 | xxx | xxx | xxx | xxx |

考察:

- (例文)シンプルな背景の画像では、モデル複雑度xxxでも実用的な結果が得られた。

- (例文)複雑な背景の画像では、モデル複雑度xxxが必要であることが確認できた。

- (例文)モデル複雑度を上げることで、境界線の品質が向上し、細部(髪の毛など)の再現性が改善された。

- (例文)背景の複雑さに応じて適切なパラメータを選択することで、処理時間と精度のバランスを最適化できる。

結論:

(例文)本実験では、背景の複雑さがセグメンテーション精度に大きく影響することが確認できた。(例文)シンプルな背景では低い複雑度でも十分な結果が得られるが、複雑な背景では高い複雑度が必要となる。(例文)実用上は、画像の特性を事前に評価し、適切なモデル複雑度を選択することが重要である。

実験のヒント:

- 同じ人物で背景だけを変えた画像を用意すると、背景の影響を明確に評価できる

- 複数の画像で実験し、傾向を確認することで、より信頼性の高い結論が得られる

- 結果を画像として保存しておくと、レポート作成時に便利である

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)