RT-DETRv2物体検出実験 Colab プログラム(インタラクティブなパラメータ調整機能付き)による実験・研究スキルの基礎

【概要】Google Colabで動作する物体検出AI(RT-DETRv2)を使用した実験プログラム。画像をアップロードし、スライダーで信頼度閾値を調整することで、リアルタイムに検出結果を確認できる。人・車・動物など80種類の物体を検出可能。誤検出と見逃しのトレードオフを体験的に理解し、実験・研究の基礎スキルを学習できる教材である。

Colabのページ(ソースコードと説明): https://colab.research.google.com/drive/1gJOMdEc5VZbtNmFh403iYuoT6bUMAcmm?usp=sharing

【目次】

プログラムの使用法

1. このプログラムの利用シーン

画像内の物体を自動的に検出し、その位置とクラスを特定する用途に使用される。物体検出の閾値パラメータを調整しながら、その効果をリアルタイムで確認できるため、研究開発、教育、プロトタイピングなど、物体検出技術の実験や検証を必要とする場面で活用できる。

2. 主な機能

画像ファイルのアップロードによる物体検出

自分のパソコンやスマートフォンに保存されている写真を、Google Colabにアップロード(転送)する。プログラムはアップロードされた画像を読み込み、その中に何が写っているかを自動的に探し出す。

80クラスのCOCOデータセット物体の検出

このプログラムは80種類の物体を認識できる。これらの物体は、COCOデータセット(大規模な物体検出用の画像データベース)で定義されている。人物、車両、動物など、日常的に見かける物体が含まれている。下の対応表を参照すること。

インタラクティブなパラメータ調整機能

スライダーを使って、信頼度閾値を動的に調整できる。スライダーを動かすと、即座に検出が再実行され、結果が更新される。これにより、パラメータが検出結果に与える影響をリアルタイムで確認できる。

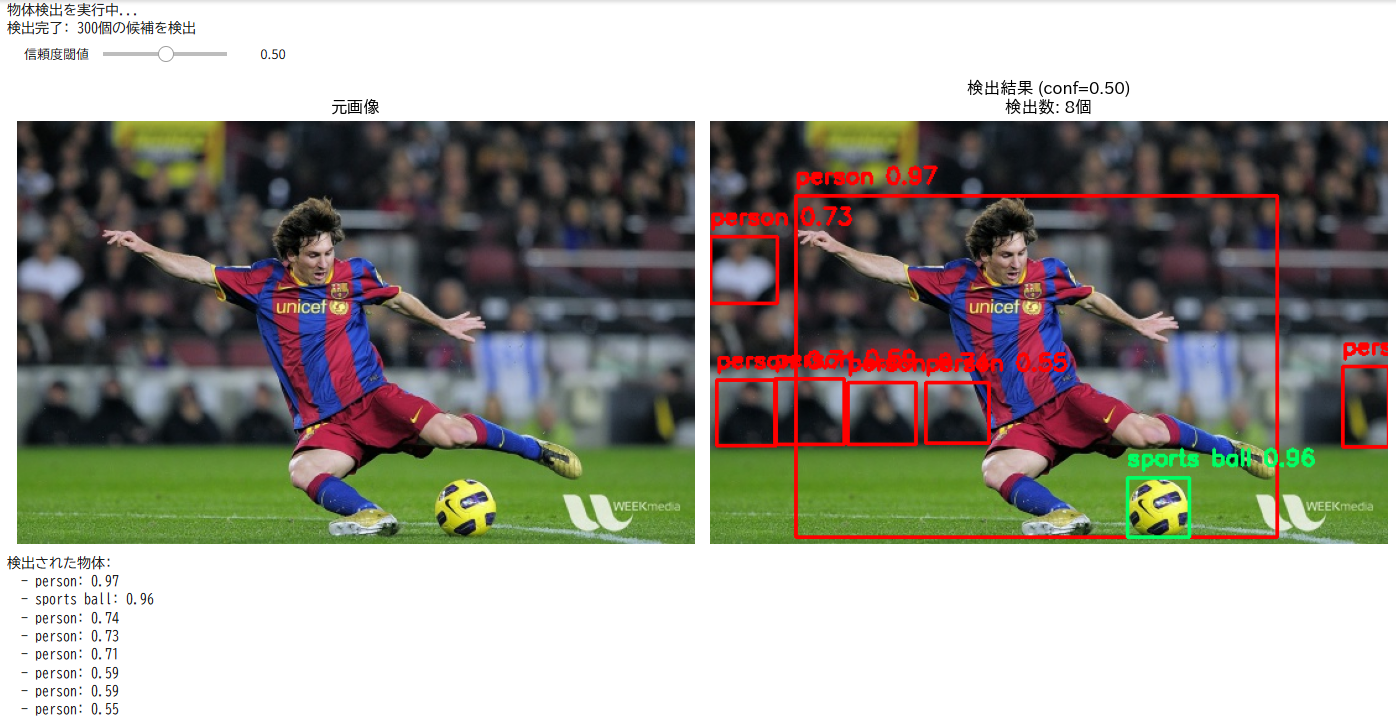

検出結果の視覚化(バウンディングボックスとラベル)

プログラムは検出した物体を画像上に表示する。物体の周りに緑色の矩形の枠(バウンディングボックス)を描き、その上に物体の名前(ラベル)と信頼度を表示する。元画像と検出結果を並べて表示するため、どこに何が検出されたかを視覚的に比較できる。

検出物体の詳細情報表示(クラス名、信頼度、検出数)

プログラムは検出した物体について、以下の情報を表示する。

- クラス名:物体の種類の名前(例:「人」「車」「犬」)

- 信頼度:プログラムがその物体であると確信している度合いを0.0から1.0の数値で表したもの。1.0に近いほど確信度が高い。例えば、信頼度0.95は「95%の確率でその物体である」という意味である

- 検出数:画像内で検出された物体の総数

3. 基本的な使い方

- 処理画像を準備しておく

- Colabのページを開く

Colabのページ(ソースコードと説明): https://colab.research.google.com/drive/1gJOMdEc5VZbtNmFh403iYuoT6bUMAcmm?usp=sharing

- セルを実行する

- 表示されるファイル選択ダイアログから検出対象の画像ファイルを選択する

- モデルの読み込みが完了すると、スライダーが表示される

- スライダーを動かして信頼度閾値を調整し、検出結果の変化を確認する

4. 便利な機能

- 複数の画像形式に対応(JPEG、PNG)

- スライダーによる直感的なパラメータ調整(信頼度閾値:0.0~1.0)

- リアルタイムでの検出結果更新により、パラメータの影響を即座に確認可能

- 元画像と検出結果の並列表示により、視覚的な比較が容易

- 検出された物体のリスト表示により、詳細情報を確認可能

5. パラメータの説明

信頼度(Confidence)とは

物体検出の信頼度とは、AIモデルがその物体を正しく認識している確信の度合いを0~1の数値で表したものである。1に近いほど確信度が高い。

信頼度閾値(Confidence Threshold)

検出結果をフィルタリングする基準となる値である。この値より高い信頼度を持つ検出のみが表示される。

- 値を上げる(0.5~0.7):誤検出が減少するが、見逃しが増える可能性がある

- 値を下げる(0.1~0.2):より多くの物体を検出するが、誤検出も増える

- 推奨値:0.25(バランスの取れた設定)

プログラムの説明

概要

このプログラムは、Google Colab環境でRT-DETRv2モデルを使用した物体検出を実行する。ユーザーがアップロードした画像に対して、スライダーで調整可能な閾値パラメータを用いて物体検出を行い、検出結果をリアルタイムで視覚化して表示する機能を提供する。

主要技術

RT-DETRv2 (Real-Time Detection Transformer version 2)

物体検出アルゴリズムである[1]。このプログラムでは、r101vdモデルを使用している。

Transformers

事前学習済みモデルの実装と展開を支援するPythonパッケージである[2]。RT-DETRv2を含む複数のモデルをサポートし、訓練、検証、推論、エクスポートの機能を統合したフレームワークを提供する。

ipywidgets

Jupyter NotebookやGoogle Colabでインタラクティブなウィジェット(スライダー、ボタンなど)を提供するライブラリである。このプログラムでは、信頼度閾値を動的に調整するためのスライダーUIを実装している。

技術的特徴

- インタラクティブなパラメータ調整

ipywidgetsの@interact デコレータを使用し、スライダーによるリアルタイムなパラメータ調整機能を実装している。スライダーを動かすと即座に検出が再実行され、結果が更新される。これにより、パラメータの影響を直感的に理解できる。

- 明示的な閾値設定

信頼度閾値を明示的に指定する。ユーザーは0.0から1.0の範囲で自由に調整でき、極端な値での動作も確認できる。これにより、閾値パラメータの理解を深めることができる。

- 視覚的な比較表示

matplotlibを使用し、元画像と検出結果を並べて表示する。検出された物体にはバウンディングボックスとラベル(クラス名、信頼度)を描画し、視覚的に分かりやすい形で結果を提示する。

実装の特色

Google Colab環境に特化した実装として、以下の機能を備える。

- ファイルアップロードAPIによるインタラクティブな画像入力

- ipywidgetsによる直感的なパラメータ調整UI

- matplotlibを使用した視覚的な結果表示(元画像と検出結果の並列表示)

- 検出数のリアルタイム表示

- 検出物体の詳細情報(クラス名、信頼度)のリスト出力

- 教育・研究用途に適した広範囲なパラメータ調整範囲

参考文献

[1] Lv, W., Zhao, Y., Xu, S., Wei, J., Wang, G., Cui, C., Du, Y., Dang, Q., & Liu, Y. (2024). DETRs Beat YOLOs on Real-time Object Detection. arXiv preprint arXiv:2304.08069. https://arxiv.org/abs/2304.08069

[2] Wolf, T., et al. (2020). Transformers: State-of-the-Art Natural Language Processing. Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations. https://github.com/huggingface/transformers

実験・研究スキルの基礎:Google Colabで学ぶ物体検出実験

1. 実験・研究のスキル構成要素

実験や研究を行うには、以下の5つの構成要素を理解する必要がある。

1.1 実験用データ

このプログラムでは画像ファイルが実験用データである。

1.2 実験計画

何を明らかにするために実験を行うのかを定める。

計画例は以下のとおりである。

- 信頼度閾値が検出数に与える影響を確認する

- 誤検出を最小化するためのパラメータ設定を見つける

- 見逃しを減らしながら誤検出を抑える方法を探る

- 特定の物体(人、車など)を確実に検出する設定を見つける

1.3 プログラム

実験を実施するためのツールである。このプログラムはTransformersのRT-DETRv2モデルとipywidgetsのinteract関数を使用している。

- プログラムの機能を理解して活用することが基本である

- 基本となるプログラムを出発点として、将来、様々な機能を自分で追加することができる

1.4 プログラムの機能

このプログラムはパラメータで物体検出を制御する。

入力パラメータは以下のとおりである。

- 信頼度閾値:検出結果を表示する最低信頼度(0.0~1.0)

出力情報は以下のとおりである。

- 元画像(左側)と検出結果画像(右側)の並列表示

- 現在のパラメータ値と検出数を含む画像タイトル

- 検出された物体のリスト(クラス名と信頼度)

スライダーの動作は以下のとおりである。

- スライダーを動かすと即座に検出が実行され、結果が更新される

1.5 検証(結果の確認と考察)

プログラムの実行結果を観察し、パラメータの影響を考察する。

基本認識は以下のとおりである。

- パラメータを変えると結果が変わる。その変化を観察することが実験である

- 「良い結果」「悪い結果」は目的によって異なる

観察のポイントは以下のとおりである。

- 検出数はどう変化するか

- 誤検出(存在しない物体の検出)は発生しているか

- 見逃し(本来検出すべき物体の未検出)は発生しているか

- 信頼度の値は妥当か

2. 間違いの原因と対処方法

2.1 プログラムのミス(人為的エラー)

モデルのダウンロードに時間がかかる場合がある。

- 原因:初回実行時にRT-DETRv2モデルをダウンロードしている

- 対処方法:これは正常な動作である。ダウンロードが完了するまで待つ

2.2 期待と異なる結果が出る場合

パラメータを変えても検出数が変化しない場合がある。

- 原因:元々検出される物体が少ない画像、またはパラメータの変化幅が小さすぎる

- 対処方法:信頼度閾値を0.1から0.7まで大きく変化させて観察する

明らかに存在する物体が検出されない場合がある。

- 原因:信頼度閾値が高すぎる、または物体がCOCOデータセットの80クラスに含まれていない

- 対処方法:信頼度閾値を0.1程度まで下げて確認する。それでも検出されない場合は、その物体クラスが対応していない可能性がある

誤検出が多すぎる場合がある。

- 原因:信頼度閾値が低すぎる

- 対処方法:信頼度閾値を0.5以上に上げる。どの程度で誤検出が減るか記録する

3. 実験レポートのサンプル

誤検出と見逃しのバランス調整

実験目的は以下のとおりである。

テスト画像内の人物を確実に検出しながら、誤検出を最小化するための最適な信頼度閾値を見つける。

実験計画は以下のとおりである。

信頼度閾値を変化させて最適値を探す。

実験方法は以下のとおりである。

プログラムを実行し、スライダーを操作しながら以下の基準で評価する。

- 正検出数:正しく検出された人物の数

- 誤検出数:人物でないものが人物として検出された数

- 見逃し数:検出されなかった人物の数

実験結果は以下のとおりである。

| 信頼度閾値 | 検出総数 | 正検出数 | 誤検出数 | 見逃し数 | 総合評価 |

|---|---|---|---|---|---|

| 0.10 | x | x | x | x | x |

| 0.25 | x | x | x | x | x |

| 0.50 | x | x | x | x | x |

| 0.70 | x | x | x | x | x |

考察は以下のとおりである。

- (例文)信頼度閾値xxxxでは検出総数が多いが、誤検出も多く含まれていた。背景の物体を人物と誤認識する傾向が見られた

- (例文)信頼度閾値xxxxでは誤検出が減少し、ほとんどの人物を正しく検出できた。デフォルト値として妥当な設定である

- (例文)信頼度閾値xxxx以上では誤検出はほぼなくなったが、画像の端や一部が隠れた人物の見逃しが増加した

- (例文)信頼度閾値を上げるほど誤検出は減るが、同時に見逃しも増えるというトレードオフの関係が確認できた

結論は以下のとおりである。

(例文)本実験の画像においては、信頼度閾値0.25がバランスの取れた設定であった。誤検出を完全に防ぐことよりも、重要な人物を見逃さないことを優先する場合は0.25、誤検出を極力避けたい場合は0.50が適切である。用途に応じて閾値を調整する必要性が確認できた。

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)