YOLOv11インスタンスセグメンテーションのためのデータオーグメンテーション

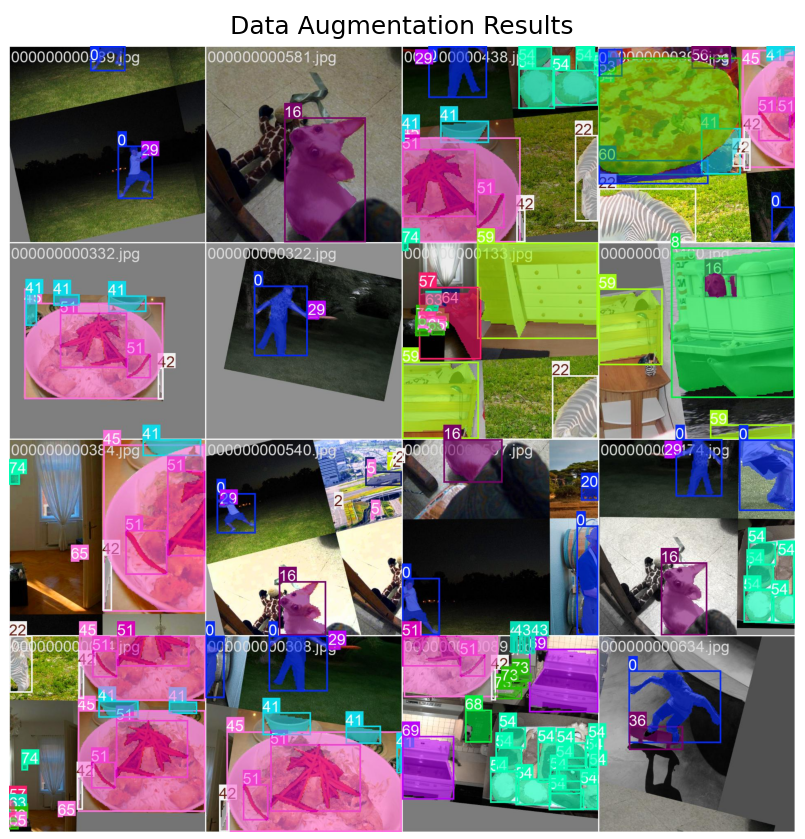

【概要】YOLO11セグメンテーションモデル用のデータオーグメンテーションの実装。COCO128データセットからの元画像128枚を回転・スケーリング・色調変更等により数千パターンに拡張し学習効果を向上させる。拡張画像は保存されず学習時のみ使用される。

目次

概要

主要技術

YOLOv11インスタンスセグメンテーションのためのデータオーグメンテーション

体験価値

データオーグメンテーション(学習の瞬間だけコンピュータが画像を変形させて使う機能)による学習効果の変化を目視で確認できる。元画像128枚から数千パターンの変形画像を生成する過程を確認する。変形した画像は保存されないため、ファイル数は変わらないが様々なパターンで学習が実行される。

事前準備

Python, Windsurfをインストールしていない場合の手順(インストール済みの場合は実行不要)。

- 管理者権限でコマンドプロンプトを起動する(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)。

- 以下のコマンドをそれぞれ実行する(winget コマンドは1つずつ実行)。

REM Python をシステム領域にインストール

winget install --scope machine --id Python.Python.3.12 -e --silent

REM Windsurf をシステム領域にインストール

winget install --scope machine --id Codeium.Windsurf -e --silent

REM Python のパス設定

set "PYTHON_PATH=C:\Program Files\Python312"

set "PYTHON_SCRIPTS_PATH=C:\Program Files\Python312\Scripts"

echo "%PATH%" | find /i "%PYTHON_PATH%" >nul

if errorlevel 1 setx PATH "%PATH%;%PYTHON_PATH%" /M >nul

echo "%PATH%" | find /i "%PYTHON_SCRIPTS_PATH%" >nul

if errorlevel 1 setx PATH "%PATH%;%PYTHON_SCRIPTS_PATH%" /M >nul

REM Windsurf のパス設定

set "WINDSURF_PATH=C:\Program Files\Windsurf"

if exist "%WINDSURF_PATH%" (

echo "%PATH%" | find /i "%WINDSURF_PATH%" >nul

if errorlevel 1 setx PATH "%PATH%;%WINDSURF_PATH%" /M >nul

)

必要なライブラリのインストール

コマンドプロンプトを管理者として実行(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行する:

pip install ultralytics matplotlib opencv-python japanize-matplotlib pillow

データオーグメンテーションの仕組み

データオーグメンテーションとは学習の瞬間だけコンピュータが画像を変形させて使う機能である。変形した画像は保存されない。

具体的な処理例:

- 元画像「car.jpg」を読み込む

- その瞬間に「少し回転させたcar.jpg」として学習に使う

- 回転させた写真は保存されない

- 次回は「色を変えたcar.jpg」として使う

- 色を変えた写真も保存されない

結果:

- 元々の画像:128枚

- 学習後の画像ファイル:128枚(同じ)

- 画像ファイルは1枚も増えない

- ファイル数は変わらないが、様々なパターンで学習

COCO128-segデータセット

COCO128-segデータセット(Common Objects in Context、物体検出用の標準データセット)は自動ダウンロードされ、以下の構造で配置される:

coco128-seg/

├── train/

│ ├── images/ # 学習用画像(128枚)

│ └── labels/ # 学習用ラベル(.txt)

├── val/

│ ├── images/ # 検証用画像

│ └── labels/ # 検証用ラベル(.txt)

└── coco128-seg.yaml # データセット設定ファイル

- ラベル形式: YOLOセグメンテーション形式(正規化されたポリゴン座標)

- coco128-seg.yaml: パス情報とCOCO80クラス名を定義

- 対象クラス: person, bicycle, car, motorcycle, airplane等80クラス

ファインチューニング

事前学習済みモデル(yolo11n-seg.pt)の重みを初期値として使用し、新しいデータセット(COCO128-seg)で追加学習を実行する手法である。

プログラムコード

# YOLO11データオーグメンテーション効果確認プログラム

# COCO128データセットでのセグメンテーション学習時のデータ拡張結果可視化

# 論文: "Ultralytics YOLO11" (2024年9月リリース)

# GitHub: https://github.com/ultralytics/ultralytics

# 特徴: YOLO11は最新のリアルタイム物体検出・セグメンテーションモデル

# YOLOv8mより22%少ないパラメータで高いmAP実現、5種類のモデルサイズ

# 学習済みモデル: yolo11n-seg.pt(Nano版、軽量なセグメンテーション用)

# 前準備: pip install ultralytics matplotlib opencv-python japanize-matplotlib pillow

import matplotlib.pyplot as plt

import japanize_matplotlib

import cv2

from ultralytics import YOLO

from PIL import Image, ImageDraw, ImageFont

import numpy as np

import os

# 利用可能なYOLO11セグメンテーション学習済みモデル:

# yolo11n-seg.pt - Nano: 軽量、エッジデバイス向け(2.9Mパラメータ、mAP 38.9)

# yolo11s-seg.pt - Small: Nanoより精度向上、計算量増加(10.1Mパラメータ、mAP 46.6)

# yolo11m-seg.pt - Medium: 汎用用途、バランス型(22.4Mパラメータ、mAP 51.5)

# yolo11l-seg.pt - Large: 高精度、高計算量(27.6Mパラメータ、mAP 53.4)

# yolo11x-seg.pt - Extra-large: 最高精度、最大計算量(62.1Mパラメータ、mAP 54.7)

# ガイダンス表示

print("=" * 60)

print("YOLO11 データオーグメンテーション効果確認プログラム")

print("=" * 60)

print("\n【概要】")

print("COCO128データセットを用いて、YOLO11のセグメンテーション学習時の")

print("データ拡張効果を可視化します。")

print("\n【操作方法】")

print("1. プログラムが自動的に学習を開始します")

print("2. 学習完了後、データ拡張結果が表示されます")

print("3. 表示された画像ウィンドウを閉じると終了します")

print("\n【注意事項】")

print("- 初回実行時はモデルとデータセットのダウンロードが行われます")

print("- 学習には数分程度かかる場合があります")

print("-" * 60)

print("処理を開始します...\n")

# 設定パラメータ

MODEL_NAME = "yolo11n-seg.pt"

DATASET_CONFIG = "coco128-seg.yaml"

EPOCHS = 3 # デモ用から実用的な値に変更

ROTATION_DEGREES = 15.0

TRANSLATE_RATIO = 0.1

SCALE_FACTOR = 0.3

FLIP_PROBABILITY = 0.5

HSV_HUE = 0.015

HSV_SATURATION = 0.4 # 論理的整合性のため修正

HSV_VALUE = 0.4

MOSAIC_PROBABILITY = 0.8

MIXUP_PROBABILITY = 0.15 # Mixupを有効化

FIGURE_SIZE = (12, 8)

RESULT_IMAGE_PATH = 'runs/segment/train/train_batch0.jpg'

# メイン処理

print("モデルを読み込んでいます...")

model = YOLO(MODEL_NAME)

print(f"\n学習を開始します(エポック数: {EPOCHS})...")

model.train(

data=DATASET_CONFIG,

epochs=EPOCHS,

degrees=ROTATION_DEGREES,

translate=TRANSLATE_RATIO,

scale=SCALE_FACTOR,

fliplr=FLIP_PROBABILITY,

hsv_h=HSV_HUE,

hsv_s=HSV_SATURATION,

hsv_v=HSV_VALUE,

mosaic=MOSAIC_PROBABILITY,

mixup=MIXUP_PROBABILITY,

plots=True

)

# 結果表示

print("\n学習が完了しました。結果を表示します...")

if os.path.exists(RESULT_IMAGE_PATH):

img = cv2.imread(RESULT_IMAGE_PATH)

# 日本語テキスト表示の準備

FONT_PATH = 'C:/Windows/Fonts/meiryo.ttc'

FONT_SIZE = 20

if os.path.exists(FONT_PATH):

font = ImageFont.truetype(FONT_PATH, FONT_SIZE)

img_pil = Image.fromarray(cv2.cvtColor(img, cv2.COLOR_BGR2RGB))

draw = ImageDraw.Draw(img_pil)

draw.text((10, 10), "データオーグメンテーション結果", font=font, fill=(0, 255, 0))

img_rgb = np.array(img_pil)

else:

img_rgb = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)

plt.figure(figsize=FIGURE_SIZE)

plt.imshow(img_rgb)

plt.title('データオーグメンテーション結果')

plt.axis('off')

plt.show()

print("\n【結果の説明】")

print("表示された画像には以下のデータ拡張が適用されています:")

print(f"- モザイク処理: 4つの画像を結合(確率{MOSAIC_PROBABILITY*100}%)")

print(f"- Mixup処理: 画像の混合(確率{MIXUP_PROBABILITY*100}%)")

print(f"- 回転: ±{ROTATION_DEGREES}度")

print(f"- 平行移動: 画像サイズの±{TRANSLATE_RATIO*100}%")

print(f"- スケーリング: ±{SCALE_FACTOR*100}%")

print(f"- 左右反転: 確率{FLIP_PROBABILITY*100}%")

print(f"- 色相調整: ±{HSV_HUE*100}%")

print(f"- 彩度調整: ±{HSV_SATURATION*100}%")

print(f"- 明度調整: ±{HSV_VALUE*100}%")

else:

print(f"\n警告: 結果画像が見つかりません: {RESULT_IMAGE_PATH}")

print("学習ログを確認してください。")

print("\nプログラムを終了します。")

使用方法

- 上記のプログラムを実行

- 実行過程の観察

- COCO128-segデータセットの自動ダウンロード

- データオーグメンテーション処理の実行

- 学習済みモデルの保存

- 拡張結果画像の表示

- 結果確認

runs/segment/train/weights/best.pt: 最適化されたモデルruns/segment/train/train_batch0.jpg: 実際に使用された拡張画像バッチ

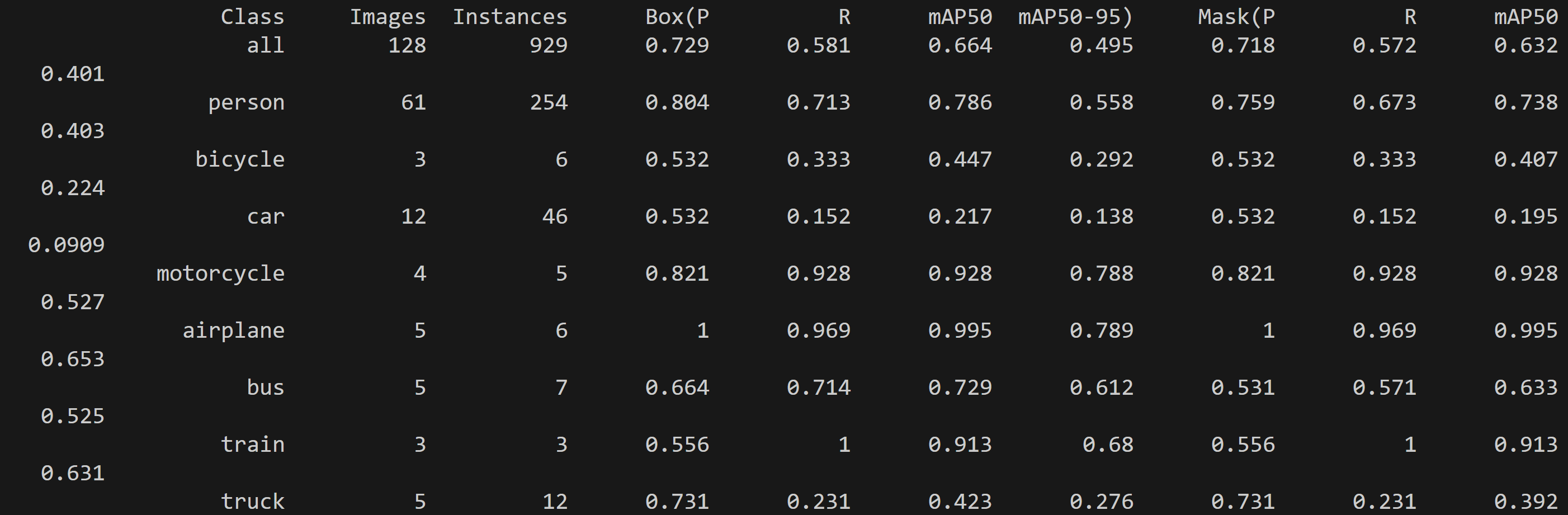

実行結果の詳細

実行前の状態:

- 事前学習済みYOLOv11n-segモデル(COCO 80クラス対応)

実行後の変化:

- person, car, bicycle等のクラスのマスク検出精度が向上

- runs/segment/train/weights/best.ptに最適化されたモデルが保存(学習済みモデルの保存を確認)

- runs/segment/train/train_batch0.jpgに学習時に実際に使用された拡張後の画像バッチが保存される(拡張効果を視覚確認)

- 拡張結果が1つの画面に表示される

実験・探求のアイデア

AIモデル選択実験

- yolo11n-seg.pt(軽量版)

- yolo11s-seg.pt(標準版)

- yolo11m-seg.pt(中規模版)

- yolo11l-seg.pt(大規模版)

各モデルでの学習時間と精度の変化を比較する。

データオーグメンテーション パラメータ実験

基本的な変換:

- 水平反転: fliplr=0.5(デフォルト値、50%確率で適用)

- 回転: degrees=15.0(±15度の範囲、デフォルトは0.0、物体の自然な回転範囲を想定)

- スケーリング: scale=0.3(0.7-1.3倍の範囲、デフォルトは0.5で0.5-1.5倍)

- 色調変更: hsv_h=0.015, hsv_s=0.7, hsv_v=0.4(公式デフォルト値)

注意が必要な変換:

- 平行移動: translate=0.1(デフォルト値、画像端の物体が部分的に切れる場合がある)

- Mosaic拡張: mosaic=0.8(デフォルトは1.0だが、複雑な形状では品質維持のため確率を下げる)

- MixUp: mixup=0.0(デフォルト値、無効のまま)

体験・探求による発見

- 拡張画像の視覚確認

train_batch0.jpgを開き、元画像がどのように変形されているかを確認する。回転、色調変更、スケーリングの実際の効果を確認する。 - 学習前後の精度比較

# 学習前の推論 results_before = YOLO("yolo11n-seg.pt").predict("test_image.jpg") # 学習後の推論 results_after = YOLO("runs/segment/train/weights/best.pt").predict("test_image.jpg")

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)