Self-Attentionメカニズムの確認

【概要】PyTorchによるSelf-Attentionの基本動作を体験する。TransformerのQuery・Key・Valueによる重み付き平均計算を実習し、アテンション重みの変化を数値で確認する。

目次

概要

技術名:Self-Attention

出典:Vaswani, A., Shazeer, N., Parmar, N., Uszkoreit, J., Jones, L., Gomez, A. N., Kaiser, L., & Polosukhin, I. (2017). Attention is all you need. Advances in Neural Information Processing Systems, 30, 5998-6008.

従来手法との比較:RNN(回帰型ニューラルネットワーク)/CNN(畳み込みニューラルネットワーク)は長距離依存関係の捕捉が困難で逐次処理が必要である。Self-Attentionは系列内の任意の位置間で直接的に関係性を計算し、並列処理が可能である。

基本概念:Self-AttentionはTransformerの中核技術で、同一系列内での注意計算を行う。Query(何を探すか)、Key(何を持つか)、Value(実際の情報)の3要素で構成され、入力系列内の各要素間の関係性を直接計算する。

数学的定義:Attention(Q,K,V) = softmax(QK^T/√d_k)V。スケーリングファクター√d_kは内積値の分散を制御し学習を安定化する。ソフトマックス関数(確率分布を生成する関数)は重みを正規化する。

応用例:機械翻訳、文書要約、画像認識、音声認識などの自然言語処理・画像認識分野で活用される。

学習効果:Self-Attentionの計算過程を段階的に確認し、各トークンが他のトークンに注意を向ける仕組みを理解する。

Python開発環境,ライブラリ類

ここでは、最低限の事前準備について説明する。機械学習や深層学習を行う場合は、NVIDIA CUDA、Visual Studio、Cursorなどを追加でインストールすると便利である。これらについては別ページ https://www.kkaneko.jp/cc/dev/aiassist.htmlで詳しく解説しているので、必要に応じて参照してください。

Python 3.12 のインストール

インストール済みの場合は実行不要。

管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行する。管理者権限は、wingetの--scope machineオプションでシステム全体にソフトウェアをインストールするために必要である。

REM Python をシステム領域にインストール

winget install --scope machine --id Python.Python.3.12 -e --silent --accept-source-agreements --accept-package-agreements

REM Python のパス設定

set "PYTHON_PATH=C:\Program Files\Python312"

set "PYTHON_SCRIPTS_PATH=C:\Program Files\Python312\Scripts"

echo "%PATH%" | find /i "%PYTHON_PATH%" >nul

if errorlevel 1 setx PATH "%PATH%;%PYTHON_PATH%" /M >nul

echo "%PATH%" | find /i "%PYTHON_SCRIPTS_PATH%" >nul

if errorlevel 1 setx PATH "%PATH%;%PYTHON_SCRIPTS_PATH%" /M >nul【関連する外部ページ】

Python の公式ページ: https://www.python.org/

AI エディタ Windsurf のインストール

Pythonプログラムの編集・実行には、AI エディタの利用を推奨する。ここでは,Windsurfのインストールを説明する。

管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行して、Windsurfをシステム全体にインストールする。管理者権限は、wingetの--scope machineオプションでシステム全体にソフトウェアをインストールするために必要となる。

winget install --scope machine --id Codeium.Windsurf -e --silent --accept-source-agreements --accept-package-agreements【関連する外部ページ】

Windsurf の公式ページ: https://windsurf.com/

必要なライブラリをシステム領域にインストール

コマンドプロンプトを管理者として実行(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行する

pip install -U torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126

プログラムコード

ソースコード

# Self-Attentionメカニズム体験プログラム

# PyTorchによるSelf-Attentionの基本動作を可視化

# 論文: "Attention Is All You Need" (Vaswani et al., NIPS 2017)

# GitHub: https://github.com/pytorch/pytorch

# 特徴: Transformerの中核技術、Q・K・V変換による重み付き平均計算

# 自然言語処理・画像認識分野で広く活用

# 前準備: pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu126

import torch

import torch.nn.functional as F

# 定数定義

TOKEN_COUNT = 3 # トークン数

FEATURE_DIM = 4 # 特徴次元数

RANDOM_SEED = 42 # 乱数シード(再現性確保)

# メイン処理

torch.manual_seed(RANDOM_SEED)

# 入力データ定義(3つのトークンの特徴ベクトル)

input_data = torch.tensor([[1.0, 0.0, 1.0, 0.0],

[0.0, 2.0, 0.0, 2.0],

[1.0, 1.0, 1.0, 1.0]])

# 線形変換層初期化(バイアスなし)

torch.manual_seed(RANDOM_SEED)

query_weight = torch.nn.Linear(FEATURE_DIM, FEATURE_DIM, bias=False)

key_weight = torch.nn.Linear(FEATURE_DIM, FEATURE_DIM, bias=False)

value_weight = torch.nn.Linear(FEATURE_DIM, FEATURE_DIM, bias=False)

# Self-Attention計算

# Q, K, V生成(それぞれ独立した重み行列を使用)

query_matrix = query_weight(input_data)

key_matrix = key_weight(input_data)

value_matrix = value_weight(input_data)

# スケーリングドット積アテンション計算

raw_attention_scores = torch.matmul(query_matrix, key_matrix.T)

# スケーリング: 勾配消失を防ぐため√d_kで正規化

scaled_scores = raw_attention_scores / torch.sqrt(torch.tensor(query_matrix.size(-1), dtype=torch.float32))

# ソフトマックス: 各行の合計が1になるよう正規化

attention_weights = F.softmax(scaled_scores, dim=-1)

# 重み付き平均: アテンション重みでValueを統合

attention_output = torch.matmul(attention_weights, value_matrix)

# 結果出力

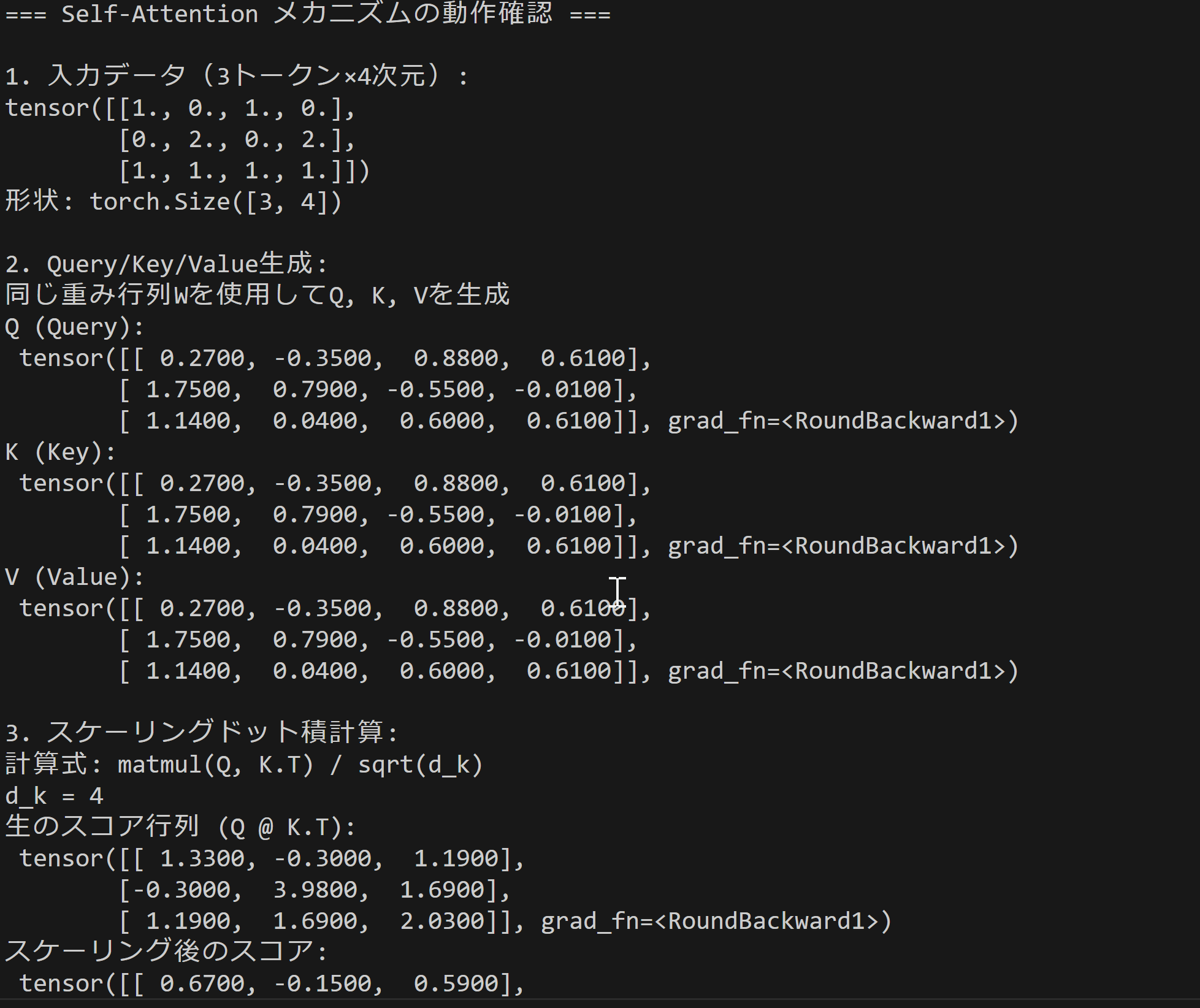

print("=== Self-Attention メカニズムの動作確認 ===")

print(f"\n1. 入力データ({TOKEN_COUNT}トークン×{FEATURE_DIM}次元):")

print(input_data)

print(f"形状: {input_data.shape}")

print("\n2. Query/Key/Value生成:")

print("それぞれ独立した重み行列を使用してQ, K, Vを生成")

print("Q (Query):\n", query_matrix.round(decimals=2))

print("K (Key):\n", key_matrix.round(decimals=2))

print("V (Value):\n", value_matrix.round(decimals=2))

print("\n3. スケーリングドット積計算:")

print("計算式: matmul(Q, K.T) / sqrt(d_k)")

print(f"d_k = {query_matrix.size(-1)}")

print("生のスコア行列 (Q @ K.T):\n", raw_attention_scores.round(decimals=2))

print("スケーリング後のスコア:\n", scaled_scores.round(decimals=2))

print("\n4. ソフトマックス重み付け:")

print("F.softmax()で各トークンの寄与度を調整")

print("アテンション重み:\n", attention_weights.round(decimals=3))

print("各行の合計(確認):", attention_weights.sum(dim=-1).round(decimals=3))

print("\n5. 最終出力:")

print("重み付き平均として新たなベクトルを出力")

print("計算式: weights @ V")

print("Attention出力:\n", attention_output.round(decimals=2))

print("\n=== 処理の要約 ===")

print("1. 入力をQ, K, Vに変換(それぞれ独立した重み行列を使用)")

print("2. QとKの内積でアテンションスコアを計算")

print("3. スケーリング(√d_k で除算)")

print("4. ソフトマックスで正規化(重みの合計=1)")

print("5. 重み付きでVを平均化して出力")

使用方法

- 上記のプログラムを実行する

実行結果として、Self-Attentionの各計算段階が順次表示される。

実験・探求のアイデア

設定変更実験

- 異なる重み行列の初期化(

SEEDの値を変更) - 入力次元数の変更(

Dを8, 16, 32に変更) - トークン数の変更(

Nを5, 10に変更)

実験要素

- 入力データパターンの変更(すべて同じ値、交互パターン、ランダム値)

- スケーリング係数の変更(

sqrt(D)を固定値に変更) - 表示精度の変更(

round(decimals=2)の値を1や4に変更)

探求のアイデア

- 入力データを類似度の高いトークンに変更し、アテンション重みの変化を観察する

- 特定のトークンを極端な値に設定し、他のトークンへの影響度を確認する

- アテンション重みの分布から、どのトークンが影響力を持つかを分析する

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)