FastText日本語単語ベクトル演算

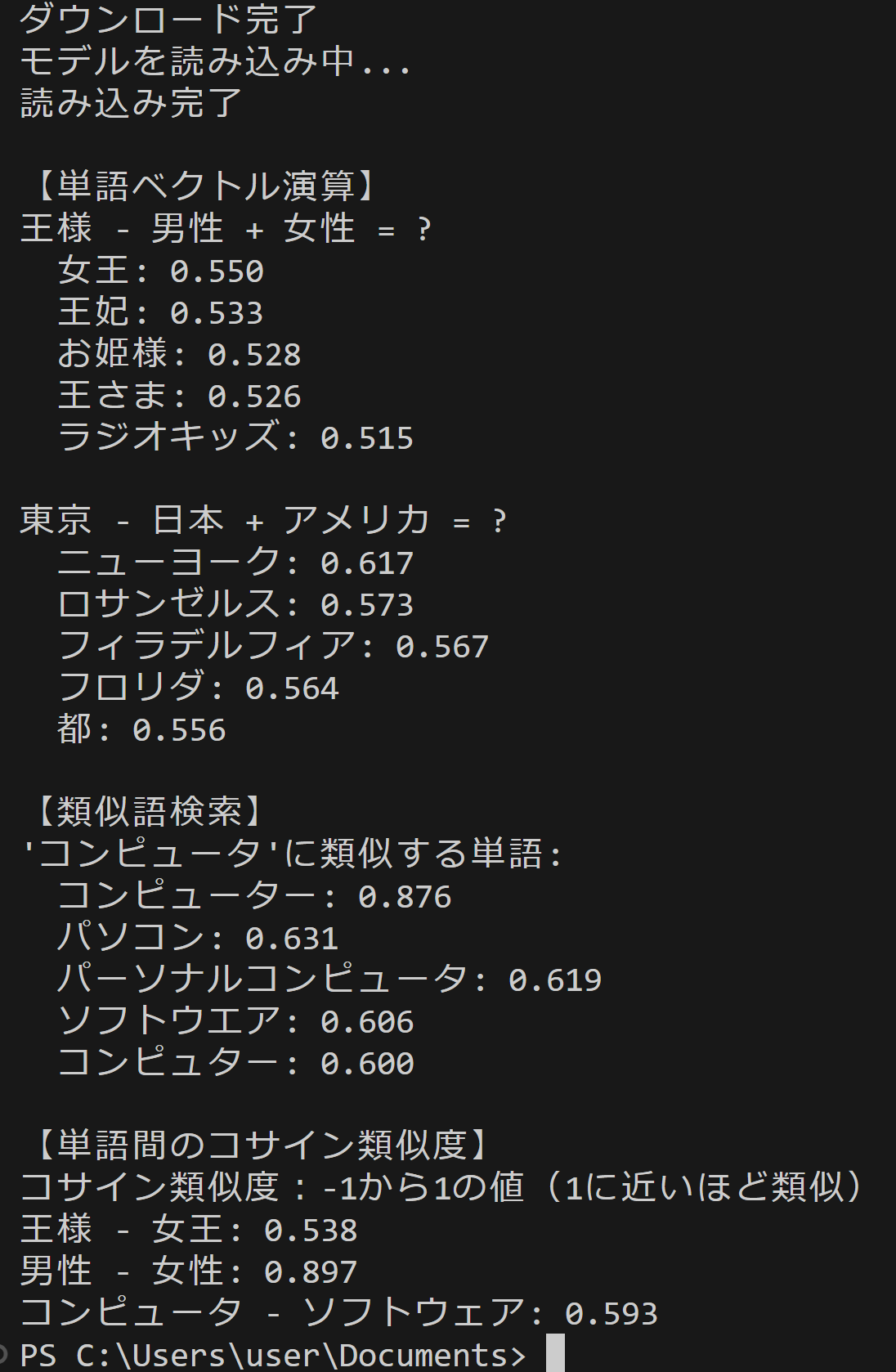

【概要】FastText技術を確認する。FastTextは、Bojanowski, P., Grave, E., Joulin, A., & Mikolov, T. (2017). Enriching Word Vectors with Subword Information. Transactions of the Association for Computational Linguistics, 5, 135-146.で提案された単語埋め込み手法である。この技術は単語を文字n-gramに分解して学習することで、学習データに含まれていない未知語に対しても、その文字構成からベクトル表現を生成。機械翻訳、感情分析、文書分類などの自然言語処理で活用される。ここでは、日本語単語ベクトルの演算を実行し、「王様-男性+女性=女王」のような意味的関係を確認する。

目次

1. Python開発環境,ライブラリ類

ここでは、最低限の事前準備について説明する。機械学習や深層学習を行う場合は、NVIDIA CUDA、Visual Studio、Cursorなどを追加でインストールすると便利である。これらについては別ページ https://www.kkaneko.jp/cc/dev/aiassist.htmlで詳しく解説しているので、必要に応じて参照してください。

Python 3.12 のインストール

インストール済みの場合は実行不要。

管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行する。管理者権限は、wingetの--scope machineオプションでシステム全体にソフトウェアをインストールするために必要である。

REM Python をシステム領域にインストール

winget install --scope machine --id Python.Python.3.12 -e --silent --accept-source-agreements --accept-package-agreements

REM Python のパス設定

set "PYTHON_PATH=C:\Program Files\Python312"

set "PYTHON_SCRIPTS_PATH=C:\Program Files\Python312\Scripts"

echo "%PATH%" | find /i "%PYTHON_PATH%" >nul

if errorlevel 1 setx PATH "%PATH%;%PYTHON_PATH%" /M >nul

echo "%PATH%" | find /i "%PYTHON_SCRIPTS_PATH%" >nul

if errorlevel 1 setx PATH "%PATH%;%PYTHON_SCRIPTS_PATH%" /M >nul【関連する外部ページ】

Python の公式ページ: https://www.python.org/

AI エディタ Windsurf のインストール

Pythonプログラムの編集・実行には、AI エディタの利用を推奨する。ここでは,Windsurfのインストールを説明する。

管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行して、Windsurfをシステム全体にインストールする。管理者権限は、wingetの--scope machineオプションでシステム全体にソフトウェアをインストールするために必要となる。

winget install --scope machine --id Codeium.Windsurf -e --silent --accept-source-agreements --accept-package-agreements【関連する外部ページ】

Windsurf の公式ページ: https://windsurf.com/

必要なPythonライブラリのインストール

コマンドプロンプトを管理者として実行(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行する。

pip install gensim numpy scikit-learn matplotlib japanize-matplotlib

2. プログラムコード

# プログラム名: FastText日本語単語ベクトル演算デモ

# 特徴技術名: FastText

# 出典: Bojanowski, P., Grave, E., Joulin, A., & Mikolov, T. (2017). Enriching word vectors with subword information. Transactions of the Association for Computational Linguistics, 5, 135-146.

# 特徴機能: サブワード情報を利用した単語埋め込み - 文字n-gramベースで単語を表現し、未知語にも対応可能な単語ベクトル生成

# 学習済みモデル: Common Crawl日本語FastTextモデル(cc.ja.300.vec.gz)- 157言語対応、300次元ベクトル、Common Crawlコーパスで学習済み、URL: https://dl.fbaipublicfiles.com/fasttext/vectors-crawl/cc.ja.300.vec.gz

# 方式設計:

# - 関連利用技術: Gensim(単語ベクトル操作・類似度計算)、scikit-learn(PCAによる次元削減)、matplotlib/japanize-matplotlib(可視化)

# - 入力と出力: 入力: なし(プログラム内で定義された単語を使用)、出力: コンソールへの類似度・演算結果表示、2次元可視化グラフ、result.txtファイル

# - 処理手順: 1)学習済みモデルのダウンロード・読み込み、2)単語ベクトル演算(加減算)、3)類似語検索、4)PCAによる2次元可視化、5)コサイン類似度計算

# - 前処理、後処理: 前処理: モデルファイルの存在確認とダウンロード、後処理: 可視化結果の表示と結果ファイル保存

# - 追加処理: 日本語フォント設定(japanize-matplotlib)による可視化の日本語対応

# - 調整を必要とする設定値: RANDOM_SEED(PCAの再現性制御、デフォルト42)、TOPN(類似語表示数、デフォルト5)

# 将来方策: インタラクティブな単語入力機能を追加し、ユーザが任意の単語でベクトル演算を実行可能にする

# その他の重要事項: 初回実行時は約2GBのモデルファイルをダウンロードするため時間がかかる

# 前準備: pip install gensim numpy scikit-learn matplotlib japanize-matplotlib

import os

import urllib.request

import gensim

import numpy as np

from sklearn.decomposition import PCA

import matplotlib.pyplot as plt

import japanize_matplotlib

# 定数定義

RANDOM_SEED = 42 # 再現性のための乱数シード

MODEL_URL = 'https://dl.fbaipublicfiles.com/fasttext/vectors-crawl/cc.ja.300.vec.gz'

MODEL_FILE = 'cc.ja.300.vec.gz'

RESULT_FILE = 'result.txt'

TOPN = 5 # 類似語検索の表示数

# 可視化設定

FIG_SIZE = (10, 8)

SCATTER_SIZE = 200

FONT_SIZE_ANNOTATION = 16

FONT_SIZE_TITLE = 18

FONT_SIZE_LABEL = 14

# 演算対象の単語設定

VECTOR_CALC_WORDS = [

(['王様', '女性'], ['男性'], '王様 - 男性 + 女性 = ?'),

(['東京', 'アメリカ'], ['日本'], '東京 - 日本 + アメリカ = ?')

]

SIMILAR_TARGET = 'コンピュータ'

VISUALIZATION_WORDS = ['王様', '女王', '男性', '女性', '王子', '王女']

SIMILARITY_PAIRS = [('王様', '女王'), ('男性', '女性'), ('コンピュータ', 'ソフトウェア')]

# 乱数シード設定

np.random.seed(RANDOM_SEED)

# 結果記録用関数

def log_result(message, results_list):

print(message)

results_list.append(message)

# プログラム開始時の説明

print('FastText日本語単語ベクトル演算デモ')

print('このプログラムは日本語の単語ベクトルを使用して、単語の演算や類似度計算を行います。')

print('初回実行時は約2GBのモデルファイルをダウンロードします。')

print()

# 処理結果を保存するためのリスト

results = []

results.append('FastText日本語単語ベクトル演算デモ - 実行結果')

results.append('')

# モデルのダウンロードと読み込み

log_result('日本語FastText学習済みモデルをダウンロード中...', results)

if not os.path.exists(MODEL_FILE):

try:

urllib.request.urlretrieve(MODEL_URL, MODEL_FILE)

log_result('ダウンロード完了', results)

except Exception as e:

print(f'モデルのダウンロードに失敗しました: {MODEL_URL}')

print(f'エラー: {e}')

exit()

log_result('モデルを読み込み中...', results)

try:

model = gensim.models.KeyedVectors.load_word2vec_format(MODEL_FILE, binary=False)

log_result('読み込み完了', results)

except Exception as e:

print(f'モデルの読み込みに失敗しました: {MODEL_FILE}')

print(f'エラー: {e}')

exit()

# メイン処理

log_result('', results)

log_result('【単語ベクトル演算】', results)

# ベクトル演算

for positive, negative, description in VECTOR_CALC_WORDS:

if all(word in model for word in positive + negative):

result = model.most_similar(positive=positive, negative=negative, topn=TOPN)

log_result(description, results)

for word, score in result:

log_result(f' {word}: {score:.3f}', results)

log_result('', results)

# 類似語検索

log_result('【類似語検索】', results)

if SIMILAR_TARGET in model:

similar_words = model.most_similar(SIMILAR_TARGET, topn=TOPN)

log_result(f"'{SIMILAR_TARGET}'に類似する単語:", results)

for word, score in similar_words:

log_result(f' {word}: {score:.3f}', results)

# ベクトル空間の可視化

word_vectors = []

valid_words = []

for word in VISUALIZATION_WORDS:

if word in model:

word_vectors.append(model[word])

valid_words.append(word)

if len(word_vectors) > 1:

pca = PCA(n_components=2, random_state=RANDOM_SEED)

vectors_2d = pca.fit_transform(word_vectors)

plt.figure(figsize=FIG_SIZE)

for i, word in enumerate(valid_words):

plt.scatter(vectors_2d[i, 0], vectors_2d[i, 1], s=SCATTER_SIZE)

plt.annotate(word, (vectors_2d[i, 0], vectors_2d[i, 1]),

xytext=(5, 5), textcoords='offset points', fontsize=FONT_SIZE_ANNOTATION)

plt.title('日本語単語ベクトルの2次元可視化', fontsize=FONT_SIZE_TITLE)

plt.xlabel('第1主成分', fontsize=FONT_SIZE_LABEL)

plt.ylabel('第2主成分', fontsize=FONT_SIZE_LABEL)

plt.grid(True, alpha=0.3)

plt.tight_layout()

plt.show()

# 単語間のコサイン類似度

log_result('', results)

log_result('【単語間のコサイン類似度】', results)

log_result('コサイン類似度:-1から1の値(1に近いほど類似)', results)

for w1, w2 in SIMILARITY_PAIRS:

if w1 in model and w2 in model:

similarity = model.similarity(w1, w2)

log_result(f'{w1} - {w2}: {similarity:.3f}', results)

# 結果をファイルに保存

with open(RESULT_FILE, 'w', encoding='utf-8') as f:

f.write('\n'.join(results))

print(f'\n{RESULT_FILE}に保存しました')

3. 使用方法

- 上記のプログラムを実行する

- 初回実行時は学習済みモデル(約4GB)のダウンロードに時間がかかる。2回目以降は読み込みのみとなる。

4. 実験・探求のアイデア

AIモデル選択

FastText以外に以下の日本語単語ベクトルモデルが利用可能である:

- 東北大学日本語Wikipediaモデル(entity_vector.model.bin):200次元、日本語特化

- 白ヤギコーポレーション日本語モデル:50次元、軽量モデル

追加実験

1. 単語ベクトル演算の組み合わせ変更:

- 「医者 - 男性 + 女性」で性別による職業表現の違いを観察

- 「パリ - フランス + 日本」で首都の関係性を検証

- 「寿司 - 日本 + イタリア」で文化的要素の変換を試行

2. 類似度の閾値実験:

- topnパラメータを1〜20に変更し、類似語の広がりを観察

- 異なるカテゴリの単語間の類似度を測定

3. 可視化する単語群の変更:

- 動物:['犬', '猫', '鳥', '魚', '馬', '牛']

- 色:['赤', '青', '緑', '黄', '白', '黒']

- 感情:['喜び', '悲しみ', '怒り', '恐れ', '驚き', '嫌悪']

体験・実験・探求のアイデア

未知語への対応検証:造語や新語を入力し、FastTextの処理を観察する。

時代による意味変化の推測:古語と現代語の類似度を考察する。

専門用語の関係性発見:特定分野の専門用語群を入力し、専門用語間の関連性を分析する。

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)