ONNX機械学習モデル変換・推論

【概要】scikit-learnモデルをONNX形式に変換し推論性能を比較する。ONNXの相互運用性と効果を確認。RandomForestClassifierでの変換精度と速度変化を確認。

目次

概要

背景と課題

機械学習フレームワーク(TensorFlow、PyTorch、scikit-learn等)は独自のモデル形式を持つため、フレームワーク間でのモデル共有には互換性の課題が存在する。学習環境と推論環境が異なる場合、モデルの移行が困難になる。

ONNX(Open Neural Network Exchange)の役割

ONNXは異なる機械学習フレームワーク間でのモデル相互運用を可能にするオープンスタンダード形式である。モデルを計算グラフ(ノードとエッジで表現される処理の流れ図)として表現し、標準化されたオペレーター(数学的演算処理)と型システム(データ型の定義体系)を使用してモデル構造を定義する。

出典: Bai, J., Lu, F., Zhang, K., et al. (2019). ONNX: Open Neural Network Exchange. GitHub repository. https://github.com/onnx/onnx

技術的制約

全てのモデルタイプがサポートされるわけではなく、フレームワーク固有の機能は変換時に制限される場合がある。scikit-learnでは主要な分類・回帰アルゴリズムがサポートされている。

応用分野

クラウドで学習したモデルをエッジデバイスで実行、Webブラウザでの機械学習推論、異なる開発チーム間でのモデル共有、モバイルアプリケーションへのモデルデプロイメント、リアルタイム推論システムでの活用が可能である。

学習目標

scikit-learnで学習したモデルをONNX形式に変換し、推論速度と精度の変化を測定することで、モデル変換技術の特性を理解する。

事前準備

ここでは、最低限の事前準備について説明する。機械学習や深層学習を行う場合は、NVIDIA CUDA、Visual Studio、Cursorなどを追加でインストールすると便利である。これらについては別ページ https://www.kkaneko.jp/cc/dev/aiassist.htmlで詳しく解説しているので、必要に応じて参照してください。

Python 3.12 のインストール

インストール済みの場合は実行不要。

管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行する。管理者権限は、wingetの--scope machineオプションでシステム全体にソフトウェアをインストールするために必要である。

REM Python をシステム領域にインストール

winget install --scope machine --id Python.Python.3.12 -e --silent --accept-source-agreements --accept-package-agreements

REM Python のパス設定

set "PYTHON_PATH=C:\Program Files\Python312"

set "PYTHON_SCRIPTS_PATH=C:\Program Files\Python312\Scripts"

echo "%PATH%" | find /i "%PYTHON_PATH%" >nul

if errorlevel 1 setx PATH "%PATH%;%PYTHON_PATH%" /M >nul

echo "%PATH%" | find /i "%PYTHON_SCRIPTS_PATH%" >nul

if errorlevel 1 setx PATH "%PATH%;%PYTHON_SCRIPTS_PATH%" /M >nul【関連する外部ページ】

Python の公式ページ: https://www.python.org/

AI エディタ Windsurf のインストール

Pythonプログラムの編集・実行には、AI エディタの利用を推奨する。ここでは,Windsurfのインストールを説明する。

管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行して、Windsurfをシステム全体にインストールする。管理者権限は、wingetの--scope machineオプションでシステム全体にソフトウェアをインストールするために必要となる。

winget install --scope machine --id Codeium.Windsurf -e --silent --accept-source-agreements --accept-package-agreements【関連する外部ページ】

Windsurf の公式ページ: https://windsurf.com/

必要なPythonパッケージのインストール

コマンドプロンプトを管理者として実行(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行する。

pip install scikit-learn skl2onnx onnxruntime numpy

プログラムコード

# ONNX変換による機械学習モデル動作確認プログラム

# 特徴技術名: ONNX (Open Neural Network Exchange)

# 出典: Bai, J., Lu, F., Zhang, K., et al. (2019). ONNX: Open Neural Network Exchange. arXiv preprint arXiv:1712.03213.

# 特徴機能: クロスプラットフォーム・クロスフレームワークでのモデル相互運用性。異なる機械学習フレームワーク間でモデルを共有・実行可能にする標準フォーマット

# 学習済みモデル: なし(プログラム内でRandomForestClassifierを学習)

# 方式設計:

# - 関連利用技術: scikit-learn (機械学習ライブラリ、RandomForestClassifierを提供)、skl2onnx (scikit-learnモデルのONNX変換ツール)、ONNX Runtime (推論エンジン)

# - 入力と出力: 入力: Irisデータセット(プログラム内で自動読み込み)、出力: モデル変換と推論結果の確認

# - 処理手順: 1) Irisデータセットの読み込みと分割、2) RandomForestClassifierの学習、3) scikit-learnモデルでの推論、4) ONNXフォーマットへの変換、5) ONNX Runtimeでの推論、6) 両モデルの推論結果比較

# - 前処理、後処理: 前処理: データ型をfloat32に変換(ONNX推論時)、後処理: 推論結果の一致確認

# - 追加処理: なし

# - 調整を必要とする設定値: N_ESTIMATORS (RandomForestの決定木数、デフォルト10)、RANDOM_SEED (再現性のための乱数シード、デフォルト42)

# 将来方策: N_ESTIMATORSの最適値を決定するため、複数の値で精度評価する機能の実装

# その他の重要事項: Windows環境での動作確認済み

# 前準備: pip install scikit-learn skl2onnx onnxruntime numpy

import numpy as np

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import train_test_split

from skl2onnx import convert_sklearn

from skl2onnx.common.data_types import FloatTensorType

import onnxruntime as ort

# 定数定義

RANDOM_SEED = 42 # 再現性のための乱数シード

N_ESTIMATORS = 10 # RandomForestの決定木数

TEST_SIZE = 0.25 # テストデータの割合

TARGET_OPSET = 12 # ONNX opsetバージョン

# プログラム開始時の概要表示

print('=== ONNX変換による機械学習モデル動作確認プログラム ===')

print('scikit-learnのRandomForestClassifierをONNX形式に変換し、')

print('両形式での推論結果の一致を確認します。')

print()

print('操作方法: プログラムは自動実行されます。')

print('注意事項: 必要なライブラリがインストールされていることを確認してください。')

print()

# データセット読み込みと分割

X, y = load_iris(return_X_y=True)

X_train, X_test, y_train, y_test = train_test_split(

X, y, test_size=TEST_SIZE, random_state=RANDOM_SEED

)

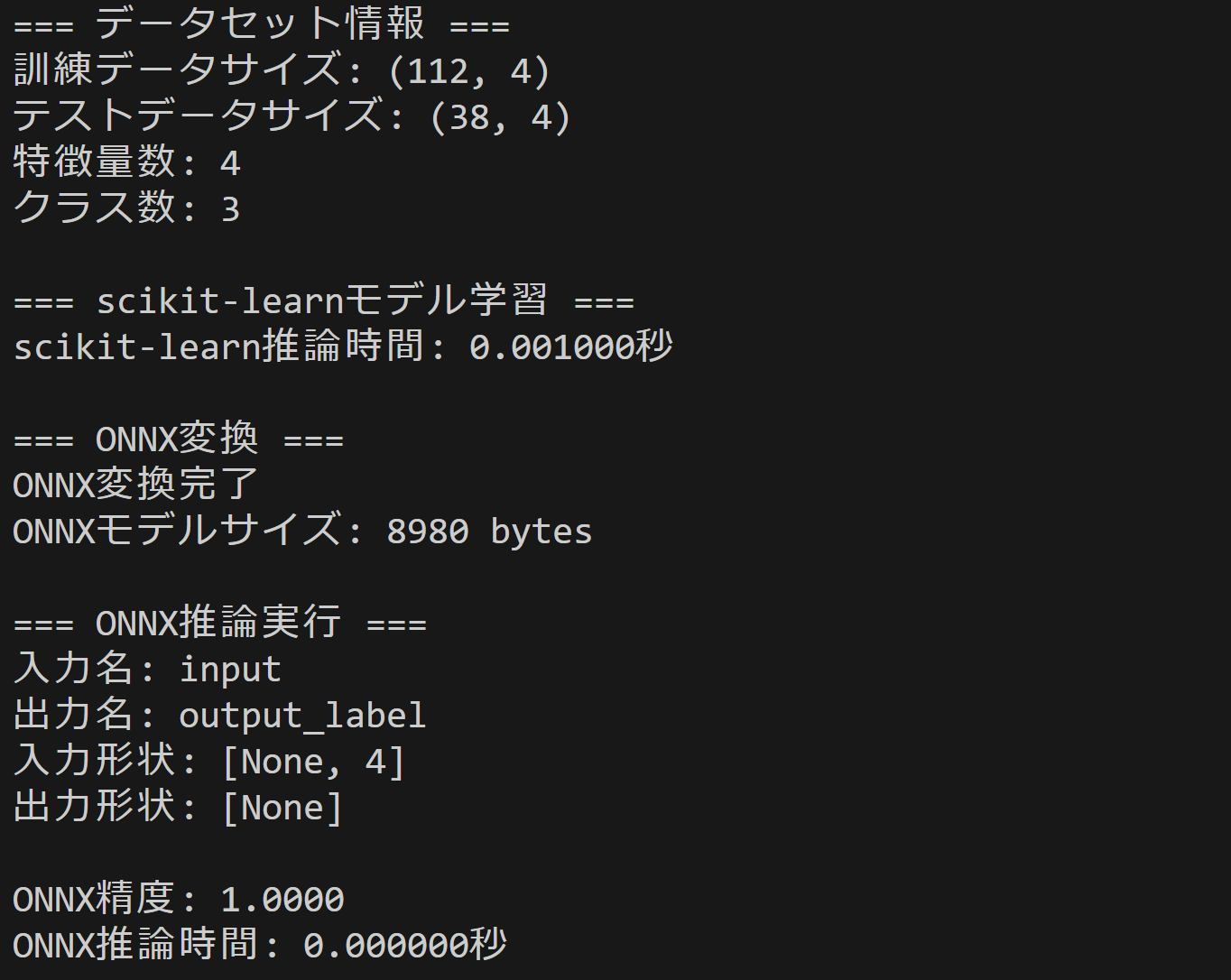

print('=== データセット情報 ===')

print(f'訓練データサイズ: {X_train.shape}')

print(f'テストデータサイズ: {X_test.shape}')

print(f'特徴量数: {X.shape[1]}')

print(f'クラス数: {len(np.unique(y))}')

print()

# メイン処理

print('=== scikit-learnモデル学習 ===')

sklearn_model = RandomForestClassifier(

n_estimators=N_ESTIMATORS, random_state=RANDOM_SEED

)

sklearn_model.fit(X_train, y_train)

# scikit-learn推論

sklearn_pred = sklearn_model.predict(X_test)

print(f'scikit-learn予測結果の形状: {sklearn_pred.shape}')

print(f'scikit-learn予測結果のデータ型: {sklearn_pred.dtype}')

# 精度計算(正確性のため明示的にint型に変換)

sklearn_pred = sklearn_pred.astype(np.int64)

y_test = y_test.astype(np.int64)

sklearn_accuracy = np.sum(sklearn_pred == y_test) / len(y_test)

print(f'scikit-learn精度: {sklearn_accuracy:.4f}')

print()

print('=== ONNX変換 ===')

initial_types = [('input', FloatTensorType([None, X.shape[1]]))]

onnx_model = convert_sklearn(

sklearn_model,

initial_types=initial_types,

target_opset=TARGET_OPSET

)

print('ONNX変換完了')

print(f'ONNXモデルサイズ: {len(onnx_model.SerializeToString())} bytes')

print(f'ONNX opsetバージョン: {TARGET_OPSET}')

print()

print('=== ONNX推論実行 ===')

# CPUプロバイダーを明示的に指定

onnx_session = ort.InferenceSession(

onnx_model.SerializeToString(),

providers=['CPUExecutionProvider']

)

# 入出力情報の詳細確認

input_name = onnx_session.get_inputs()[0].name

print(f'入力名: {input_name}')

print(f'入力形状: {onnx_session.get_inputs()[0].shape}')

print(f'入力データ型: {onnx_session.get_inputs()[0].type}')

# 出力情報の確認

print(f'出力数: {len(onnx_session.get_outputs())}')

for i, output in enumerate(onnx_session.get_outputs()):

print(f'出力[{i}]名: {output.name}')

print(f'出力[{i}]形状: {output.shape}')

print(f'出力[{i}]データ型: {output.type}')

print(f'実行プロバイダー: {onnx_session.get_providers

使用方法

- 上記のプログラムコードを実行する

実験・探求のアイデア

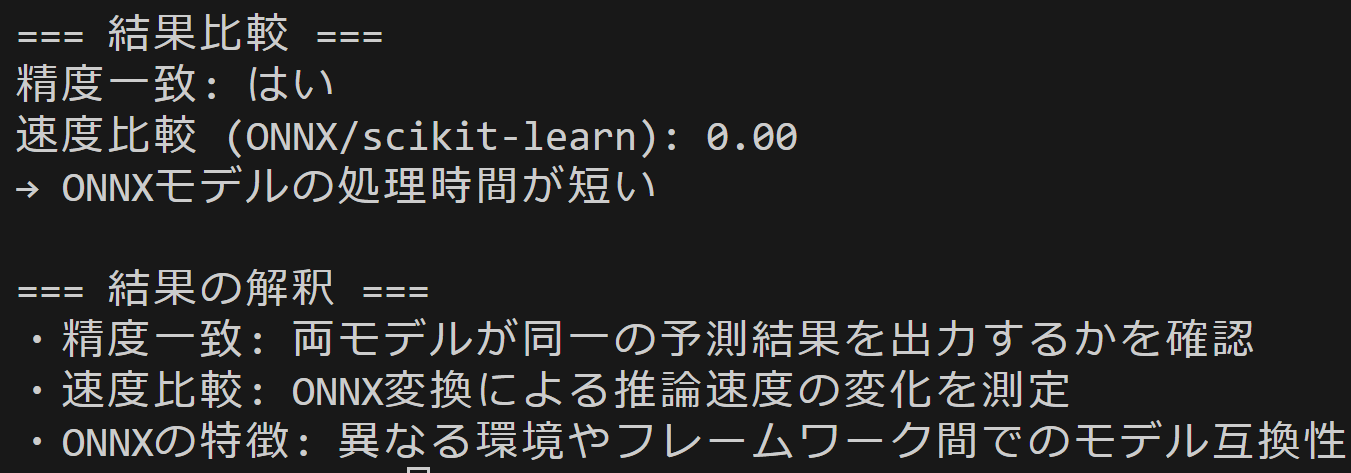

機械学習モデル選択の実験

- RandomForestClassifier: 決定木アンサンブル手法(複数の決定木を組み合わせた分類器)

- SVM: サポートベクターマシン(データを分離する最適な境界面を見つける分類器)

- LogisticRegression: 線形分類器(線形関数を用いた確率的分類器)

- MLPClassifier: 多層パーセプトロン(複数の層からなるニューラルネットワーク)

各モデルでONNX変換時の速度変化を比較し、モデルの種類による違いを観察する。

追加実験

- データセット変更: Iris以外のデータセット(Wine、Breast Cancer等)での性能比較

- モデルサイズ変更: n_estimatorsを10、50、100に変更し、モデル複雑度と変換効果の関係を調査

- 推論回数増加: 1000回の推論を実行し、累積時間での性能差を測定

研究のアイデア

- 変換精度の検証: 異なるデータセットでの精度保持率を調査し、ONNX変換の信頼性を確認

- モデル保存・読み込み: ONNXモデルをファイル保存し、別のプログラムで読み込む実験

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)