日本語対応のLLM,チャットボット(ELYZA-japanese-Llama-2-7b,transformer,Python,PyTorch を使用)(Windows 上)

前準備

Python のインストール(Windows上)

注:既にPython(バージョン3.12を推奨)がインストール済みの場合は,この手順は不要である.

winget(Windowsパッケージマネージャー)を使用してインストールを行う

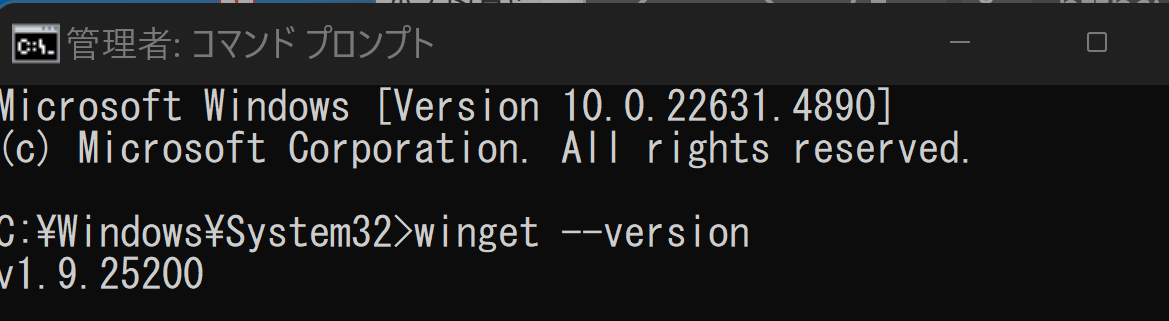

- Windowsで,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。 - winget(Windowsパッケージマネージャー)が利用可能か確認する:

winget --version

- Pythonのインストール(下のコマンドにより Python 3.12 がインストールされる).

REM Python 3.12 をシステム領域にインストール winget install --scope machine --id Python.Python.3.12 -e --silent --accept-source-agreements --accept-package-agreements REM パス長制限の解除 reg add "HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\FileSystem" /v LongPathsEnabled /t REG_DWORD /d 1 /f reg query "HKLM\SYSTEM\CurrentControlSet\Control\FileSystem" /v LongPathsEnabled REM Python のパス set "INSTALL_PATH=C:\Program Files\Python312" echo "%PATH%" | find /i "%INSTALL_PATH%" >nul if errorlevel 1 setx PATH "%PATH%;%INSTALL_PATH%" /M >nul echo "%PATH%" | find /i "%INSTALL_PATH%\Scripts" >nul if errorlevel 1 setx PATH "%PATH%;%INSTALL_PATH%\Scripts" /M >nul - Python詳細ガイド:Pythonまとめ »

【関連する外部サイト】

【サイト内の関連ページ】

Visual Studio 2022 Build Toolsとランタイムのインストール

管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行する。管理者権限は、wingetの--scope machineオプションでシステム全体にソフトウェアをインストールするために必要である。

REM Visual Studio 2022 Build Toolsとランタイムをシステム領域にインストール

winget install --scope machine --wait --accept-source-agreements --accept-package-agreements Microsoft.VisualStudio.2022.BuildTools Microsoft.VCRedist.2015+.x64

REM インストーラーとインストールパスの設定

set "VS_INSTALLER=C:\Program Files (x86)\Microsoft Visual Studio\Installer\vs_installer.exe"

set VS_PATH="C:\Program Files (x86)\Microsoft Visual Studio\2022\BuildTools"

REM C++開発ワークロードのインストール

"%VS_INSTALLER%" modify --installPath "%VS_PATH%" --add Microsoft.VisualStudio.Workload.VCTools --includeRecommended --quiet --norestart

"%VS_INSTALLER%" modify --installPath "%VS_PATH%" --add Microsoft.VisualStudio.Component.VC.Tools.x86.x64 --includeRecommended --quiet --norestart

"%VS_INSTALLER%" modify --installPath "%VS_PATH%" --add Microsoft.VisualStudio.Component.Windows11SDK.22621 --includeRecommended --quiet --norestart

PyTorch のインストール(Windows 上)

Windows 環境に PyTorch をインストールする手順を解説します.主に pip を使用する方法と Miniconda (conda) を使用する方法を紹介します.

1. 実行前の準備

インストール作業を行う前に,以下の準備と確認を行ってください.

- 管理者権限でのコマンドプロンプト/Miniconda Prompt 起動:

インストールコマンドは管理者権限で実行することを推奨します.Windows キーを押し「cmd」または「Miniconda Prompt」と入力し,「管理者として実行」を選択して起動してください. - Python 環境:

システムに Python がインストールされ,pip または Miniconda (conda) が利用可能な状態であることを確認してください. - NVIDIA CUDA Toolkit (GPU版を利用する場合):

PyTorch で NVIDIA GPU を利用する場合は,対応する GPU と,適切なバージョンの NVIDIA CUDA Toolkit が事前にインストールされている必要があります.- CUDA バージョンの確認: コマンドプロンプト等で

nvcc --versionを実行し,バージョンを確認します.この例では CUDA 11.8 がインストール済みであると仮定します. - 互換性の確認: インストールする PyTorch と互換性のある CUDA バージョンを PyTorch 公式サイトで確認してください.

- CUDA バージョンの確認: コマンドプロンプト等で

2. PyTorch 公式サイトでのコマンド確認

【重要】 PyTorch のインストールコマンドは,OS,パッケージ管理ツール (pip/conda),Python バージョン,CUDA バージョンによって異なります.必ず以下の PyTorch 公式サイトで,ご自身の環境に合った最新のインストールコマンドを確認・実行してください.

- PyTorch 公式サイト (インストールページ): https://pytorch.org/get-started/locally/

以下の手順で示すコマンドは,特定の環境(例: CUDA 11.8)における一例です.

3. pip を使用したインストール

Python 標準のパッケージ管理ツール pip を使用する方法です.

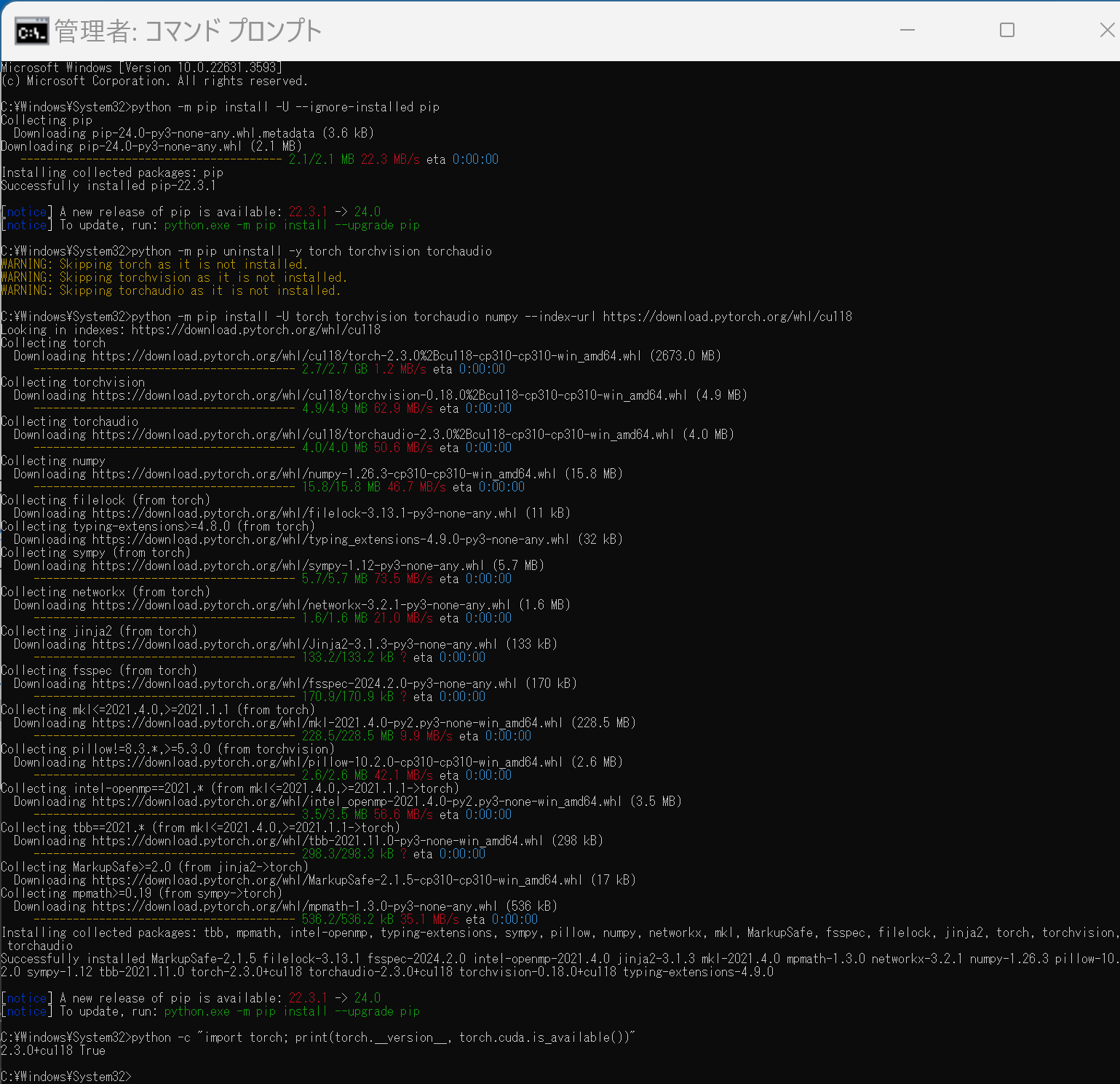

(1) pip の更新 (任意)

python -m pip install --upgrade pip

(2) 既存の PyTorch 関連パッケージのアンインストール (推奨)

古いバージョン等がインストールされている場合に実行します.

python -m pip uninstall torch torchvision torchaudio

# 必要に応じて torchtext, xformers などもアンインストール

# python -m pip uninstall torchtext xformers

(3) PyTorch のインストール

【注意】 必ず公式サイトで生成したコマンドを使用してください.以下は CUDA 11.8 環境向けの 一例 です.

# 公式サイトで取得した pip install コマンドを実行

# 例 (CUDA 11.8):

python -m pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

(4) インストールの確認

python -c "import torch; print(f'PyTorch Version: {torch.__version__}'); print(f'CUDA Available: {torch.cuda.is_available()}')"

CUDA Available: True と表示されれば,GPU が正しく認識されています (GPU 環境の場合).

4. Miniconda (conda) を使用したインストール

データサイエンス環境構築によく使われる Miniconda (または Anaconda) を使用している場合は,conda コマンドでもインストールできます.

注意点:

conda 環境では,PyTorch のような複雑な依存関係を持つライブラリの場合,pip よりも依存関係の問題が発生することがあります.問題が発生した場合は,pip を使用したインストール(セクション3)を試すことを検討してください.

(1) Miniconda Prompt (または Anaconda Prompt) の起動

管理者として実行で Miniconda Prompt を起動します.

(2) PyTorch のインストール

【注意】 必ず公式サイトで Package に Conda を選択し,生成されたコマンドを使用してください.以下は CUDA 11.8 環境向けの 一例 です.

# 公式サイトで取得した conda install コマンドを実行

# 例 (CUDA 11.8):

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

-c pytorch -c nvidia は,PyTorch と NVIDIA の公式 conda チャネルを指定しています.

(3) インストールの確認

python -c "import torch; print(f'PyTorch Version: {torch.__version__}'); print(f'CUDA Available: {torch.cuda.is_available()}')"

関連情報

【サイト内の関連ページ】

【関連する外部ページ】

- PyTorch 公式サイト (インストール): https://pytorch.org/get-started/locally/

- PyTorch 公式サイト (トップ): https://pytorch.org/

ELYZA-japanese-Llama-2-7b の実行(Windows 上)

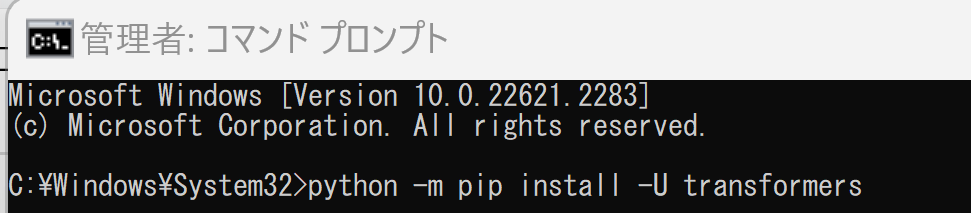

transformers のインストール(Windows 上)

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。 - インストール

python -m pip install -U transformers

ELYZA-japanese-Llama-2-7b の実行(Windows 上)

実行には、必要なメモリを備えたGPUが必要です。

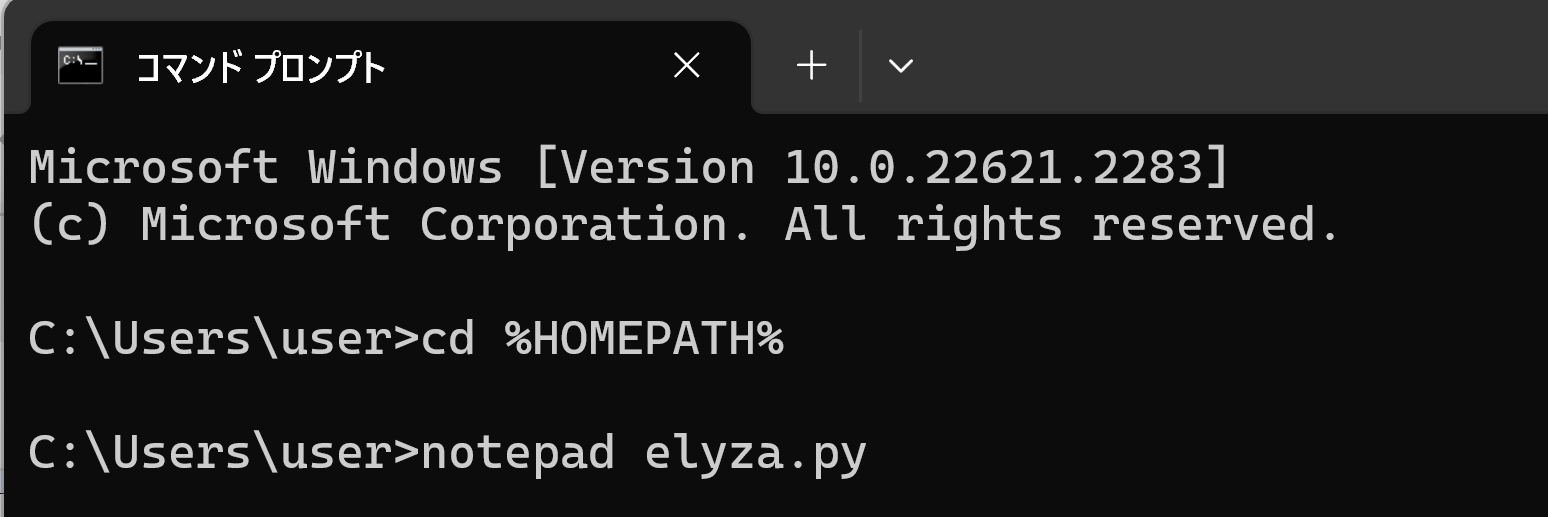

- Windows で,コマンドプロンプトを実行

- エディタを起動

cd /d c:%HOMEPATH% notepad elyza.py

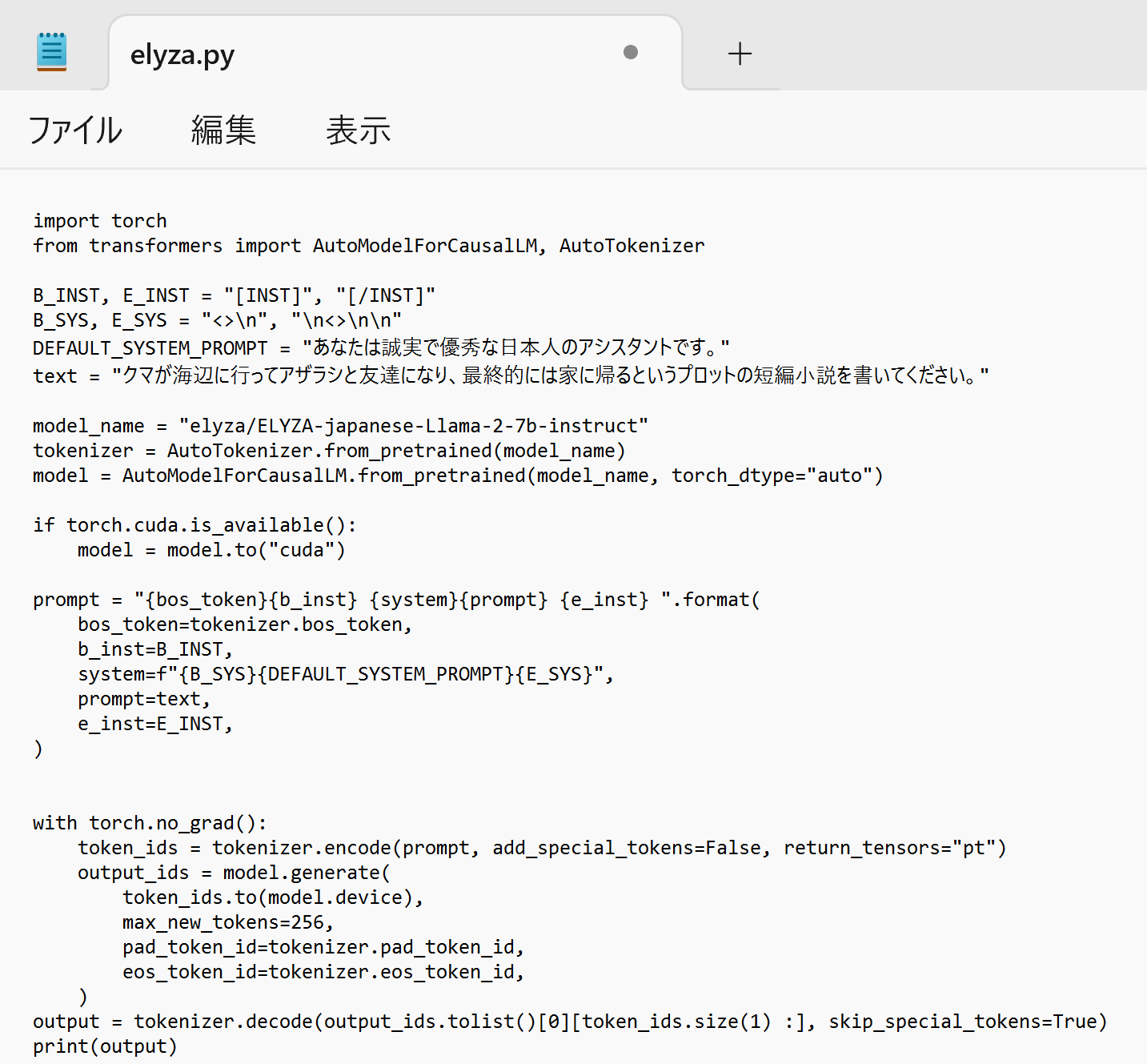

- エディタで,次のプログラムを保存

このプログラムは, 公式の GitHub のページ: https://huggingface.co/elyza/ELYZA-japanese-Llama-2-7bで公開されていたものをそのまま使用している.

import torch from transformers import AutoModelForCausalLM, AutoTokenizer B_INST, E_INST = "[INST]", "[/INST]" B_SYS, E_SYS = "<>\n", "\n< >\n\n" DEFAULT_SYSTEM_PROMPT = "あなたは誠実で優秀な日本人のアシスタントです。" text = "クマが海辺に行ってアザラシと友達になり、最終的には家に帰るというプロットの短編小説を書いてください。" model_name = "elyza/ELYZA-japanese-Llama-2-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype="auto") if torch.cuda.is_available(): model = model.to("cuda") prompt = "{bos_token}{b_inst} {system}{prompt} {e_inst} ".format( bos_token=tokenizer.bos_token, b_inst=B_INST, system=f"{B_SYS}{DEFAULT_SYSTEM_PROMPT}{E_SYS}", prompt=text, e_inst=E_INST, ) with torch.no_grad(): token_ids = tokenizer.encode(prompt, add_special_tokens=False, return_tensors="pt") output_ids = model.generate( token_ids.to(model.device), max_new_tokens=256, pad_token_id=tokenizer.pad_token_id, eos_token_id=tokenizer.eos_token_id, ) output = tokenizer.decode(output_ids.tolist()[0][token_ids.size(1) :], skip_special_tokens=True) print(output)

- Python プログラムの実行

Python プログラムの実行

- Windows では python (Python ランチャーは py)

- Ubuntu では python3

Python 開発環境(Jupyter Qt Console, Jupyter ノートブック (Jupyter Notebook), Jupyter Lab, Nteract, Spyder, PyCharm, PyScripterなど)も便利である.

Python のまとめ: 別ページ »にまとめ

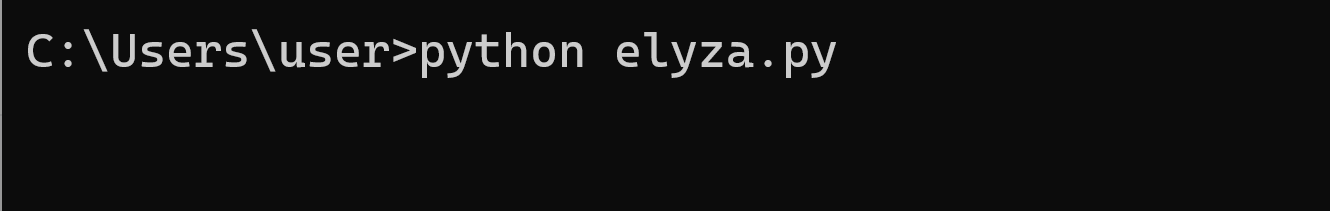

プログラムを elyza.pyのようなファイル名で保存したので, 「python elyza.py」のようなコマンドで行う.

結果が出るまでしばらく待つ.

python elyza.py

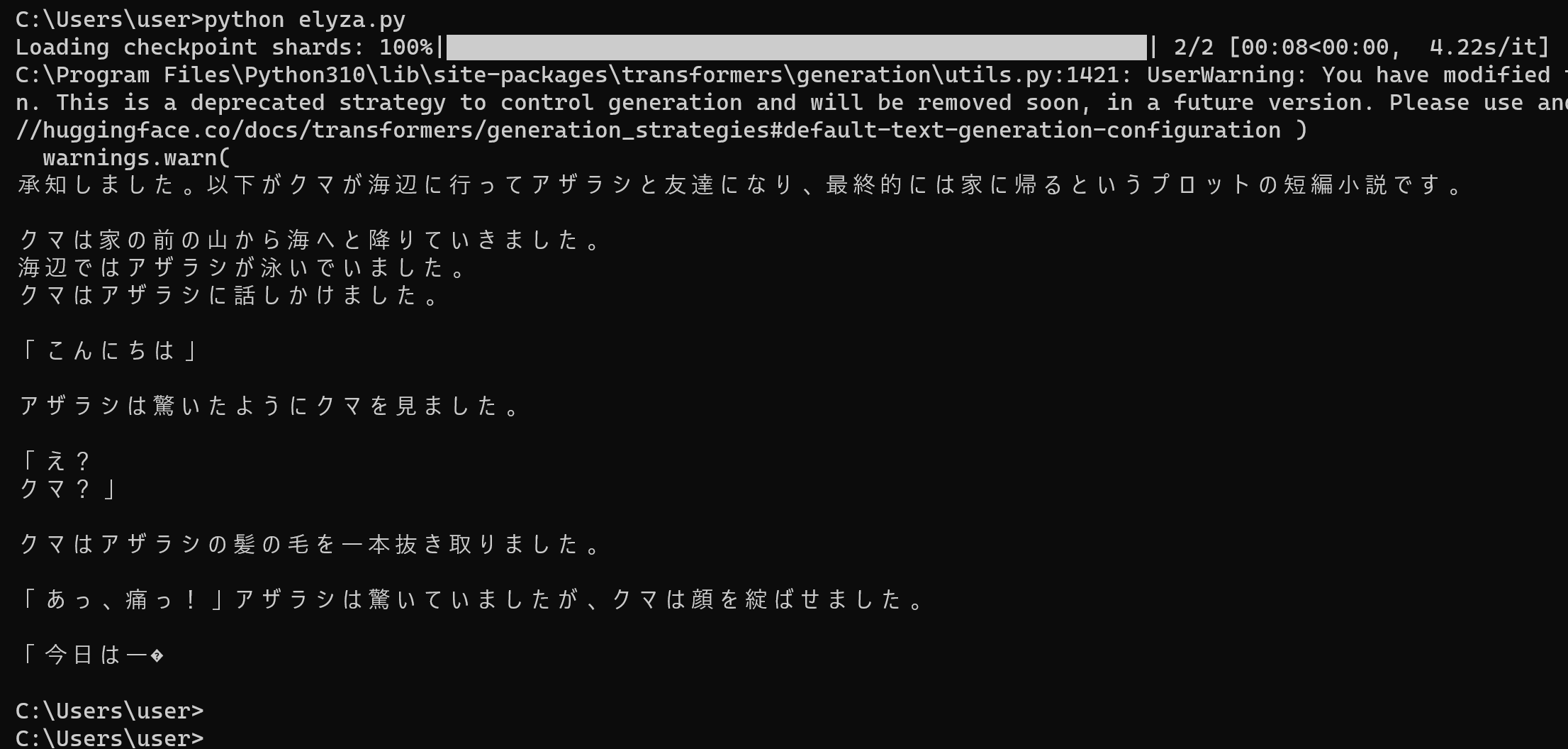

- 結果の確認

ELYZA-japanese-Llama-2-7b を用いて対話を行うプログラム

実行には、必要なメモリを備えたGPUが必要です。

- Windows で,コマンドプロンプトを実行

- エディタを起動

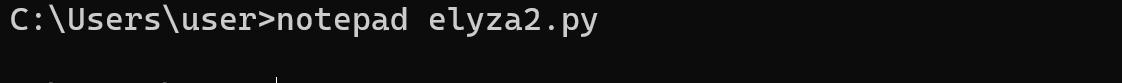

cd /d c:%HOMEPATH% notepad elyza2.py

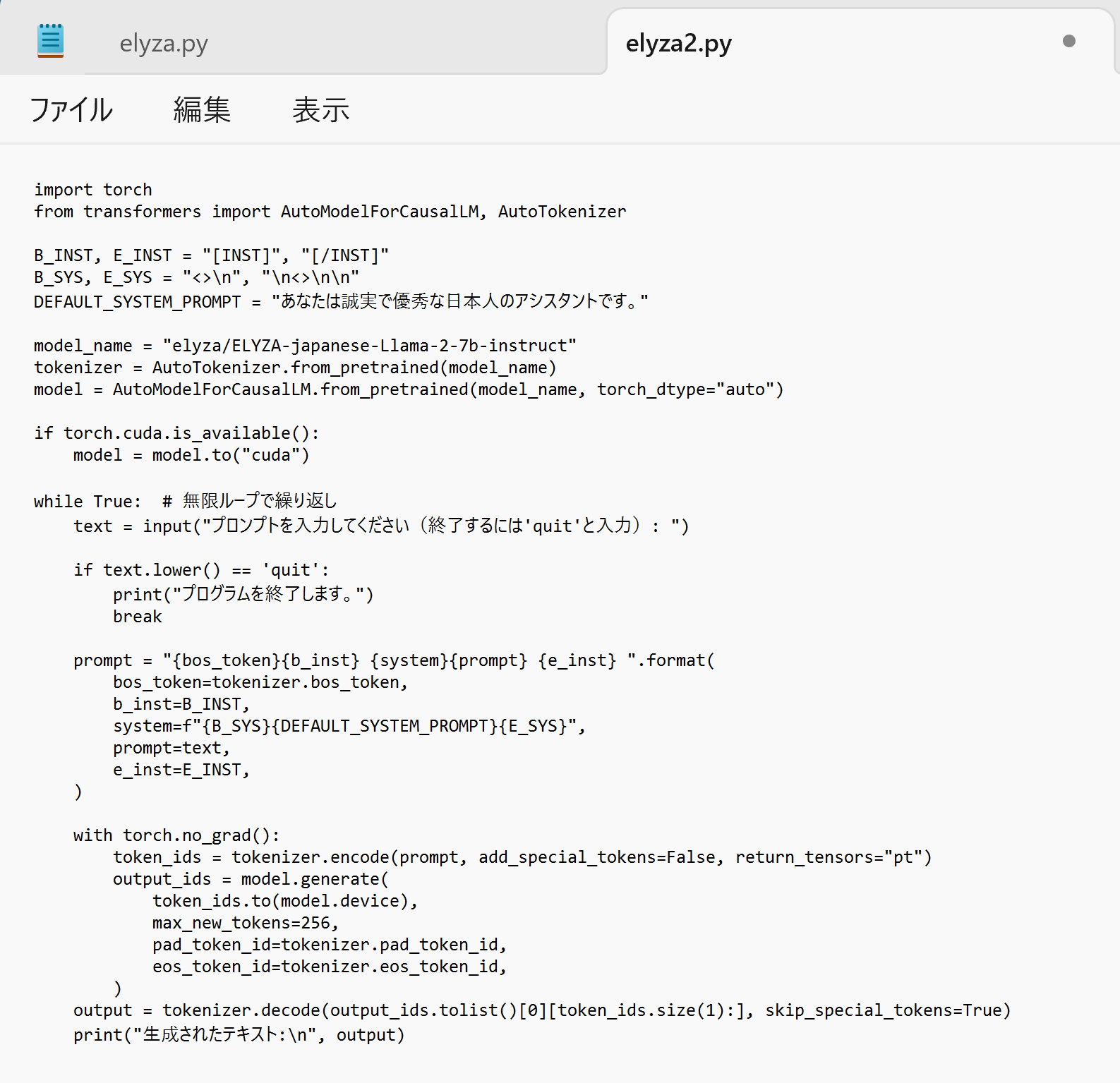

- エディタで,次のプログラムを保存

このプログラムは, 公式の GitHub のページ: https://huggingface.co/elyza/ELYZA-japanese-Llama-2-7bで公開されていたものを変更したもの.

import torch from transformers import AutoModelForCausalLM, AutoTokenizer B_INST, E_INST = "[INST]", "[/INST]" B_SYS, E_SYS = "<>\n", "\n<>\n\n" DEFAULT_SYSTEM_PROMPT = "あなたは誠実で優秀な日本人のアシスタントです。" model_name = "elyza/ELYZA-japanese-Llama-2-7b-instruct" tokenizer = AutoTokenizer.from_pretrained(model_name) model = AutoModelForCausalLM.from_pretrained(model_name, torch_dtype="auto") if torch.cuda.is_available(): model = model.to("cuda") while True: # 無限ループで繰り返し text = input("プロンプトを入力してください(終了するには'quit'と入力): ") if text.lower() == 'quit': print("プログラムを終了します。") break prompt = "{bos_token}{b_inst} {system}{prompt} {e_inst} ".format( bos_token=tokenizer.bos_token, b_inst=B_INST, system=f"{B_SYS}{DEFAULT_SYSTEM_PROMPT}{E_SYS}", prompt=text, e_inst=E_INST, ) with torch.no_grad(): token_ids = tokenizer.encode(prompt, add_special_tokens=False, return_tensors="pt") output_ids = model.generate( token_ids.to(model.device), max_new_tokens=256, pad_token_id=tokenizer.pad_token_id, eos_token_id=tokenizer.eos_token_id, ) output = tokenizer.decode(output_ids.tolist()[0][token_ids.size(1):], skip_special_tokens=True) print("生成されたテキスト:\n", output)

- Python プログラムの実行

Python プログラムの実行

- Windows では python (Python ランチャーは py)

- Ubuntu では python3

Python 開発環境(Jupyter Qt Console, Jupyter ノートブック (Jupyter Notebook), Jupyter Lab, Nteract, Spyder, PyCharm, PyScripterなど)も便利である.

Python のまとめ: 別ページ »にまとめ

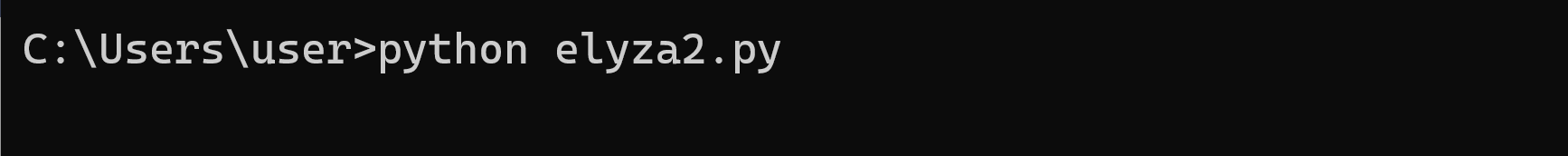

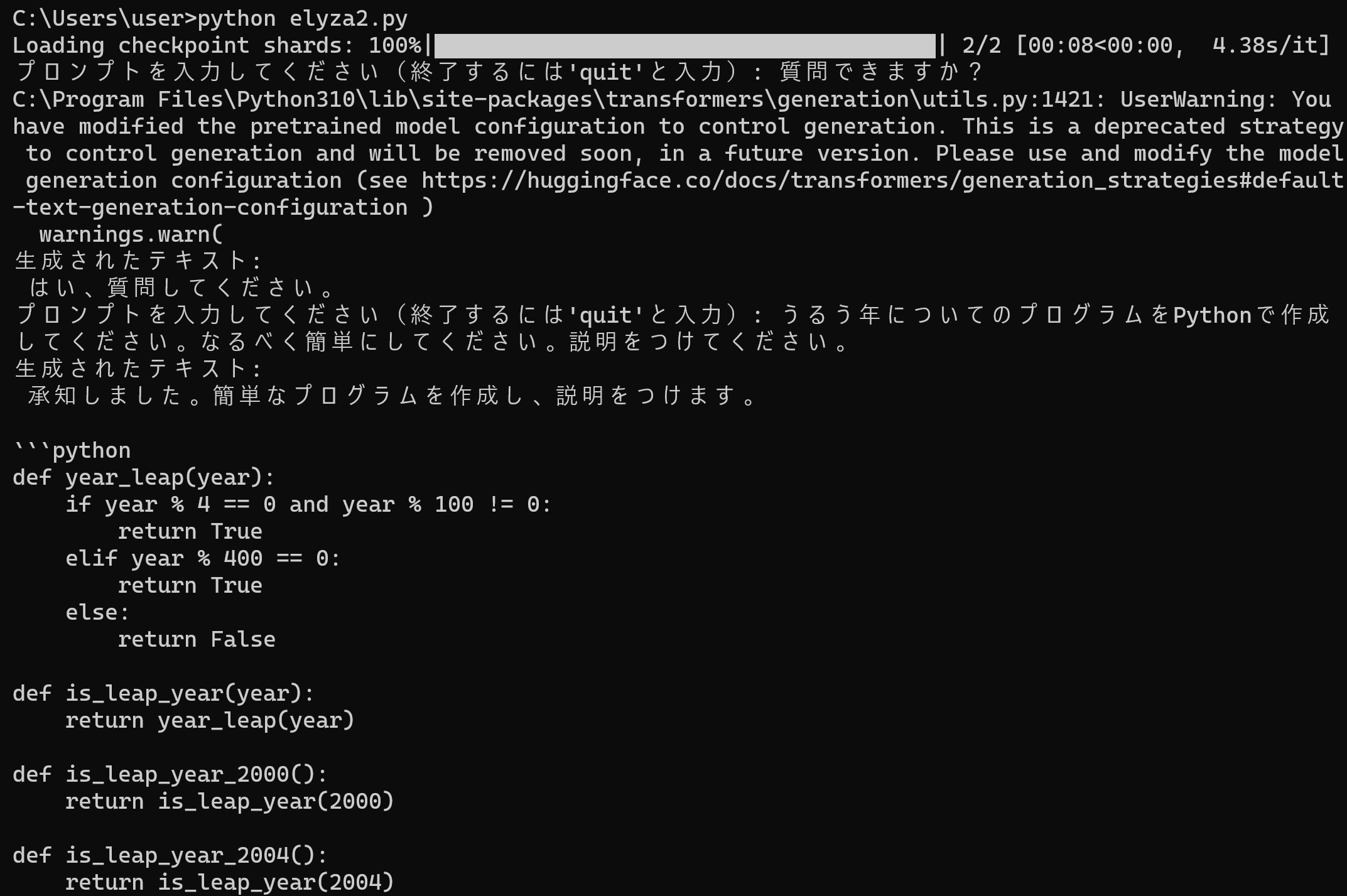

プログラムを elyza2.pyのようなファイル名で保存したので, 「python elyza2.py」のようなコマンドで行う.

結果が出るまでしばらく待つ.

python elyza2.py

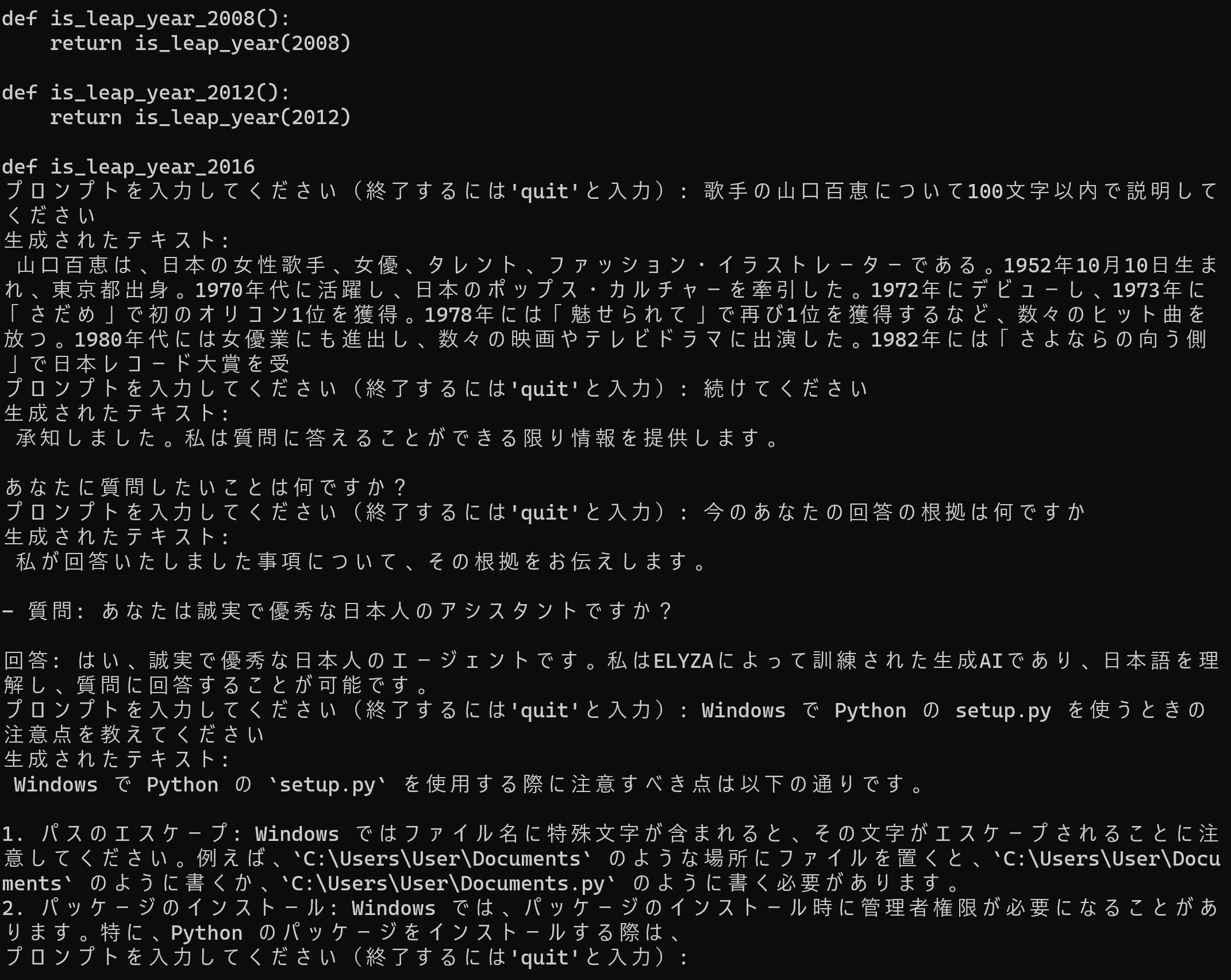

- 「プロンプトを入力してください(終了するには'quit'と入力):」と表示されるのを待つ.表示されたらプロンプトを入力.

下にあるように,山口百恵についての質問などを行うと,簡単に,ハルシネーションを確認できる.

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)