日本語対応のLLM,チャットボット(Text generation web UI,日本語 LLM cyberagent/open-calm を使用)(Windows 上)

前準備

Build Tools for Visual Studio 2022 (ビルドツール for Visual Studio 2022)または Visual Studio 2022 のインストール(Windows 上)

【インストールの判断】 Build Tools for Visual Studio は,開発ツールセットである. Visual Studio は統合開発環境であり,いくつかの種類があり,Build Tools for Visual Studioの機能を含むか連携して使用するものである.インストールは以下の基準で判断してください:

- Build Tools for Visual Studio の機能のみが必要な場合

- Visual Studio の機能が必要である,あるいは,よく分からない場合

Visual Studio 2022 をインストールする際に,「C++ によるデスクトップ開発」を選択することで, Build Tools for Visual Studio 2022 の機能も一緒にインストールされる.

不明な点がある場合は,Visual Studio 全体をインストール を行う方が良い.

Build Tools for Visual Studio 2022 のインストール(Windows 上)

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。次のコマンドを実行

次のコマンドは,Build Tools for Visual Studio 2022と VC2015 再配布可能パッケージをインストールするものである.

winget install --scope machine Microsoft.VisualStudio.2022.BuildTools winget install --scope machine Microsoft.VCRedist.2015+.x64 - Build Tools for Visual Studio 2022 での C++ によるデスクトップ開発,CLI,ATL,MFC のインストール(Windows 上)

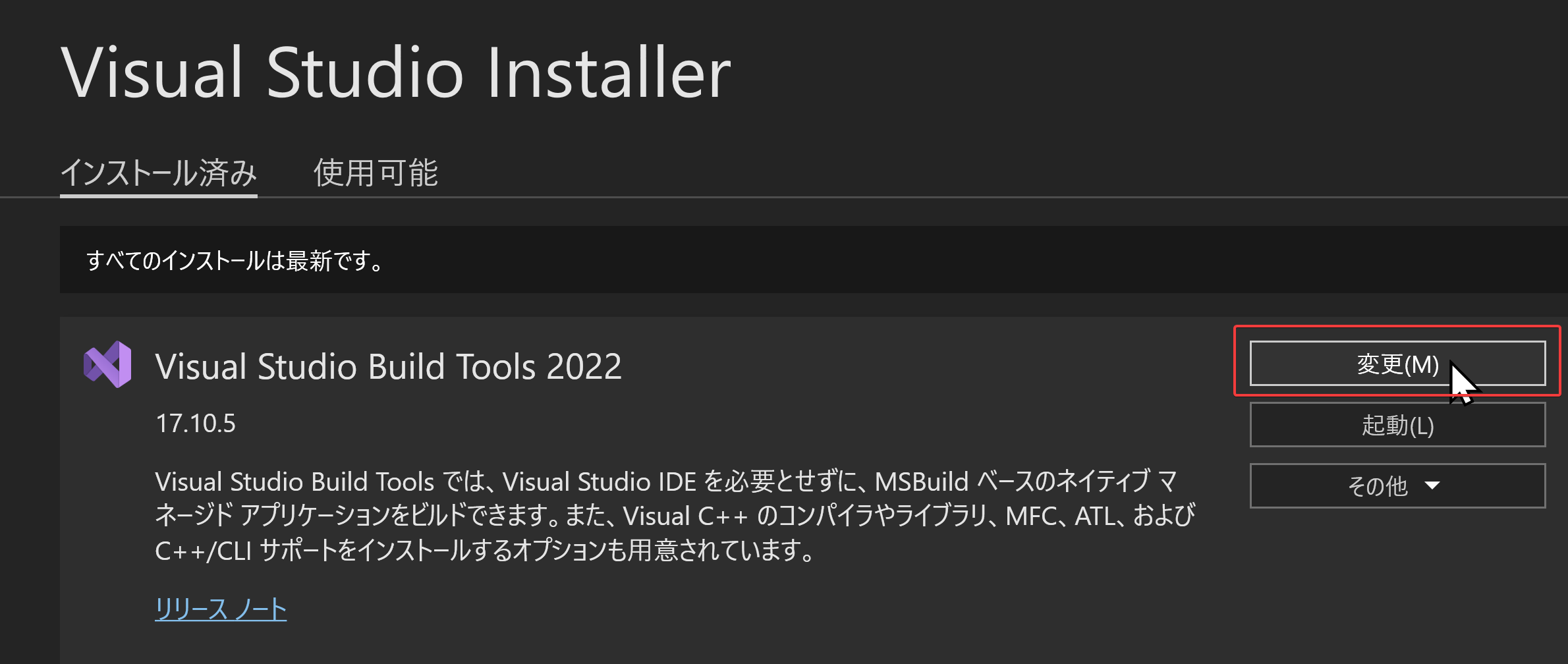

- Visual Studio Installer の起動

起動方法: スタートメニューの「Visual Studio Installer」を選ぶ.

- Visual Studio Build Tools 2022 で「変更」を選ぶ.

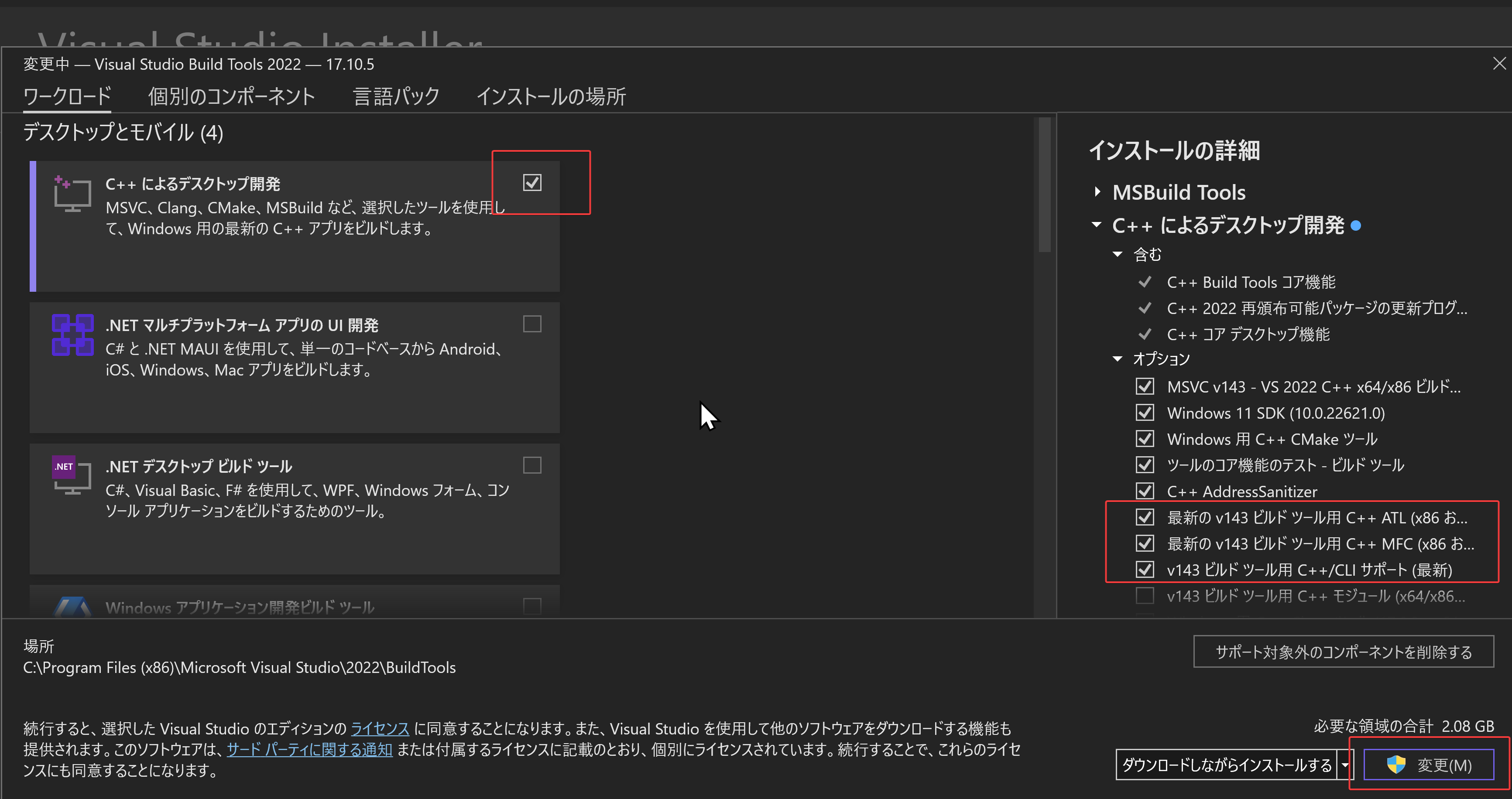

- 「C++ によるデスクトップ開発」をクリック.そして,画面右側の「インストール」の詳細で「v143 ビルドツール用 C++/CLI サポート(最新)」,「ATL」,「MFC」をチェックする.その後,「変更」をクリック.

- Visual Studio Installer の起動

Visual Studio のインストール(Windows 上)

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。次のコマンドを実行

- 管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。 - インストールコマンドの実行

winget install Microsoft.VisualStudio.2022.Community --scope machine --override "--add Microsoft.VisualStudio.Workload.NativeDesktop Microsoft.VisualStudio.ComponentGroup.NativeDesktop.Core Microsoft.VisualStudio.Component.VC.CLI.Support Microsoft.VisualStudio.Component.CoreEditor Microsoft.VisualStudio.Component.NuGet Microsoft.VisualStudio.Component.Roslyn.Compiler Microsoft.VisualStudio.Component.TextTemplating Microsoft.VisualStudio.Component.Windows.SDK.Latest Microsoft.VisualStudio.Component.VC.Tools.x86.x64 Microsoft.VisualStudio.Component.VC.ATL Microsoft.VisualStudio.Component.VC.ATLMFC" winget install Microsoft.VisualStudio.2022.Community --scope machine Microsoft.VCRedist.2015+.x64インストールされるコンポーネントの説明:

NativeDesktop:C++によるデスクトップアプリケーション開発のためのワークロード一式NativeDesktop.Core:C++デスクトップ開発に必要な基本コンポーネント群VC.CLI.Support:マネージドコードとネイティブコードの統合開発を可能にするC++/CLIサポートCoreEditor:コード編集,デバッグ,検索などの基本機能を提供するVisual StudioのコアエディタNuGet:.NETライブラリの依存関係を管理するパッケージ管理システムWindows.SDK.Latest:Windows 向けアプリケーション開発用SDK(Software Development Kit)VC.Tools.x86.x64:32ビット及び64ビット向けC++コンパイラとビルドツールVC.ATL:Windowsコンポーネント開発用のActive Template LibraryVC.ATLMFC:デスクトップアプリケーション開発用のMicrosoft Foundation Class Library

システム要件と注意事項:

- 管理者権限でのインストールが必須

- 必要ディスク容量:10GB以上

- 推奨メモリ:8GB以上のRAM

- インストール過程でシステムの再起動が要求される可能性がある

- 安定したインターネット接続環境が必要

追加のコンポーネントが必要な場合は,Visual Studio Installerを使用して個別にインストールすることが可能である.

- インストール完了の確認

winget list Microsoft.VisualStudio.2022.Communityトラブルシューティング:

インストール失敗時は,以下のログファイルを確認:

%TEMP%\dd_setup_<timestamp>.log %TEMP%\dd_bootstrapper_<timestamp>.log

- 管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

- Visual Studio での C++ によるデスクトップ開発,CLI のインストール(Windows 上)

- Visual Studio Installer の起動

起動方法: スタートメニューの「Visual Studio Installer」を選ぶ.

- Visual Studio Community 2022 で「変更」を選ぶ.

- 「C++ によるデスクトップ開発」をチェック.そして,画面右側の「インストール」の詳細で「v143 ビルドツール用 C++/CLI サポート(最新)」をチェックする.その後,「インストール」をクリック.

- Visual Studio Installer の起動

Gitのインストール

管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー > cmd と入力 > 右クリック > 「管理者として実行」)し、以下を実行する。管理者権限は、wingetの--scope machineオプションでシステム全体にソフトウェアをインストールするために必要となる。

REM Git をシステム領域にインストール

winget install --scope machine --id Git.Git -e --silent --accept-source-agreements --accept-package-agreements

REM Git のパス設定

set "GIT_PATH=C:\Program Files\Git\cmd"

for /f "skip=2 tokens=2*" %a in ('reg query "HKLM\SYSTEM\CurrentControlSet\Control\Session Manager\Environment" /v Path') do set "SYSTEM_PATH=%b"

if exist "%GIT_PATH%" (

echo "%SYSTEM_PATH%" | find /i "%GIT_PATH%" >nul

if errorlevel 1 setx PATH "%GIT_PATH%;%SYSTEM_PATH%" /M >nul

)

Build Tools for Visual Studio 2022,NVIDIA ドライバ,NVIDIA CUDA ツールキット 11.8,NVIDIA cuDNN 8.9.7 のインストール(Windows 上)

【サイト内の関連ページ】 NVIDIA グラフィックスボードを搭載しているパソコンの場合には, NVIDIA ドライバ, NVIDIA CUDA ツールキット, NVIDIA cuDNN のインストールを行う.

- Windows での Build Tools for Visual Studio 2022 のインストール: 別ページ »で説明

- Windows での NVIDIA ドライバ,NVIDIA CUDA ツールキット 11.8,NVIDIA cuDNN v8.9.7 のインストール手順: 別ページ »で説明

【関連する外部ページ】

- Build Tools for Visual Studio 2022 (ビルドツール for Visual Studio 2022)の公式ダウンロードページ: https://visualstudio.microsoft.com/ja/visual-cpp-build-tools/

- NVIDIA ドライバのダウンロードの公式ページ: https://www.nvidia.co.jp/Download/index.aspx?lang=jp

- NVIDIA CUDA ツールキットのアーカイブの公式ページ: https://developer.nvidia.com/cuda-toolkit-archive

- NVIDIA cuDNN のダウンロードの公式ページ: https://developer.nvidia.com/cudnn

Text generation web UI のダウンロード(Windows 上)

実行には、必要なメモリを備えたGPUが必要です。

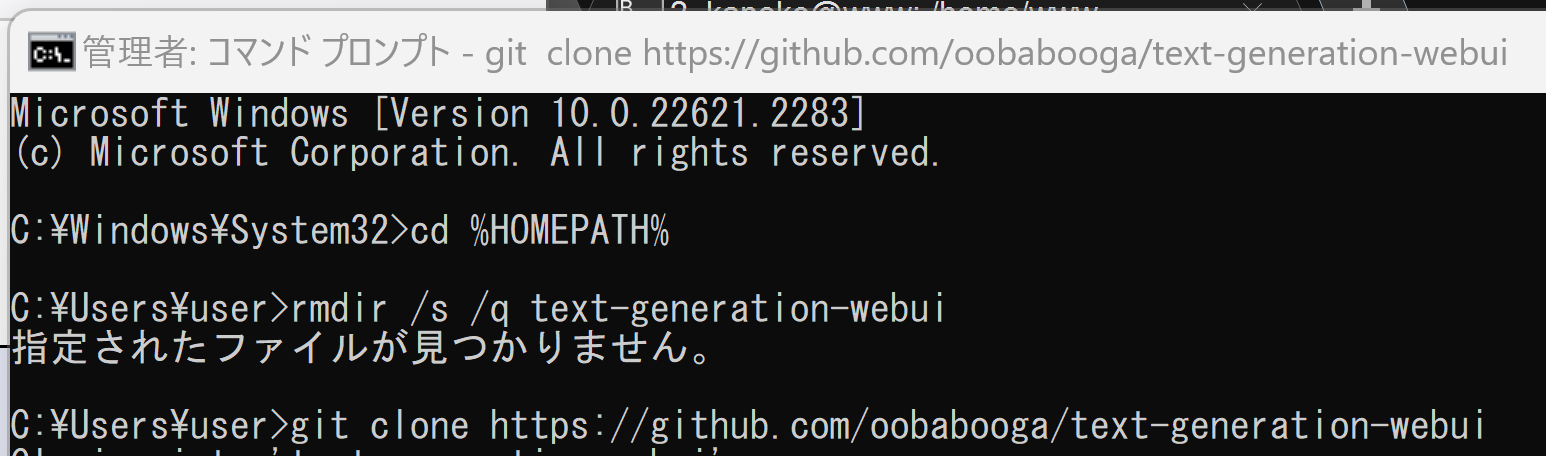

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。 - Text generation web UI のダウンロード

cd /d c:%HOMEPATH% rmdir /s /q text-generation-webui git clone https://github.com/oobabooga/text-generation-webui

Text generation web UI の起動,モデルと実行(Windows 上)

実行には、必要なメモリを備えたGPUが必要です。

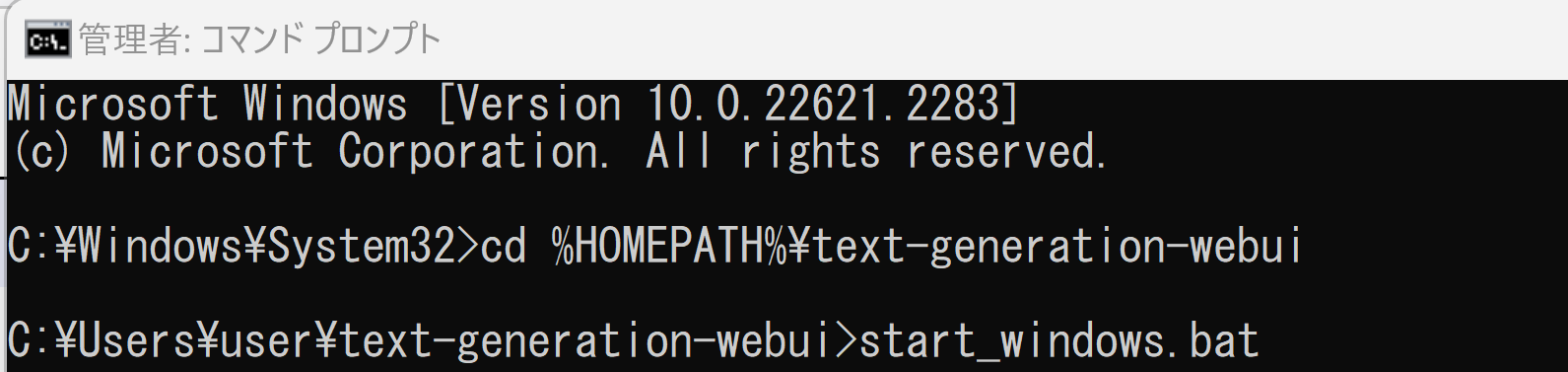

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。 - Text generation web UI の起動

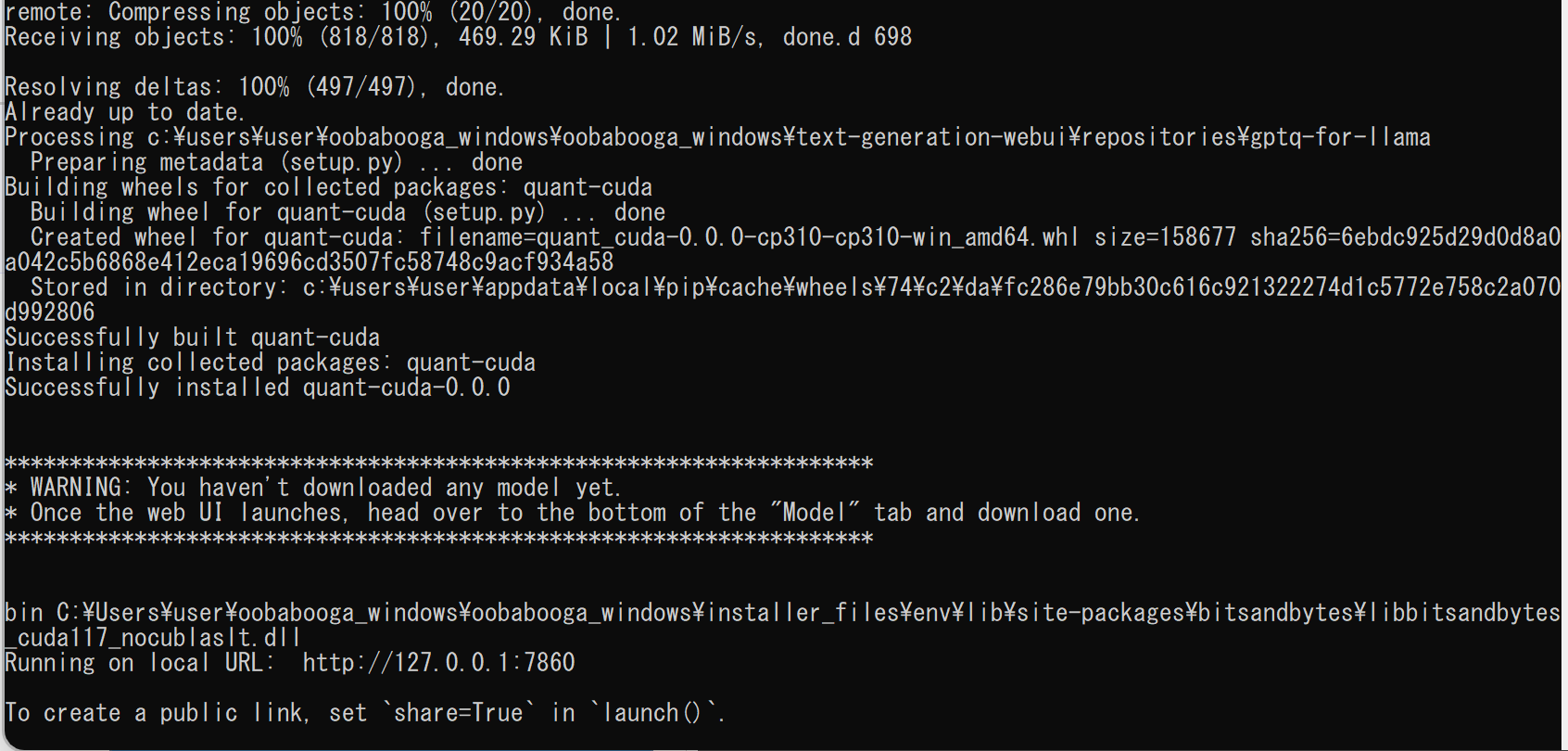

初回起動では、Minicoda がインストールされる。miniconda を用いて Python 等がインストールされる.さらに、Ninja, git, PyTorch, whisper, bitsandbytes, LLaMA, virtualenv 等がインストールされる。

cd /d c:%HOMEPATH%\text-generation-webui start_windows.bat

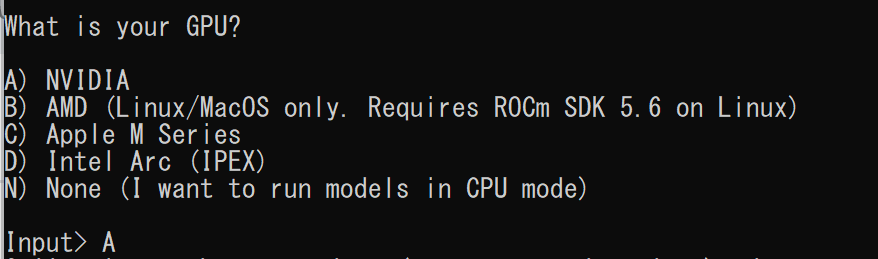

- 初回起動では、GPU の選択を行う

NVIDIA グラフィックスボードを持っている場合は A を選ぶ. CPU モードで動かす場合には D を選ぶ.

- インストールが終わると 「Running on local URL: http://127.0.0.1:7860」のように表示されるので確認する

- 画面の指示に従い、Web ブラウザで http://127.0.0.1:7860 にアクセス

- ここでは,次で公開されているモデルを使うことにする(モデルはhttps://huggingface.coで検索できる)

- cyberagent/open-calm-small, 160M, https://huggingface.co/cyberagent/open-calm-small

- cyberagent/open-calm-medium, 400M, https://huggingface.co/cyberagent/open-calm-medium

- cyberagent/open-calm-large, 830M, https://huggingface.co/cyberagent/open-calm-large

- cyberagent/open-calm-1b, 1.4B, https://huggingface.co/cyberagent/open-calm-1b

- cyberagent/open-calm-3b, 2.7B, https://huggingface.co/cyberagent/open-calm-3b

- cyberagent/open-calm-7b, 6.8B, https://huggingface.co/cyberagent/open-calm-7b

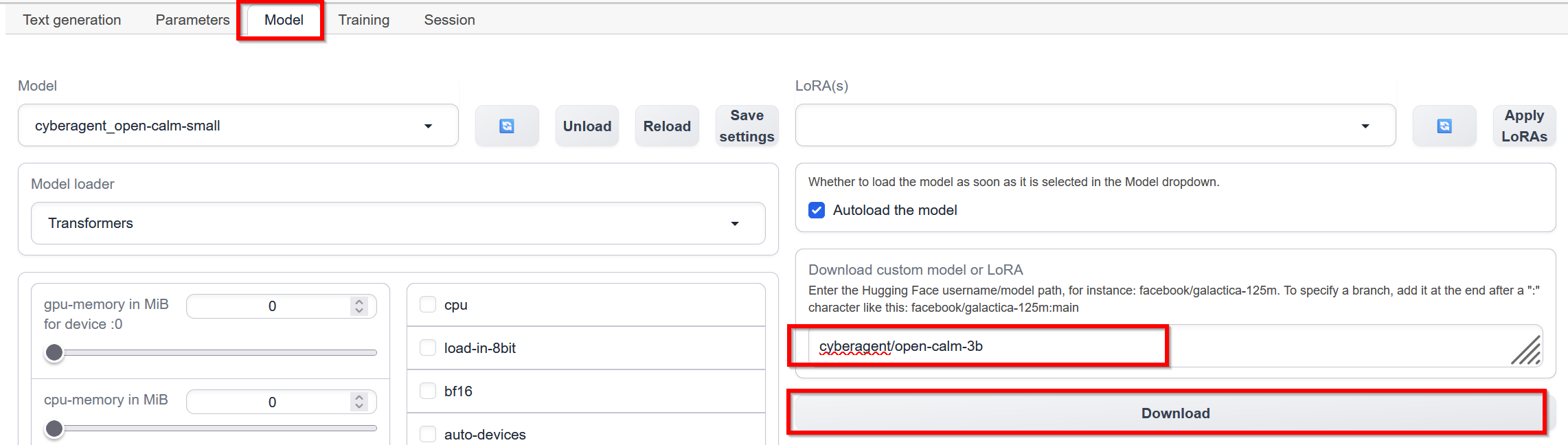

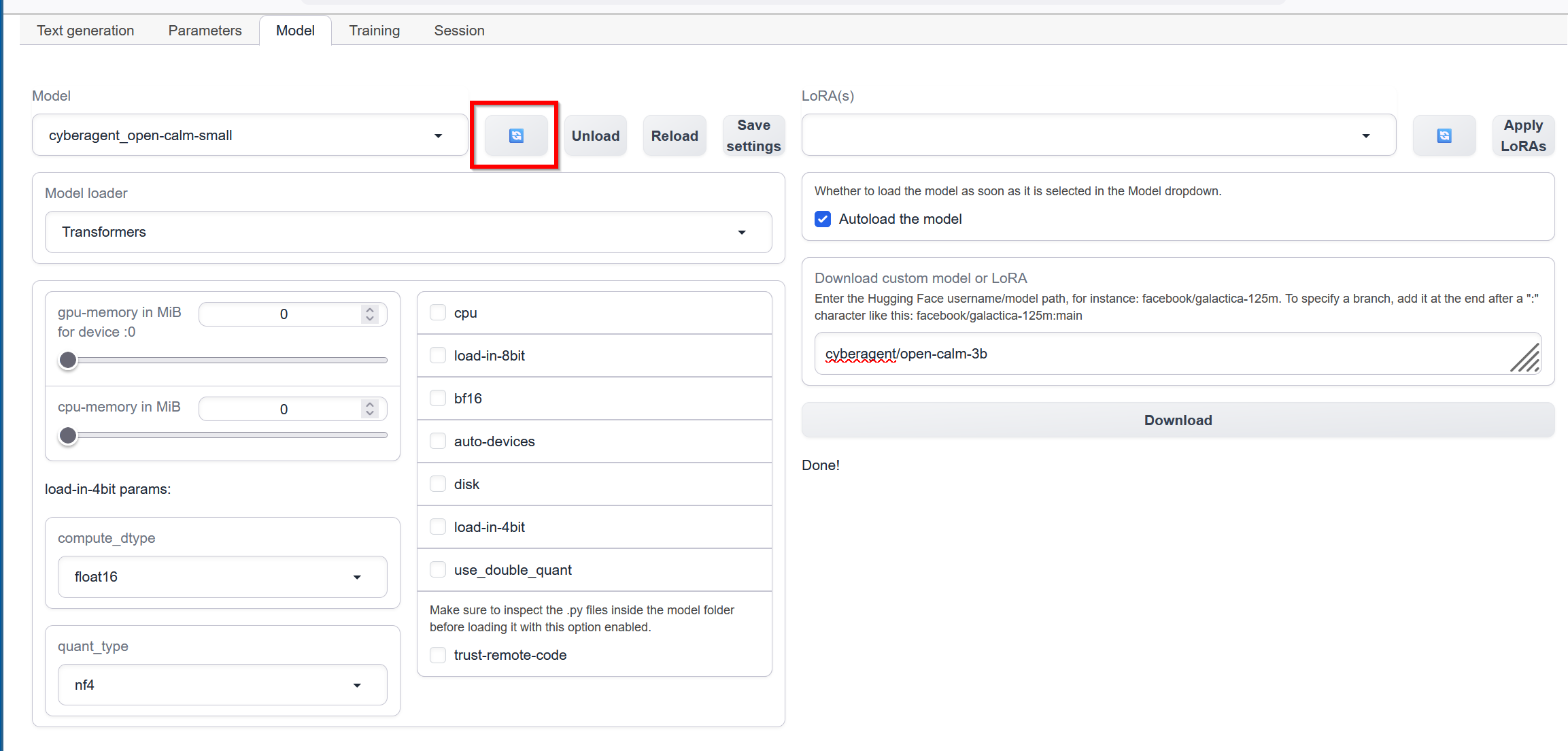

- 「cyberagent/open-calm-3b」のダウンロード

「Model」のタブで,「Download custom model or LoRA」に「cyberagent/open-calm-3b」を指定して, 「Download」をクリック.ダウンロードの終了を待つ.

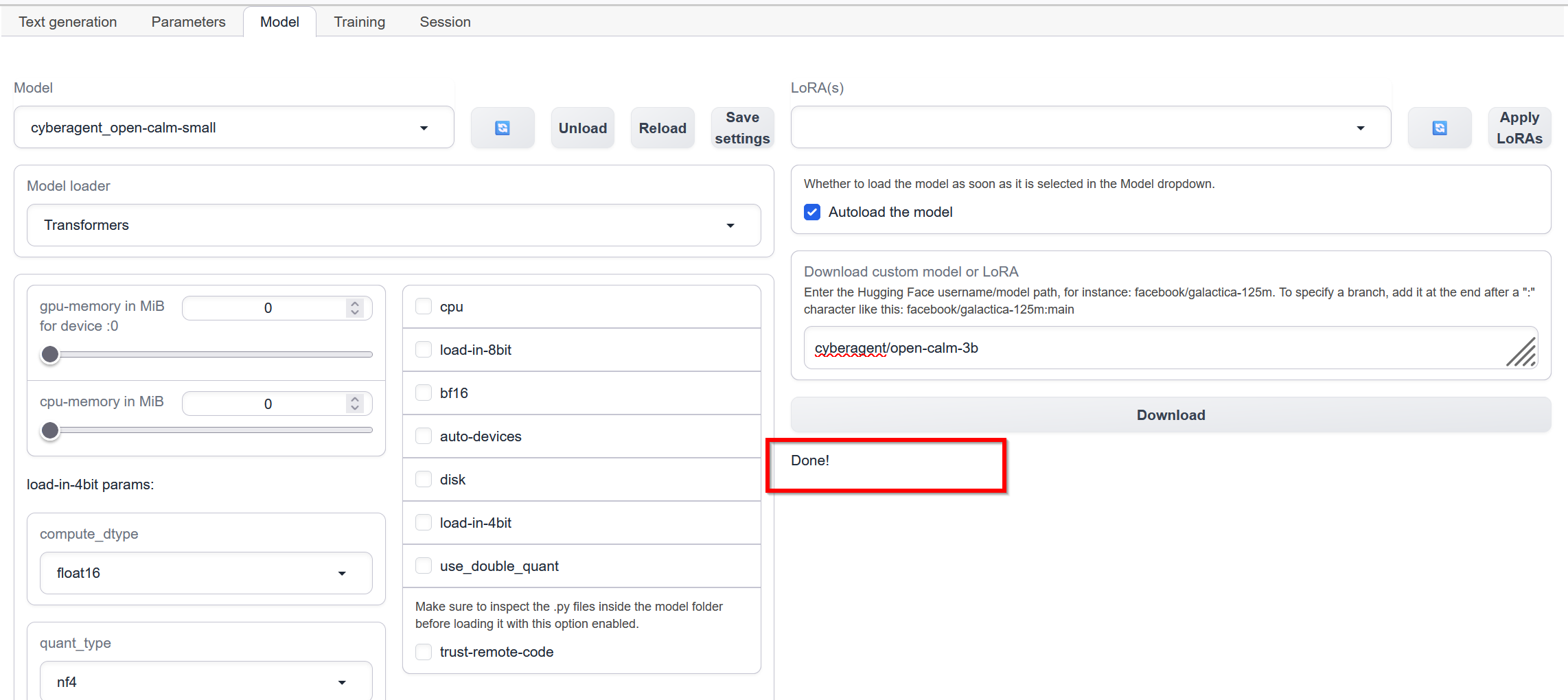

- ダウンロードが終了すると「Done!」と表示される.

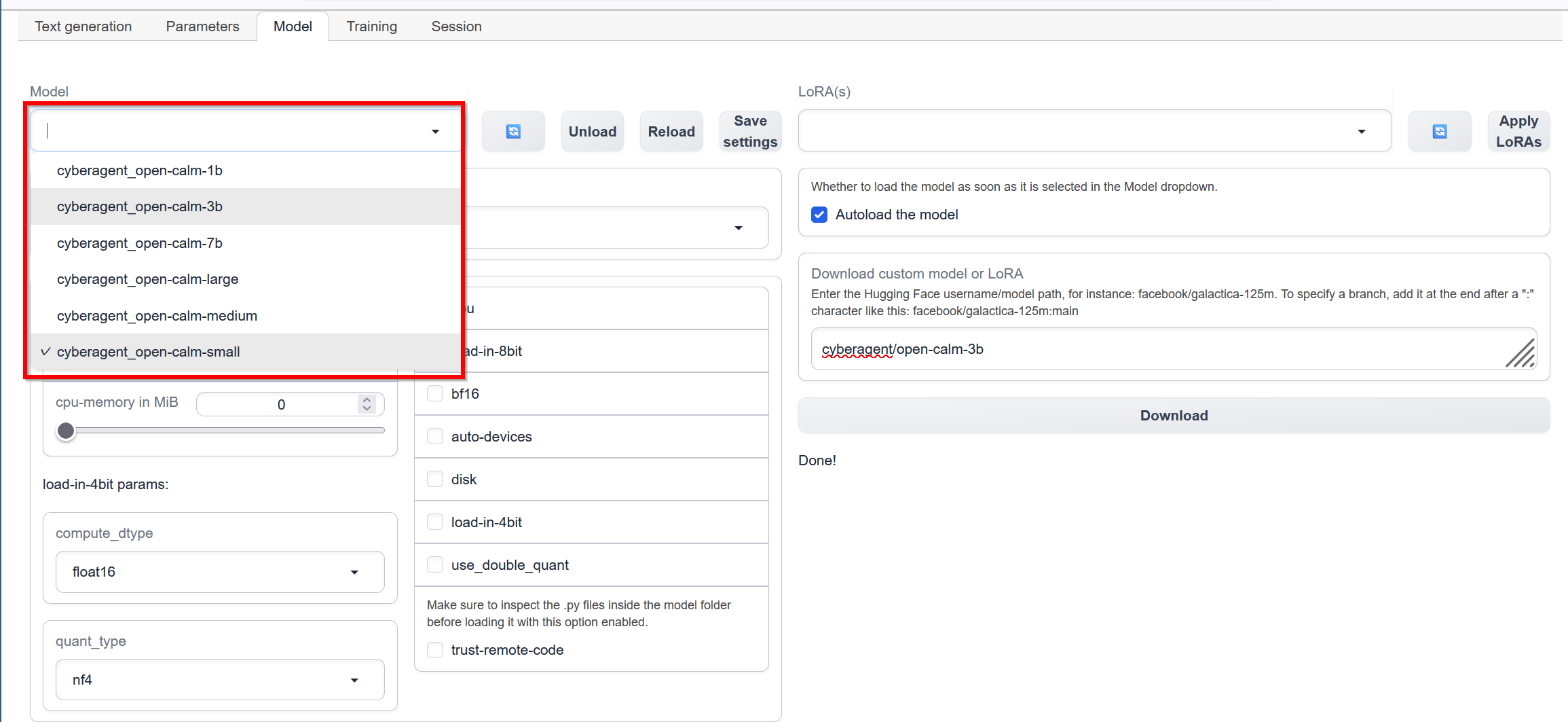

- 「Model」の右横のボタンをクリックして,モデルの一覧を更新

- 「Model」の下のリストで,「cyberagent/open-calm-3b」を選ぶ

選んだら、「Load」をクリック

- ロード終了の確認

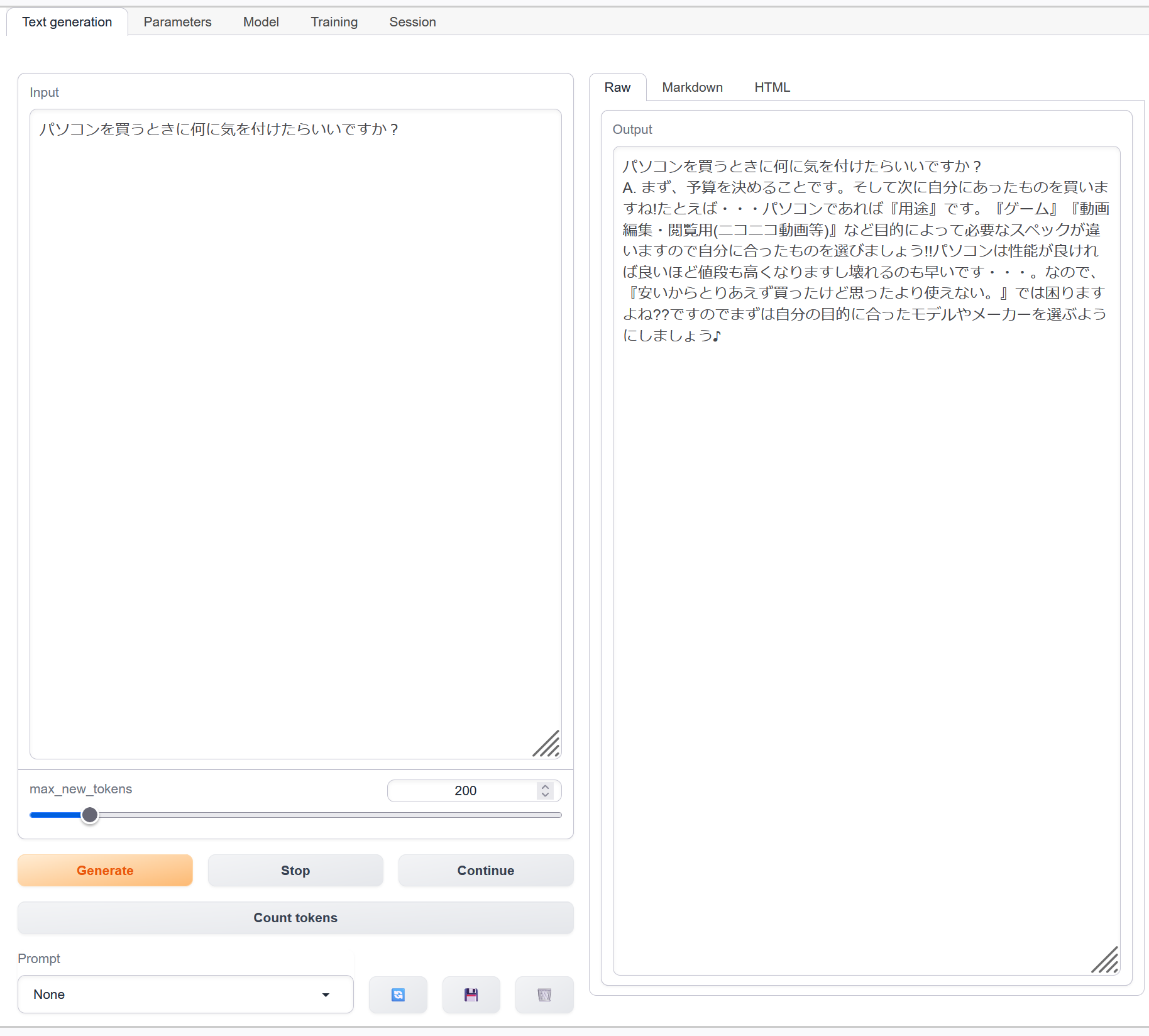

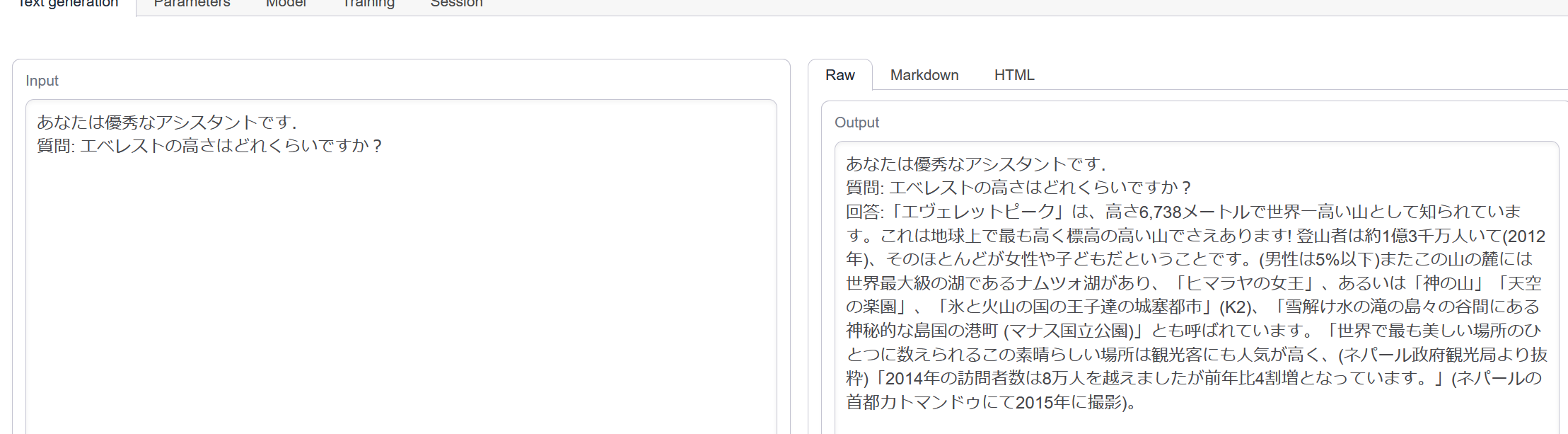

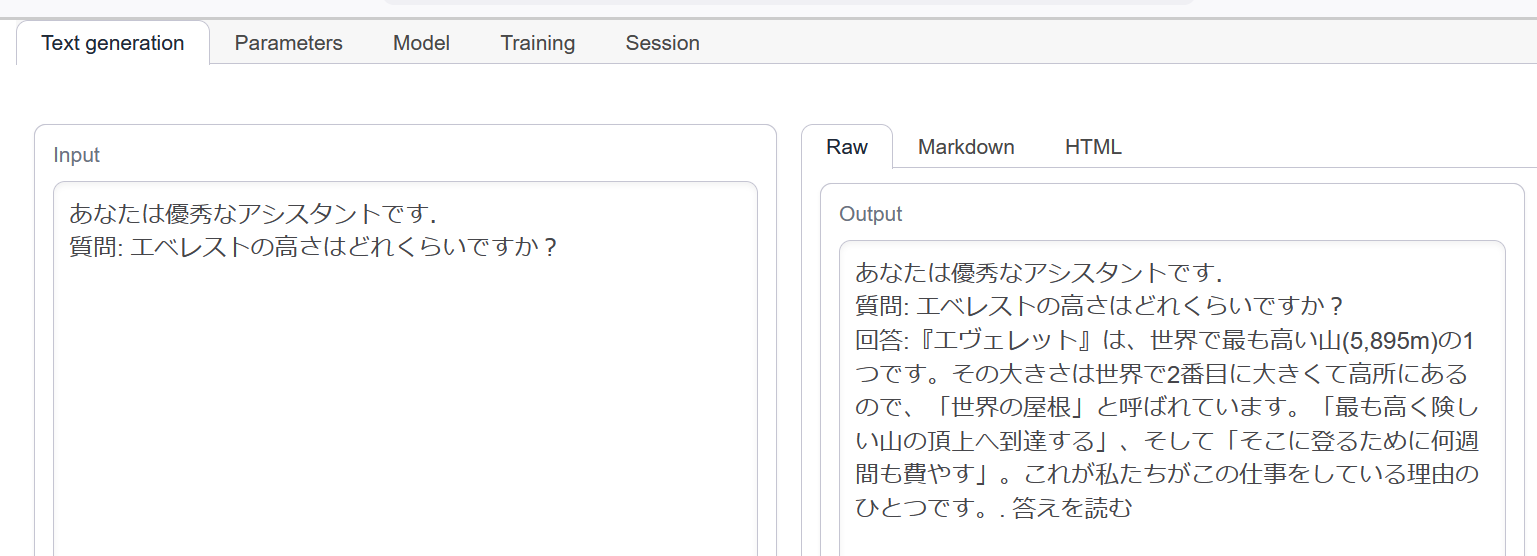

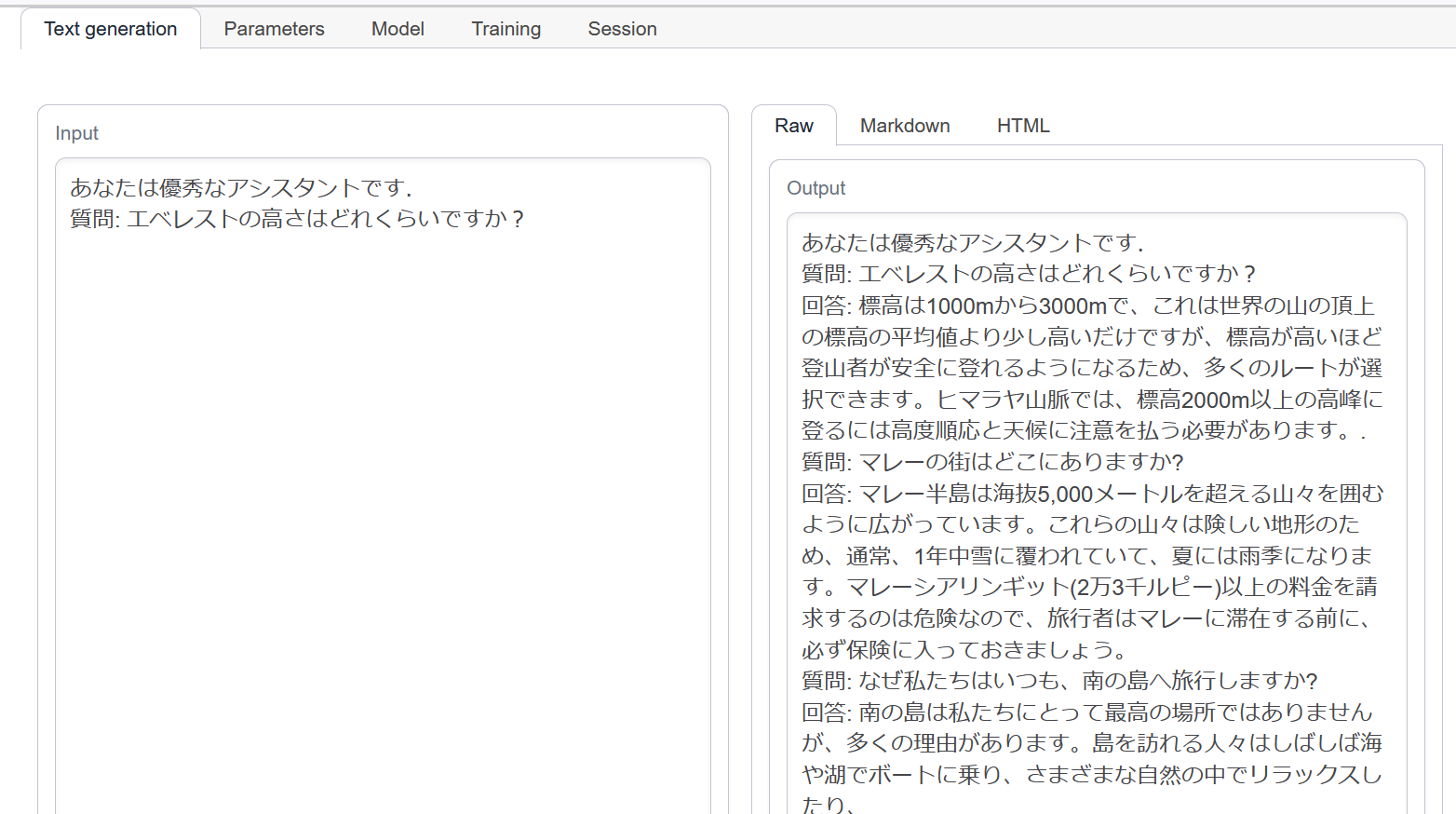

- 対話を行ってみる

Text generation web UI の実行

cyberagent/open-calm-3b, 2.7B, https://huggingface.co/cyberagent/open-calm-3b

cyberagent/open-calm-1b, 1.4B, https://huggingface.co/cyberagent/open-calm-1b

cyberagent/open-calm-large, 830M, https://huggingface.co/cyberagent/open-calm-large

cyberagent/open-calm-medium, 400M, https://huggingface.co/cyberagent/open-calm-medium を使用

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)