PostgreSQL への CSV ファイルインポートと性能確認手順

CSV ファイルインポートとは,CSVファイルをリレーショナルデータベースのテーブルにインポートすることである.

- ここで扱う CSV ファイルは, 先頭行には,各列の属性名が記述されているものである.

- 1つのCSVファイルを1つのテーブルにインポートする処理を実行する.

- CSVファイルのレコードの中の値の順序は厳密に維持する.

このページで紹介しているソフトウェア類の利用条件等については,利用者自身で確認すること.

【サイト内の関連ページ】

前準備

CSV ファイルの準備

- テスト用に使うCSV データの合成: 別ページ »で説明

PostgreSQL のインストール

PostgreSQL の利用: 別ページ »にまとめ

- Windows での PostgreSQL のインストール: 別ページ »で説明

- Ubuntu での PostgreSQL のインストール: 別ページ »で説明

CSV ファイルインポートのテスト実行(PostgreSQL を使用)

以下の設定を行い,実行する.

- 「T1000M_1.csv」の部分には,インポートするCSV ファイル名を指定する

- 「T1000M_1.sql」の部分には,作成するテーブル定義の SQL を指定する

- 「T1000M_1」の部分には,作成するテーブル名を指定する

- 「testdb」の部分には,PostgreSQL のデータベース名を指定する

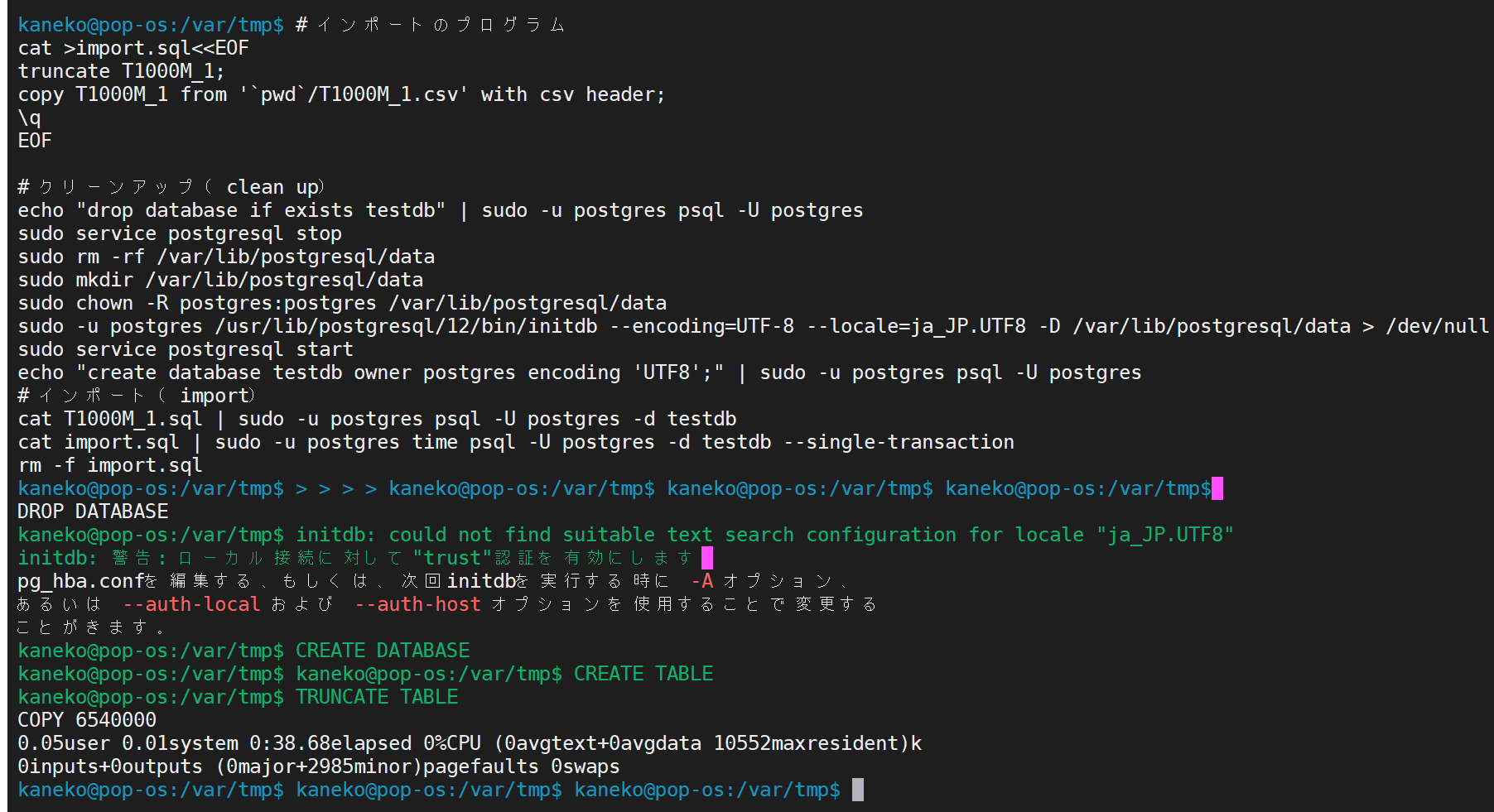

# インポートのプログラム

cat >import.sql<T1000M_1.csv' with csv header;

\q

EOF

# クリーンアップ(clean up)

echo "drop database if exists testdb" | sudo -u postgres psql -U postgres

sudo service postgresql stop

sudo rm -rf /var/lib/postgresql/data

sudo mkdir /var/lib/postgresql/data

sudo chown -R postgres:postgres /var/lib/postgresql/data

sudo -u postgres /usr/lib/postgresql/12/bin/initdb --encoding=UTF-8 --locale=ja_JP.UTF8 -D /var/lib/postgresql/data > /dev/null

sudo service postgresql start

echo "create database testdb owner postgres encoding 'UTF8';" | sudo -u postgres psql -U postgres

# インポート(import)

cat T1000M_1.sql | sudo -u postgres psql -U postgres -d testdb

cat import.sql | sudo -u postgres time psql -U postgres -d testdb --single-transaction

rm -f import.sql

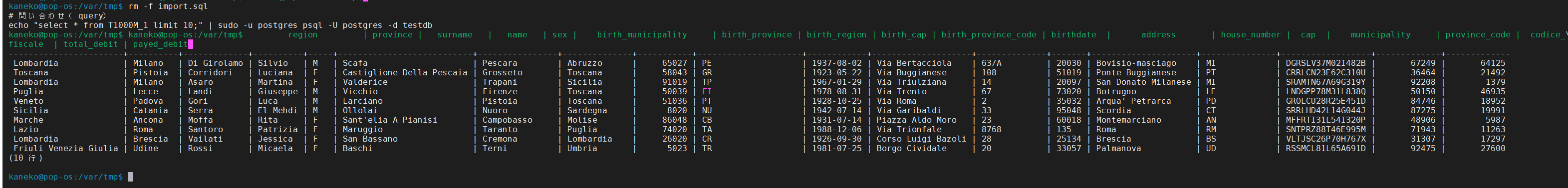

# 問い合わせ(query)

echo "select * from T1000M_1 limit 10;" | sudo -u postgres psql -U postgres -d testdb

echo "select region, count(*) from T1000M_1 group by region;" | sudo -u postgres psql -U postgres -d testdb

echo "select birth_cap from T1000M_1 where birth_cap > 80000 limit 10;" | sudo -u postgres psql -U postgres -d testdb

その性能計測

以下のプログラムを実行し,dstat を用いて性能を測定する.

# キャッシュのクリア(PageCache, dentries and inodes)

function cache_clear() {

/usr/bin/sync

/usr/bin/sync

/usr/bin/sync

/usr/bin/sync

/usr/bin/sync

sleep 3

sudo sysctl -w vm.drop_caches=3 > /dev/null

echo 3 | sudo tee -a /proc/sys/vm/drop_caches > /dev/null

return

}

# 性能を測定するプログラム,上のプログラムと同一

cat >import.sql<T1000M_1.csv' with csv header;

\q

EOF

# クリーンアップ(clean up),上のプログラムと同一

echo "drop database if exists testdb" | sudo -u postgres psql -U postgres

sudo service postgresql stop

sudo rm -rf /var/lib/postgresql/data

sudo mkdir /var/lib/postgresql/data

sudo chown -R postgres:postgres /var/lib/postgresql/data

sudo -u postgres /usr/lib/postgresql/12/bin/initdb --encoding=UTF-8 --locale=ja_JP.UTF8 -D /var/lib/postgresql/data

sudo service postgresql start

echo "create database testdb owner postgres encoding 'UTF8';" | sudo -u postgres psql -U postgres

# dstat データをプロットするプログラムの準備

WIDTH=48

HEIGHT=20

sudo apt -y install dstat

rm -f dstatplot.py

wget https://www.kkaneko.jp/data/rdb/dstatplot.py

# キャッシュのクリア

cache_clear

# 48 は表示の横幅を指定

# 20 は表示の縦幅を指定

# 表示が開始されるまで「表示の横幅」秒待機する.

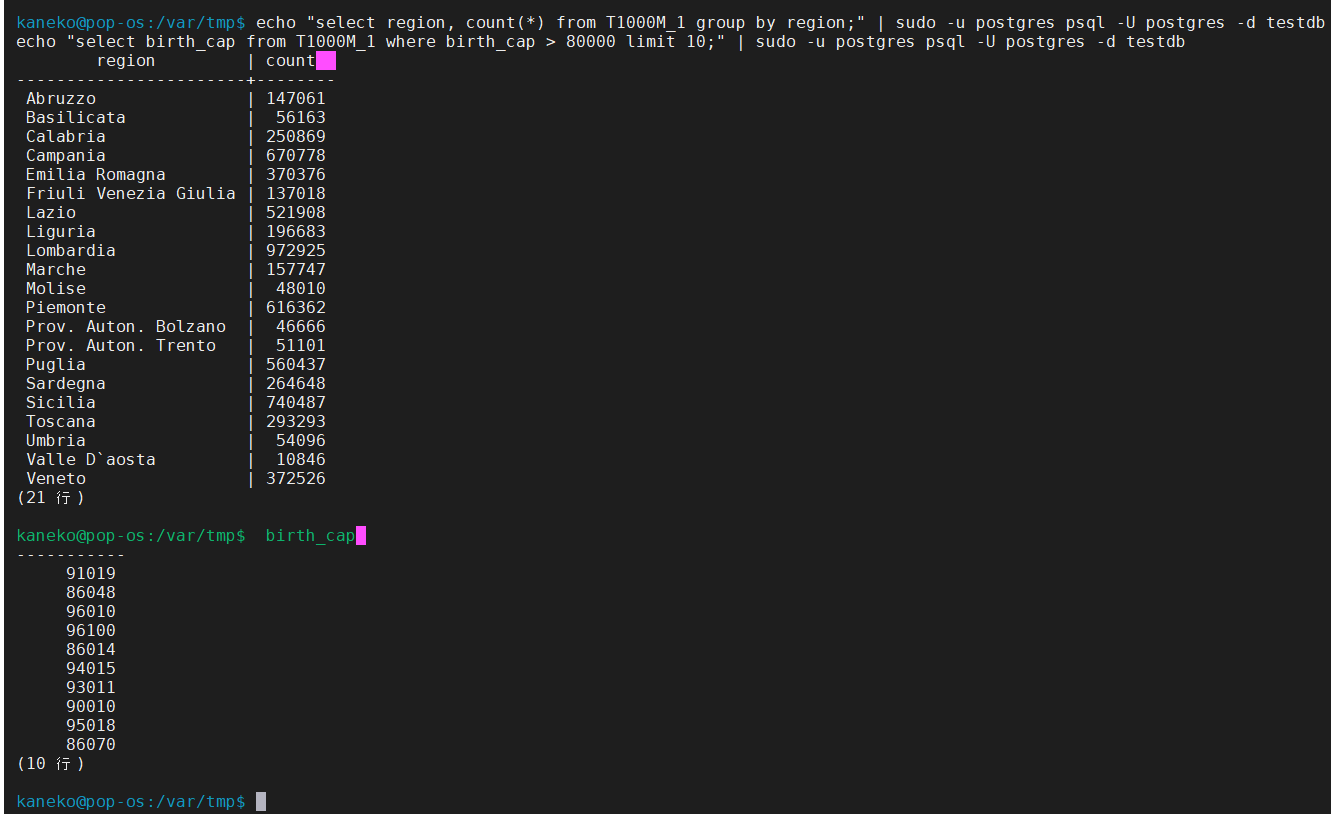

dstat -tcdylm -C 0,1,2,3,4,5,6,7 | python3 dstatplot.py $WIDTH $HEIGHT &

sleep $WIDTH

# インポート(import),上のプログラムと同一

cat T1000M_1.sql | sudo -u postgres psql -U postgres -d testdb --single-transaction

cat import.sql | sudo -u postgres time psql -U postgres -d testdb

rm -f import.sql

数字 0 から 7 はプロセッサのコアを表す.R, W はストレージの読み書きを示す.m はメモリ使用量を表す.

リード,ライトの処理は即座に開始される.読み込まれたデータはメモリ上に保持される. メモリは即座には解放されない.また,トランザクション終了後にデータの書き込みが実行される.

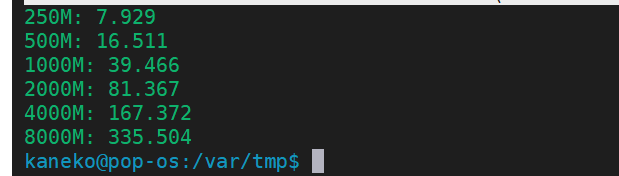

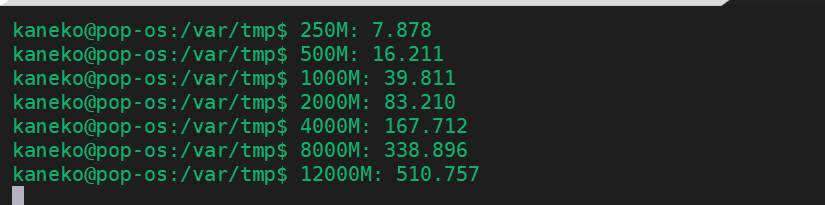

CSV ファイルインポートでのファイルサイズと処理時間の関係(PostgreSQL を使用)

#/bin/bash

function elapsed() {

echo `python3 -c "import sys; print( float(sys.argv[2]) - float(sys.argv[1]) )" $1 $2`

return

}

function avg() {

echo `python3 -c 'import sys; print("%.3f" % ((float(sys.argv[1]) + float(sys.argv[2]) + float(sys.argv[3])) / 3.0) )' $1 $2 $3`

return

}

# キャッシュのクリア(PageCache, dentries and inodes)

function cache_clear() {

/usr/bin/sync

/usr/bin/sync

/usr/bin/sync

/usr/bin/sync

/usr/bin/sync

sleep 3

sudo sysctl -w vm.drop_caches=3 > /dev/null

echo 3 | sudo tee -a /proc/sys/vm/drop_caches > /dev/null

return

}

F=/etc/postgresql/12/main/postgresql.conf

function archive_mode_on() {

sudo sed -i 's/#wal_level = minimal/wal_level = minimal/g' $F

sudo sed -i 's/#wal_level = replica/wal_level = minimal/g' $F

sudo sed -i 's/wal_level = replica/wal_level = minimal/g' $F

sudo sed -i 's/#wal_level = logical/wal_level = minimal/g' $F

sudo sed -i 's/wal_level = logical/wal_level = minimal/g' $F

}

function archive_mode_off() {

sudo sed -i 's/#wal_level = minimal/wal_level = replica/g' $F

sudo sed -i 's/wal_level = minimal/wal_level = replica/g' $F

sudo sed -i 's/#wal_level = replica/wal_level = replica/g' $F

sudo sed -i 's/#wal_level = logical/wal_level = replica/g' $F

sudo sed -i 's/wal_level = logical/wal_level = replica/g' $F

}

# $1: CSV file name, $2: Table name, $3: PostgreSQL Database name

function psql_import() {

# クリーンアップ(clean up)

echo "drop database if exists $3" | sudo -u postgres psql -U postgres > /dev/null

cache_clear

sudo service postgresql stop

cache_clear

sudo rm -rf /var/lib/postgresql/data

sudo mkdir /var/lib/postgresql/data

sudo chown -R postgres:postgres /var/lib/postgresql/data

sudo -u postgres /usr/lib/postgresql/12/bin/initdb --encoding=UTF-8 --locale=ja_JP.UTF8 -D /var/lib/postgresql/data > /dev/null

sudo service postgresql start

echo "create database $3 owner postgres encoding 'UTF8';" | sudo -u postgres psql -U postgres 1>/dev/null 2>/dev/null

#

cat $4 | sudo -u postgres psql -U postgres -d $3 > /dev/null

rm -f psql_import.sql

# インポートのプログラム

cat >psql_import.sql<postgres time psql -U postgres -d $3 --single-transaction --quiet 1>/dev/null 2>/dev/null

current=`date +%s.%N`

echo `elapsed $start $current`

return

}

#

archive_mode_off

# 250M

cache_clear

elapsed1=`psql_import T250M_1.csv T250M_1 t250m_1_db T250M_1.sql`

cache_clear

elapsed2=`psql_import T250M_1.csv T250M_1 t250m_1_db T250M_1.sql`

cache_clear

elapsed3=`psql_import T250M_1.csv T250M_1 t250m_1_db T250M_1.sql`

echo 250M: `avg $elapsed1 $elapsed2 $elapsed3`

# 500M

cache_clear

elapsed1=`psql_import T500M_1.csv T500M_1 t500m_1_db T500M_1.sql`

cache_clear

elapsed2=`psql_import T500M_1.csv T500M_1 t500m_1_db T500M_1.sql`

cache_clear

elapsed3=`psql_import T500M_1.csv T500M_1 t500m_1_db T500M_1.sql`

echo 500M: `avg $elapsed1 $elapsed2 $elapsed3`

# 1000M

cache_clear

elapsed1=`psql_import T1000M_1.csv T1000M_1 t1000m_1_db T1000M_1.sql`

cache_clear

elapsed2=`psql_import T1000M_1.csv T1000M_1 t1000m_1_db T1000M_1.sql`

cache_clear

elapsed3=`psql_import T1000M_1.csv T1000M_1 t1000m_1_db T1000M_1.sql`

echo 1000M: `avg $elapsed1 $elapsed2 $elapsed3`

# 2000M

cache_clear

elapsed1=`psql_import T2000M_1.csv T2000M_1 t2000m_1_db T2000M_1.sql`

cache_clear

elapsed2=`psql_import T2000M_1.csv T2000M_1 t2000m_1_db T2000M_1.sql`

cache_clear

elapsed3=`psql_import T2000M_1.csv T2000M_1 t2000m_1_db T2000M_1.sql`

echo 2000M: `avg $elapsed1 $elapsed2 $elapsed3`

# 4000M

cache_clear

elapsed1=`psql_import T4000M_1.csv T4000M_1 t4000m_1_db T4000M_1.sql`

cache_clear

elapsed2=`psql_import T4000M_1.csv T4000M_1 t4000m_1_db T4000M_1.sql`

cache_clear

elapsed3=`psql_import T4000M_1.csv T4000M_1 t4000m_1_db T4000M_1.sql`

echo 4000M: `avg $elapsed1 $elapsed2 $elapsed3`

# 8000M

cache_clear

elapsed1=`psql_import T8000M_1.csv T8000M_1 t8000m_1_db T8000M_1.sql`

cache_clear

elapsed2=`psql_import T8000M_1.csv T8000M_1 t8000m_1_db T8000M_1.sql`

cache_clear

elapsed3=`psql_import T8000M_1.csv T8000M_1 t8000m_1_db T8000M_1.sql`

echo 8000M: `avg $elapsed1 $elapsed2 $elapsed3`

# 12000M

cache_clear

elapsed1=`psql_import T12000M_1.csv T12000M_1 t12000m_1_db T12000M_1.sql`

cache_clear

elapsed2=`psql_import T12000M_1.csv T12000M_1 t12000m_1_db T12000M_1.sql`

cache_clear

elapsed3=`psql_import T12000M_1.csv T12000M_1 t12000m_1_db T12000M_1.sql`

echo 12000M: `avg $elapsed1 $elapsed2 $elapsed3`

wal_mode = minimal で実行したとき

wal_mode = replica で実行したとき

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)