OpenCV でビデオのフレーム間差分,トラッキングビジョン,オプティカルフロー(Python を使用)

【目次】

【関連する外部ページ】

- OpenCV の公式ページ: https://opencv.org

- GitHub の OpenCV のページ: https://github.com/opencv/opencv/releases

【サイト内の関連ページ】

- OpenCV について [PDF] , [パワーポイント]

- OpenCVとPythonを活用した画像・ビデオ処理プログラム: 別ページ »

前準備

Python のインストール(Windows,Ubuntu 上)

- Windows での Python 3.10,関連パッケージ,Python 開発環境のインストール(winget を使用しないインストール): 別ページ »で説明

- Ubuntu では,システム Pythonを使うことができる.Python3 開発用ファイル,pip, setuptools のインストール: 別ページ »で説明

【サイト内の関連ページ】

- Python のまとめ: 別ページ »にまとめ

- Google Colaboratory の使い方など: 別ページ »で説明

【関連する外部ページ】 Python の公式ページ: https://www.python.org/

Python 開発環境のインストール

- Windows での Python 開発環境として,Jupyter Qt Console, Jupyter ノートブック (Jupyter Notebook), Jupyter Lab, Nteract, spyder のインストール: 別ページ »で説明

- Windows での PyCharm のインストール: 別ページ »で説明

- Windows での PyScripter のインストール: 別ページ »で説明

OpenCV Python のインストール

Python で OpenCV を動かすためのもの.

OpenCV Python のインストールは:別ページ »で説明1~2 コマンドの実行でインストールできる.

このページで説明のために使用するビデオ

前準備として,動画ファイルを準備する

ここで使用する動画ファイル:sample1.mp4

この動画ファイルのダウンロードは, Windows でコマンドプロンプトを管理者として開き 次のコマンドを実行する.

mkdir c:\image

cd c:\image

curl -O https://www.kkaneko.jp/sample/face/sample1.mp4

上のコマンドがうまく

Python プログラムの実行

【サイト内の関連ページ】 Python のまとめ: 別ページ »

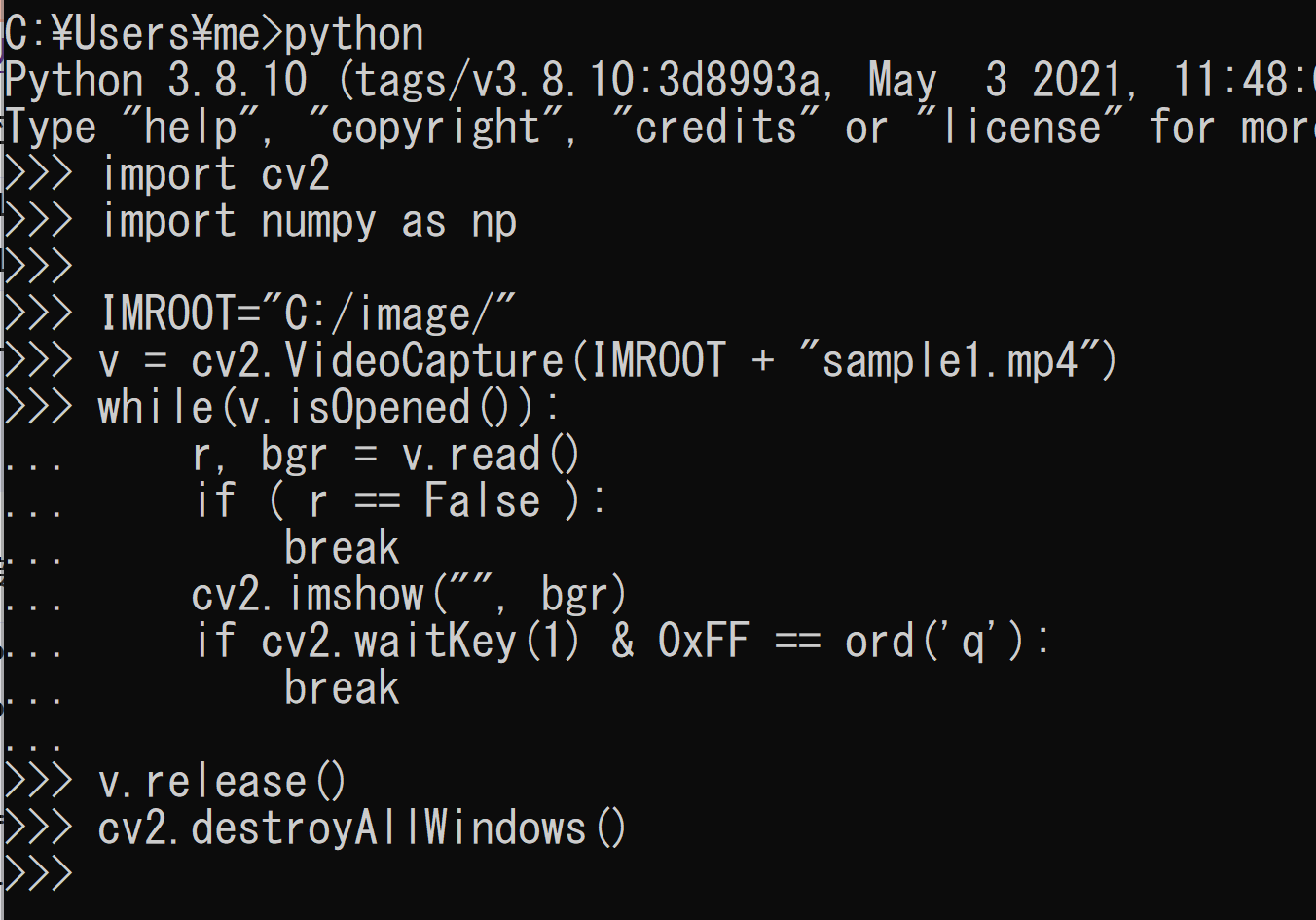

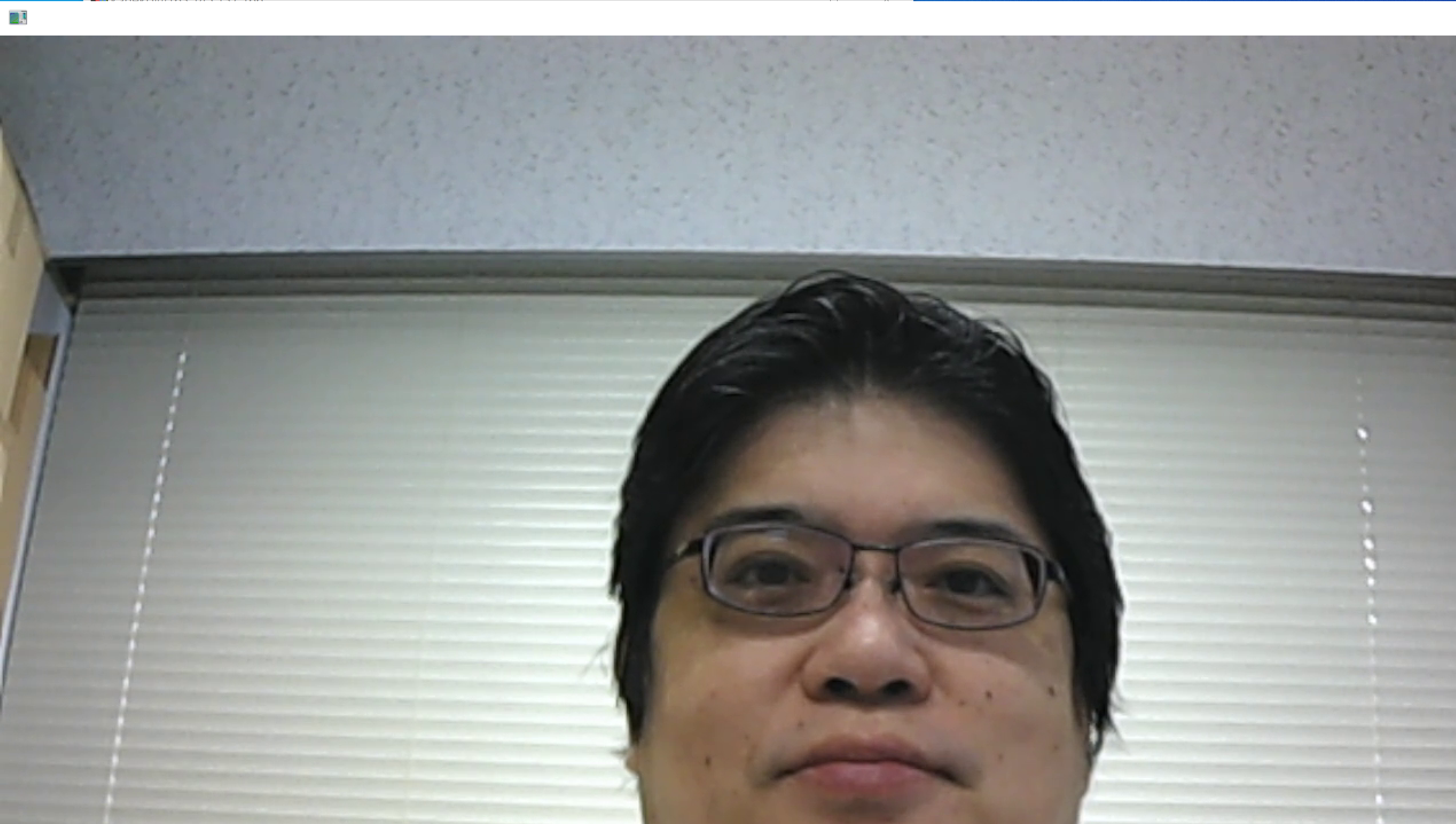

1フレームずつファイルから読み出しては,表示することを繰り返す.早送りに見えるのは正常動作.

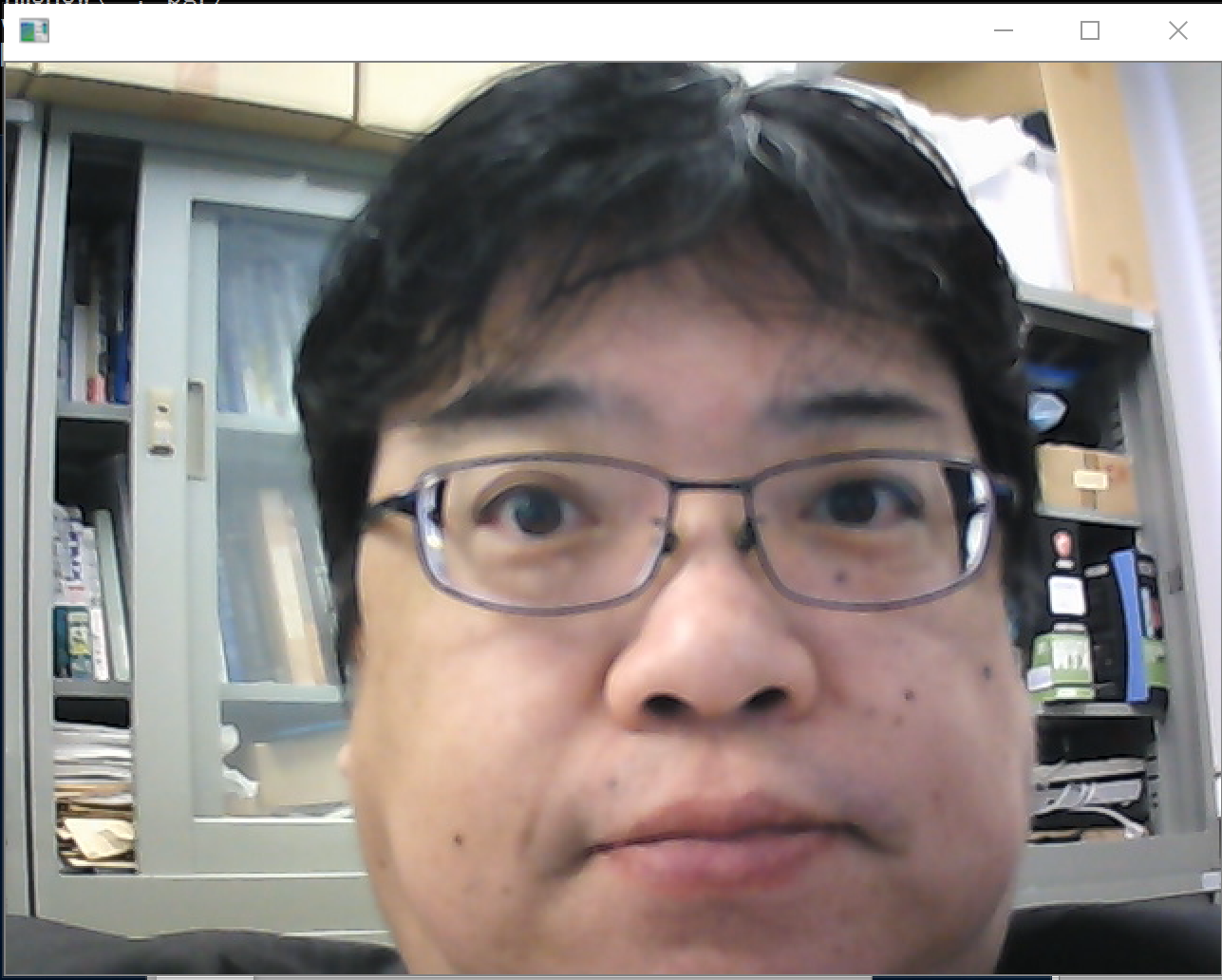

表示を確認.

このあと,ウインドウの右上の「x」をクリックしない.画面の中をクリックしてから,「q」キーを押して閉じる.以下同様.

パソコン接続できるビデオカメラを準備し,パソコンに接続しておく.

*「v = cv2.VideoCapture(0)」に変えただけ

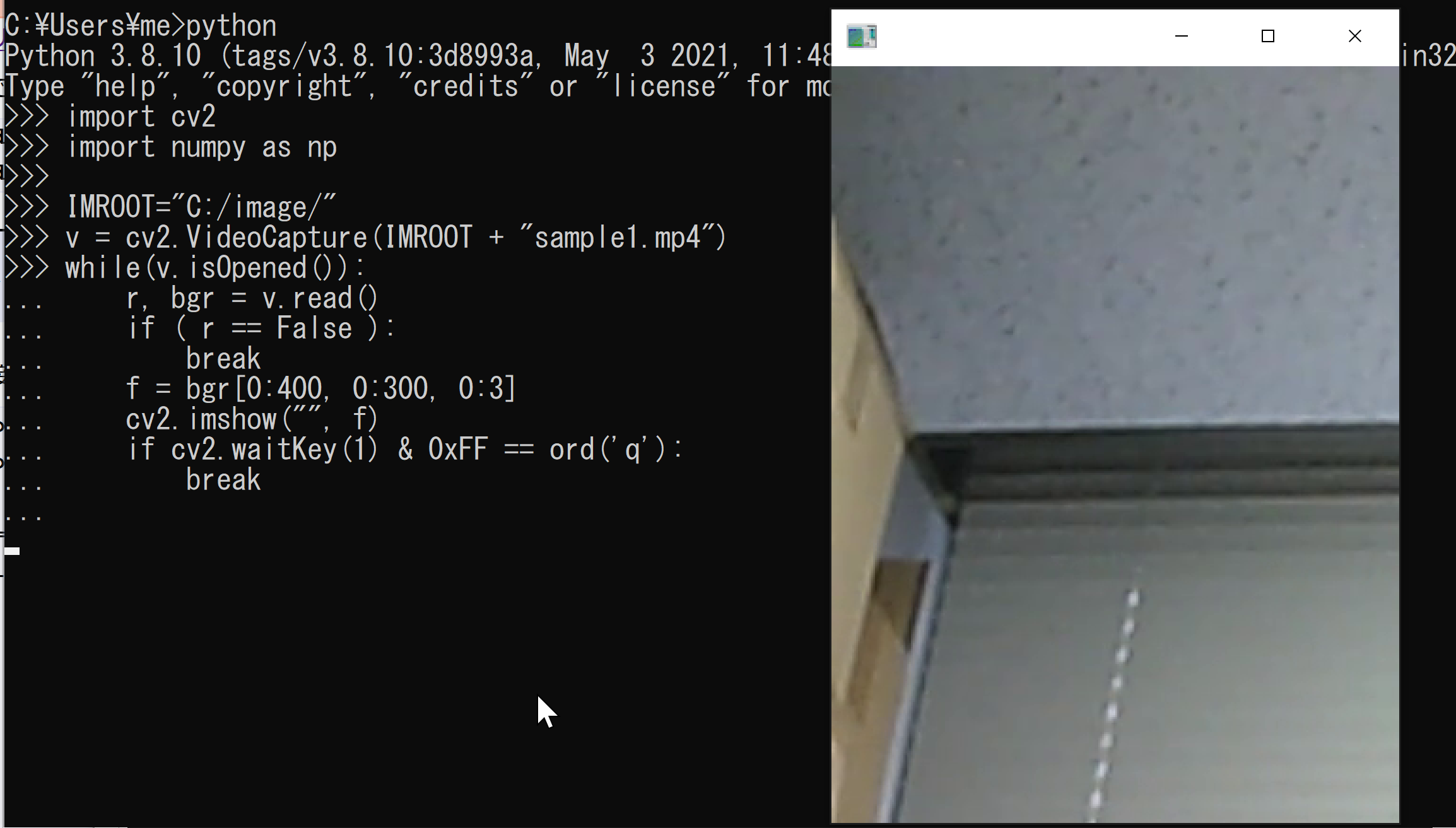

「bgr[0:400, 0:300, 0:3]」で範囲を指定して、必要部分の切り出しを行っている

* 止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

表示の一部分

パソコン接続できるビデオカメラを準備し,パソコンに接続しておく.

*「v = cv2.VideoCapture(0)」に変えただけ

「トラッキングに適するポイント(追跡用の点)」を複数抜き出す(Shi-Tomasi の手法)ことを行ってみる

* 途中で止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

パソコン接続できるビデオカメラを準備し,パソコンに接続しておく.

*「v = cv2.VideoCapture(0)」に変えただけ

* 途中で止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

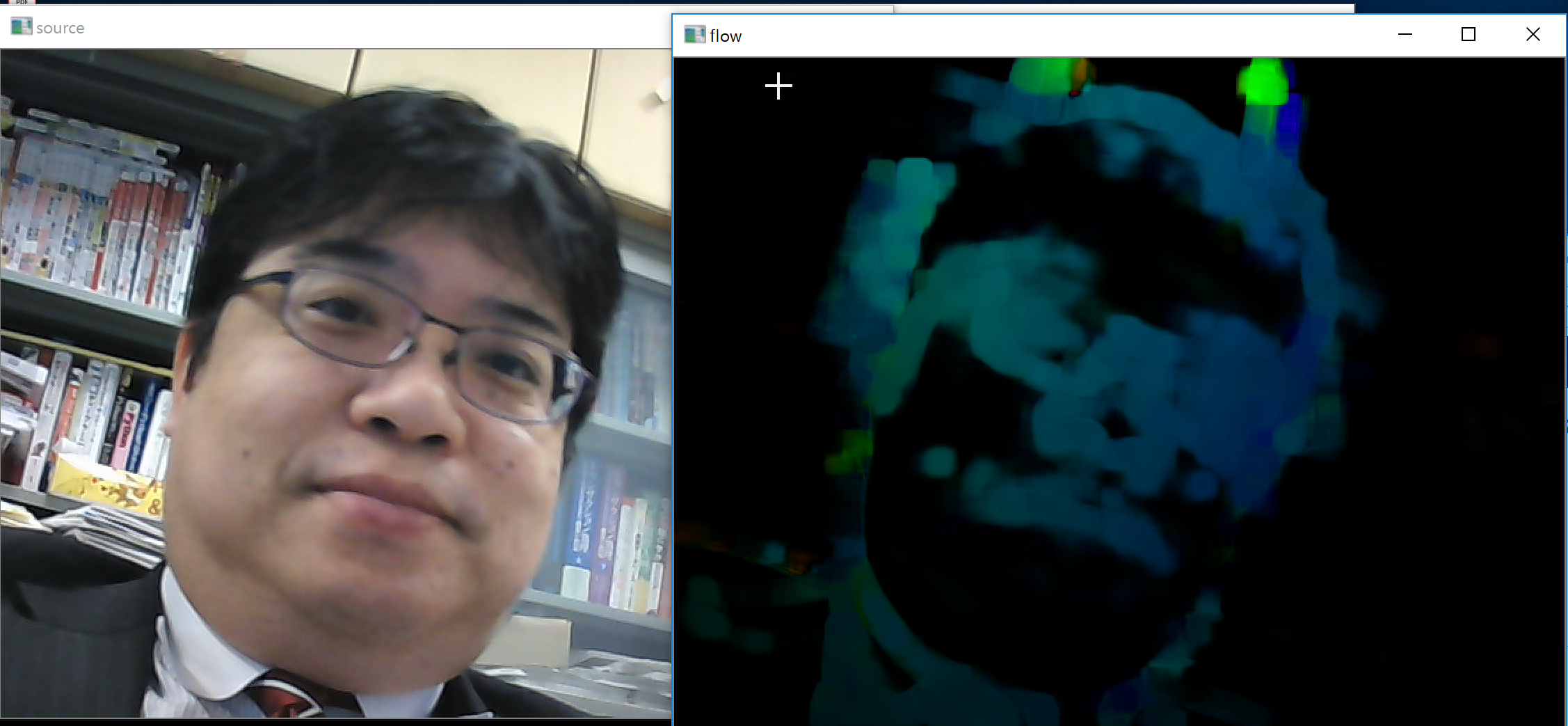

オプティカルフローは,ビデオから「動きの情報」を取り出す

* 途中で止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

パソコン接続できるビデオカメラを準備し,パソコンに接続しておく.

*「v = cv2.VideoCapture(0)」に変えただけ

* 途中で止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

謝辞:https://github.com/opencv/opencv/blob/master/samples/python/stereo_match.py

で公開されているプログラムに少し手を加えて使用している(video パッケージを使わない。パソコンカメラを使うようにしている)

動画ファイルの表示

動画ファイルの表示例

import os

import numpy as np

import cv2

IMROOT=os.environ['LOCALAPPDATA'] + '/'

v = cv2.VideoCapture(IMROOT + "sample1.mp4")

while(v.isOpened()):

r, bgr = v.read()

if ( r == False ):

break

cv2.imshow("", bgr)

# Press Q to exit

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

パソコン接続ビデオカメラの表示例

import cv2

import numpy as np

v = cv2.VideoCapture(0)

while(v.isOpened()):

r, bgr = v.read()

if ( r == False ):

break

cv2.imshow("", bgr)

# Press Q to exit

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

動画ファイルの表示例(必要部分の切り出し)

import os

import numpy as np

import cv2

IMROOT=os.environ['LOCALAPPDATA'] + '/'

v = cv2.VideoCapture(IMROOT + "sample1.mp4")

while(v.isOpened()):

r, bgr = v.read()

if ( r == False ):

break

f = bgr[0:400, 0:300, 0:3]

cv2.imshow("", f)

# Press Q to exit

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

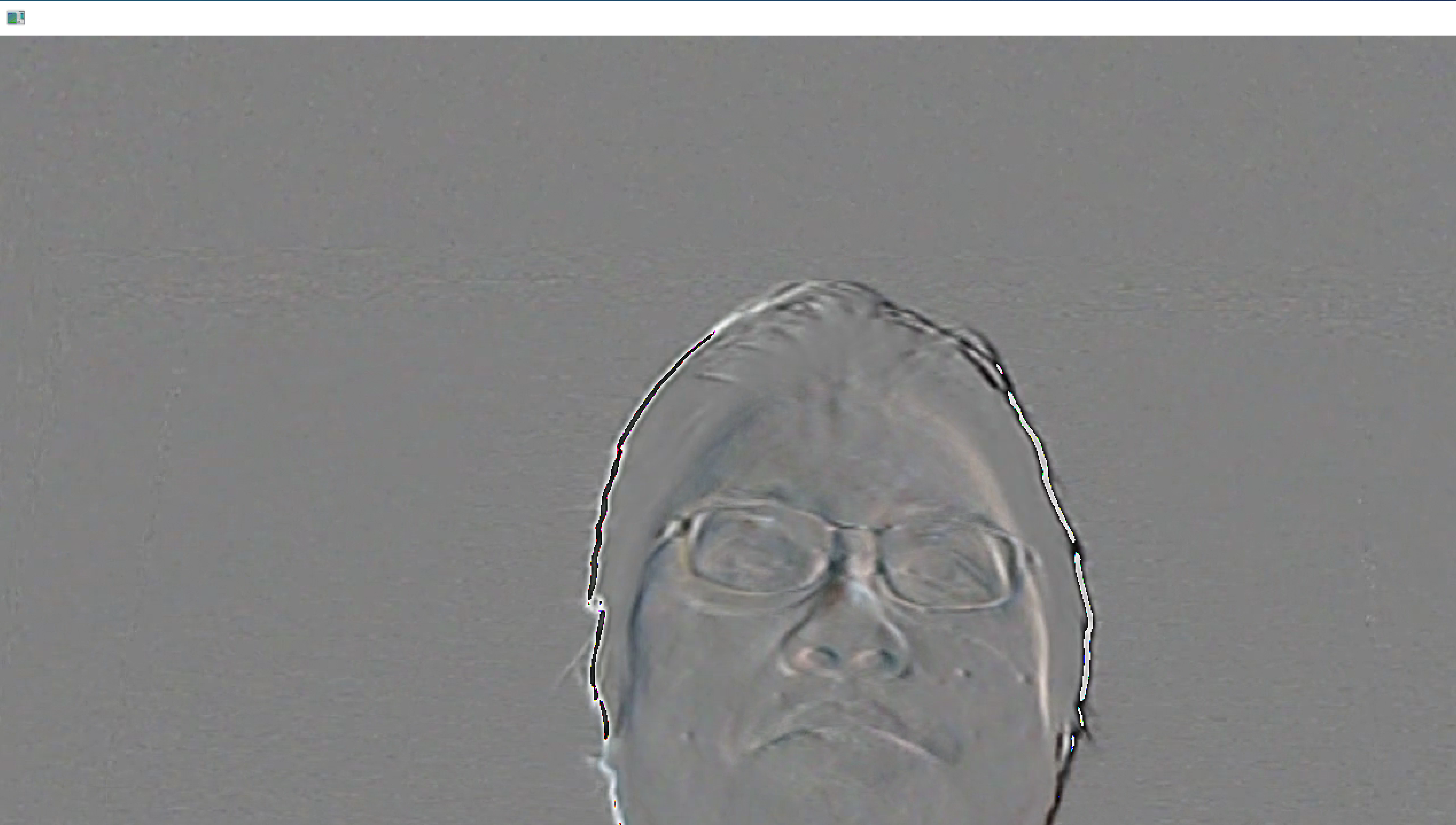

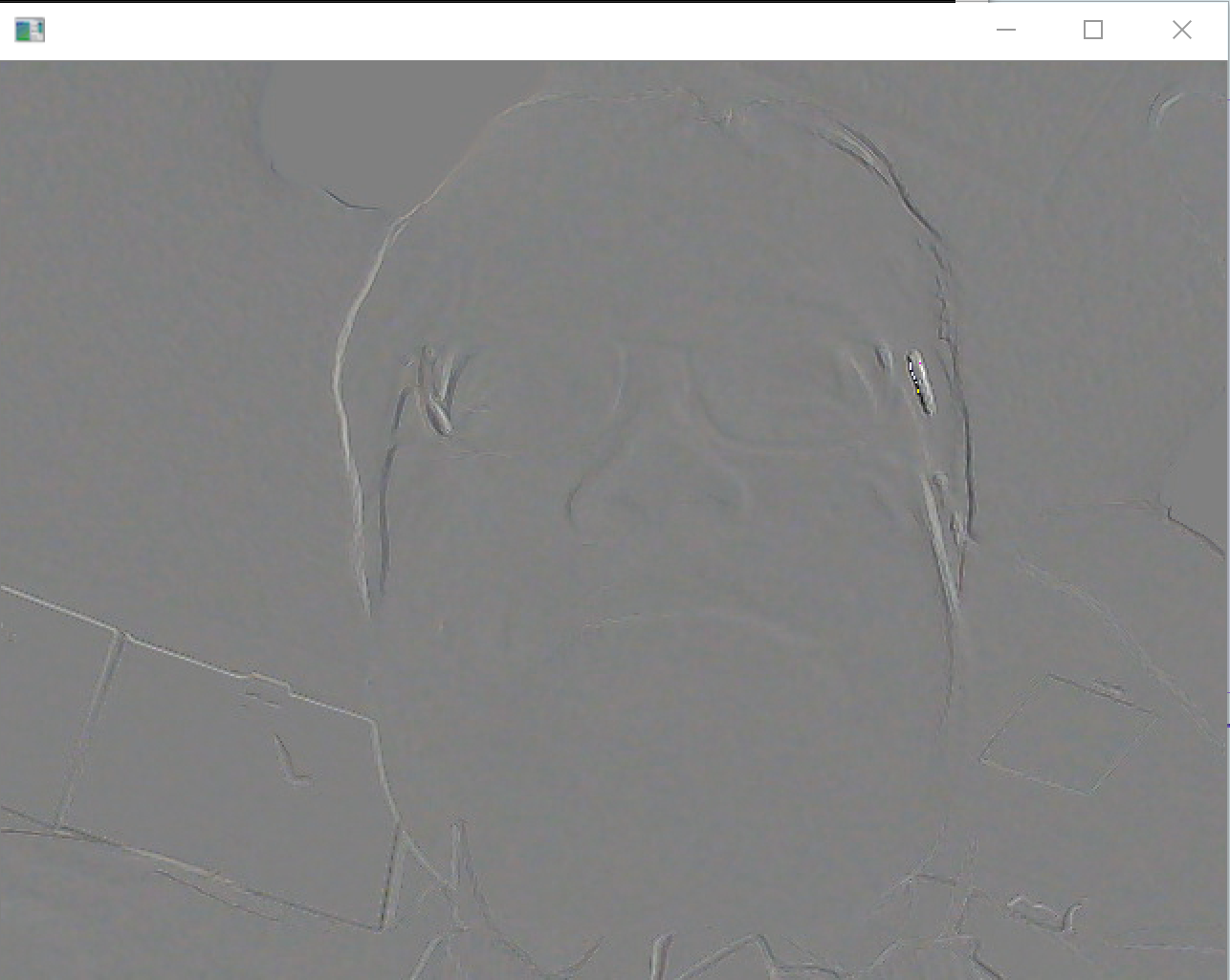

連続フレームの差分表示(フレーム間差分)

動画ファイル

import os

import numpy as np

import cv2

IMROOT=os.environ['LOCALAPPDATA'] + '/'

v = cv2.VideoCapture(IMROOT + "sample1.mp4")

r, bgr = v.read()

while(v.isOpened()):

bgr2 = bgr

r, bgr = v.read()

if ( r == False ):

break

cv2.imshow("", bgr - bgr2 + 128)

# Press Q to exit

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

パソコン接続ビデオカメラ

import cv2

import numpy as np

v = cv2.VideoCapture(0)

r, bgr = v.read()

while(v.isOpened()):

bgr2 = bgr

r, bgr = v.read()

if ( r == False ):

break

cv2.imshow("", bgr - bgr2 + 128)

# Press Q to exit

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

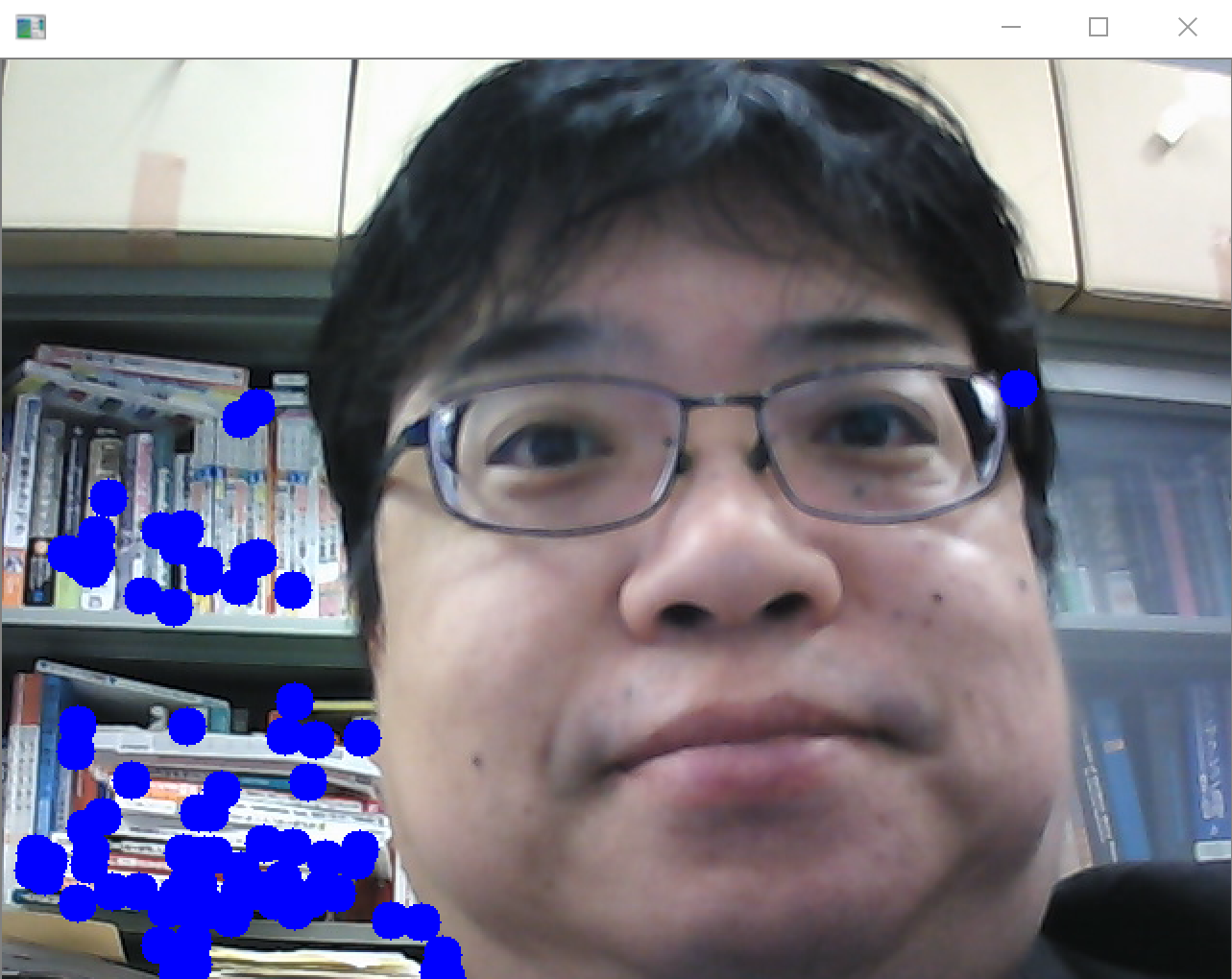

トラッキングビジョン

動画ファイル

import os

import numpy as np

import cv2

IMROOT=os.environ['LOCALAPPDATA'] + '/'

v = cv2.VideoCapture(IMROOT + "sample1.mp4")

fourcc = cv2.VideoWriter_fourcc(*'XVID')

while(v.isOpened()):

r, bgr = v.read()

if ( r == False ):

break

g = cv2.cvtColor(bgr, cv2.COLOR_BGR2GRAY)

d = cv2.goodFeaturesToTrack(g, 80, 0.01, 5, 3)

if d is not None:

d = np.int0(d)

for i in d:

x,y = i.ravel()

cv2.circle(bgr, (x,y), 10, 255, -1)

cv2.imshow("", bgr)

# Press Q to exit

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

パソコン接続ビデオカメラ

import cv2

import numpy as np

v = cv2.VideoCapture(0)

fourcc = cv2.VideoWriter_fourcc(*'XVID')

while(v.isOpened()):

r, bgr = v.read()

if ( r == False ):

break

g = cv2.cvtColor(bgr, cv2.COLOR_BGR2GRAY)

d = cv2.goodFeaturesToTrack(g, 80, 0.01, 5, 3)

if d is not None:

d = np.int0(d)

for i in d:

x,y = i.ravel()

cv2.circle(bgr, (x,y), 10, 255, -1)

cv2.imshow("", bgr)

# Press Q to exit

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

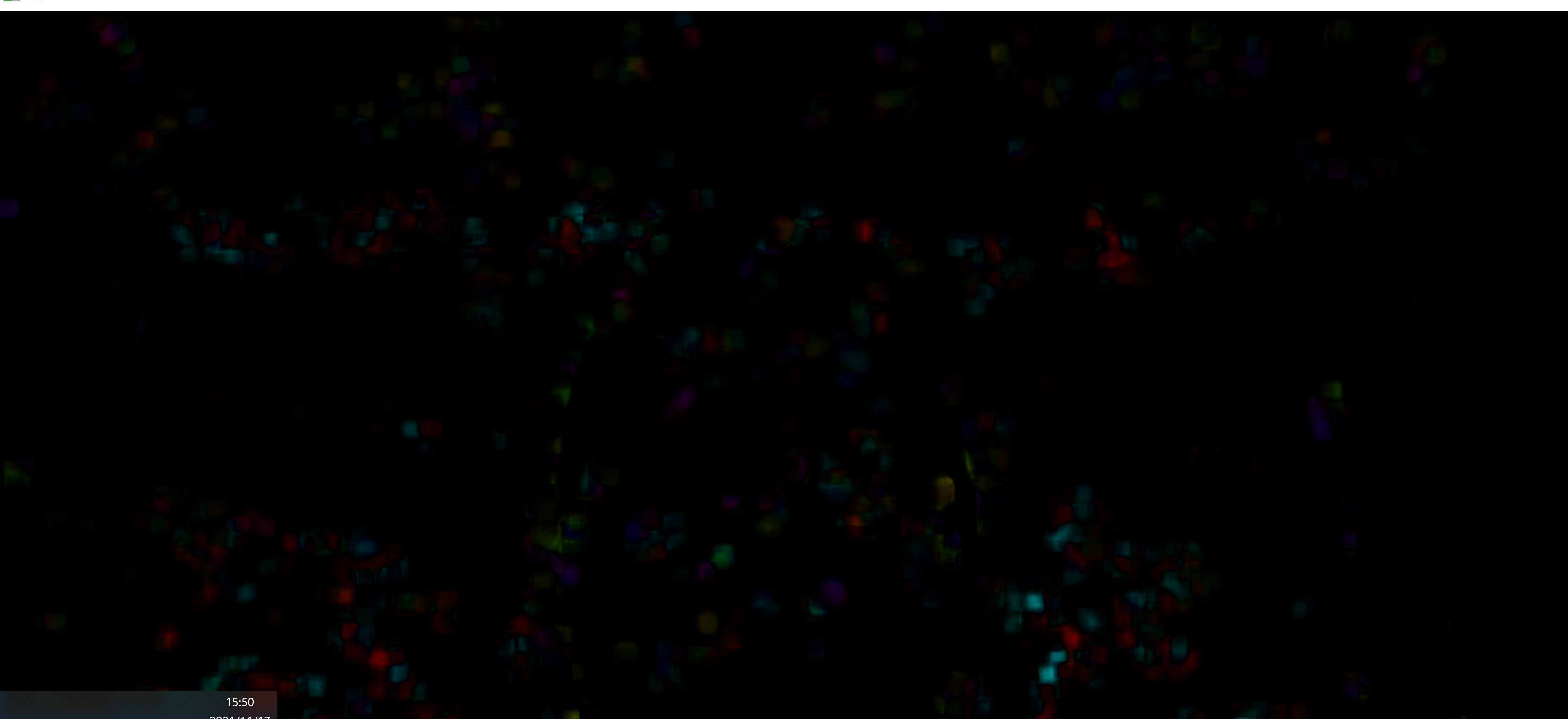

オプティカルフロー(Farnebackの方法による)

動画ファイル

import os

import numpy as np

import cv2

IMROOT=os.environ['LOCALAPPDATA'] + '/'

v = cv2.VideoCapture(IMROOT + "sample1.mp4")

fourcc = cv2.VideoWriter_fourcc(*'XVID')

ret, bgr1 = v.read()

prvs = cv2.cvtColor(bgr1,cv2.COLOR_BGR2GRAY)

hsv = np.zeros_like(bgr1)

hsv[...,1] = 255

while(1):

ret, bgr2 = v.read()

next = cv2.cvtColor(bgr2, cv2.COLOR_BGR2GRAY)

# pyr_scale, levels, winsize, iterations, poly_n, poly_sigma, flags

flow = cv2.calcOpticalFlowFarneback(prvs, next, None, 0.5, 3, 15, 3, 5, 1.2, 0)

mag, ang = cv2.cartToPolar(flow[...,0], flow[...,1])

hsv[...,0] = ang*180/np.pi/2

hsv[...,2] = cv2.normalize(mag,None,0,255,cv2.NORM_MINMAX)

rgb = cv2.cvtColor(hsv,cv2.COLOR_HSV2BGR)

cv2.imshow('source',bgr2)

cv2.imshow('flow',rgb)

# Press Q to exit

if cv2.waitKey(1) & 0xFF == ord('q'):

break

prvs = next

v.release()

cv2.destroyAllWindows()

パソコン接続ビデオカメラ

import cv2

import numpy as np

v = cv2.VideoCapture(0)

fourcc = cv2.VideoWriter_fourcc(*'XVID')

ret, bgr1 = v.read()

prvs = cv2.cvtColor(bgr1,cv2.COLOR_BGR2GRAY)

hsv = np.zeros_like(bgr1)

hsv[...,1] = 255

while(1):

ret, bgr2 = v.read()

next = cv2.cvtColor(bgr2, cv2.COLOR_BGR2GRAY)

# pyr_scale, levels, winsize, iterations, poly_n, poly_sigma, flags

flow = cv2.calcOpticalFlowFarneback(prvs, next, None, 0.5, 3, 15, 3, 5, 1.2, 0)

mag, ang = cv2.cartToPolar(flow[...,0], flow[...,1])

hsv[...,0] = ang*180/np.pi/2

hsv[...,2] = cv2.normalize(mag,None,0,255,cv2.NORM_MINMAX)

rgb = cv2.cvtColor(hsv,cv2.COLOR_HSV2BGR)

cv2.imshow('source',bgr2)

cv2.imshow('flow',rgb)

# Press Q to exit

if cv2.waitKey(1) & 0xFF == ord('q'):

break

prvs = next

v.release()

cv2.destroyAllWindows()

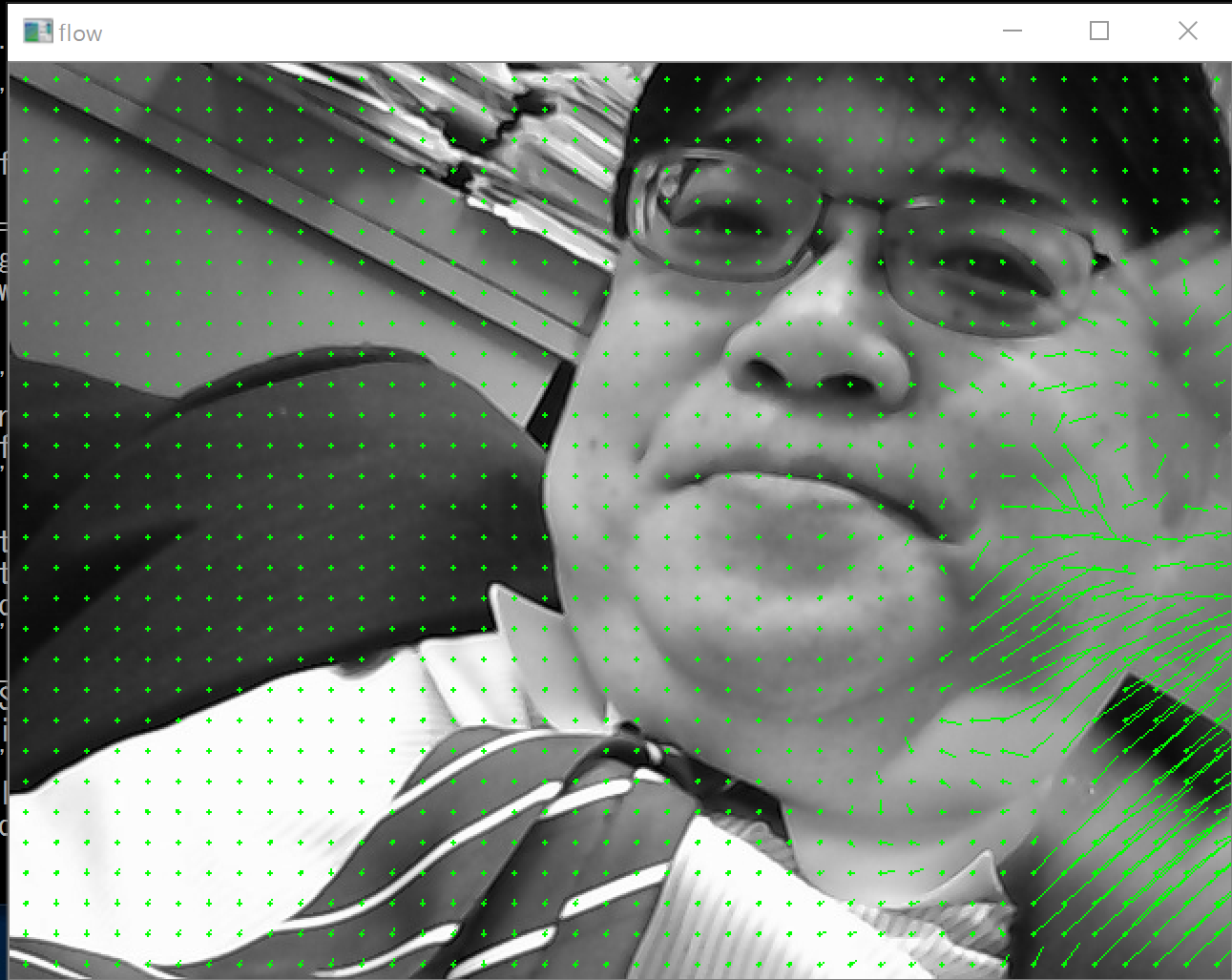

DIS optical flow

import numpy as np

import cv2 as cv

def draw_flow(img, flow, step=16):

h, w = img.shape[:2]

y, x = np.mgrid[step/2:h:step, step/2:w:step].reshape(2,-1).astype(int)

fx, fy = flow[y,x].T

lines = np.vstack([x, y, x+fx, y+fy]).T.reshape(-1, 2, 2)

lines = np.int32(lines + 0.5)

vis = cv.cvtColor(img, cv.COLOR_GRAY2BGR)

cv.polylines(vis, lines, 0, (0, 255, 0))

for (x1, y1), (x2, y2) in lines:

cv.circle(vis, (x1, y1), 1, (0, 255, 0), -1)

return vis

def draw_hsv(flow):

h, w = flow.shape[:2]

fx, fy = flow[:,:,0], flow[:,:,1]

ang = np.arctan2(fy, fx) + np.pi

v = np.sqrt(fx*fx+fy*fy)

hsv = np.zeros((h, w, 3), np.uint8)

hsv[...,0] = ang*(180/np.pi/2)

hsv[...,1] = 255

hsv[...,2] = np.minimum(v*4, 255)

bgr = cv.cvtColor(hsv, cv.COLOR_HSV2BGR)

return bgr

def warp_flow(img, flow):

h, w = flow.shape[:2]

flow = -flow

flow[:,:,0] += np.arange(w)

flow[:,:,1] += np.arange(h)[:,np.newaxis]

res = cv.remap(img, flow, None, cv.INTER_LINEAR)

return res

import sys

cam = cv.VideoCapture(0)

ret, prev = cam.read()

prevgray = cv.cvtColor(prev, cv.COLOR_BGR2GRAY)

show_hsv = False

show_glitch = False

use_spatial_propagation = False

use_temporal_propagation = True

cur_glitch = prev.copy()

inst = cv.DISOpticalFlow.create(cv.DISOPTICAL_FLOW_PRESET_MEDIUM)

inst.setUseSpatialPropagation(use_spatial_propagation)

flow = None

while True:

ret, img = cam.read()

gray = cv.cvtColor(img, cv.COLOR_BGR2GRAY)

if flow is not None and use_temporal_propagation:

#warp previous flow to get an initial approximation for the current flow:

flow = inst.calc(prevgray, gray, warp_flow(flow,flow))

else:

flow = inst.calc(prevgray, gray, None)

prevgray = gray

cv.imshow('flow', draw_flow(gray, flow))

if show_hsv:

cv.imshow('flow HSV', draw_hsv(flow))

if show_glitch:

cur_glitch = warp_flow(cur_glitch, flow)

cv.imshow('glitch', cur_glitch)

ch = 0xFF & cv.waitKey(5)

if ch == 27:

break

if ch == ord('1'):

show_hsv = not show_hsv

print('HSV flow visualization is', ['off', 'on'][show_hsv])

if ch == ord('2'):

show_glitch = not show_glitch

if show_glitch:

cur_glitch = img.copy()

print('glitch is', ['off', 'on'][show_glitch])

if ch == ord('3'):

use_spatial_propagation = not use_spatial_propagation

inst.setUseSpatialPropagation(use_spatial_propagation)

print('spatial propagation is', ['off', 'on'][use_spatial_propagation])

if ch == ord('4'):

use_temporal_propagation = not use_temporal_propagation

print('temporal propagation is', ['off', 'on'][use_temporal_propagation])

cv.destroyAllWindows()

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)