Apache Spark 3.4.0 のインストールとテスト実行(Ubuntu 上)

前準備

Ubuntu のシステム更新

Ubuntu で OS のシステム更新を行うときは, 次のコマンドを実行.

Ubuntu で OS のシステム更新を行うときは, 端末で,次のコマンドを実行する。これは、パッケージ情報を最新の状態に保ち、インストール済みのパッケージをセキュリティアップデートやバグ修正を含めて更新するためである。

# パッケージリストの情報を更新

sudo apt update

# インストール済みのパッケージを包括的に更新 (依存関係も考慮)

sudo apt full-upgrade

# カーネル更新等で実際に再起動が必要な場合のみ実行を推奨

# sudo shutdown -r now

Git のインストール

端末で,次のコマンドを実行する.

# パッケージリストの情報を更新

sudo apt update

sudo apt -y install git

前準備として JDK のインストール

OpenJDK 18 のインストールと設定(Ubuntu 上): 別ページ »で説明

* その利用条件は,利用者自身で確認すること.

Apache Spark のインストールとテスト実行(Ubuntu 上)

次のURL に記載の手順でインストールを行う.

- インストール操作

次のコマンドを実行.

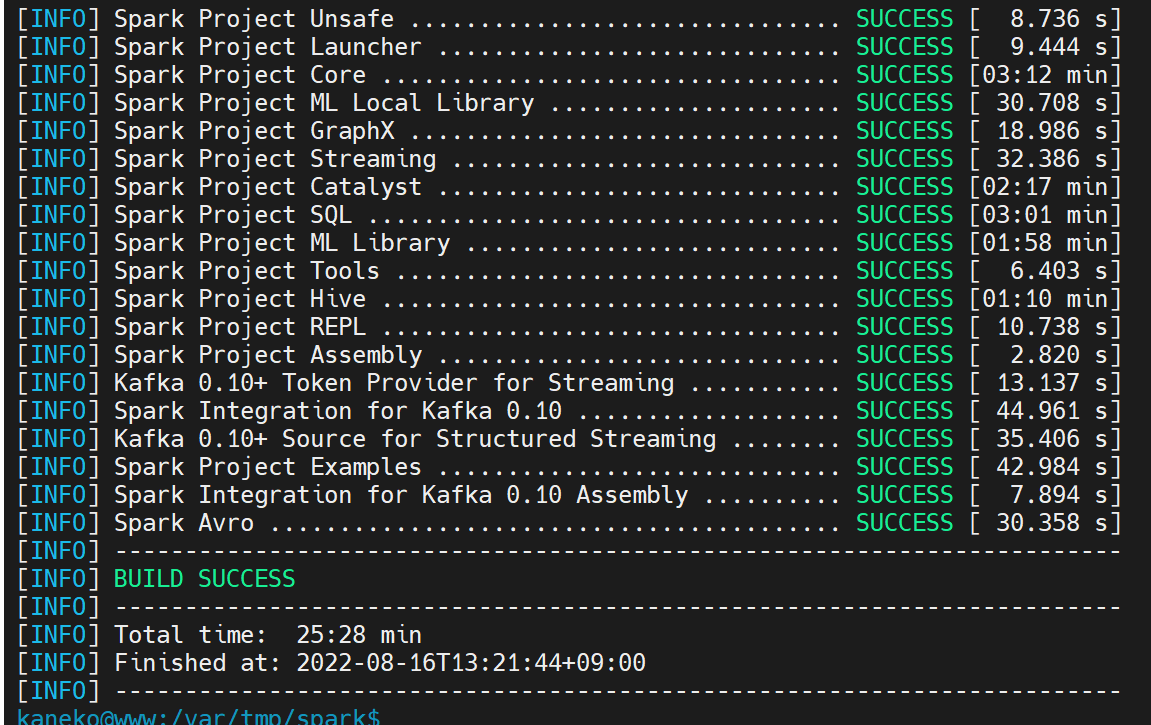

export SROOT=/var/tmp sudo apt -y install maven cd $SROOT git clone https://github.com/apache/spark cd spark ./build/mvn -DskipTests clean package - 終了の確認

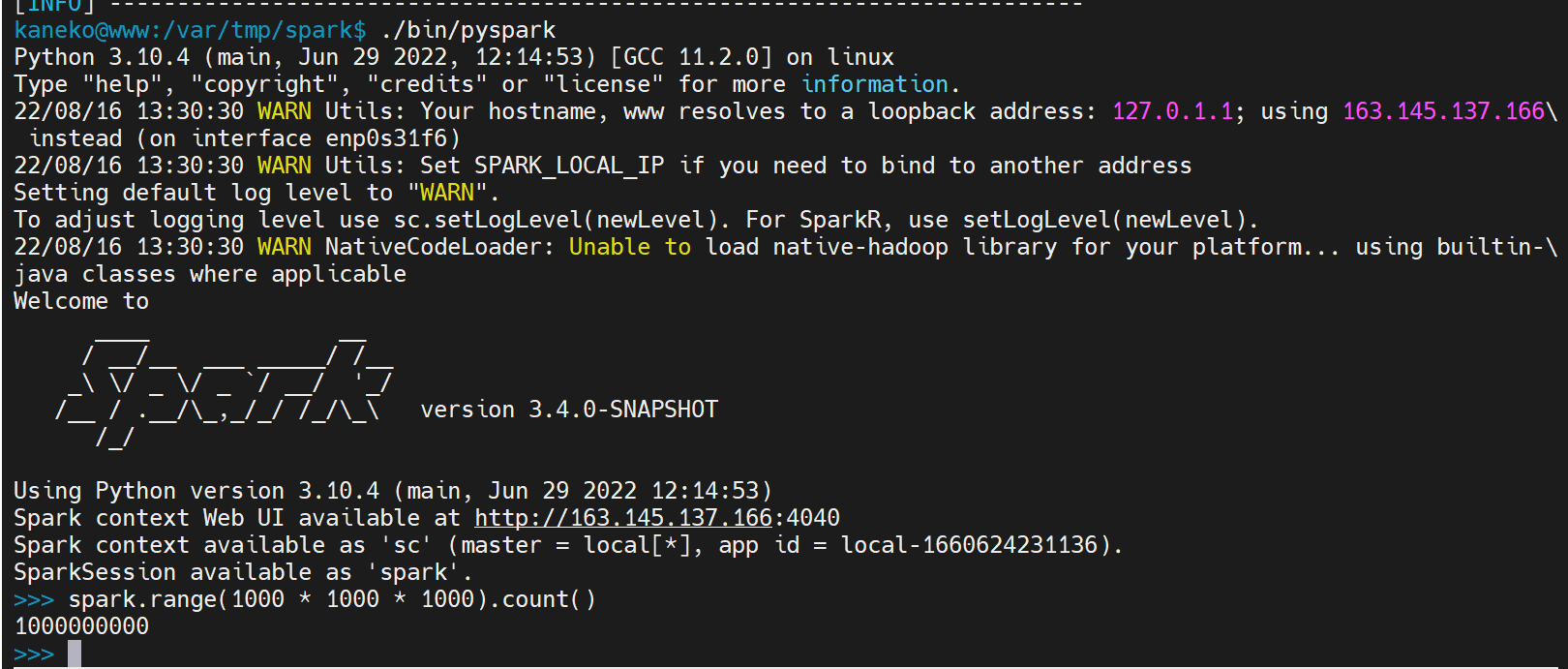

- 確認のため,Apache Spark の Python シェルを起動し,簡単なプログラムを動かしてみる.

./bin/pyspark spark.range(1000 * 1000 * 1000).count()

SQL の実行例

pyspark

sqlContext.read.format("com.databricks.spark.csv").option("header", "false").option("inferSchema", "true").load("/tmp/w.csv").registerTempTable("weather")

r = sqlContext.sql("select * from weather")

d.show()

d.schema

r.show()

r.schema

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)