Grounding DINO のインストールと動作確認(ゼロショットの物体検出とセグメンテーション) (Python,PyTorch を使用)(Windows 上)

Grounding DINOは、Zero-Shot TransferとReferring Object Detectionに対応した高度な物体検出モデルである。このモデルはDINOとGrounded Pre-Trainingを組み合わせている。現在の実装では、Swin-TやSwin-Lをバックボーンとして使用している。Windows環境でのインストールは、GitHubからのリポジトリクローンと必要なパッケージのインストールで完了する。訓練済みモデルもダウンロード可能である。動作確認はPythonを用いて行い、指定したプロンプトに基づいての動作が可能である。さらに、画像選択ダイアログで画像を選択し、プロンプトも実行時にユーザーが指定できるPythonプログラムを示している。このページの手順により、Grounding DINOの基本的なセットアップと動作確認が簡単に行える。詳細は公式のGitHubページで確認できる。

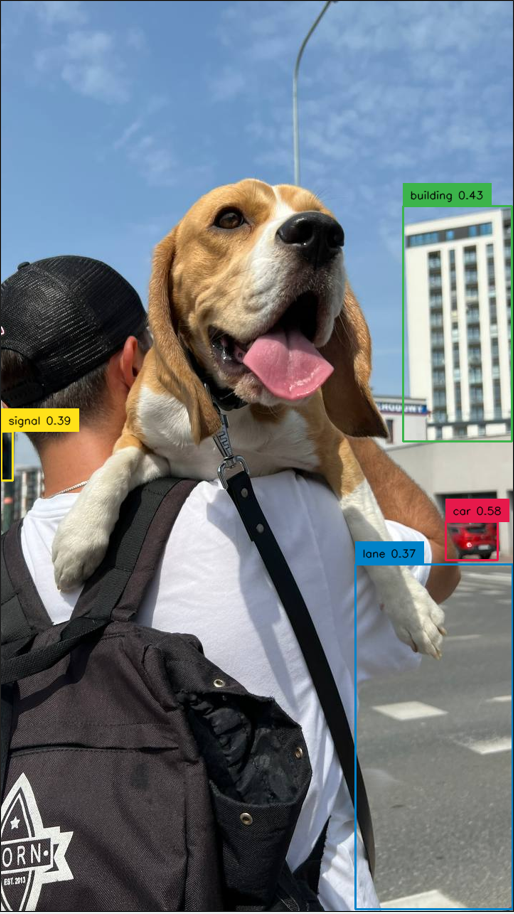

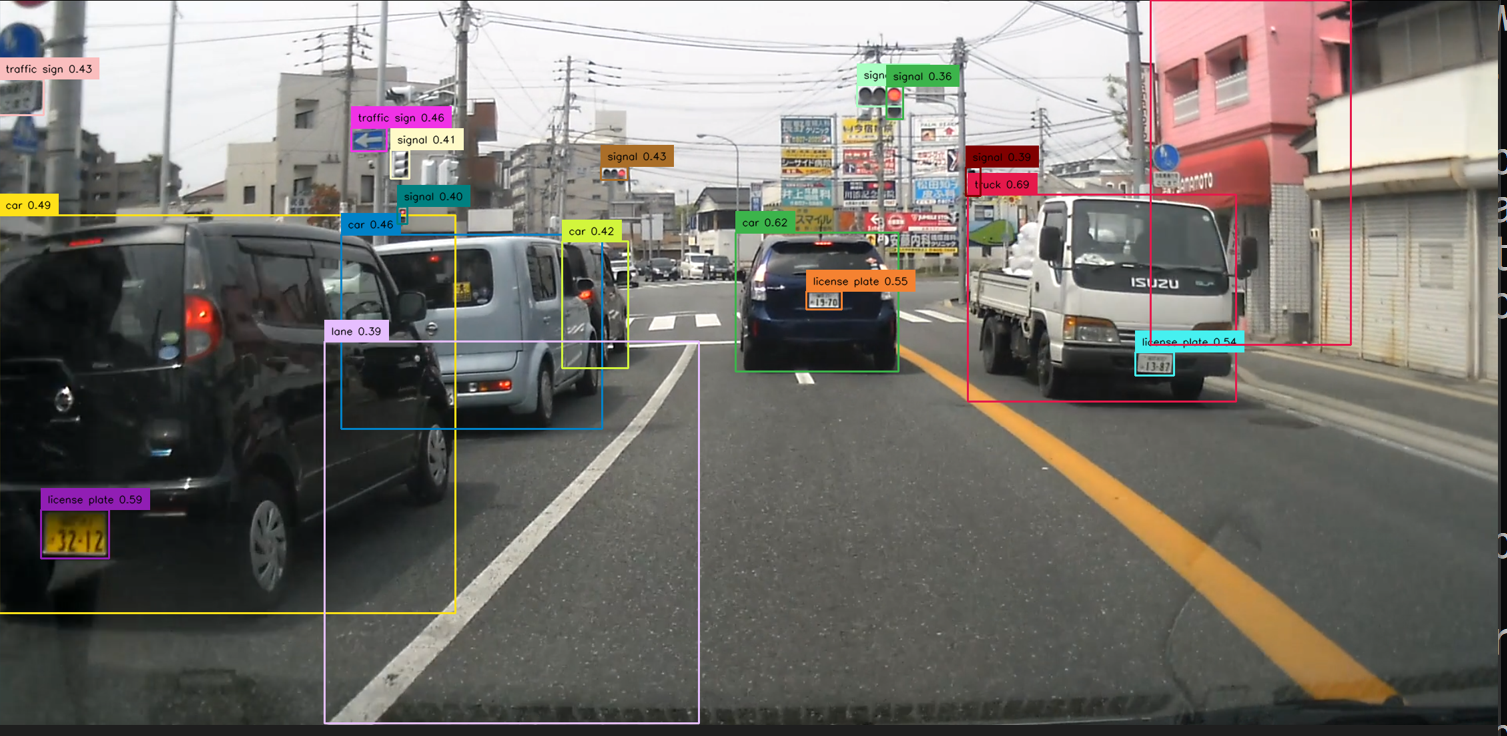

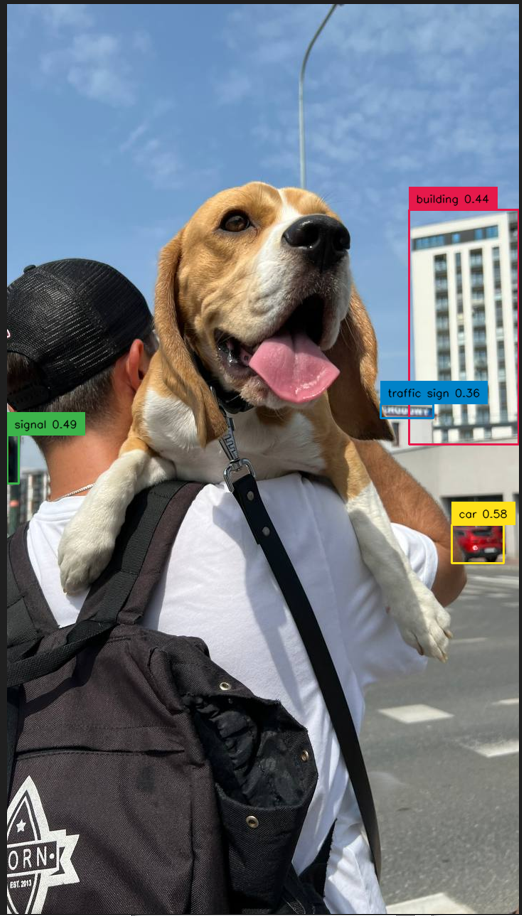

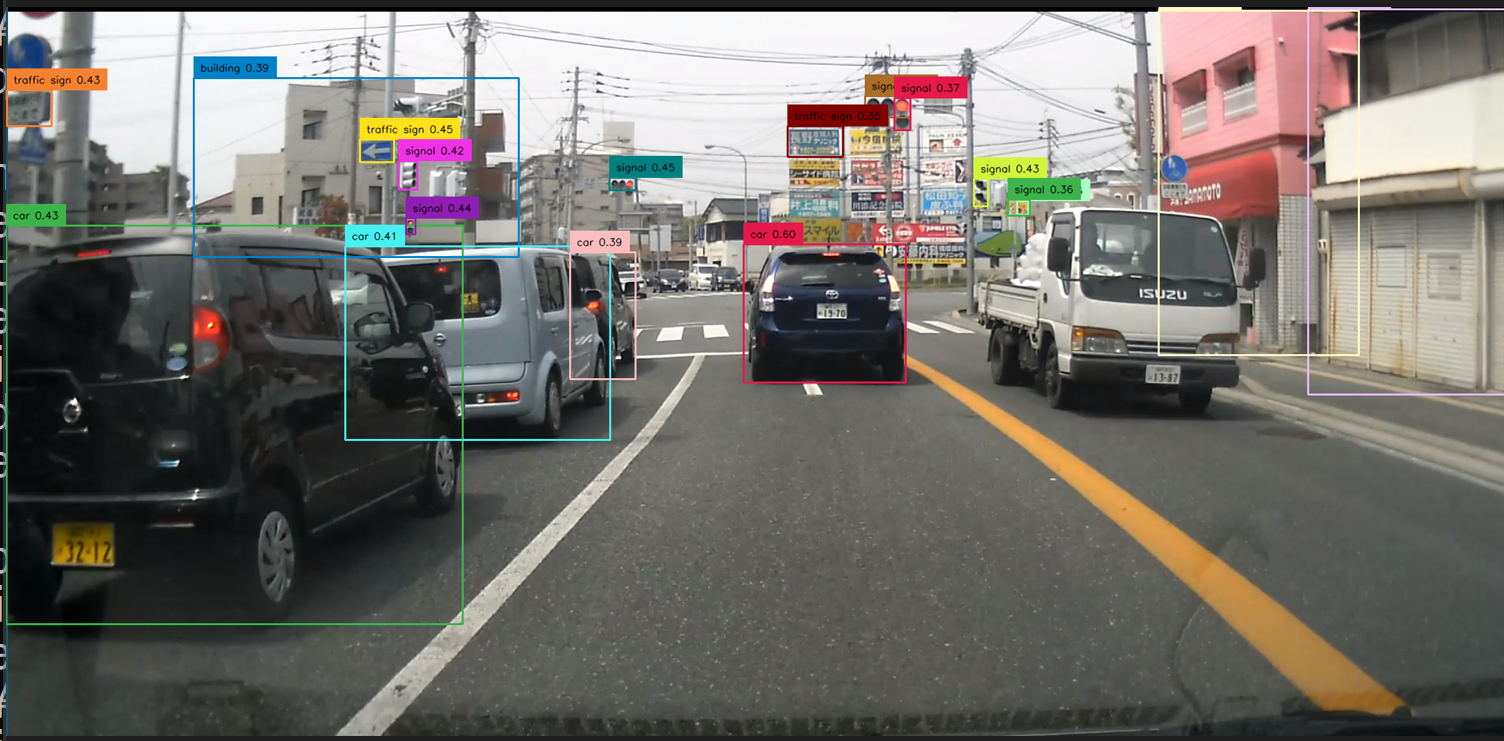

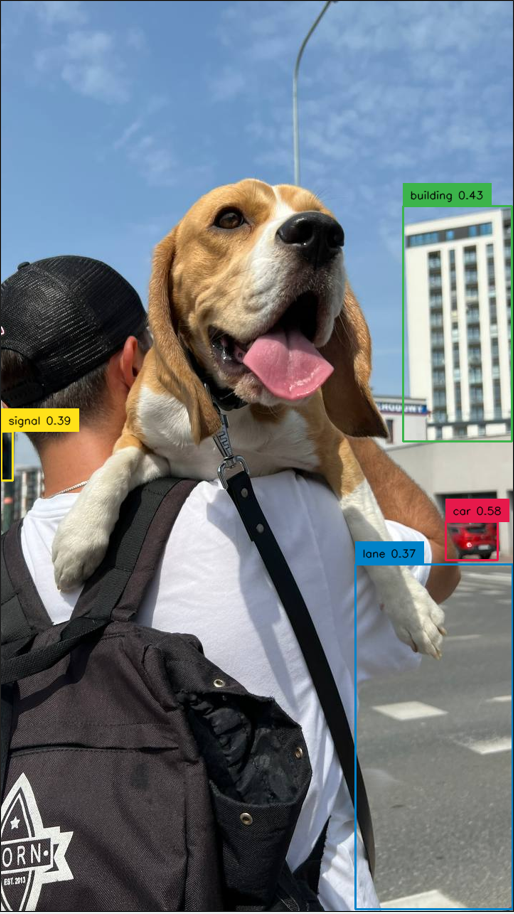

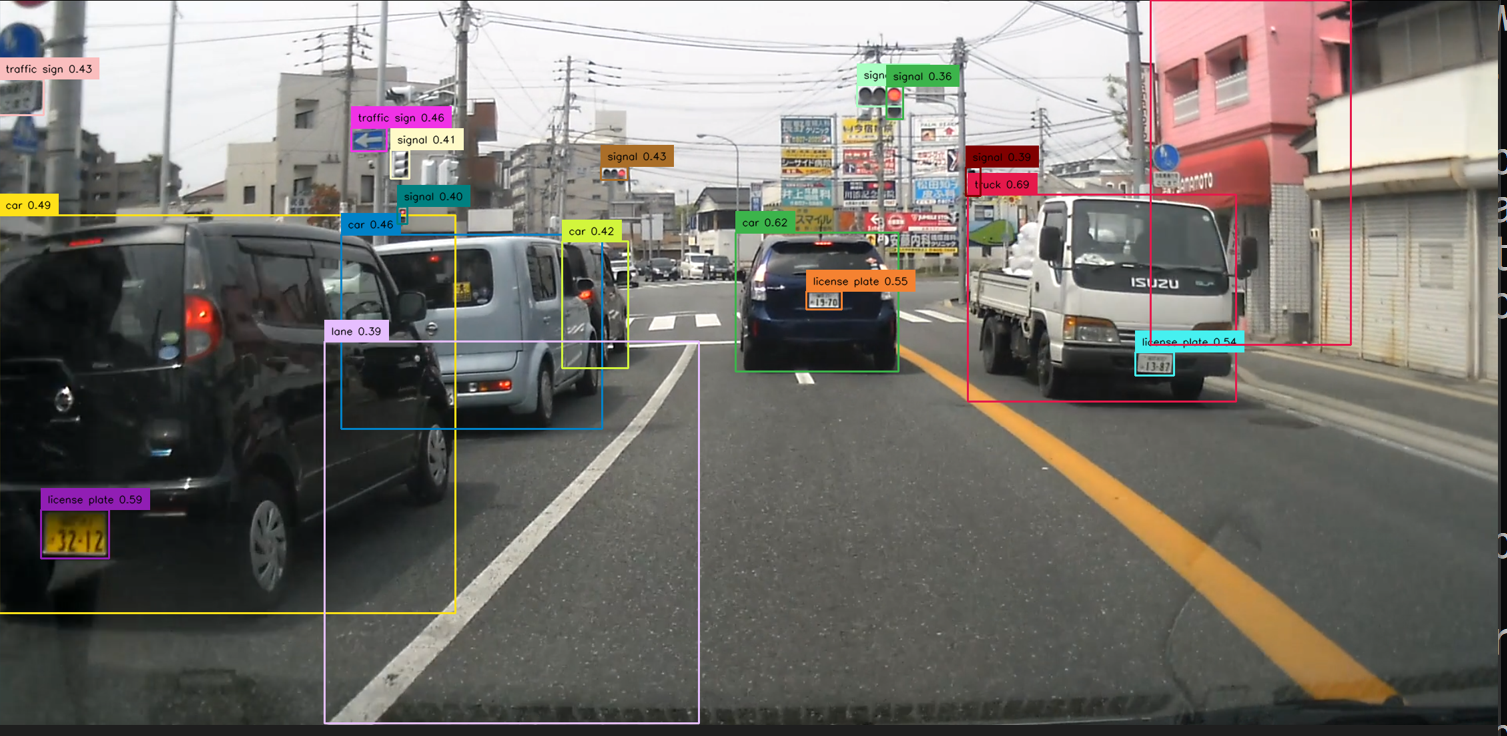

テキストのプロンプトとして,「building . car . signal . traffic sign」を指定したときの実行結果は次の通り.

【目次】

- 前準備

- Grounding DINO のインストール(Windows 上)

- Grounding DINO の動作確認(Windows 上)

- Grounding DINO を使う Python プログラムの実行(Windows 上)

Grounding DINO

Grounding DINO は,Zero-Shot TransferとReferring Object Detectionという二つの物体検出タスクに対応している。精度向上のために、DINO(自己教師あり学習手法)とGrounded Pre-Trainingが組み合わされています。Grounding DINO の実験では、バックボーンとして、Swin-TやSwin-Lが採用された。実験結果では、Zero-Shot Transferのタスクで、Grounding DINOはDINOとGLIPを上回る高い精度を達成していることが示されている。

【文献】

Liu, Shilong and Zeng, Zhaoyang and Ren, Tianhe and Li, Feng and Zhang, Hao and Yang, Jie and Li, Chunyuan and Yang, Jianwei and Su, Hang and Zhu, Jun and others, Grounding dino: Marrying dino with grounded pre-training for open-set object detection, arXiv preprint arXiv:2303.05499, 2023.

https://arxiv.org/pdf/2303.05499v4.pdf

【関連する外部ページ】

- 公式の GitHub のページ: https://github.com/idea-research/groundingdino

- Grounding DINO のオンラインデモ(Google Colaboratory 上): https://colab.research.google.com/github/roboflow-ai/notebooks/blob/main/notebooks/zero-shot-object-detection-with-grounding-dino.ipynb

- Paper with Code のページ: https://paperswithcode.com/paper/grounding-dino-marrying-dino-with-grounded

前準備

Build Tools for Visual Studio 2022 のインストール(Windows 上)

Build Tools for Visual Studio は,Visual Studio の IDE を含まない C/C++ コンパイラ,ライブラリ,ビルドツール等のコマンドライン向け開発ツールセットである。

以下のコマンドを管理者権限のコマンドプロンプトで実行する

(手順:Windowsキーまたはスタートメニュー → cmd と入力 → 右クリック → 「管理者として実行」)。

REM VC++ ランタイム

winget install --scope machine --accept-source-agreements --accept-package-agreements --silent --id Microsoft.VCRedist.2015+.x64

REM Build Tools + Desktop development with C++(VCTools)+ 追加コンポーネント(一括)

winget install --id Microsoft.VisualStudio.2022.BuildTools ^

--override "--passive --wait --add Microsoft.VisualStudio.Workload.VCTools --includeRecommended --add Microsoft.VisualStudio.Component.VC.Llvm.Clang --add Microsoft.VisualStudio.ComponentGroup.ClangCL --add Microsoft.VisualStudio.Component.VC.CMake.Project --add Microsoft.VisualStudio.Component.Windows11SDK.26100"--add で追加されるコンポーネント

上記のコマンドでは,まず Build Tools 本体と Visual C++ 再頒布可能パッケージをインストールし,次に setup.exe を用いて以下のコンポーネントを追加している。

VCTools:C++ デスクトップ開発ワークロード(--includeRecommendedにより、MSVC コンパイラ、C++ AddressSanitizer、vcpkg、CMake ツール、Windows 11 SDK 等の推奨コンポーネントが含まれる)VC.Llvm.Clang:Windows 向け C++ Clang コンパイラClangCL:clang-cl ツールセットを含むコンポーネントグループ(MSBuild から Clang を使用するために必要)VC.CMake.Project:Windows 向け C++ CMake ツールWindows11SDK.26100:Windows 11 SDK(ビルド 10.0.26100)

インストール完了の確認

winget list Microsoft.VisualStudio.2022.BuildTools上記以外の追加のコンポーネントが必要になった場合は Visual Studio Installer で個別にインストールできる。

Visual Studio の機能を必要とする場合は、追加インストールできる。

Python 3.12 のインストール

以下のいずれかの方法で Python 3.12 をインストールする。

方法1:winget によるインストール

Python がインストール済みの場合、この手順は不要である。管理者権限のコマンドプロンプトで以下を実行する。管理者権限のコマンドプロンプトを起動するには、Windows キーまたはスタートメニューから「cmd」と入力し、表示された「コマンドプロンプト」を右クリックして「管理者として実行」を選択する。

winget install -e --id Python.Python.3.12 --scope machine --silent --accept-source-agreements --accept-package-agreements --override "/quiet InstallAllUsers=1 PrependPath=1 AssociateFiles=1 InstallLauncherAllUsers=1"--scope machine を指定することで、システム全体(全ユーザー向け)にインストールされる。このオプションの実行には管理者権限が必要である。インストール完了後、コマンドプロンプトを再起動すると PATH が自動的に設定される。

方法2:インストーラーによるインストール

- Python 公式サイト(https://www.python.org/downloads/)にアクセスし、「Download Python 3.x.x」ボタンから Windows 用インストーラーをダウンロードする。

- ダウンロードしたインストーラーを実行する。

- 初期画面の下部に表示される「Add python.exe to PATH」に必ずチェックを入れてから「Customize installation」を選択する。このチェックを入れ忘れると、コマンドプロンプトから

pythonコマンドを実行できない。 - 「Install Python 3.xx for all users」にチェックを入れ、「Install」をクリックする。

インストールの確認

コマンドプロンプトで以下を実行する。

python --versionバージョン番号(例:Python 3.12.x)が表示されればインストール成功である。「'python' は、内部コマンドまたは外部コマンドとして認識されていません。」と表示される場合は、インストールが正常に完了していない。

Git のインストール

以下のコマンドを管理者権限のコマンドプロンプトで実行する

(手順:Windowsキーまたはスタートメニュー → cmd と入力 → 右クリック → 「管理者として実行」)。管理者権限は、wingetの--scope machineオプションでシステム全体にソフトウェアをインストールするために必要となる。

REM Git をシステム領域にインストール

winget install --scope machine --id Git.Git -e --silent --accept-source-agreements --accept-package-agreements

REM Git のパス設定

set "GIT_PATH=C:\Program Files\Git\cmd"

for /f "skip=2 tokens=2*" %a in ('reg query "HKLM\SYSTEM\CurrentControlSet\Control\Session Manager\Environment" /v Path') do set "SYSTEM_PATH=%b"

if exist "%GIT_PATH%" (

echo "%SYSTEM_PATH%" | find /i "%GIT_PATH%" >nul

if errorlevel 1 setx PATH "%GIT_PATH%;%SYSTEM_PATH%" /M >nul

)

【関連する外部ページ】

- Git の公式ページ: https://git-scm.com/

Build Tools for Visual Studio 2022,NVIDIA ドライバ,NVIDIA CUDA ツールキット 11.8,NVIDIA cuDNN 8.9.7 のインストール(Windows 上)

【サイト内の関連ページ】 NVIDIA グラフィックスボードを搭載しているパソコンの場合には, NVIDIA ドライバ, NVIDIA CUDA ツールキット, NVIDIA cuDNN のインストールを行う.

- Windows での Build Tools for Visual Studio 2022 のインストール: 別ページ »で説明

- Windows での NVIDIA ドライバ,NVIDIA CUDA ツールキット 11.8,NVIDIA cuDNN v8.9.7 のインストール手順: 別ページ »で説明

【関連する外部ページ】

- Build Tools for Visual Studio 2022 (ビルドツール for Visual Studio 2022)の公式ダウンロードページ: https://visualstudio.microsoft.com/ja/visual-cpp-build-tools/

- NVIDIA ドライバのダウンロードの公式ページ: https://www.nvidia.co.jp/Download/index.aspx?lang=jp

- NVIDIA CUDA ツールキットのアーカイブの公式ページ: https://developer.nvidia.com/cuda-toolkit-archive

- NVIDIA cuDNN のダウンロードの公式ページ: https://developer.nvidia.com/cudnn

PyTorch のインストール(Windows 上)

- 以下の手順を管理者権限のコマンドプロンプトで実行する

(手順:Windowsキーまたはスタートメニュー →

cmdと入力 → 右クリック → 「管理者として実行」)。 - PyTorch のページを確認

- 次のようなコマンドを実行(実行するコマンドは,PyTorch のページの表示されるコマンドを使う).

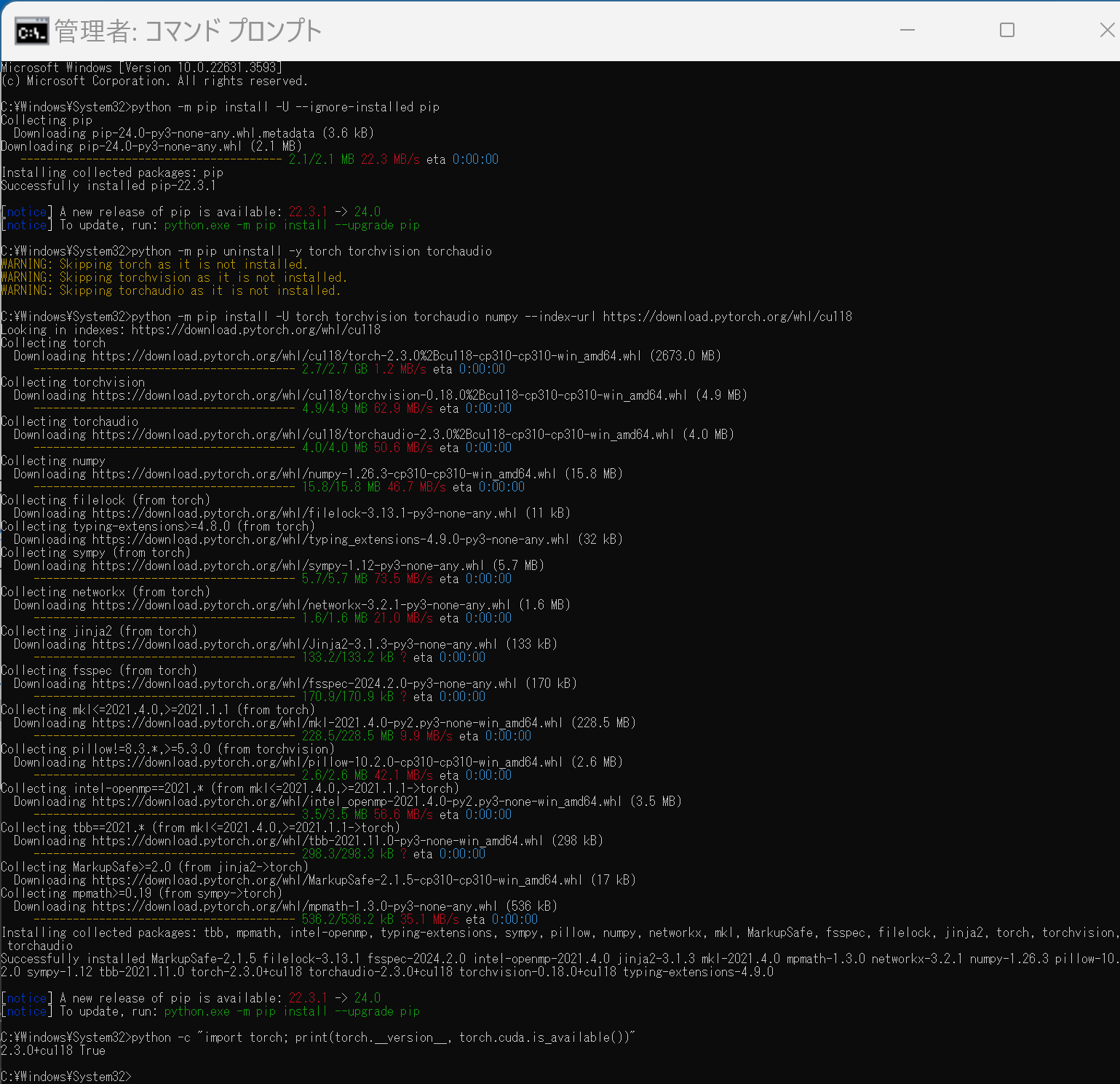

次のコマンドを実行することにより, PyTorch 2.3 (NVIDIA CUDA 11.8 用)がインストールされる. 但し,Anaconda3を使いたい場合には別手順になる.

事前に NVIDIA CUDA のバージョンを確認しておくこと(ここでは,NVIDIA CUDA ツールキット 11.8 が前もってインストール済みであるとする).

PyTorch で,GPU が動作している場合には,「torch.cuda.is_available()」により,True が表示される.

python -m pip install -U --ignore-installed pip python -m pip uninstall -y torch torchvision torchaudio torchtext xformers python -m pip install -U torch torchvision torchaudio numpy --index-url https://download.pytorch.org/whl/cu118 python -c "import torch; print(torch.__version__, torch.cuda.is_available())" Anaconda3を使いたい場合には, Anaconda プロンプト (Anaconda Prompt) を管理者として実行し, 次のコマンドを実行する. (PyTorch と NVIDIA CUDA との連携がうまくいかない可能性があるため,Anaconda3を使わないことも検討して欲しい).

Anaconda3を使いたい場合には, Anaconda プロンプト (Anaconda Prompt) を管理者として実行し, 次のコマンドを実行する. (PyTorch と NVIDIA CUDA との連携がうまくいかない可能性があるため,Anaconda3を使わないことも検討して欲しい).conda install -y pytorch torchvision torchaudio pytorch-cuda=11.8 cudnn -c pytorch -c nvidia py -c "import torch; print(torch.__version__, torch.cuda.is_available())"【サイト内の関連ページ】

【関連する外部ページ】

Grounding DINO のインストール(Windows 上)

- 以下の手順を管理者権限のコマンドプロンプトで実行する

(手順:Windowsキーまたはスタートメニュー →

cmdと入力 → 右クリック → 「管理者として実行」)。 - ダウンロードとインストール,訓練済みモデルのダウンロード

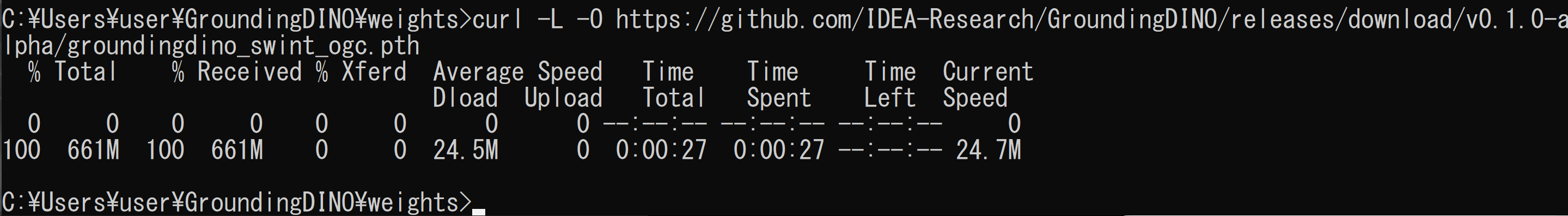

cd /d c:%HOMEPATH% rmdir /s /q GroundingDINO git clone --recursive https://github.com/IDEA-Research/GroundingDINO.git cd GroundingDINO python -m pip install -r requirements.txt python setup.py develop mkdir weights cd weights curl -L -O https://media.roboflow.com/notebooks/examples/dog.jpeg curl -L -O https://media.roboflow.com/notebooks/examples/dog-2.jpeg curl -L -O https://media.roboflow.com/notebooks/examples/dog-3.jpeg curl -L -O https://media.roboflow.com/notebooks/examples/dog-4.jpeg curl -L -O https://github.com/IDEA-Research/GroundingDINO/releases/download/v0.1.0-alpha/groundingdino_swint_ogc.pth - 終了の確認

エラーメッセージが出ていないこと.

Grounding DINO の動作確認(Windows 上)

Grounding DINO を用いて画像のアノテーションを行う.

- Windows で,コマンドプロンプトを実行

- エディタを起動

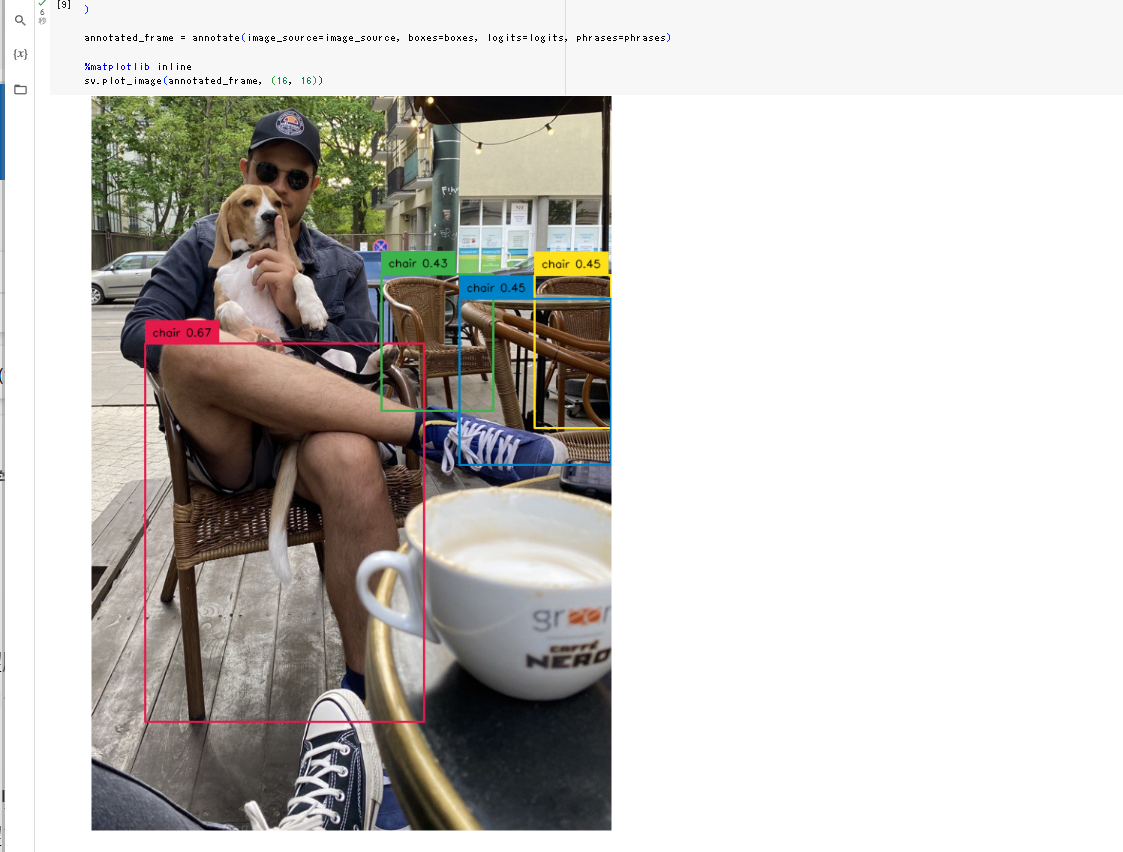

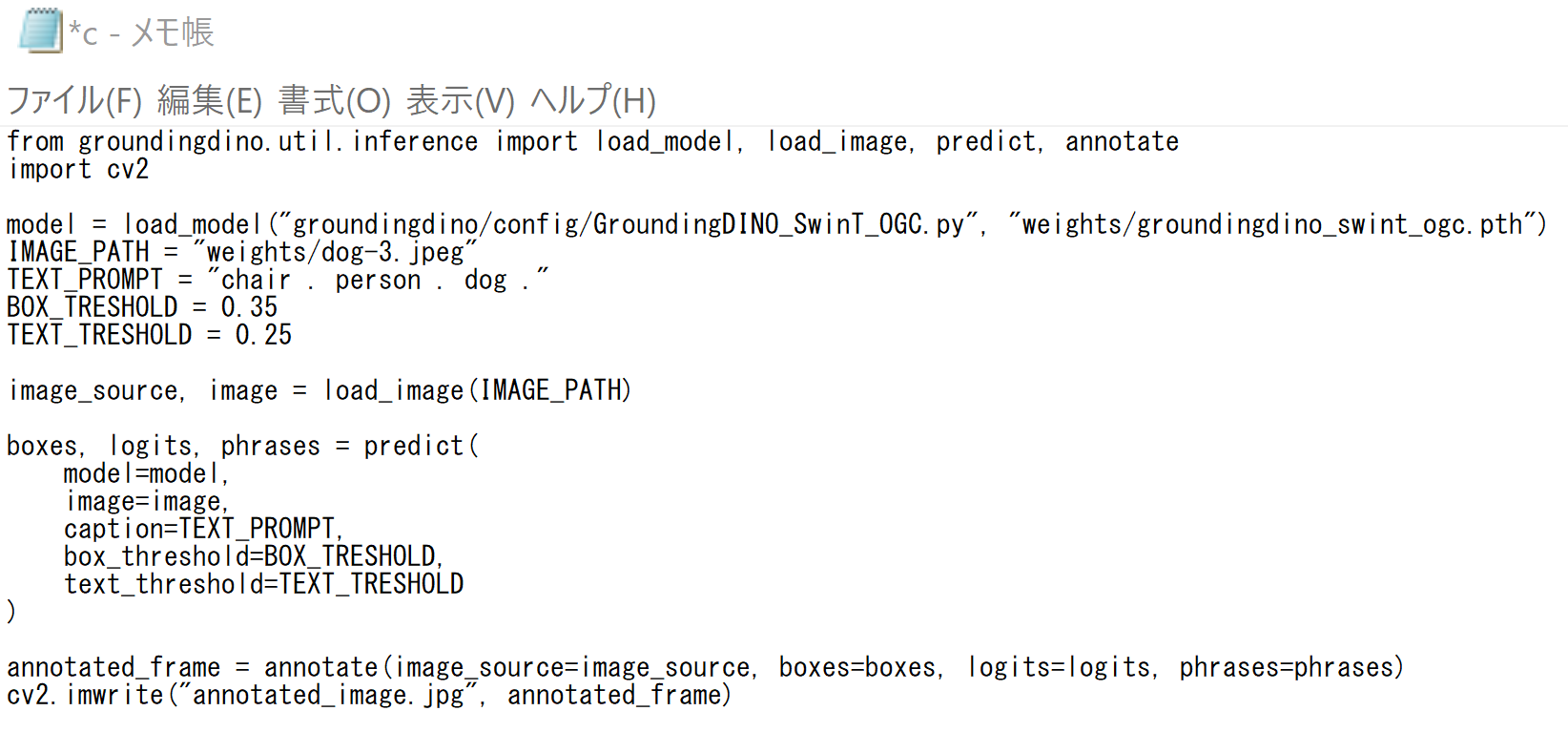

cd /d c:%HOMEPATH%\GroundingDINO notepad c.py - エディタで,次のプログラムを保存

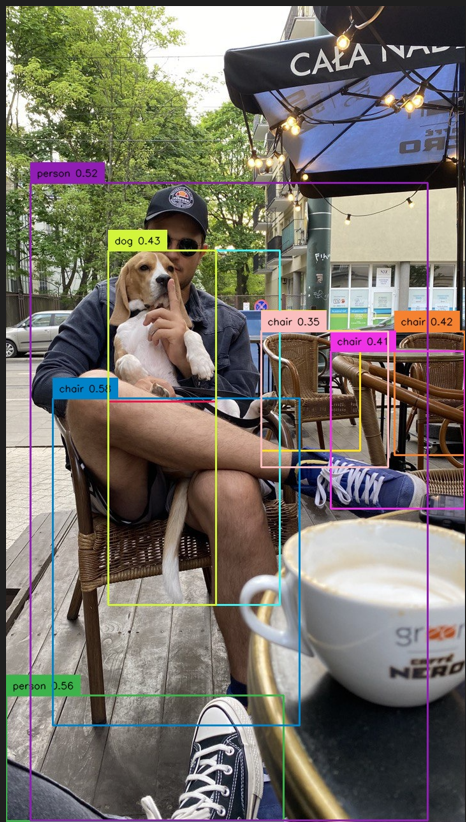

プロンプトとして,「TEXT_PROMPT = "chair . person . dog ."」のようにしている.

このプログラムは, 公式の GitHub のページ: https://github.com/idea-research/groundingdinoで公開されていたものを使用している.

from groundingdino.util.inference import load_model, load_image, predict, annotate import cv2 model = load_model("groundingdino/config/GroundingDINO_SwinT_OGC.py", "weights/groundingdino_swint_ogc.pth") IMAGE_PATH = "weights/dog-3.jpeg" TEXT_PROMPT = "chair . person . dog ." BOX_TRESHOLD = 0.35 TEXT_TRESHOLD = 0.25 image_source, image = load_image(IMAGE_PATH) boxes, logits, phrases = predict( model=model, image=image, caption=TEXT_PROMPT, box_threshold=BOX_TRESHOLD, text_threshold=TEXT_TRESHOLD ) annotated_frame = annotate(image_source=image_source, boxes=boxes, logits=logits, phrases=phrases) cv2.imwrite("annotated_image.jpg", annotated_frame)

- Python プログラムの実行

Python プログラムの実行

- Windows では python (Python ランチャーは py)

- Ubuntu では python3

【サイト内の関連ページ】 Python のまとめ: 別ページ »

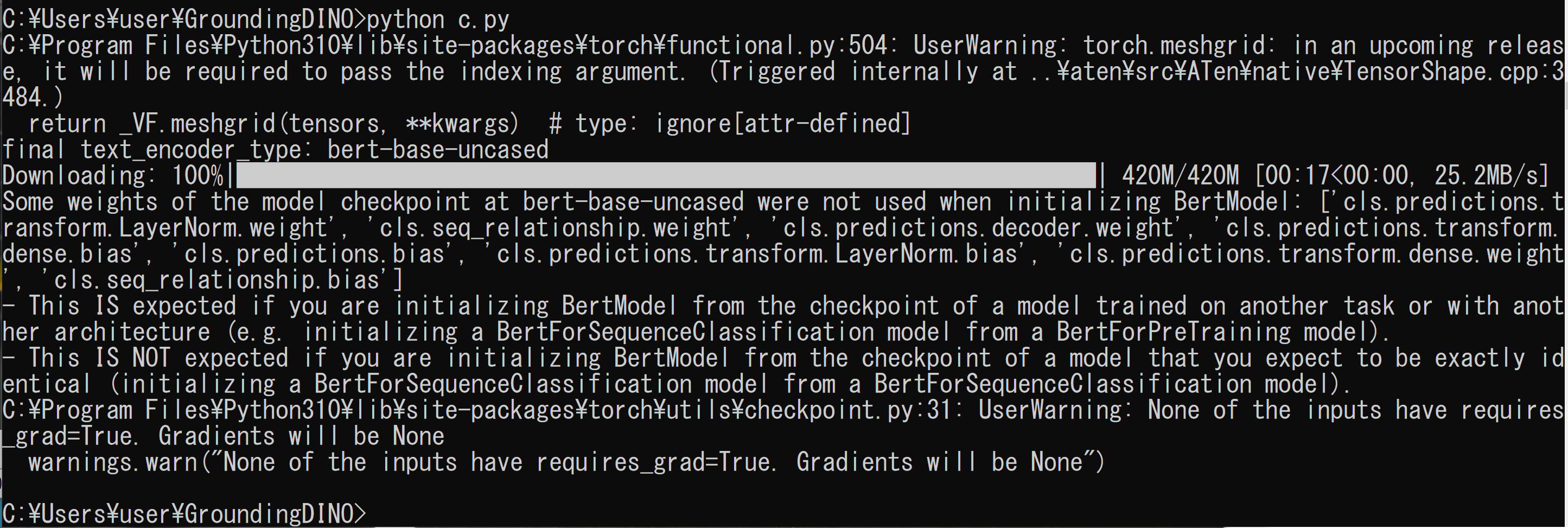

プログラムを c.pyのようなファイル名で保存したので, 「python c.py」のようなコマンドで行う.

python c.py

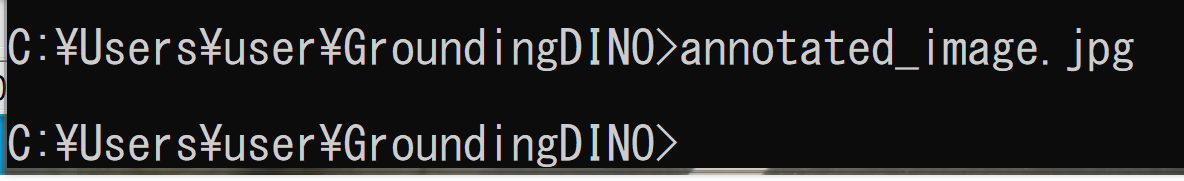

- 結果の確認

annotated_image.jpg

Grounding DINO を使う Python プログラムの実行(Windows 上)

手元の画像ファイルで実行してみる

実行時に画像ファイルを選択する.画像ファイルは複数選択可能である.

- Windows で,コマンドプロンプトを実行

- エディタを起動

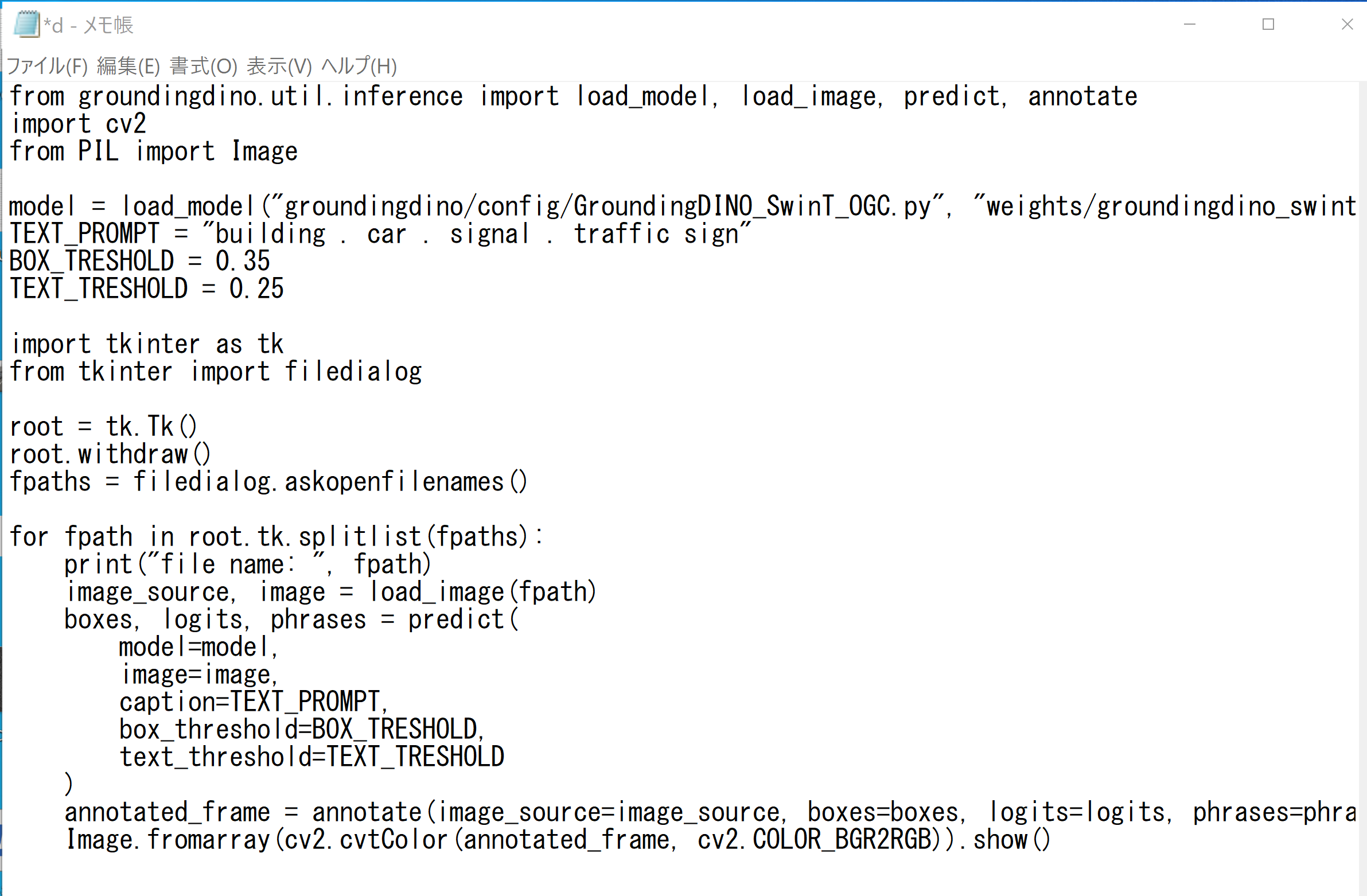

cd /d c:%HOMEPATH%\GroundingDINO notepad d.py - エディタで,次のプログラムを保存

このプログラムは, 公式の GitHub のページ: https://github.com/idea-research/groundingdinoで公開されていたものを変更して使用している.

from groundingdino.util.inference import load_model, load_image, predict, annotate import cv2 from PIL import Image model = load_model("groundingdino/config/GroundingDINO_SwinT_OGC.py", "weights/groundingdino_swint_ogc.pth") TEXT_PROMPT = "building . car . signal . traffic sign" BOX_TRESHOLD = 0.35 TEXT_TRESHOLD = 0.25 import tkinter as tk from tkinter import filedialog root = tk.Tk() root.withdraw() fpaths = filedialog.askopenfilenames() for fpath in root.tk.splitlist(fpaths): print("file name: ", fpath) image_source, image = load_image(fpath) boxes, logits, phrases = predict( model=model, image=image, caption=TEXT_PROMPT, box_threshold=BOX_TRESHOLD, text_threshold=TEXT_TRESHOLD ) annotated_frame = annotate(image_source=image_source, boxes=boxes, logits=logits, phrases=phrases) Image.fromarray(cv2.cvtColor(annotated_frame, cv2.COLOR_BGR2RGB)).show()

- Python プログラムの実行

Python プログラムの実行

- Windows では python (Python ランチャーは py)

- Ubuntu では python3

【サイト内の関連ページ】 Python のまとめ: 別ページ »

プログラムを d.pyのようなファイル名で保存したので, 「python d.py」のようなコマンドで行う.

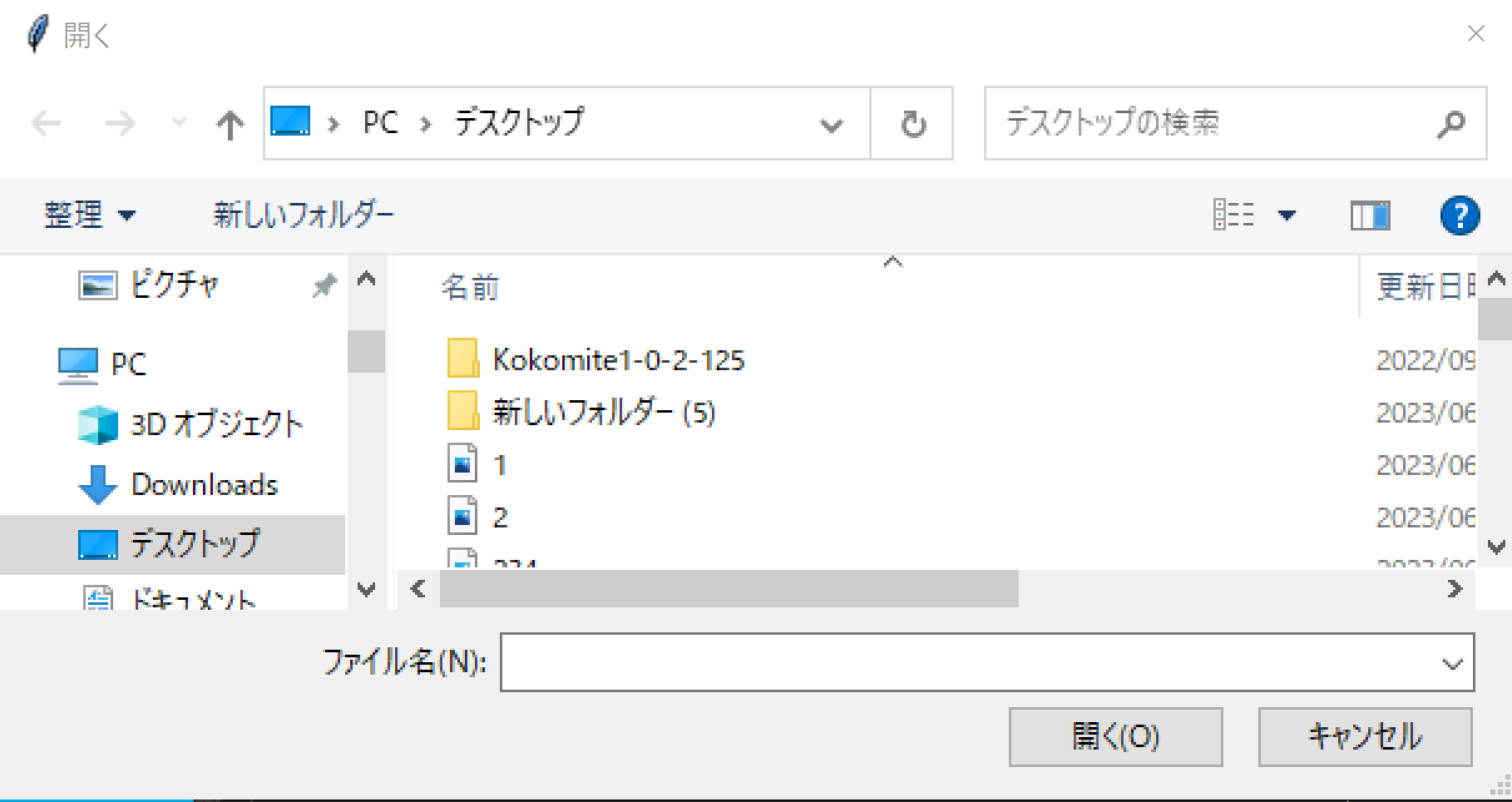

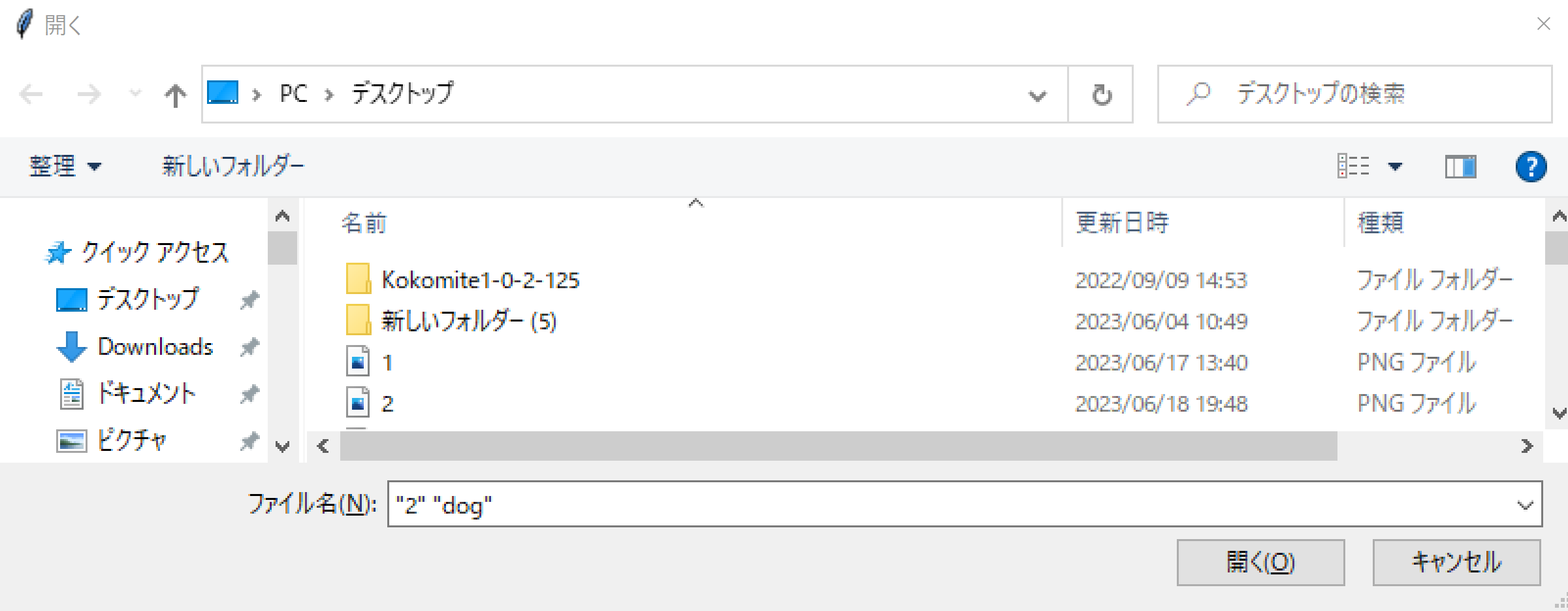

python d.pyファイル選択画面が出るので,画像ファイルを選択する.ファイルは複数選択可能である.

- 結果の確認

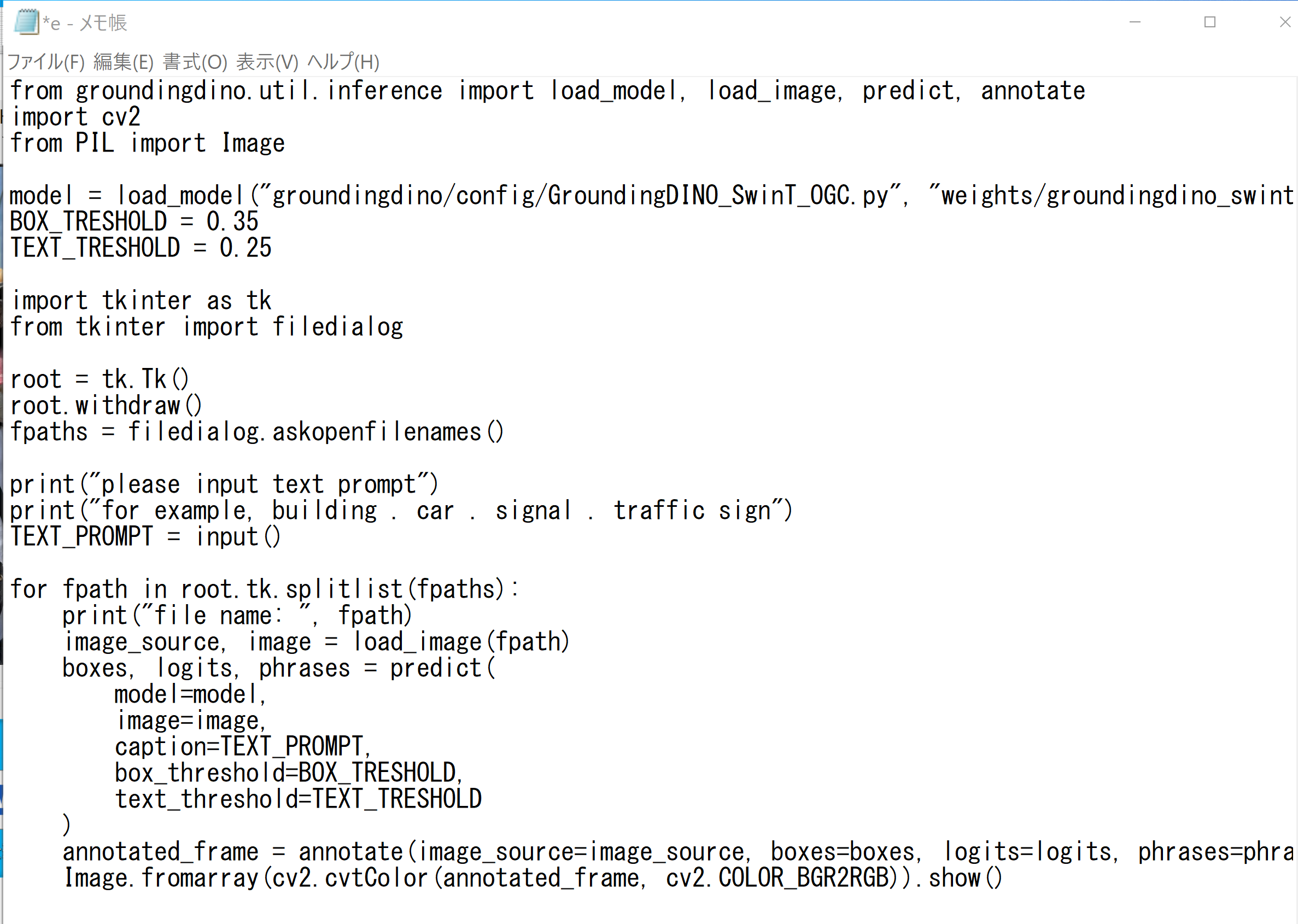

実行時にプロンプトも指定する.

実行時に画像ファイルを選択する.画像ファイルは複数選択可能である. プロンプトも指定できる. プロンプトは,「building . car . signal . traffic sign」のように入れること.英語のみ.

- Windows で,コマンドプロンプトを実行

- エディタを起動

cd /d c:%HOMEPATH%\GroundingDINO notepad e.py - エディタで,次のプログラムを保存

このプログラムは, 公式の GitHub のページ: https://github.com/idea-research/groundingdinoで公開されていたものを変更して使用している.

from groundingdino.util.inference import load_model, load_image, predict, annotate import cv2 from PIL import Image model = load_model("groundingdino/config/GroundingDINO_SwinT_OGC.py", "weights/groundingdino_swint_ogc.pth") BOX_TRESHOLD = 0.35 TEXT_TRESHOLD = 0.25 import tkinter as tk from tkinter import filedialog root = tk.Tk() root.withdraw() fpaths = filedialog.askopenfilenames() print("please input text prompt") print("for example, building . car . signal . traffic sign") TEXT_PROMPT = input() for fpath in root.tk.splitlist(fpaths): print("file name: ", fpath) image_source, image = load_image(fpath) boxes, logits, phrases = predict( model=model, image=image, caption=TEXT_PROMPT, box_threshold=BOX_TRESHOLD, text_threshold=TEXT_TRESHOLD ) annotated_frame = annotate(image_source=image_source, boxes=boxes, logits=logits, phrases=phrases) Image.fromarray(cv2.cvtColor(annotated_frame, cv2.COLOR_BGR2RGB)).show()

- Python プログラムの実行

Python プログラムの実行

- Windows では python (Python ランチャーは py)

- Ubuntu では python3

【サイト内の関連ページ】 Python のまとめ: 別ページ »

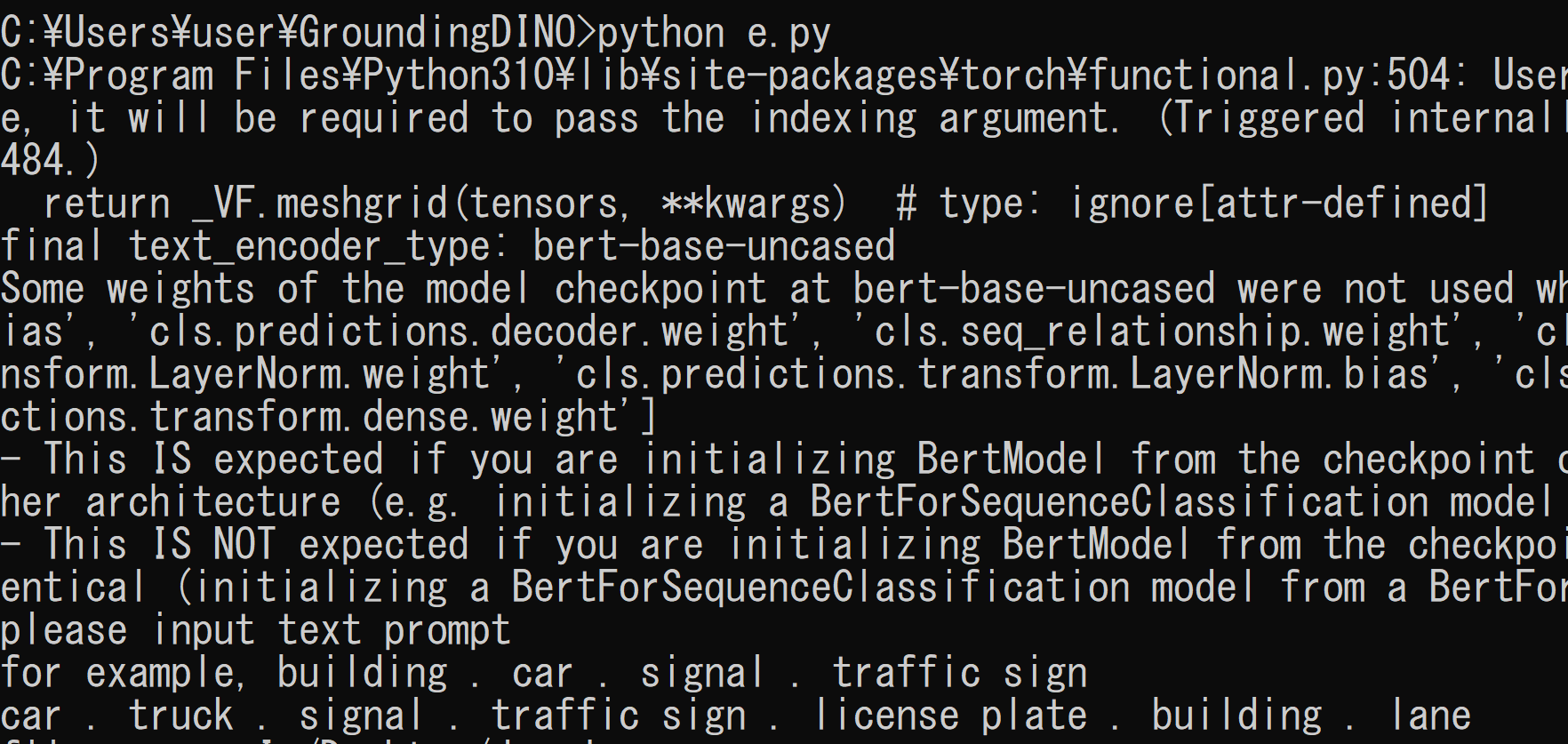

プログラムを e.pyのようなファイル名で保存したので, 「python e.py」のようなコマンドで行う.

python e.pyファイル選択画面が出るので,画像ファイルを選択する.ファイルは複数選択可能である.

テキストのプロンプトは,「building . car . signal . traffic sign」のように入れること.英語のみ.

- 結果の確認

- 以下の手順を管理者権限のコマンドプロンプトで実行する

(手順:Windowsキーまたはスタートメニュー →

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)