MMEditing のインストールと動作確認(超解像,画像のノイズ除去,イメージ・インペインティング,イメージ・マッティング)(PyTorch,Python を使用)(Windows 上)

- 文献

MMEditing Contributors, OpenMMLab Editing Estimation Toolbox and Benchmark, https://github.com/open-mmlab/mmediting, 2020.

- MMEditing の GitHub のページ: https://github.com/open-mmlab/mmediting

- MMEditing の公式ドキュメント: https://mmdetection.readthedocs.io

- MMEditing の image matting の公式チュートリアル: https://github.com/open-mmlab/mmediting/blob/master/demo/matting_tutorial.ipynb

- MMEditing の 画像のノイズ除去 (image restoration) の公式チュートリアル: https://github.com/open-mmlab/mmediting/blob/master/demo/restorer_basic_tutorial.ipynb

【目次】

前準備

Build Tools for Visual Studio 2022 のインストール(Windows 上)

Build Tools for Visual Studio は,Visual Studio の IDE を含まない C/C++ コンパイラ,ライブラリ,ビルドツール等のコマンドライン向け開発ツールセットである。

以下のコマンドを管理者権限のコマンドプロンプトで実行する

(手順:Windowsキーまたはスタートメニュー → cmd と入力 → 右クリック → 「管理者として実行」)。

REM VC++ ランタイム

winget install --scope machine --accept-source-agreements --accept-package-agreements --silent --id Microsoft.VCRedist.2015+.x64

REM Build Tools + Desktop development with C++(VCTools)+ 追加コンポーネント(一括)

winget install --id Microsoft.VisualStudio.2022.BuildTools --accept-source-agreements --accept-package-agreements ^

--override "--passive --wait --norestart --add Microsoft.VisualStudio.Workload.VCTools --includeRecommended --add Microsoft.VisualStudio.Component.VC.Llvm.Clang --add Microsoft.VisualStudio.ComponentGroup.ClangCL --add Microsoft.VisualStudio.Component.VC.CMake.Project --add Microsoft.VisualStudio.Component.Windows11SDK.26100"--add で追加されるコンポーネント

上記のコマンドでは,まず Build Tools 本体と Visual C++ 再頒布可能パッケージをインストールし,次に setup.exe を用いて以下のコンポーネントを追加している。

VCTools:C++ デスクトップ開発ワークロード(--includeRecommendedにより、MSVC コンパイラ、C++ AddressSanitizer、vcpkg、CMake ツール、Windows 11 SDK 等の推奨コンポーネントが含まれる)VC.Llvm.Clang:Windows 向け C++ Clang コンパイラClangCL:clang-cl ツールセットを含むコンポーネントグループ(MSBuild から Clang を使用するために必要)VC.CMake.Project:Windows 向け C++ CMake ツールWindows11SDK.26100:Windows 11 SDK(ビルド 10.0.26100)

インストール完了の確認

winget list Microsoft.VisualStudio.2022.BuildTools上記以外の追加のコンポーネントが必要になった場合は Visual Studio Installer で個別にインストールできる。

Visual Studio の機能を必要とする場合は、追加インストールできる。

Python 3.12 のインストール(Windows 上) [クリックして展開]

以下のいずれかの方法で Python 3.12 をインストールする。Python がインストール済みの場合、この手順は不要である。

方法1:winget によるインストール

管理者権限のコマンドプロンプトで以下を実行する。管理者権限のコマンドプロンプトを起動するには、Windows キーまたはスタートメニューから「cmd」と入力し、表示された「コマンドプロンプト」を右クリックして「管理者として実行」を選択する。

winget install -e --id Python.Python.3.12 --scope machine --silent --accept-source-agreements --accept-package-agreements --override "/quiet InstallAllUsers=1 PrependPath=1 AssociateFiles=1 InstallLauncherAllUsers=1"--scope machine を指定することで、システム全体(全ユーザー向け)にインストールされる。このオプションの実行には管理者権限が必要である。インストール完了後、コマンドプロンプトを再起動すると PATH が自動的に設定される。

方法2:インストーラーによるインストール

- Python 公式サイト(https://www.python.org/downloads/)にアクセスし、「Download Python 3.x.x」ボタンから Windows 用インストーラーをダウンロードする。

- ダウンロードしたインストーラーを実行する。

- 初期画面の下部に表示される「Add python.exe to PATH」に必ずチェックを入れてから「Customize installation」を選択する。このチェックを入れ忘れると、コマンドプロンプトから

pythonコマンドを実行できない。 - 「Install Python 3.xx for all users」にチェックを入れ、「Install」をクリックする。

インストールの確認

コマンドプロンプトで以下を実行する。

python --versionバージョン番号(例:Python 3.12.x)が表示されればインストール成功である。「'python' は、内部コマンドまたは外部コマンドとして認識されていません。」と表示される場合は、インストールが正常に完了していない。

Git のインストール

管理者権限のコマンドプロンプトで以下を実行する。管理者権限のコマンドプロンプトを起動するには、Windows キーまたはスタートメニューから「cmd」と入力し、表示された「コマンドプロンプト」を右クリックして「管理者として実行」を選択する。

REM Git をシステム領域にインストール

winget install --scope machine --id Git.Git -e --silent --accept-source-agreements --accept-package-agreements --force --custom "/NORESTART /NOCANCEL /COMPONENTS=""gitlfs"" /o:EditorOption=Notepad /o:PathOption=Cmd /o:CRLFOption=CRLFCommitAsIs /o:DefaultBranchOption=main /o:SSHOption=OpenSSH /o:UseCredentialManager=Enabled"

【関連する外部ページ】

- Git の公式ページ: https://git-scm.com/

Build Tools for Visual Studio 2022,NVIDIA ドライバ,NVIDIA CUDA ツールキット 11.8,NVIDIA cuDNN 8.9.7 のインストール(Windows 上)

【サイト内の関連ページ】 NVIDIA グラフィックスボードを搭載しているパソコンの場合には, NVIDIA ドライバ, NVIDIA CUDA ツールキット, NVIDIA cuDNN のインストールを行う.

- Windows での Build Tools for Visual Studio 2022 のインストール: 別ページ »で説明

- Windows での NVIDIA ドライバ,NVIDIA CUDA ツールキット 11.8,NVIDIA cuDNN v8.9.7 のインストール手順: 別ページ »で説明

【関連する外部ページ】

- Build Tools for Visual Studio 2022 (ビルドツール for Visual Studio 2022)の公式ダウンロードページ: https://visualstudio.microsoft.com/ja/visual-cpp-build-tools/

- NVIDIA ドライバのダウンロードの公式ページ: https://www.nvidia.co.jp/Download/index.aspx?lang=jp

- NVIDIA CUDA ツールキットのアーカイブの公式ページ: https://developer.nvidia.com/cuda-toolkit-archive

- NVIDIA cuDNN のダウンロードの公式ページ: https://developer.nvidia.com/cudnn

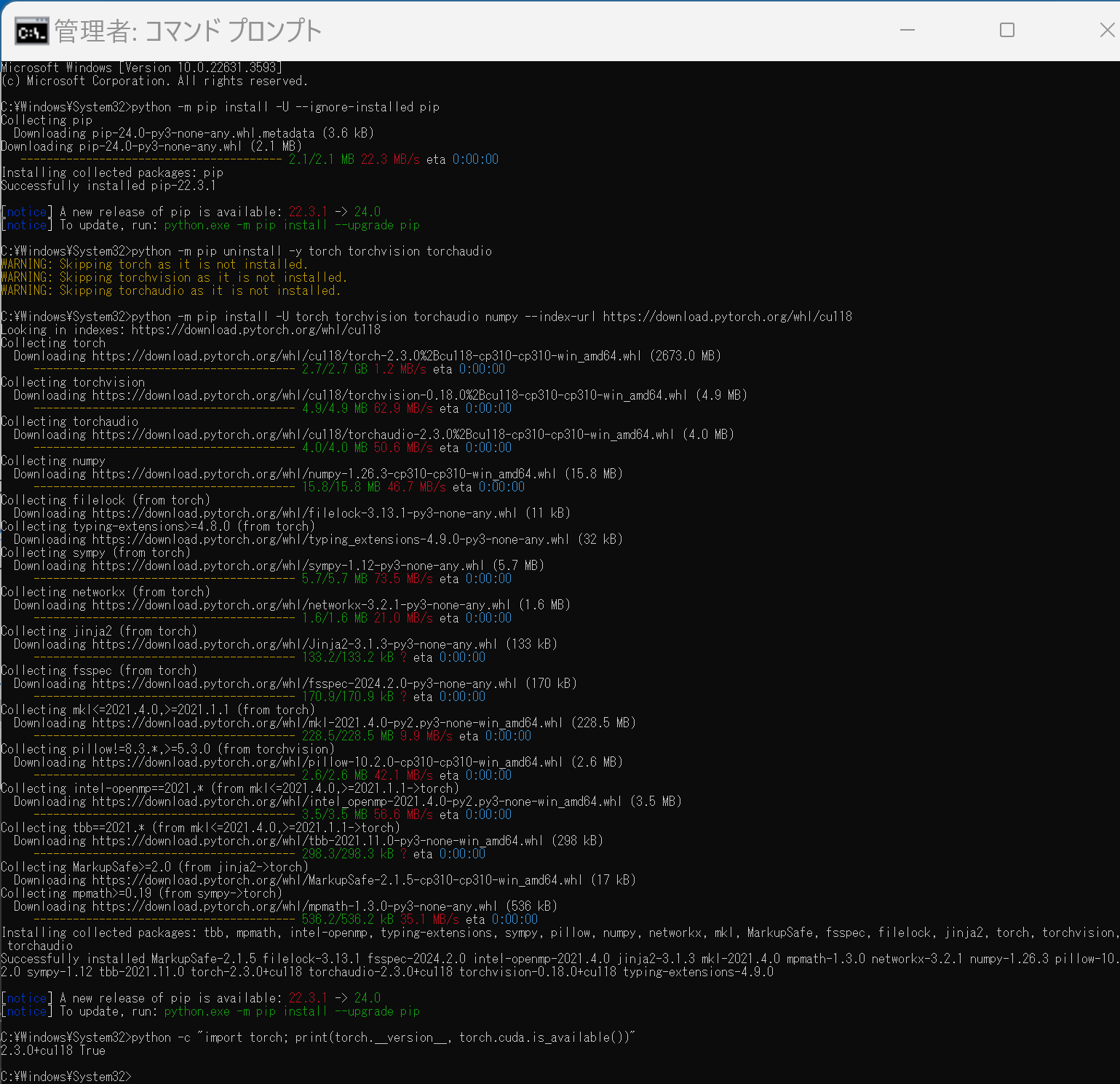

PyTorch のインストール(Windows 上)

- 以下の手順を管理者権限のコマンドプロンプトで実行する

(手順:Windowsキーまたはスタートメニュー →

cmdと入力 → 右クリック → 「管理者として実行」)。 - PyTorch のページを確認

- 次のようなコマンドを実行(実行するコマンドは,PyTorch のページの表示されるコマンドを使う).

次のコマンドを実行することにより, PyTorch 2.3 (NVIDIA CUDA 11.8 用)がインストールされる. 但し,Anaconda3を使いたい場合には別手順になる.

事前に NVIDIA CUDA のバージョンを確認しておくこと(ここでは,NVIDIA CUDA ツールキット 11.8 が前もってインストール済みであるとする).

PyTorch で,GPU が動作している場合には,「torch.cuda.is_available()」により,True が表示される.

python -m pip install -U --ignore-installed pip python -m pip uninstall -y torch torchvision torchaudio torchtext xformers python -m pip install -U torch torchvision torchaudio numpy --index-url https://download.pytorch.org/whl/cu118 python -c "import torch; print(torch.__version__, torch.cuda.is_available())" Anaconda3を使いたい場合には, Anaconda プロンプト (Anaconda Prompt) を管理者として実行し, 次のコマンドを実行する. (PyTorch と NVIDIA CUDA との連携がうまくいかない可能性があるため,Anaconda3を使わないことも検討して欲しい).

Anaconda3を使いたい場合には, Anaconda プロンプト (Anaconda Prompt) を管理者として実行し, 次のコマンドを実行する. (PyTorch と NVIDIA CUDA との連携がうまくいかない可能性があるため,Anaconda3を使わないことも検討して欲しい).conda install -y pytorch torchvision torchaudio pytorch-cuda=11.8 cudnn -c pytorch -c nvidia py -c "import torch; print(torch.__version__, torch.cuda.is_available())"【サイト内の関連ページ】

【関連する外部ページ】

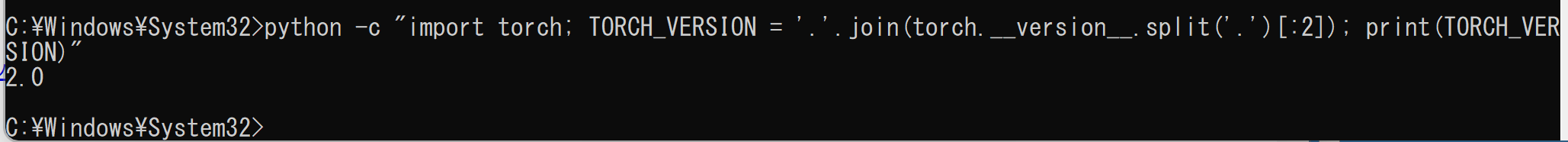

MMEditing のインストール(Windows 上)

インストールの方法は複数ある. ここでは, NVIDIA CUDA ツールキットを使うことも考え, インストールしやすい方法として,ソースコードからビルドしてインストールする方法を案内している.

- 以下の手順を管理者権限のコマンドプロンプトで実行する

(手順:Windowsキーまたはスタートメニュー →

cmdと入力 → 右クリック → 「管理者として実行」)。 - PyTorch がインストールできていることを確認するために,PyTorch のバージョンを表示

python -c "import torch; TORCH_VERSION = '.'.join(torch.__version__.split('.')[:2]); print(TORCH_VERSION)"

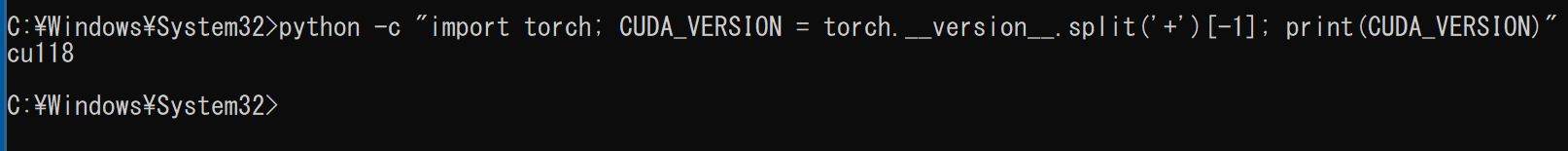

- PyTorch が NVIDIA CUDA ツールキットを認識できていることを確認するために,

PyTorch が認識しているNVIDIA CUDA ツールキット のバージョンを表示

このとき,実際には 11.8 をインストールしているのに,「cu117」のように古いバージョンが表示されることがある.このような場合は,気にせずに続行する.

python -c "import torch; CUDA_VERSION = torch.__version__.split('+')[-1]; print(CUDA_VERSION)"

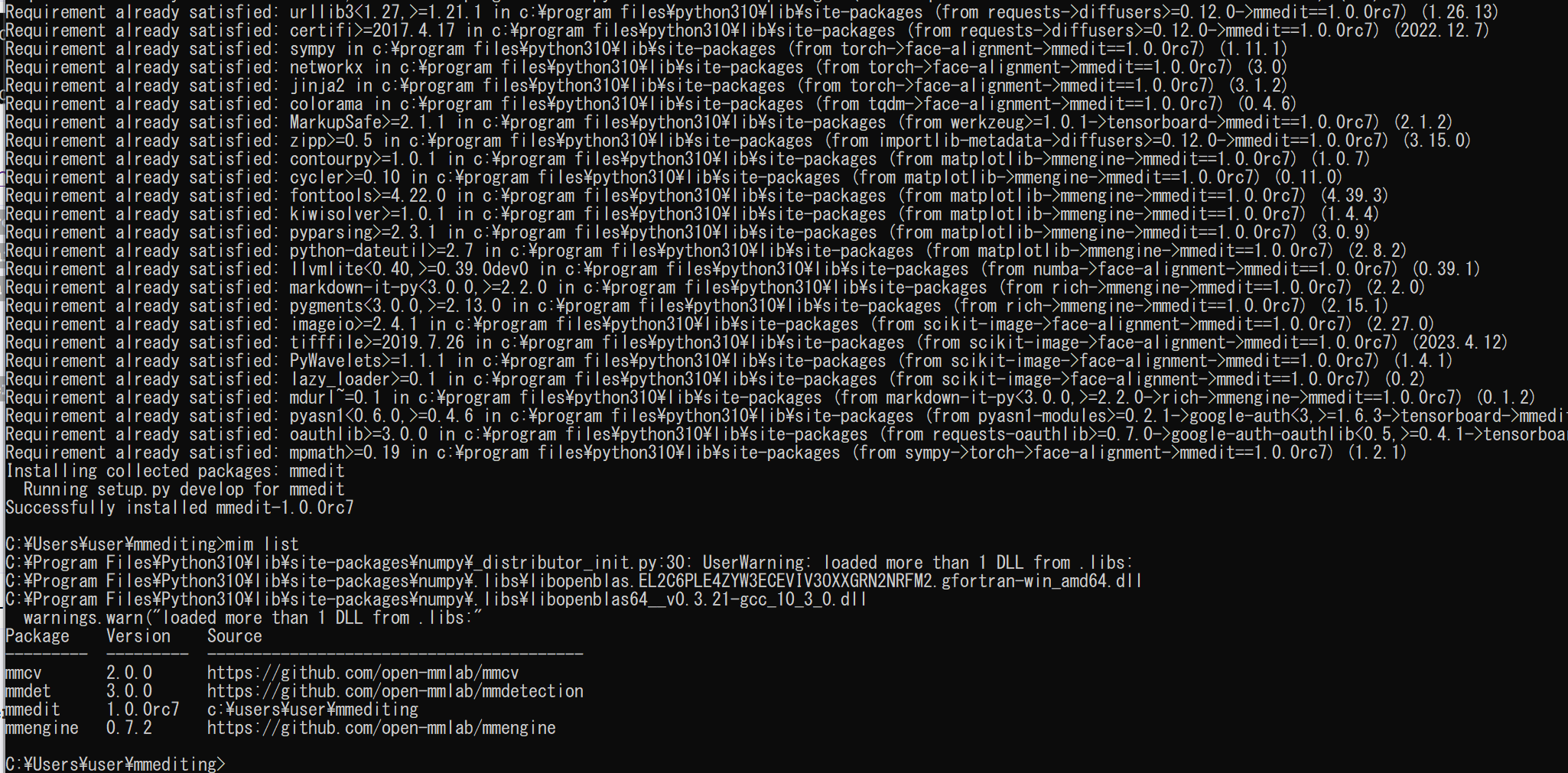

- MIM,MMPose のインストール

インストール手順は, https://mmcv.readthedocs.io/en/latest/get_started/installation.html に記載の手順による

python -m pip install -U --ignore-installed pip python -m pip uninstall -y openmim mmcv mmcv-full opencv-python opencv-python-headless python -m pip install -U openmim opencv-python cd /d c:%HOMEPATH% rmdir /s /q mmediting git clone https://github.com/open-mmlab/mmediting.git cd mmediting mim uninstall -y mmediting pip install -r requirements.txt mim install -e . mim list

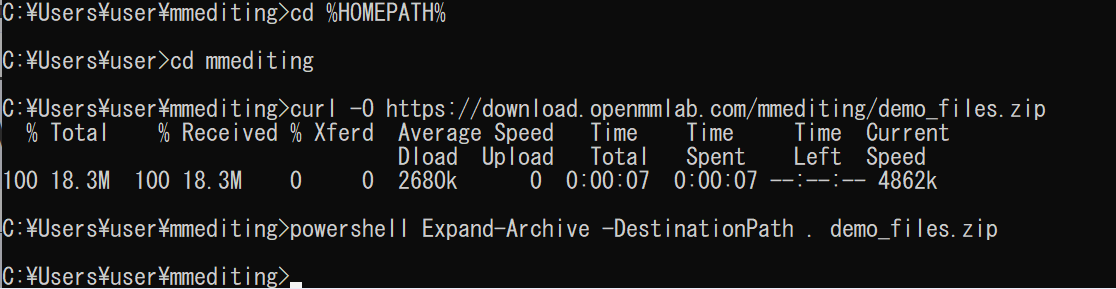

- MMEditing のデモファイルのダウンロード

cd /d c:%HOMEPATH% cd mmediting curl -O https://download.openmmlab.com/mmediting/demo_files.zip powershell -command "Expand-Archive -DestinationPath . -Path demo_files.zip"

MMEditing の動作確認(Windows 上)

超解像 (super resolution) の実行

- 次のコマンドを実行

SRCNN による画像の超解像 (super resolution) の実行

学習済みモデルを使用.

MMEditing の SRCNN の説明ページ: https://github.com/open-mmlab/mmediting/blob/master/configs/srcnn/README.md

コマンドの説明: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.md

cd /d c:%HOMEPATH% cd mmediting python demo/restoration_demo.py ./configs/srcnn/srcnn_x4k915_1xb16-1000k_div2k.py https://download.openmmlab.com/mmediting/restorers/srcnn/srcnn_x4k915_1x16_1000k_div2k_20200608-4186f232.pth ./demo_files/lq_images/bird.png ./outputs/bird_SRCNN.png python -c "import mmcv; mmcv.imshow('./demo_files/lq_images/bird.png')" python -c "import mmcv; mmcv.imshow('./outputs/bird_SRCNN.png')"(ここでは,2つの画像を同じ大きさで表示)

処理前

処理後

- ESRGAN による画像の超解像 (super resolution) の実行

学習済みモデルを使用.

MMEditing の ESRGAN の説明ページ: https://github.com/open-mmlab/mmediting/blob/master/configs/esrgan/README.md

コマンドの説明: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.md

cd /d c:%HOMEPATH% cd mmediting python demo/restoration_demo.py ./configs/esrgan/esrgan_x4c64b23g32_1xb16-400k_div2k.py https://download.openmmlab.com/mmediting/restorers/esrgan/esrgan_x4c64b23g32_1x16_400k_div2k_20200508-f8ccaf3b.pth ./demo_files/lq_images/bird.png ./outputs/bird_ESRGAN.png python -c "import mmcv; mmcv.imshow('./demo_files/lq_images/bird.png')" python -c "import mmcv; mmcv.imshow('./outputs/bird_ESRGAN.png')"(ここでは,2つの画像を同じ大きさで表示)

処理前

処理後

- EDVR による連続画像の超解像 (super resolution) の実行

学習済みモデルを使用.

MMEditing の EDVR の説明ページ: https://github.com/open-mmlab/mmediting/blob/master/configs/edvr/README.md

コマンドの説明: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.md

python demo/restoration_video_demo.py ./configs/edvr/edvrm_wotsa_8xb4-600k_reds.py https://download.openmmlab.com/mmediting/restorers/edvr/edvrm_wotsa_x4_8x4_600k_reds_20200522-0570e567.pth demo_files/lq_sequences/city/ ./outputs/city_EDVR --window_size=5 python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000000.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_EDVR/00000000.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000001.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_EDVR/00000001.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000002.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_EDVR/00000002.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000003.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_EDVR/00000003.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000004.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_EDVR/00000004.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000005.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_EDVR/00000005.png')"処理前

処理後

- BasicVSR (Recurrent framework) の実行

学習済みモデルを使用.

MMEditing の EDVR の説明ページ: https://github.com/open-mmlab/mmediting/blob/master/configs/edvr/README.md

コマンドの説明: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.md

python demo/restoration_video_demo.py ./configs/basicvsr/basicvsr_2xb4_reds4.py https://download.openmmlab.com/mmediting/restorers/basicvsr/basicvsr_reds4_20120409-0e599677.pth demo_files/lq_sequences/city/ ./outputs/city_BasicVSR python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000000.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_BasicVSR/00000000.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000001.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_BasicVSR/00000001.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000002.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_BasicVSR/00000002.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000003.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_BasicVSR/00000003.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000004.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_BasicVSR/00000004.png')" python -c "import mmcv; mmcv.imshow('./demo_files/lq_sequences/city/00000005.png')" python -c "import mmcv; mmcv.imshow('./outputs/city_BasicVSR/00000005.png')"処理前

処理後

- image inpainting の実行

- DeepFillv2 による image impainting の実行

学習済みモデルを使用.

MMEditing の DeepFillv2 の説明ページ: https://github.com/open-mmlab/mmediting/blob/master/configs/inpainting/deepfillv2/README.md

コマンドの説明: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.md

python demo/inpainting_demo.py configs/deepfillv2/deepfillv2_8xb2_celeba-256x256.py https://download.openmmlab.com/mmediting/inpainting/deepfillv2/deepfillv2_256x256_8x2_celeba_20200619-c96e5f12.pth tests/data/inpainting/celeba_test.png tests/data/inpainting/bbox_mask.png outputs/inpainting_celeba.png python -c "import mmcv; mmcv.imshow('./tests/data/inpainting/celeba_test.png')" python -c "import mmcv; mmcv.imshow('./outputs/inpainting_celeba.png')"処理前

処理後

- Global&Local による image impainting の実行

学習済みモデルを使用.

MMEditing の Global&Local の説明ページ: https://github.com/open-mmlab/mmediting/blob/master/configs/inpainting/global_local/README.md

コマンドの説明: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.md

python demo/inpainting_demo.py configs/inpainting/global_local/gl_256x256_8x12_celeba.py https://download.openmmlab.com/mmediting/inpainting/global_local/gl_256x256_8x12_celeba_20200619-5af0493f.pth tests/data/image/celeba_test.png tests/data/image/bbox_mask.png tests/data/pred/inpainting_celeba.png python -c "import mmcv; mmcv.imshow('./tests/data/image/celeba_test.png')" python -c "import mmcv; mmcv.imshow('./tests/data/pred/inpainting_celeba.png')"

- DeepFillv2 による image impainting の実行

- image matting の実行

- GCA による image matting の実行

学習済みモデルを使用.

MMEditing の GCA の説明ページ: https://github.com/open-mmlab/mmediting/blob/master/configs/mattors/gca/README.md

コマンドの説明: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.md

python demo/matting_demo.py configs/mattors/gca/gca_r34_4x10_200k_comp1k.py https://download.openmmlab.com/mmediting/mattors/gca/gca_r34_4x10_200k_comp1k_SAD-34.77_20200604_213848-4369bea0.pth tests/data/merged/GT05.jpg tests/data/trimap/GT05.png tests/data/pred/GT05.png python -c "import mmcv; mmcv.imshow('./tests/data/merged/GT05.jpg')" python -c "import mmcv; mmcv.imshow('./tests/data/trimap/GT05.png')" python -c "import mmcv; mmcv.imshow('./tests/data/pred/GT05.png')" - IndexNet による image matting の実行

学習済みモデルを使用.

MMEditing の IndexNet の説明ページ: https://github.com/open-mmlab/mmediting/blob/master/configs/mattors/indexnet/README.md

コマンドの説明: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.md

python demo/matting_demo.py configs/mattors/indexnet/indexnet_mobv2_1x16_78k_comp1k.py https://download.openmmlab.com/mmediting/mattors/indexnet/indexnet_mobv2_1x16_78k_comp1k_SAD-45.6_20200618_173817-26dd258d.pth tests/data/merged/GT05.jpg tests/data/trimap/GT05.png tests/data/pred/GT05.png python -c "import mmcv; mmcv.imshow('./tests/data/merged/GT05.jpg')" python -c "import mmcv; mmcv.imshow('./tests/data/trimap/GT05.png')" python -c "import mmcv; mmcv.imshow('./tests/data/pred/GT05.png')" - DIM による image matting の実行

学習済みモデルを使用.

MMEditing の DIM の説明ページ: https://github.com/open-mmlab/mmediting/blob/master/configs/mattors/dim/README.md

コマンドの説明: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.md

python demo/matting_demo.py configs/mattors/dim/dim_stage3_v16_pln_1x1_1000k_comp1k.py https://download.openmmlab.com/mmediting/mattors/dim/dim_stage3_v16_pln_1x1_1000k_comp1k_SAD-50.6_20200609_111851-647f24b6.pth tests/data/merged/GT05.jpg tests/data/trimap/GT05.png tests/data/pred/GT05.png python -c "import mmcv; mmcv.imshow('./tests/data/merged/GT05.jpg')" python -c "import mmcv; mmcv.imshow('./tests/data/trimap/GT05.png')" python -c "import mmcv; mmcv.imshow('./tests/data/pred/GT05.png')"

- GCA による image matting の実行

demos URL: https://github.com/open-mmlab/mmediting/blob/master/docs/en/getting_started.mdpython demo/generation_demo.py configs/example_config.py work_dirs/example_exp/example_model_20200202.pth demo/demo.jpg demo/demo_out.jpg

python demo/generation_demo.py configs/example_config.py work_dirs/example_exp/example_model_20200202.pth demo/demo.jpg demo/demo_out.jpg --unpaired_path demo/demo_unpaired.jpg

- 以下の手順を管理者権限のコマンドプロンプトで実行する

(手順:Windowsキーまたはスタートメニュー →

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)