OpenCV でビデオカメラ画像の表示,ファイル書き出し,濃淡画像処理(Python を使用)

1. エグゼクティブサマリー

本記事では,OpenCV と Python を用いて,カメラ映像のリアルタイム表示,リサイズ表示,濃淡画像変換,動画ファイル書き出し,ヒストグラム平坦化,2値化,輪郭抽出を行う.動画ファイルを入力とした OTSU 2値化・輪郭抽出・画素値統計の処理も扱う.各プログラムの説明は第4章,ソースコードは第5章に掲載している.

- 前準備(必要ソフトウェアの入手)

- カメラ画像の表示

- 表示サイズを変える

- カラー画像から濃淡画像への変換

- 動画ファイルの書き出し

- ヒストグラム平坦化 (histogram equalization)

- 2値化

- 輪郭抽出

【関連する外部ページ】

- OpenCV の公式ページ: https://opencv.org

- GitHub の OpenCV のページ: https://github.com/opencv/opencv/releases

【サイト内の関連ページ】

- OpenCV について [PDF] , [パワーポイント]

- OpenCVとPythonを活用した画像・ビデオ処理プログラム: 別ページ »

2. 前準備(必要ソフトウェアの入手)

ここでは、最低限の事前準備について説明する。機械学習や深層学習を行う場合は、NVIDIA CUDA、Visual Studio、Cursorなどを追加でインストールすると便利である。これらについては別ページ https://www.kkaneko.jp/cc/dev/aiassist.htmlで詳しく解説しているので、必要に応じて参照してください。

Python 3.12 のインストール(Windows 上) [クリックして展開]

以下のいずれかの方法で Python 3.12 をインストールする。Python がインストール済みの場合、この手順は不要である。

方法1:winget によるインストール

管理者権限のコマンドプロンプトで以下を実行する。管理者権限のコマンドプロンプトを起動するには、Windows キーまたはスタートメニューから「cmd」と入力し、表示された「コマンドプロンプト」を右クリックして「管理者として実行」を選択する。

winget install --scope machine --id Python.Python.3.12 -e --silent --disable-interactivity --force --accept-source-agreements --accept-package-agreements --override "/quiet InstallAllUsers=1 PrependPath=1 Include_pip=1 Include_test=0 Include_launcher=1 InstallLauncherAllUsers=1"--scope machine を指定することで、システム全体(全ユーザー向け)にインストールされる。このオプションの実行には管理者権限が必要である。インストール完了後、コマンドプロンプトを再起動すると PATH が自動的に設定される。

方法2:インストーラーによるインストール

- Python 公式サイト(https://www.python.org/downloads/)にアクセスし、「Download Python 3.x.x」ボタンから Windows 用インストーラーをダウンロードする。

- ダウンロードしたインストーラーを実行する。

- 初期画面の下部に表示される「Add python.exe to PATH」に必ずチェックを入れてから「Customize installation」を選択する。このチェックを入れ忘れると、コマンドプロンプトから

pythonコマンドを実行できない。 - 「Install Python 3.xx for all users」にチェックを入れ、「Install」をクリックする。

インストールの確認

コマンドプロンプトで以下を実行する。

python --versionバージョン番号(例:Python 3.12.x)が表示されればインストール成功である。「'python' は、内部コマンドまたは外部コマンドとして認識されていません。」と表示される場合は、インストールが正常に完了していない。

AIエディタ Windsurf のインストール(Windows 上) [クリックして展開]

Pythonプログラムの編集・実行には、AIエディタの利用を推奨する。ここでは、Windsurfのインストールを説明する。Windsurf がインストール済みの場合、この手順は不要である。

管理者権限のコマンドプロンプトで以下を実行する。管理者権限のコマンドプロンプトを起動するには、Windows キーまたはスタートメニューから「cmd」と入力し、表示された「コマンドプロンプト」を右クリックして「管理者として実行」を選択する。

winget install --scope machine --id Codeium.Windsurf -e --silent --disable-interactivity --force --accept-source-agreements --accept-package-agreements --custom "/SP- /SUPPRESSMSGBOXES /NORESTART /CLOSEAPPLICATIONS /DIR=""C:\Program Files\Windsurf"" /MERGETASKS=!runcode,addtopath,associatewithfiles,!desktopicon"

powershell -Command "$env:Path=[System.Environment]::GetEnvironmentVariable('Path','Machine')+';'+[System.Environment]::GetEnvironmentVariable('Path','User'); windsurf --install-extension MS-CEINTL.vscode-language-pack-ja --force; windsurf --install-extension ms-python.python --force; windsurf --install-extension Codeium.windsurfPyright --force"--scope machine を指定することで、システム全体(全ユーザー向け)にインストールされる。このオプションの実行には管理者権限が必要である。インストール完了後、コマンドプロンプトを再起動すると PATH が自動的に設定される。

【関連する外部ページ】

Windsurf の公式ページ: https://windsurf.com/

Python の OpenCV ライブラリのインストール [クリックして展開]

Python で OpenCV を使用するためのライブラリである.

管理者権限のコマンドプロンプトで以下を実行する。管理者権限のコマンドプロンプトを起動するには、Windows キーまたはスタートメニューから「cmd」と入力し、表示された「コマンドプロンプト」を右クリックして「管理者として実行」を選択する。

python -m pip install -U opencv-python opencv-contrib-python

3. 実行のための準備とその確認手順(Windows 前提)

3.1 プログラムファイルの準備

第5章のソースコードをテキストエディタ(メモ帳,Windsurf 等)に貼り付け,それぞれ以下のファイル名で保存する(文字コード:UTF-8).

| セクション | ファイル名 |

|---|---|

| カメラ画像の表示 | camera_display.py |

| 表示サイズを変える | camera_resize.py |

| カラー画像から濃淡画像への変換 | camera_grayscale.py |

| 動画ファイルの書き出し | camera_record.py |

| ヒストグラム平坦化 | camera_equalize.py |

| 2値化 | camera_binary.py |

| 輪郭抽出 | camera_contour.py |

| OTSU の方法による2値化(動画ファイル) | video_otsu.py |

| 輪郭抽出(動画ファイル) | video_contour.py |

| OTSU 2値化後の数え上げと画素値の平均 | video_otsu_stats.py |

動画ファイルを使用するプログラム(video_otsu.py,video_contour.py,video_otsu_stats.py)では,事前に動画ファイルの準備が必要である.詳細は第4章の「動画ファイルを使って試す」を参照すること.

3.2 実行コマンド

コマンドプロンプトでファイルの保存先ディレクトリに移動し,以下のように実行する.

python camera_display.py他のプログラムも同様に,ファイル名を差し替えて実行する.

3.3 動作確認チェックリスト

| 確認項目 | 期待される結果 |

|---|---|

| camera_display.py を実行 | 「カメラ映像」ウィンドウにリアルタイム映像とFPS値が表示される |

| camera_resize.py を実行 | 640ピクセル幅にリサイズされた映像が表示される |

| camera_grayscale.py を実行 | 「カラーカメラ映像」と「濃淡カメラ映像」の2つのウィンドウが表示される |

| camera_record.py を実行後に終了 | カレントディレクトリに output_YYYYMMDD_HHMMSS.avi が生成される |

| camera_equalize.py を実行 | 元画像と平坦化後の画像が横に並んで表示される |

| camera_binary.py を実行 | 元画像と2値化後の画像が横に並んで表示される |

| camera_contour.py を実行 | 元画像と輪郭画像が横に並んで表示され,輪郭数が描画される |

| 画面の中をクリックしてから「q」キーを押す | プログラムが正常に終了し,ウィンドウが閉じる |

| video_otsu.py を実行 | 動画の元画像と2値化画像のウィンドウが表示される |

| video_otsu_stats.py を実行 | フレーム番号・白色画素数・L/a/b成分の平均がコンソールに出力され,result.csv に書き出される |

4. 概要・使い方・実行上の注意

各プログラムのソースコードは第5章に掲載している.

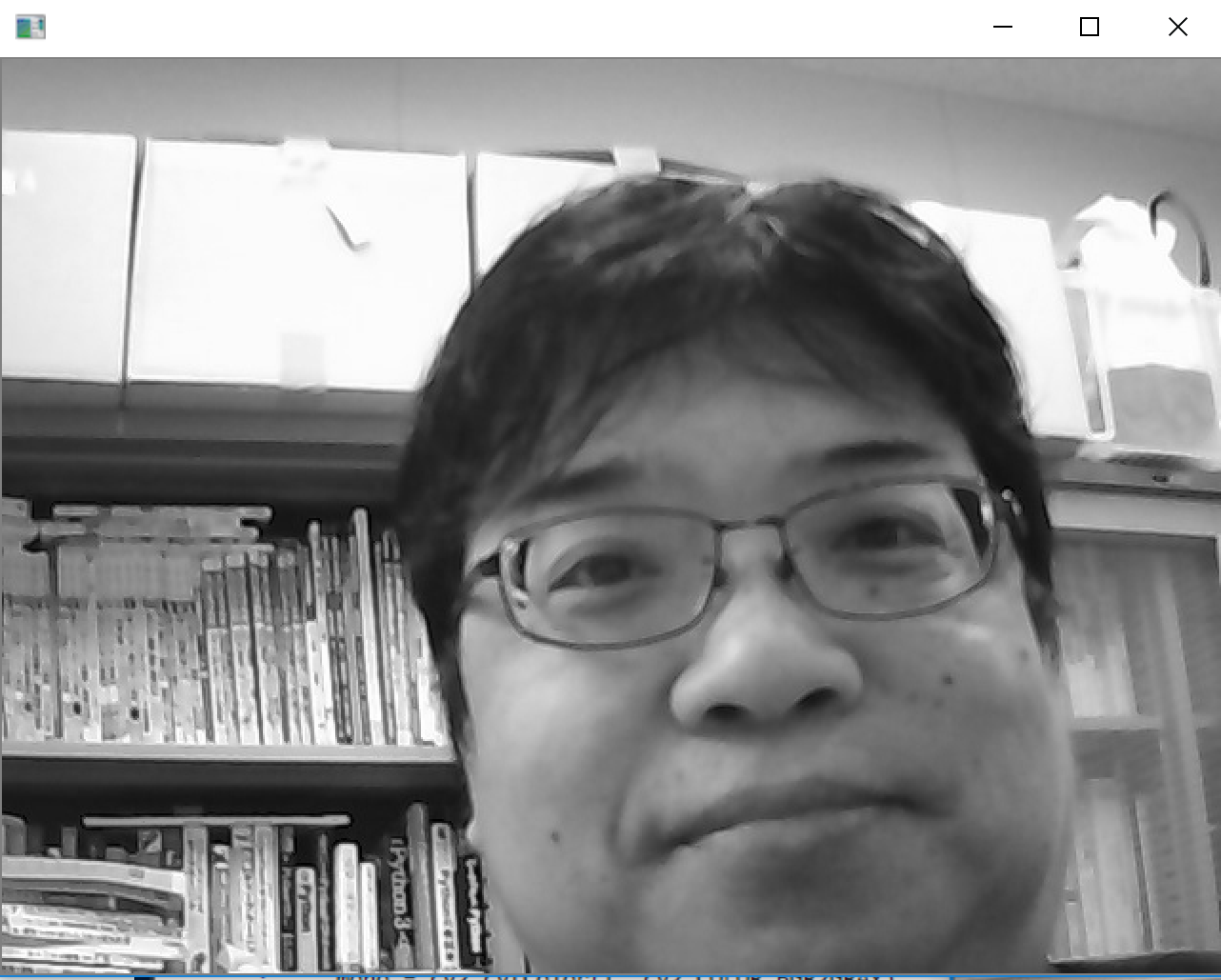

4.1 カメラ画像の表示

USB接続できるビデオカメラを準備し,パソコンに接続しておく.

止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

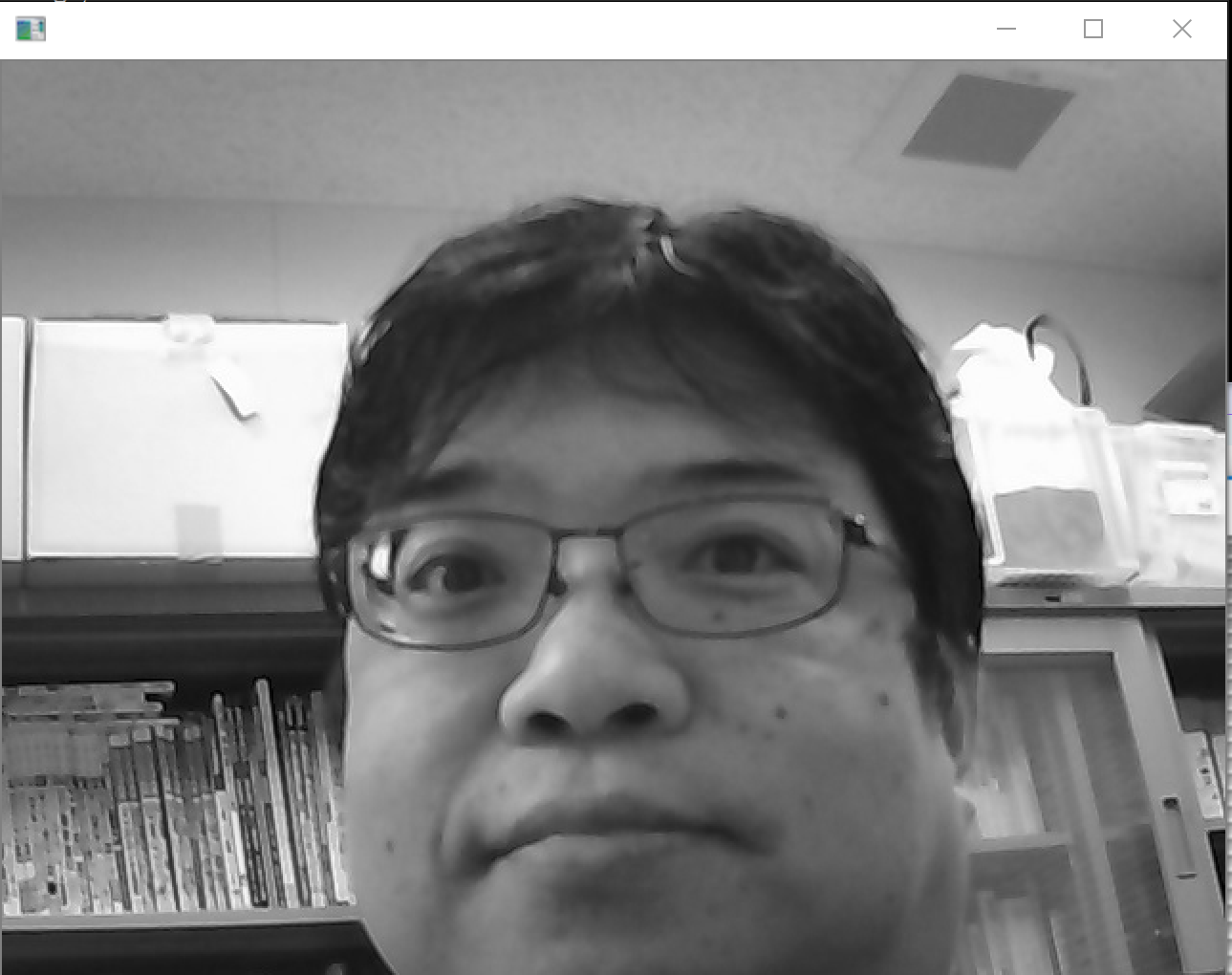

4.2 表示サイズを変える

ビデオカメラを準備し,パソコンに接続しておく.

【プログラムの機能】

カメラからリアルタイムで映像を取得し,指定した幅(640ピクセル)にリサイズして表示する.アスペクト比(縦横比)を保持したままリサイズする.'q'キーで終了する.

【プログラムの説明】

OpenCVを使用したリアルタイムカメラ映像のリサイズと表示

- opencv-python の使用

opencv-python は,OpenCV を Python から利用するためのライブラリである.

- リサイズを行う resize_frame 関数

resize_frame関数は,入力画像を指定した幅にリサイズする.アスペクト比を保持するように高さを計算する.

- メインループ

while True ループ内で以下の処理を繰り返す.

- カメラから1フレーム読み取り

- フレームをリサイズ

- リサイズしたフレームを表示

- キー入力のチェック('q'キーで終了)

- リソースの解放

プログラム終了時に,v.release()でカメラを解放し,cv2.destroyAllWindows()でウィンドウを閉じる.

- カスタマイズ

resize_width変数でリサイズ幅を調整できる.cv2.VideoCapture(0)の0を変更すると,異なるカメラを選択できる.

【プログラムの実行法】

実行するとカメラ映像が表示され,'q'キーで終了できる. カメラへのアクセス権限が必要で,既定(デフォルト)ではインデックス0のカメラを使用する.リサイズ幅はプログラムを書き換えて調整する.強制終了時('q'キーで終了しなかった場合)にはカメラが解放されない場合がある.

止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

4.3 カラー画像から濃淡画像への変換

USB接続できるビデオカメラを準備し,パソコンに接続しておく.

* 止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

4.4 動画ファイルの書き出し

USB接続できるビデオカメラを準備し,パソコンに接続しておく.

* 止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

終了すると,動画ファイル(output_YYYYMMDD_HHMMSS.avi)がカレントディレクトリに生成される.

4.5 ヒストグラム平坦化 (histogram equalization)

ヒストグラム平坦化は,モノクロ画像のコントラストを改善する手法である.

USB接続できるビデオカメラを準備し,パソコンに接続しておく.

* 止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

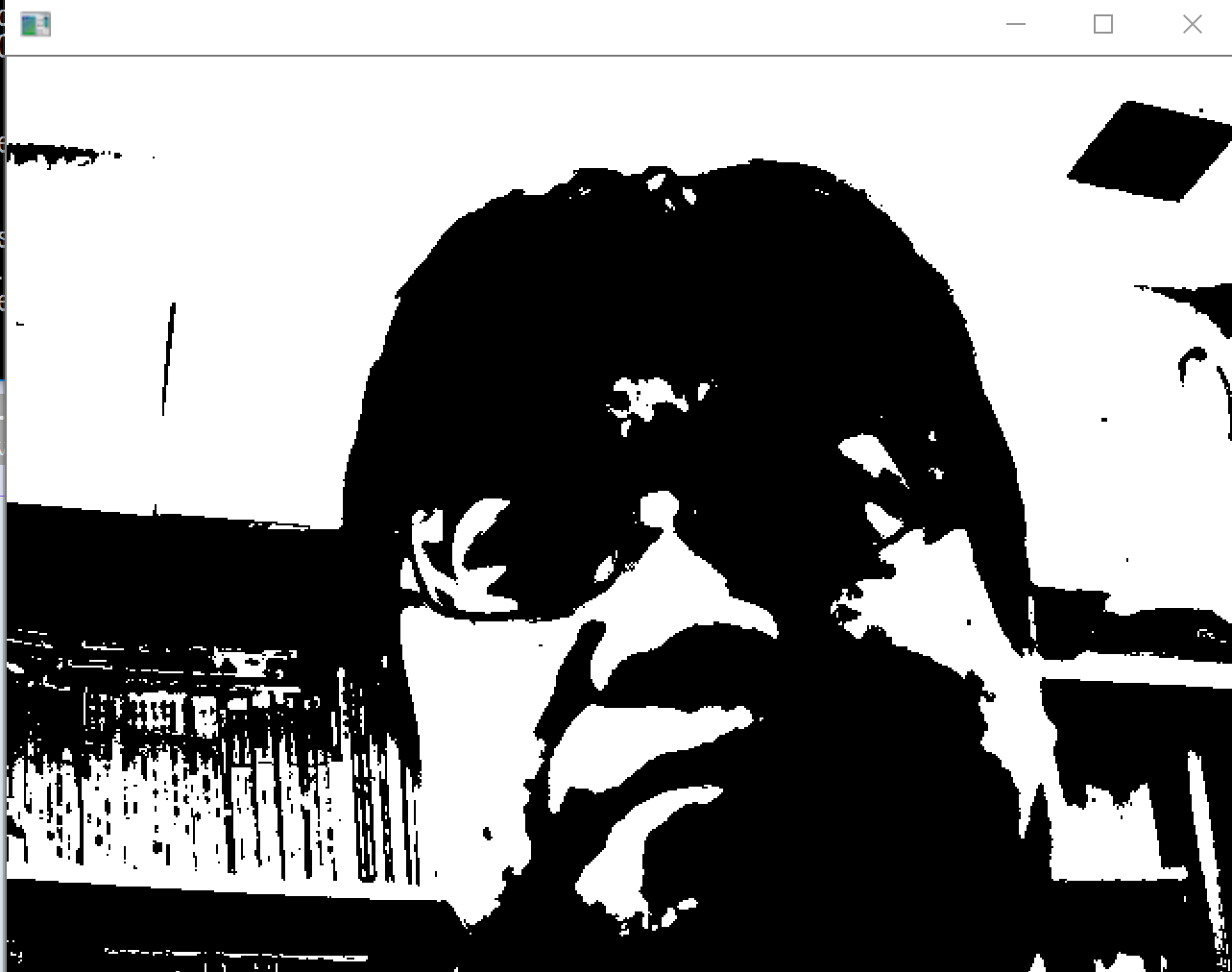

4.6 2値化

USB接続できるビデオカメラを準備し,パソコンに接続しておく.

止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

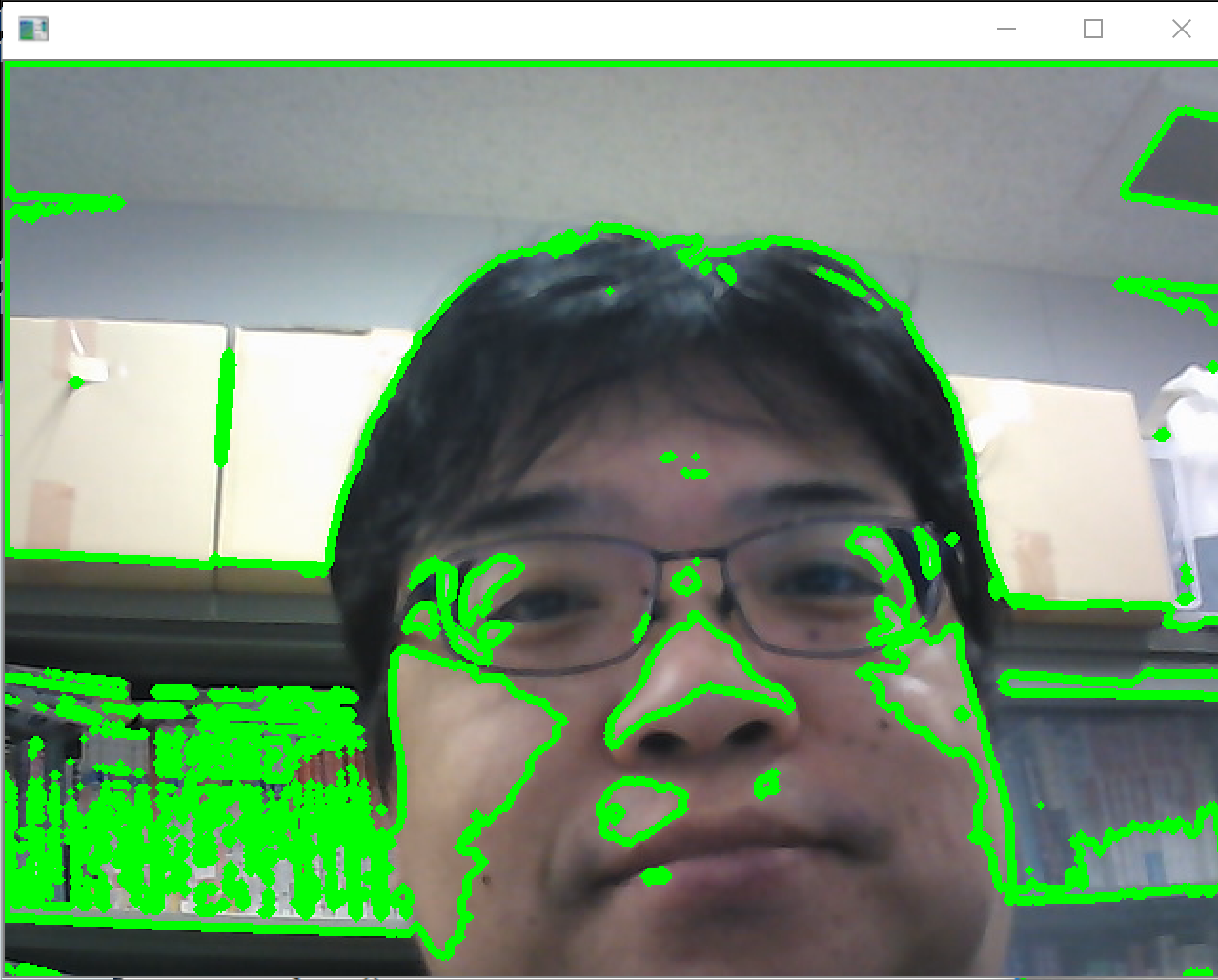

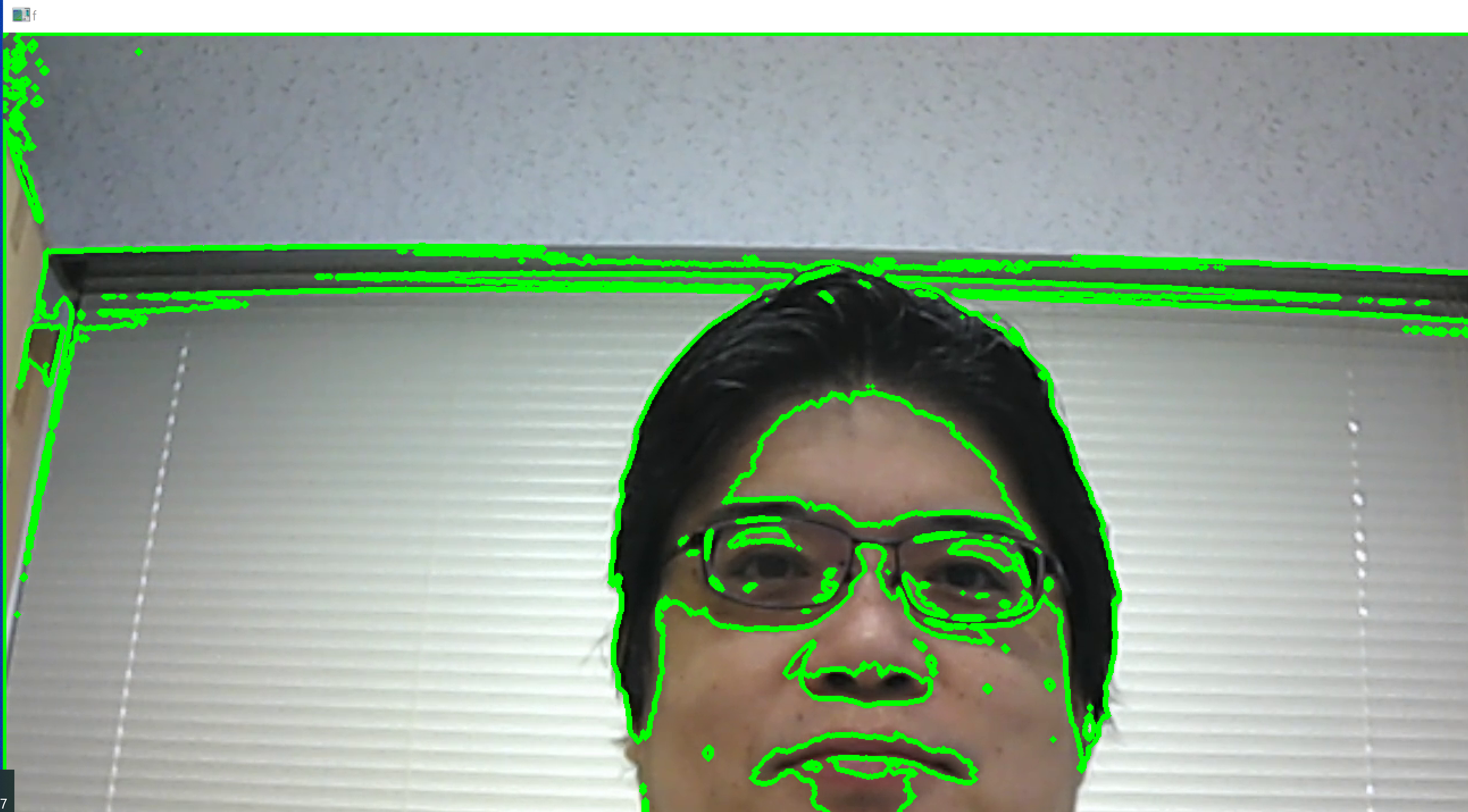

4.7 輪郭抽出

USB接続できるビデオカメラを準備し,パソコンに接続しておく.

止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

4.8 動画ファイルを使って試す

4.8.1 動画ファイルの準備

ここで使用する動画ファイル:sample1.mp4

ダウンロード方法: Windows でコマンドプロンプトを管理者として開き,次のコマンドを実行する.

mkdir c:\image

cd c:\image

curl -O https://www.kkaneko.jp/sample/face/sample1.mp4

上のコマンドがうまく実行できないときは, sample1.mp4 をダウンロードし,C:/image に置いておく.

4.8.2 OTSU の方法による2値化

* 止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

4.8.3 輪郭抽出

ここでの輪郭抽出は,2値化の結果を利用して輪郭を抽出している.

* 止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

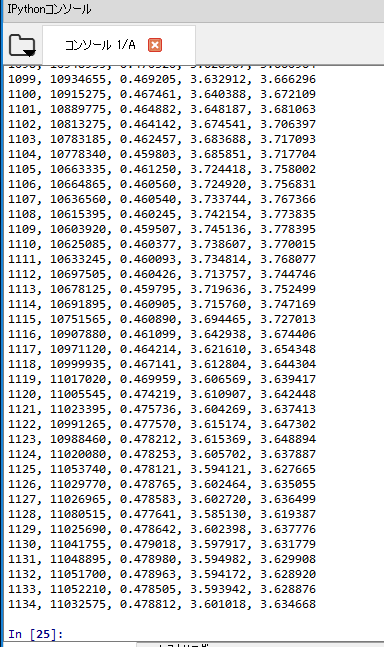

4.8.4 OTSU の方法による2値化のあと,数え上げと画素値の平均

次の処理を行う.

- OTSU の方法による2値化の結果,「白色」となった画素数を数える

- Lab 色空間を用いて,L成分,a成分,b成分の平均をフレームごとに求める.平均の分母は,OTSU 2値化で「白色」となった画素数である.

* 止めたいとき,右上の「x」をクリックしない.画面の中をクリックしてから,「q」のキーを押して閉じる

出力の各列は次のとおりである.1列目:フレーム番号,2列目:白色画素数,3列目:L成分の平均,4列目:a成分の平均,5列目:b成分の平均

5. ソースコード

5.1 カメラ画像の表示

import cv2

v = cv2.VideoCapture(0)

prev_time = cv2.getTickCount()

while True:

r, f = v.read()

current_time = cv2.getTickCount()

fps = cv2.getTickFrequency() / (current_time - prev_time)

prev_time = current_time

cv2.putText(f, f"FPS: {fps:.1f}", (10, 30), cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 255, 0), 2)

cv2.imshow("カメラ映像", f)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

5.2 表示サイズを変える

import cv2

resize_width = 640

def resize_frame(frame, width):

height = int(frame.shape[0] * (width / float(frame.shape[1])))

return cv2.resize(frame, (width, height), interpolation=cv2.INTER_AREA)

v = cv2.VideoCapture(0)

while True:

r, f = v.read()

resized_frame = resize_frame(f, resize_width)

cv2.imshow("カメラ映像", resized_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

5.3 カラー画像から濃淡画像への変換

import cv2

resize_width = 640

def resize_frame(frame, width):

height = int(frame.shape[0] * (width / float(frame.shape[1])))

return cv2.resize(frame, (width, height), interpolation=cv2.INTER_AREA)

v = cv2.VideoCapture(0)

while True:

r, f = v.read()

resized_frame = resize_frame(f, resize_width)

gray_frame = cv2.cvtColor(resized_frame, cv2.COLOR_BGR2GRAY)

cv2.imshow("カラーカメラ映像", resized_frame)

cv2.imshow("濃淡カメラ映像", gray_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

5.4 動画ファイルの書き出し

import cv2

import time

display_width = 640

def resize_frame(frame, width):

height = int(frame.shape[0] * (width / float(frame.shape[1])))

return cv2.resize(frame, (width, height), interpolation=cv2.INTER_AREA)

v = cv2.VideoCapture(0)

fps = 20.0

frame_width = int(v.get(cv2.CAP_PROP_FRAME_WIDTH))

frame_height = int(v.get(cv2.CAP_PROP_FRAME_HEIGHT))

output_filename = f"output_{time.strftime('%Y%m%d_%H%M%S')}.avi"

fourcc = cv2.VideoWriter_fourcc(*'XVID')

video_writer = cv2.VideoWriter(output_filename, fourcc, fps, (frame_width, frame_height))

print(f"録画を開始します: {output_filename}")

while True:

r, f = v.read()

video_writer.write(f)

display_frame = resize_frame(f, display_width)

cv2.imshow("カメラ映像", display_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

video_writer.release()

cv2.destroyAllWindows()

print(f"録画を終了しました: {output_filename}")

5.5 ヒストグラム平坦化 (histogram equalization)

import cv2

import numpy as np

resize_width = 640

def resize_frame(frame, width):

height = int(frame.shape[0] * (width / float(frame.shape[1])))

return cv2.resize(frame, (width, height), interpolation=cv2.INTER_AREA)

v = cv2.VideoCapture(0)

clahe = cv2.createCLAHE(clipLimit=2.0, tileGridSize=(8, 8))

while True:

r, f = v.read()

resized_frame = resize_frame(f, resize_width)

gray = cv2.cvtColor(resized_frame, cv2.COLOR_BGR2GRAY)

equalized = clahe.apply(gray)

combined_frame = np.hstack((gray, equalized))

cv2.imshow("Original vs Equalized", combined_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

5.6 2値化

import cv2

import numpy as np

resize_width = 640

def resize_frame(frame, width):

height = int(frame.shape[0] * (width / float(frame.shape[1])))

return cv2.resize(frame, (width, height), interpolation=cv2.INTER_AREA)

v = cv2.VideoCapture(0)

while True:

r, f = v.read()

resized_frame = resize_frame(f, resize_width)

gray = cv2.cvtColor(resized_frame, cv2.COLOR_BGR2GRAY)

binary = cv2.adaptiveThreshold(gray, 255, cv2.ADAPTIVE_THRESH_GAUSSIAN_C, cv2.THRESH_BINARY, 11, 2)

combined_frame = np.hstack((gray, binary))

cv2.imshow("Original vs Binary", combined_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

5.7 輪郭抽出

import cv2

import numpy as np

resize_width = 640

def resize_frame(frame, width):

height = int(frame.shape[0] * (width / float(frame.shape[1])))

return cv2.resize(frame, (width, height), interpolation=cv2.INTER_AREA)

v = cv2.VideoCapture(0)

while True:

r, f = v.read()

resized_frame = resize_frame(f, resize_width)

gray = cv2.cvtColor(resized_frame, cv2.COLOR_BGR2GRAY)

edges = cv2.Canny(gray, 100, 200)

contours, _ = cv2.findContours(edges, cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

contour_image = np.zeros_like(resized_frame)

cv2.drawContours(contour_image, contours, -1, (0, 255, 0), 2)

cv2.putText(contour_image, f"Contours: {len(contours)}", (10, 30), cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 255, 0), 2)

combined_frame = np.hstack((resized_frame, contour_image))

cv2.imshow("Original vs Contours", combined_frame)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

5.8 OTSU の方法による2値化(動画ファイル)

import os

import cv2

IMROOT = os.environ['LOCALAPPDATA'] + '/'

v = cv2.VideoCapture(IMROOT + 'sample1.mp4')

while v.isOpened():

r, f = v.read()

if r == False:

break

mono = cv2.cvtColor(f, cv2.COLOR_BGR2GRAY)

_, dst = cv2.threshold(mono, 0, 255, cv2.THRESH_OTSU)

cv2.imshow("f", f)

cv2.imshow("dst", dst)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

5.9 輪郭抽出(動画ファイル)

import os

import cv2

IMROOT = os.environ['LOCALAPPDATA'] + '/'

v = cv2.VideoCapture(IMROOT + 'sample1.mp4')

while v.isOpened():

r, f = v.read()

if r == False:

break

mono = cv2.cvtColor(f, cv2.COLOR_BGR2GRAY)

_, dst = cv2.threshold(mono, 0, 255, cv2.THRESH_OTSU)

contours, hierarchy = cv2.findContours(dst, cv2.RETR_TREE, cv2.CHAIN_APPROX_SIMPLE)

cv2.drawContours(f, contours, -1, (0, 255, 0), 3)

cv2.imshow("f", f)

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

cv2.destroyAllWindows()

5.10 OTSU の方法による2値化のあと,数え上げと画素値の平均

import os

import numpy as np

import cv2

IMROOT = os.environ['LOCALAPPDATA'] + '/'

v = cv2.VideoCapture(IMROOT + 'sample1.mp4')

i = 0

res = open(IMROOT + 'result.csv', mode='a')

while v.isOpened():

r, f = v.read()

if r == False:

break

mono = cv2.cvtColor(f, cv2.COLOR_BGR2GRAY)

_, dst = cv2.threshold(mono, 0, 255, cv2.THRESH_OTSU)

lab = cv2.cvtColor(f, cv2.COLOR_BGR2LAB)

cv2.imshow("f", f)

cv2.imshow("dst", dst)

cv2.imshow("L", lab[:,:,0])

cv2.imshow("A", lab[:,:,1])

cv2.imshow("B", lab[:,:,2])

total = np.sum(dst)

print("%d, %d, %f, %f, %f" % (i, total, np.sum(lab[:,:,0])/total, np.sum(lab[:,:,1])/total, np.sum(lab[:,:,2])/total))

res.write("%d, %d, %f, %f, %f\n" % (i, total, np.sum(lab[:,:,0])/total, np.sum(lab[:,:,1])/total, np.sum(lab[:,:,2])/total))

i = i + 1

if cv2.waitKey(1) & 0xFF == ord('q'):

break

v.release()

res.close()

cv2.destroyAllWindows()

6. まとめ

6.1 リアルタイムカメラ映像の取得と表示

cv2.VideoCapture でカメラからリアルタイムに映像を取得し,cv2.imshow で表示する.resize_frame 関数によりアスペクト比を保持したまま指定幅にリサイズできる.

6.2 濃淡画像変換とヒストグラム平坦化

cv2.cvtColor でカラー画像を濃淡画像に変換する.ヒストグラム平坦化はモノクロ画像のコントラストを改善する手法であり,CLAHE を適用して実現する.

6.3 2値化と輪郭抽出

適応的閾値処理(cv2.adaptiveThreshold)と OTSU の方法(cv2.THRESH_OTSU)による2値化を扱った.輪郭抽出では,Canny エッジ検出や2値化結果から cv2.findContours で輪郭を検出し,cv2.drawContours で描画する.

6.4 動画ファイルの書き出し

cv2.VideoWriter を用いて,カメラから取得したフレームを XVID コーデックの AVI ファイルとして書き出す.表示用にはリサイズしたフレームを使用し,ファイルにはオリジナル解像度のフレームを書き込む.

6.5 動画ファイルからの画素値統計

OTSU 2値化で「白色」となった画素数を数え,Lab 色空間の L・a・b 各成分の平均をフレームごとに計算する.結果は CSV ファイルに書き出される.

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)