FlexGen のインストールと動作確認(大規模言語モデル,チャットボット)(Python,PyTorch を使用)(Windows 上)

FlexGen のインストールと動作確認を行う.

FlexGen

FlexGen は,大規模言語モデル (large language model)を用いた推論で必要とされる計算とメモリの要求を削減する技術. 実験では,大規模言語モデル OPTOPT-175B を,16GB の単一 GPU で実行したとき 100倍以上の高速化が可能であるとされている.

【文献】 Ying Sheng, Lianmin Zheng, Binhang Yuan, Zhuohan Li, Max Ryabinin, Beidi Chen, Percy Liang, Ce Zhang, Ion Stoica, Christopher Ré., High-throughput Generative Inference of Large Language Model with a Single GPU, 2023.

PDF ファイル: https://github.com/FMInference/FlexiGen/blob/main/docs/paper.md

【サイト内の関連ページ】

- Meta の言語モデルと日本語で対話できる chatBOT プログラム(chatBOT)(FlexGen, DeepL, Python を使用)(Windows 上): 別ページ »で説明

- 対話システム,chatBOT: PDFファイル, パワーポイントファイル

【関連する外部ページ】

FlexGen の GitHub のページ: https://github.com/FMInference/FlexGen

【関連項目】 OPT

前準備

Build Tools for Visual Studio 2022 (ビルドツール for Visual Studio 2022)または Visual Studio 2022 のインストール(Windows 上)

【インストールの判断】 Build Tools for Visual Studio は,開発ツールセットである. Visual Studio は統合開発環境であり,いくつかの種類があり,Build Tools for Visual Studioの機能を含むか連携して使用するものである.インストールは以下の基準で判断してください:

- Build Tools for Visual Studio の機能のみが必要な場合

- Visual Studio の機能が必要である,あるいは,よく分からない場合

Visual Studio 2022 をインストールする際に,「C++ によるデスクトップ開発」を選択することで, Build Tools for Visual Studio 2022 の機能も一緒にインストールされる.

不明な点がある場合は,Visual Studio 全体をインストール を行う方が良い.

Build Tools for Visual Studio 2022 のインストール(Windows 上)

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。次のコマンドを実行

次のコマンドは,Build Tools for Visual Studio 2022と VC2015 再配布可能パッケージをインストールするものである.

winget install --scope machine Microsoft.VisualStudio.2022.BuildTools winget install --scope machine Microsoft.VCRedist.2015+.x64 - Build Tools for Visual Studio 2022 での C++ によるデスクトップ開発,CLI,ATL,MFC のインストール(Windows 上)

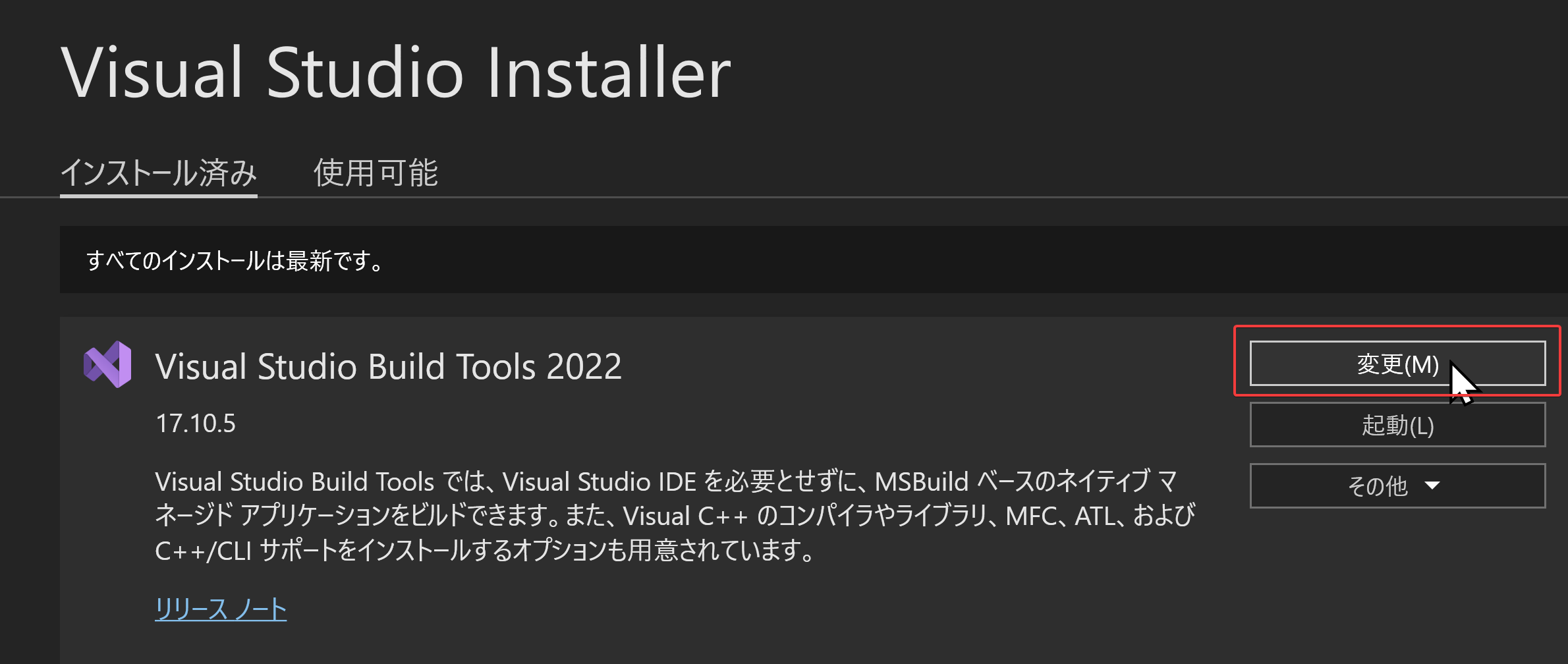

- Visual Studio Installer の起動

起動方法: スタートメニューの「Visual Studio Installer」を選ぶ.

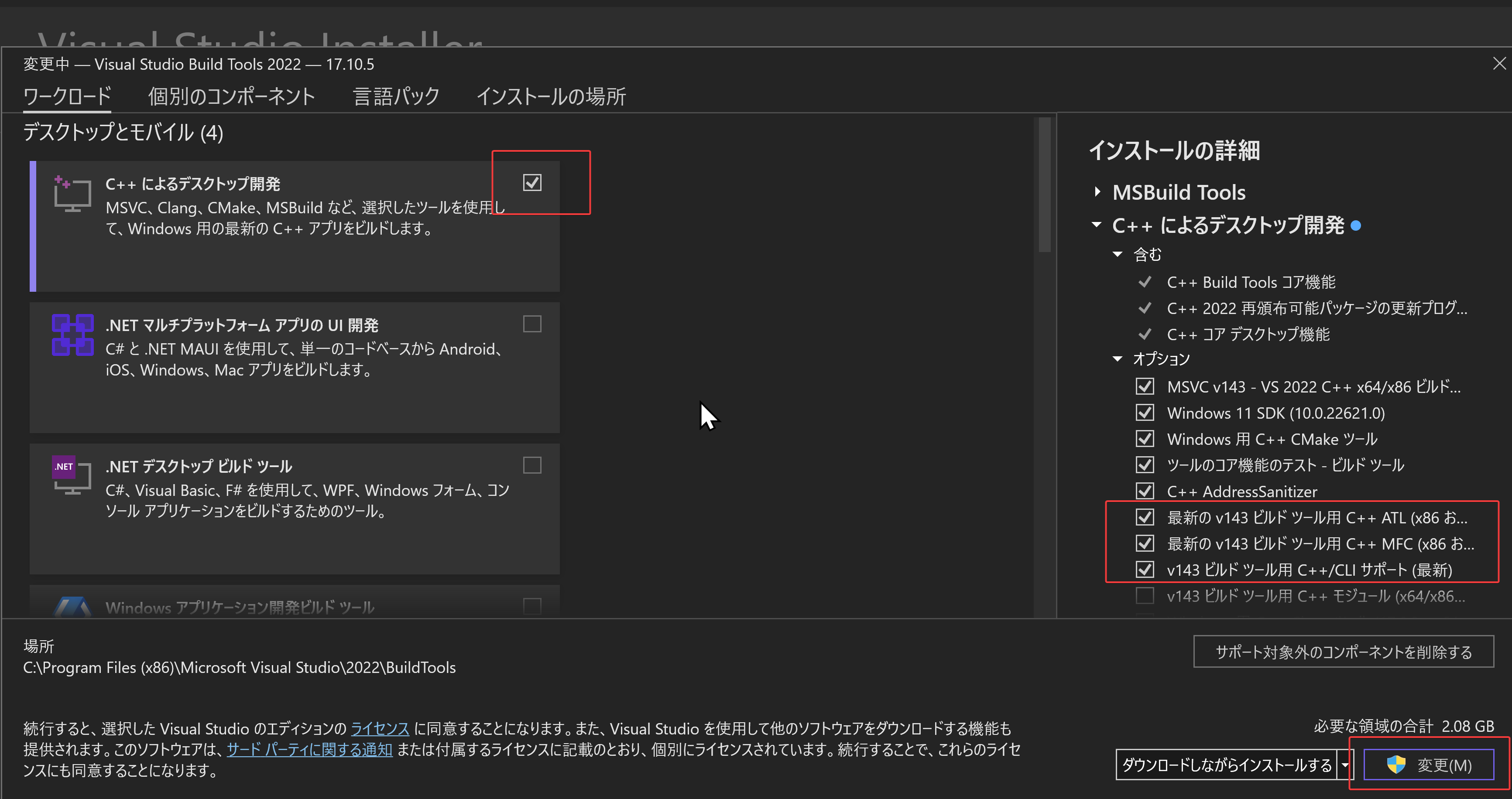

- Visual Studio Build Tools 2022 で「変更」を選ぶ.

- 「C++ によるデスクトップ開発」をクリック.そして,画面右側の「インストール」の詳細で「v143 ビルドツール用 C++/CLI サポート(最新)」,「ATL」,「MFC」をチェックする.その後,「変更」をクリック.

- Visual Studio Installer の起動

Visual Studio のインストール(Windows 上)

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。次のコマンドを実行

- 管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。 - インストールコマンドの実行

winget install Microsoft.VisualStudio.2022.Community --scope machine --override "--add Microsoft.VisualStudio.Workload.NativeDesktop Microsoft.VisualStudio.ComponentGroup.NativeDesktop.Core Microsoft.VisualStudio.Component.VC.CLI.Support Microsoft.VisualStudio.Component.CoreEditor Microsoft.VisualStudio.Component.NuGet Microsoft.VisualStudio.Component.Roslyn.Compiler Microsoft.VisualStudio.Component.TextTemplating Microsoft.VisualStudio.Component.Windows.SDK.Latest Microsoft.VisualStudio.Component.VC.Tools.x86.x64 Microsoft.VisualStudio.Component.VC.ATL Microsoft.VisualStudio.Component.VC.ATLMFC" winget install Microsoft.VisualStudio.2022.Community --scope machine Microsoft.VCRedist.2015+.x64インストールされるコンポーネントの説明:

NativeDesktop:C++によるデスクトップアプリケーション開発のためのワークロード一式NativeDesktop.Core:C++デスクトップ開発に必要な基本コンポーネント群VC.CLI.Support:マネージドコードとネイティブコードの統合開発を可能にするC++/CLIサポートCoreEditor:コード編集,デバッグ,検索などの基本機能を提供するVisual StudioのコアエディタNuGet:.NETライブラリの依存関係を管理するパッケージ管理システムWindows.SDK.Latest:Windows 向けアプリケーション開発用SDK(Software Development Kit)VC.Tools.x86.x64:32ビット及び64ビット向けC++コンパイラとビルドツールVC.ATL:Windowsコンポーネント開発用のActive Template LibraryVC.ATLMFC:デスクトップアプリケーション開発用のMicrosoft Foundation Class Library

システム要件と注意事項:

- 管理者権限でのインストールが必須

- 必要ディスク容量:10GB以上

- 推奨メモリ:8GB以上のRAM

- インストール過程でシステムの再起動が要求される可能性がある

- 安定したインターネット接続環境が必要

追加のコンポーネントが必要な場合は,Visual Studio Installerを使用して個別にインストールすることが可能である.

- インストール完了の確認

winget list Microsoft.VisualStudio.2022.Communityトラブルシューティング:

インストール失敗時は,以下のログファイルを確認:

%TEMP%\dd_setup_<timestamp>.log %TEMP%\dd_bootstrapper_<timestamp>.log

- 管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

- Visual Studio での C++ によるデスクトップ開発,CLI のインストール(Windows 上)

- Visual Studio Installer の起動

起動方法: スタートメニューの「Visual Studio Installer」を選ぶ.

- Visual Studio Community 2022 で「変更」を選ぶ.

- 「C++ によるデスクトップ開発」をチェック.そして,画面右側の「インストール」の詳細で「v143 ビルドツール用 C++/CLI サポート(最新)」をチェックする.その後,「インストール」をクリック.

- Visual Studio Installer の起動

Python 3.12,Git のインストール(Windows 上)

Pythonは,プログラミング言語の1つ. Gitは,分散型のバージョン管理システム.

【手順】

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。次のコマンドを実行

次のコマンドは,Python ランチャーとPython 3.12とGitをインストールし,Gitにパスを通すものである.

次のコマンドでインストールされるGitは 「git for Windows」と呼ばれるものであり, Git,MinGW などから構成されている.

reg add "HKLM\SYSTEM\CurrentControlSet\Control\FileSystem" /v LongPathsEnabled /t REG_DWORD /d 1 /f REM Python, Git をシステム領域にインストール winget install --scope machine --id Python.Python.3.12 --id Python.Launcher --id Git.Git -e --silent REM Python のパス set "INSTALL_PATH=C:\Program Files\Python312" echo "%PATH%" | find /i "%INSTALL_PATH%" >nul if errorlevel 1 setx PATH "%PATH%;%INSTALL_PATH%" /M >nul echo "%PATH%" | find /i "%INSTALL_PATH%\Scripts" >nul if errorlevel 1 setx PATH "%PATH%;%INSTALL_PATH%\Scripts" /M >nul REM Git のパス set "NEW_PATH=C:\Program Files\Git\cmd" if exist "%NEW_PATH%" echo "%PATH%" | find /i "%NEW_PATH%" >nul if exist "%NEW_PATH%" if errorlevel 1 setx PATH "%PATH%;%NEW_PATH%" /M >nul

【関連する外部ページ】

- Python の公式ページ: https://www.python.org/

- Git の公式ページ: https://git-scm.com/

【サイト内の関連ページ】

【関連項目】 Python, Git バージョン管理システム, Git の利用

Build Tools for Visual Studio 2022,NVIDIA ドライバ,NVIDIA CUDA ツールキット 11.8,NVIDIA cuDNN 8.9.7 のインストール(Windows 上)

【サイト内の関連ページ】 NVIDIA グラフィックスボードを搭載しているパソコンの場合には, NVIDIA ドライバ, NVIDIA CUDA ツールキット, NVIDIA cuDNN のインストールを行う.

- Windows での Build Tools for Visual Studio 2022 のインストール: 別ページ »で説明

- Windows での NVIDIA ドライバ,NVIDIA CUDA ツールキット 11.8,NVIDIA cuDNN v8.9.7 のインストール手順: 別ページ »で説明

【関連する外部ページ】

- Build Tools for Visual Studio 2022 (ビルドツール for Visual Studio 2022)の公式ダウンロードページ: https://visualstudio.microsoft.com/ja/visual-cpp-build-tools/

- NVIDIA ドライバのダウンロードの公式ページ: https://www.nvidia.co.jp/Download/index.aspx?lang=jp

- NVIDIA CUDA ツールキットのアーカイブの公式ページ: https://developer.nvidia.com/cuda-toolkit-archive

- NVIDIA cuDNN のダウンロードの公式ページ: https://developer.nvidia.com/cudnn

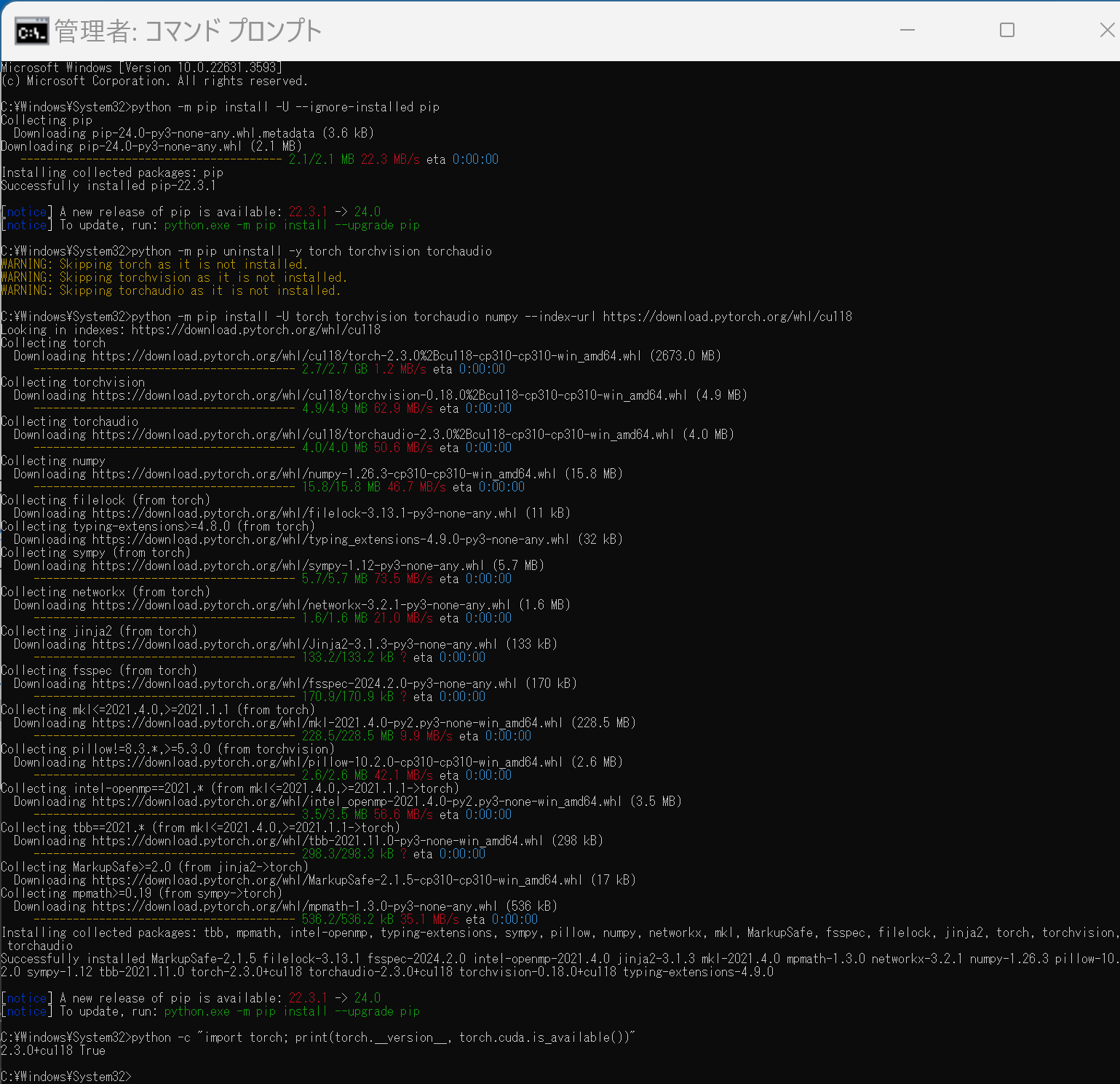

PyTorch のインストール(Windows 上)

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。 - PyTorch のページを確認

- 次のようなコマンドを実行(実行するコマンドは,PyTorch のページの表示されるコマンドを使う).

次のコマンドを実行することにより, PyTorch 2.3 (NVIDIA CUDA 11.8 用)がインストールされる. 但し,Anaconda3を使いたい場合には別手順になる.

事前に NVIDIA CUDA のバージョンを確認しておくこと(ここでは,NVIDIA CUDA ツールキット 11.8 が前もってインストール済みであるとする).

PyTorch で,GPU が動作している場合には,「torch.cuda.is_available()」により,True が表示される.

python -m pip install -U --ignore-installed pip python -m pip uninstall -y torch torchvision torchaudio torchtext xformers python -m pip install -U torch torchvision torchaudio numpy --index-url https://download.pytorch.org/whl/cu118 python -c "import torch; print(torch.__version__, torch.cuda.is_available())"

Anaconda3を使いたい場合には, Anaconda プロンプト (Anaconda Prompt) を管理者として実行し, 次のコマンドを実行する. (PyTorch と NVIDIA CUDA との連携がうまくいかない可能性があるため,Anaconda3を使わないことも検討して欲しい).

conda install -y pytorch torchvision torchaudio pytorch-cuda=11.8 cudnn -c pytorch -c nvidia py -c "import torch; print(torch.__version__, torch.cuda.is_available())"【サイト内の関連ページ】

【関連する外部ページ】

FlexGen のインストール

公式ページ https://github.com/FMInference/FlexGen の記載に従う.

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

cmdと入力 > 右クリック > 「管理者として実行」)。 - ダウンロードとインストール

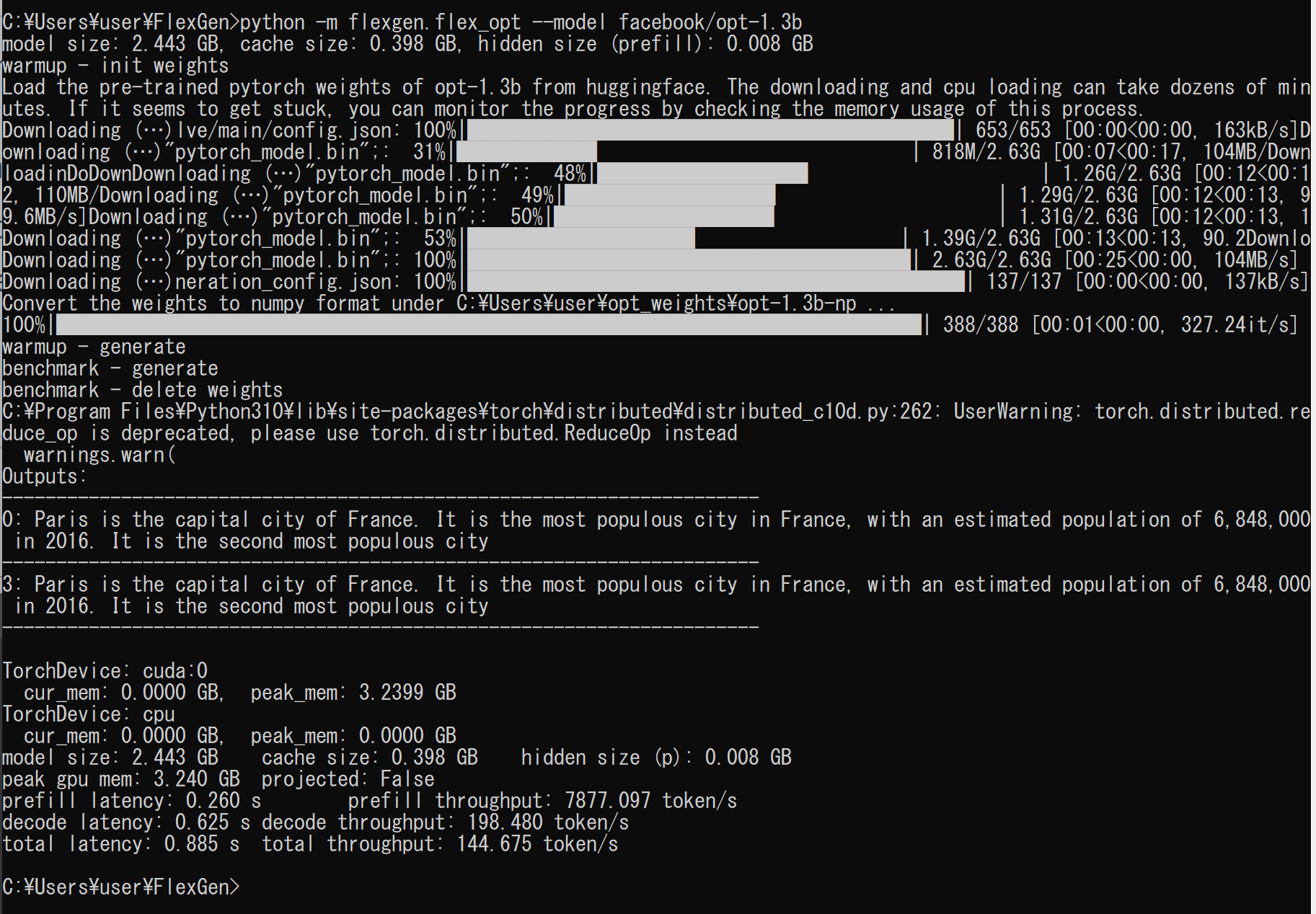

cd /d c:%HOMEPATH% rmdir /s /q FlexGen git clone https://github.com/FMInference/FlexGen.git cd FlexGen pip3 install -e . - 動作確認のため,OPT-1.3Bで実行してみる.

OPT (Open Pre-Trained Transformer) は,事前学習済みの大規模言語モデル (large language model) である.GitHub のページでは,OPT-125M, OPT-350M, OPT-1.3B, OPT-2.7B, OPT-6.7B, OPT-13B, OPT-30B, OPT-66B, OPT-175B が公開されている.

実行の結果,エラーメッセージが出ないことを確認

python -m flexgen.flex_opt --model facebook/opt-1.3b

チャットボットを動かす(FlexGen,OPT を使用)(Windows 上)

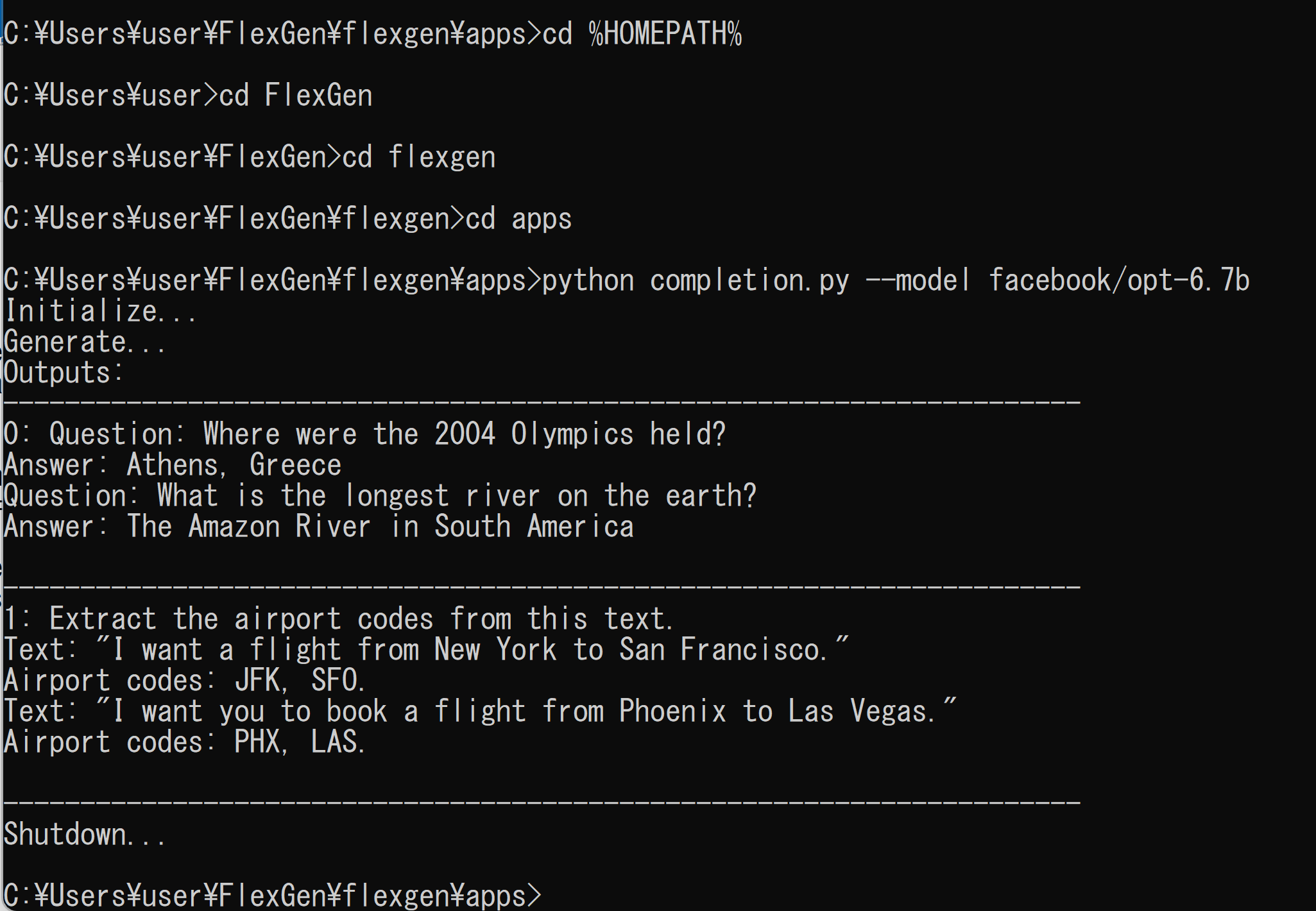

次のコマンドを実行する.プログラム中にプロンプトが記載されている. プログラムの実行により,プロンプトと,回答が表示される.

英語,中国語に対応しているようである.

OPT (Open Pre-Trained Transformer) は,事前学習済みの大規模言語モデル (large language model) である.GitHub のページでは,OPT-125M, OPT-350M, OPT-1.3B, OPT-2.7B, OPT-6.7B, OPT-13B, OPT-30B, OPT-66B, OPT-175B が公開されている.

- OPT-125M を使う場合

cd /d c:%HOMEPATH% cd FlexGen cd flexgen cd apps python completion.py --model facebook/opt-125m - OPT-6.7B を使う場合

OPT-125M より大きなメモリが必要.メモリが足りない場合には動かない

cd /d c:%HOMEPATH% cd FlexGen cd flexgen cd apps python completion.py --model facebook/opt-6.7b

日本語で使いたい場合のために,Meta の言語モデルと日本語で対話できる chatBOT プログラム(chatBOT)(FlexGen, DeepL, Python を使用)(Windows 上)を,別ページ »で説明

チャットボットに対話,音声合成を行う Python プログラム(FlexGen,OPT を使用)(Windows 上)

- Windows で,コマンドプロンプトを実行

- エディタを起動

cd /d c:%HOMEPATH% notepad qa.py - エディタで,次のプログラムを保存

"""Run a chatBOT with FlexGen and OPT models.""" import argparse import sys import win32com.client import flexgen from flexgen.flex_opt import (Policy, OptLM, ExecutionEnv, CompressionConfig, str2bool) from transformers import AutoTokenizer speech = win32com.client.Dispatch("Sapi.SpVoice") def main(args): # Initialize environment env = ExecutionEnv.create(args.offload_dir) # Offloading policy policy = Policy(1, 1, args.percent[0], args.percent[1], args.percent[2], args.percent[3], args.percent[4], args.percent[5], overlap=True, sep_layer=True, pin_weight=args.pin_weight, cpu_cache_compute=False, attn_sparsity=1.0, compress_weight=args.compress_weight, comp_weight_config=CompressionConfig( num_bits=4, group_size=64, group_dim=0, symmetric=False), compress_cache=args.compress_cache, comp_cache_config=CompressionConfig( num_bits=4, group_size=64, group_dim=2, symmetric=False)) # Model print("Initialize...") tokenizer = AutoTokenizer.from_pretrained("facebook/opt-30b", padding_side="left") tokenizer.add_bos_token = False stop = tokenizer("\n").input_ids[0] model = OptLM(args.model, env, args.path, policy) context = ( "A chat between a curious human and a knowledgeable artificial intelligence assistant.\n" "Human: Hello! What can you do?\n" "Assistant: As an AI assistant, I can answer questions and chat with you.\n" ) # Chat print(context, end="") while True: inp = input("Human: ") if not inp: print("exit...") break speech.Speak(inp) context += "Human: " + inp + "\n" inputs = tokenizer([context]) output_ids = model.generate( inputs.input_ids, do_sample=True, temperature=0.7, max_new_tokens=96, stop=stop) outputs = tokenizer.batch_decode(output_ids, skip_special_tokens=True)[0] try: index = outputs.index("\n", len(context)) except ValueError: outputs += "\n" index = outputs.index("\n", len(context)) outputs = outputs[:index + 1] print(outputs[len(context):], end="") speech.Speak(outputs[len(context):]) context = outputs # TODO: optimize the performance by reusing context cache and reducing redundant computation. # Shutdown env.close_copy_threads() if __name__ == "__main__": parser = argparse.ArgumentParser() parser.add_argument("--model", type=str, default="facebook/opt-6.7b", help="The model name.") parser.add_argument("--path", type=str, default="~/opt_weights", help="The path to the model weights. If there are no cached weights, " "FlexGen will automatically download them from HuggingFace.") parser.add_argument("--offload-dir", type=str, default="~/flexgen_offload_dir", help="The directory to offload tensors. ") parser.add_argument("--percent", nargs="+", type=int, default=[100, 0, 100, 0, 100, 0], help="Six numbers. They are " "the percentage of weight on GPU, " "the percentage of weight on CPU, " "the percentage of attention cache on GPU, " "the percentage of attention cache on CPU, " "the percentage of activations on GPU, " "the percentage of activations on CPU") parser.add_argument("--pin-weight", type=str2bool, nargs="?", const=True, default=True) parser.add_argument("--compress-weight", action="store_true", help="Whether to compress weight.") parser.add_argument("--compress-cache", action="store_true", help="Whether to compress cache.") args = parser.parse_args() assert len(args.percent) == 6 main(args) - プログラム実行

プログラムを qa.pyのようなファイル名で保存したので, 「python c.py --model facebook/opt-125m」のようなコマンドで行う.「opt-125m」のところは,使用するOPT言語モデル名を指定.

cd /d c:%HOMEPATH% python qa.py --model facebook/opt-125m

- Windows で,管理者権限でコマンドプロンプトを起動(手順:Windowsキーまたはスタートメニュー >

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)