【要約】

Grounding DINOは、Zero-Shot TransferとReferring Object Detectionに対応した高度な物体検出モデルである。このモデルはDINOとGrounded Pre-Trainingを組み合わせている。現在の実装では、Swin-TやSwin-Lをバックボーンとして使用している。Windows環境でのインストールは、GitHubからのリポジトリクローンと必要なパッケージのインストールで完了する。訓練済みモデルもダウンロード可能である。動作確認はPythonを用いて行い、指定したプロンプトに基づいての動作が可能である。さらに、画像選択ダイアログで画像を選択し、プロンプトも実行時にユーザーが指定できるPythonプログラムを示している。このページの手順により、Grounding DINOの基本的なセットアップと動作確認が簡単に行える。詳細は公式のGitHubページで確認できる。

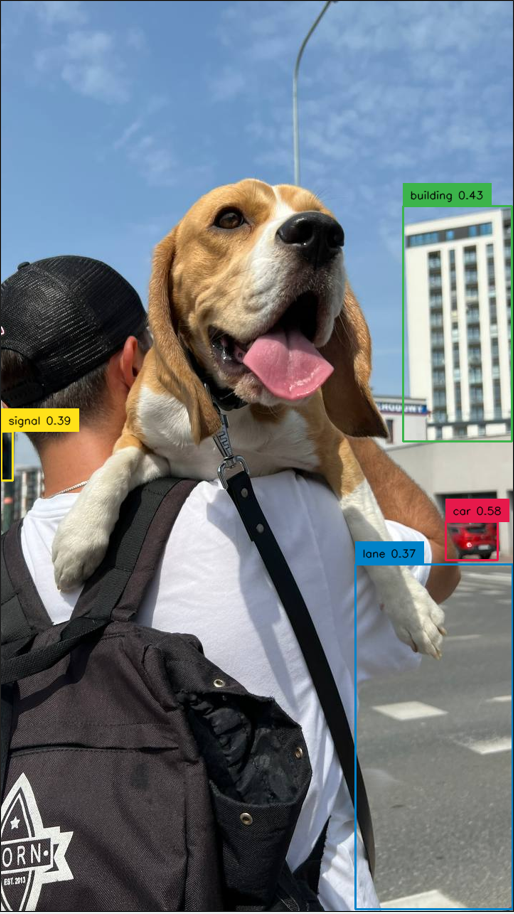

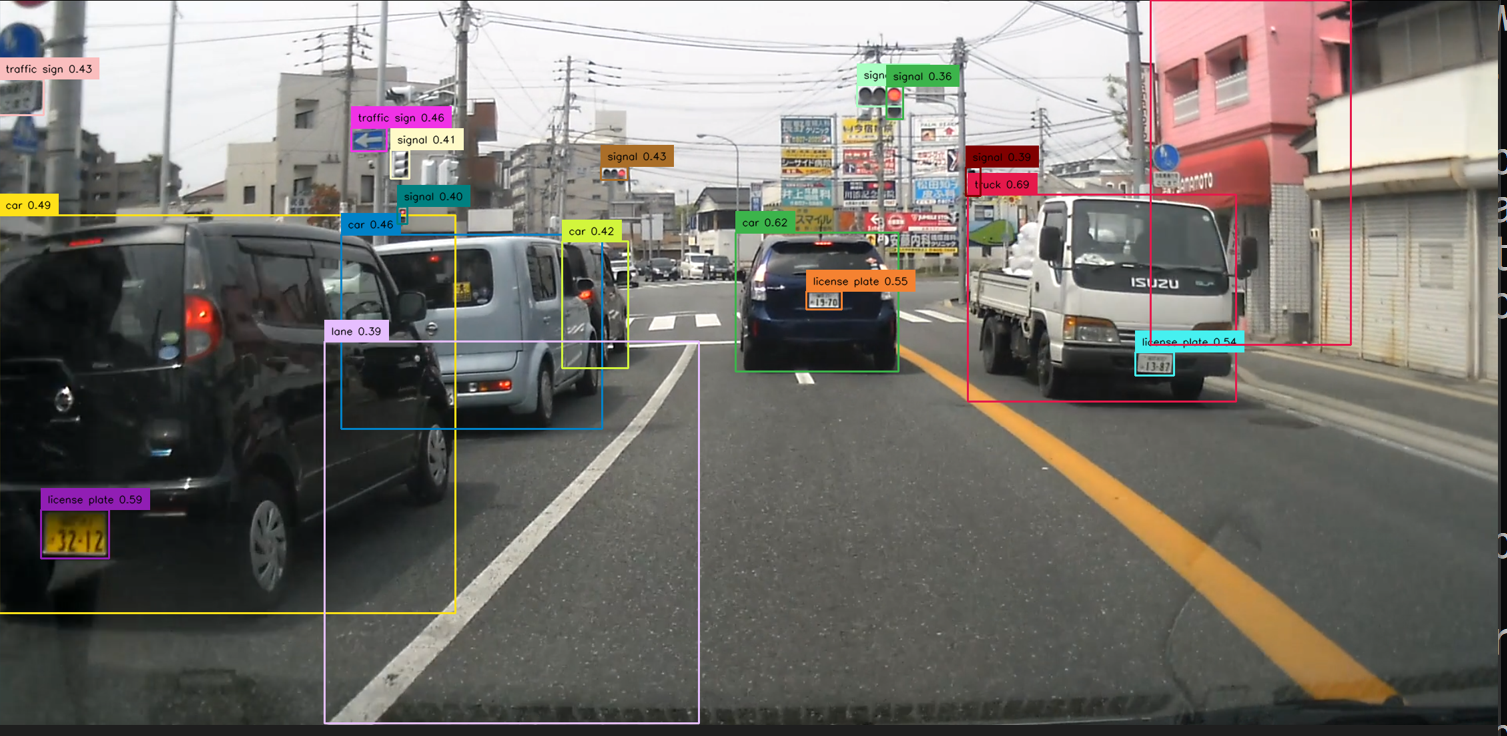

テキストのプロンプトとして,「building . car . signal . traffic sign」を指定したときの実行結果は次の通り.

【目次】

Grounding DINO は,Zero-Shot TransferとReferring Object Detectionという二つの物体検出タスクに対応している。精度向上のために、DINO(自己教師あり学習手法)とGrounded Pre-Trainingが組み合わされています。Grounding DINO の実験では、バックボーンとして、Swin-TやSwin-Lが採用された。実験結果では、Zero-Shot Transferのタスクで、Grounding DINOはDINOとGLIPを上回る高い精度を達成していることが示されている。

【文献】

Liu, Shilong and Zeng, Zhaoyang and Ren, Tianhe and Li, Feng and Zhang, Hao and Yang, Jie and Li, Chunyuan and Yang, Jianwei and Su, Hang and Zhu, Jun and others, Grounding dino: Marrying dino with grounded pre-training for open-set object detection, arXiv preprint arXiv:2303.05499, 2023.

https://arxiv.org/pdf/2303.05499v4.pdf

【関連する外部ページ】

Gitは,バージョン管理システム.ソースコードの管理や複数人での共同に役立つ.

【サイト内の関連ページ】

Windows での Git のインストール: 別ページ »で説明している.

【関連する外部ページ】

Git の公式ページ: https://git-scm.com/

【サイト内の関連ページ】

【関連する外部ページ】

Python の公式ページ: https://www.python.org/

【サイト内の関連ページ】

NVIDIA グラフィックスボードを搭載しているパソコンの場合には, NVIDIA ドライバ, NVIDIA CUDA ツールキット, NVIDIA cuDNN のインストールを行う.

【関連する外部ページ】

コマンドプロンプトを管理者として実行: 別ページ »で説明

PyTorch のページ: https://pytorch.org/index.html

次のコマンドは, PyTorch 2.0 (NVIDIA CUDA 11.8 用) をインストールする. 但し,Anaconda3を使いたい場合には別手順になる.

事前に NVIDIA CUDA のバージョンを確認しておくこと(ここでは,NVIDIA CUDA ツールキット 11.8 が前もってインストール済みであるとする).

PyTorch で,GPU が動作している場合には,「torch.cuda.is_available()」により,True が表示される.

python -m pip install -U --ignore-installed pip python -m pip install -U torch torchvision torchaudio numpy --index-url https://download.pytorch.org/whl/cu118 python -c "import torch; print(torch.__version__, torch.cuda.is_available())"

![[image]](../../tools/man/529.png)

Anaconda3を使いたい場合には, Anaconda プロンプト (Anaconda Prompt) を管理者として実行し, 次のコマンドを実行する. (PyTorch と NVIDIA CUDA との連携がうまくいかない可能性があるため,Anaconda3を使わないことも検討して欲しい).

conda install -y pytorch torchvision torchaudio pytorch-cuda=11.8 cudnn -c pytorch -c nvidia py -c "import torch; print(torch.__version__, torch.cuda.is_available())"

【サイト内の関連ページ】

【関連する外部ページ】

コマンドプロンプトを管理者として実行: 別ページ »で説明

cd %HOMEPATH% rmdir /s /q GroundingDINO git clone --recursive https://github.com/IDEA-Research/GroundingDINO.git cd GroundingDINO python -m pip install -r requirements.txt python setup.py develop mkdir weights cd weights curl -L -O https://media.roboflow.com/notebooks/examples/dog.jpeg curl -L -O https://media.roboflow.com/notebooks/examples/dog-2.jpeg curl -L -O https://media.roboflow.com/notebooks/examples/dog-3.jpeg curl -L -O https://media.roboflow.com/notebooks/examples/dog-4.jpeg curl -L -O https://github.com/IDEA-Research/GroundingDINO/releases/download/v0.1.0-alpha/groundingdino_swint_ogc.pth

エラーメッセージが出ていないこと.

![[image]](230.png)

Grounding DINO を用いて画像のアノテーションを行う.

cd %HOMEPATH%\GroundingDINO notepad c.py

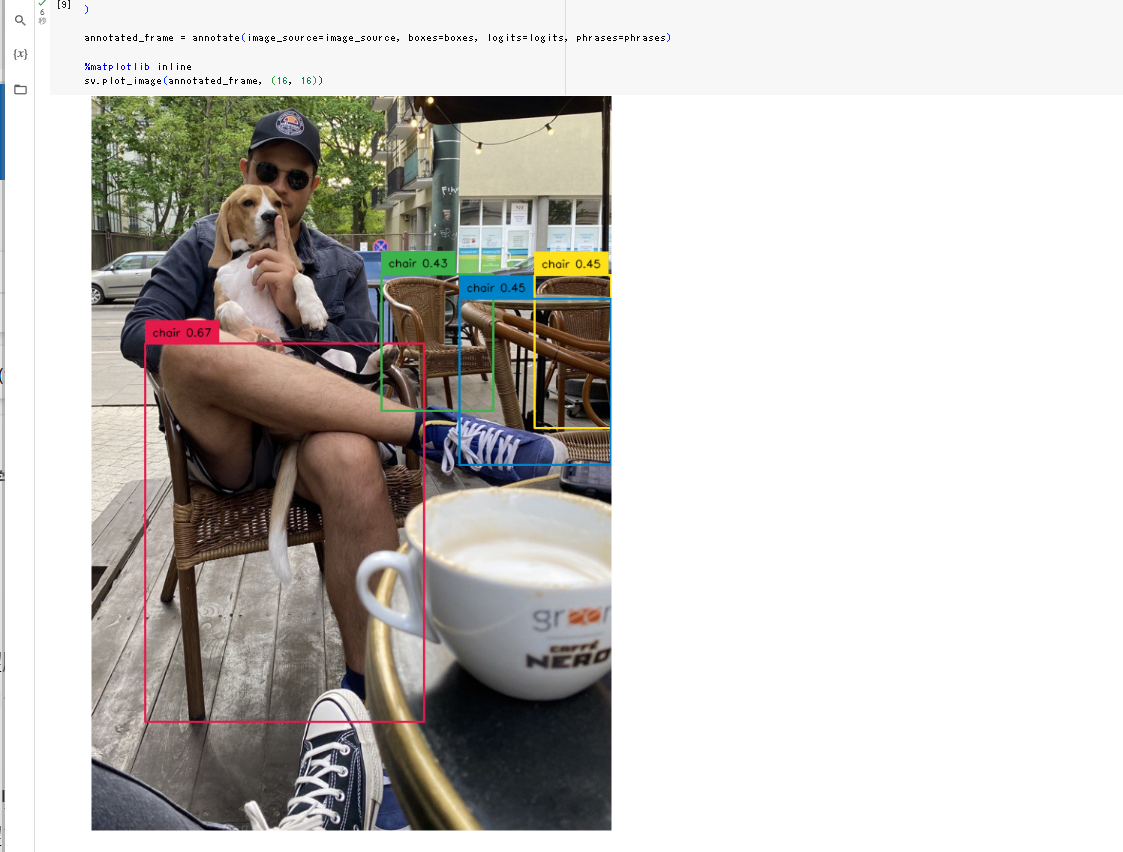

プロンプトとして,「TEXT_PROMPT = "chair . person . dog ."」のようにしている.

このプログラムは, 公式の GitHub のページ: https://github.com/idea-research/groundingdinoで公開されていたものを使用している.

from groundingdino.util.inference import load_model, load_image, predict, annotate

import cv2

model = load_model("groundingdino/config/GroundingDINO_SwinT_OGC.py", "weights/groundingdino_swint_ogc.pth")

IMAGE_PATH = "weights/dog-3.jpeg"

TEXT_PROMPT = "chair . person . dog ."

BOX_TRESHOLD = 0.35

TEXT_TRESHOLD = 0.25

image_source, image = load_image(IMAGE_PATH)

boxes, logits, phrases = predict(

model=model,

image=image,

caption=TEXT_PROMPT,

box_threshold=BOX_TRESHOLD,

text_threshold=TEXT_TRESHOLD

)

annotated_frame = annotate(image_source=image_source, boxes=boxes, logits=logits, phrases=phrases)

cv2.imwrite("annotated_image.jpg", annotated_frame)

![[image]](../../ai/win/231.png)

Python プログラムの実行

Python 開発環境(Jupyter Qt Console, Jupyter ノートブック (Jupyter Notebook), Jupyter Lab, Nteract, Spyder, PyCharm, PyScripterなど)も便利である.

Python のまとめ: 別ページ »にまとめ

プログラムを c.pyのようなファイル名で保存したので, 「python c.py」のようなコマンドで行う.

python c.py

![[image]](../../ai/win/232.png)

annotated_image.jpg

![[image]](../../ai/win/233.png)

![[image]](../../ai/win/234.png)

実行時に画像ファイルを選択する.画像ファイルは複数選択可能である.

cd %HOMEPATH%\GroundingDINO notepad d.py

このプログラムは, 公式の GitHub のページ: https://github.com/idea-research/groundingdinoで公開されていたものを変更して使用している.

from groundingdino.util.inference import load_model, load_image, predict, annotate

import cv2

from PIL import Image

model = load_model("groundingdino/config/GroundingDINO_SwinT_OGC.py", "weights/groundingdino_swint_ogc.pth")

TEXT_PROMPT = "building . car . signal . traffic sign"

BOX_TRESHOLD = 0.35

TEXT_TRESHOLD = 0.25

import tkinter as tk

from tkinter import filedialog

root = tk.Tk()

root.withdraw()

fpaths = filedialog.askopenfilenames()

for fpath in root.tk.splitlist(fpaths):

print("file name: ", fpath)

image_source, image = load_image(fpath)

boxes, logits, phrases = predict(

model=model,

image=image,

caption=TEXT_PROMPT,

box_threshold=BOX_TRESHOLD,

text_threshold=TEXT_TRESHOLD

)

annotated_frame = annotate(image_source=image_source, boxes=boxes, logits=logits, phrases=phrases)

Image.fromarray(cv2.cvtColor(annotated_frame, cv2.COLOR_BGR2RGB)).show()

![[image]](../../ai/win/235.png)

Python プログラムの実行

Python 開発環境(Jupyter Qt Console, Jupyter ノートブック (Jupyter Notebook), Jupyter Lab, Nteract, Spyder, PyCharm, PyScripterなど)も便利である.

Python のまとめ: 別ページ »にまとめ

プログラムを d.pyのようなファイル名で保存したので, 「python d.py」のようなコマンドで行う.

python d.py

ファイル選択画面が出るので,画像ファイルを選択する.ファイルは複数選択可能である.

![[image]](../../ai/win/236.png)

![[image]](../../ai/win/237.png)

![[image]](../../ai/win/238.png)

実行時に画像ファイルを選択する.画像ファイルは複数選択可能である. プロンプトも指定できる. プロンプトは,「building . car . signal . traffic sign」のように入れること.英語のみ.

cd %HOMEPATH%\GroundingDINO notepad e.py

このプログラムは, 公式の GitHub のページ: https://github.com/idea-research/groundingdinoで公開されていたものを変更して使用している.

from groundingdino.util.inference import load_model, load_image, predict, annotate

import cv2

from PIL import Image

model = load_model("groundingdino/config/GroundingDINO_SwinT_OGC.py", "weights/groundingdino_swint_ogc.pth")

BOX_TRESHOLD = 0.35

TEXT_TRESHOLD = 0.25

import tkinter as tk

from tkinter import filedialog

root = tk.Tk()

root.withdraw()

fpaths = filedialog.askopenfilenames()

print("please input text prompt")

print("for example, building . car . signal . traffic sign")

TEXT_PROMPT = input()

for fpath in root.tk.splitlist(fpaths):

print("file name: ", fpath)

image_source, image = load_image(fpath)

boxes, logits, phrases = predict(

model=model,

image=image,

caption=TEXT_PROMPT,

box_threshold=BOX_TRESHOLD,

text_threshold=TEXT_TRESHOLD

)

annotated_frame = annotate(image_source=image_source, boxes=boxes, logits=logits, phrases=phrases)

Image.fromarray(cv2.cvtColor(annotated_frame, cv2.COLOR_BGR2RGB)).show()

![[image]](../../ai/win/239.png)

Python プログラムの実行

Python 開発環境(Jupyter Qt Console, Jupyter ノートブック (Jupyter Notebook), Jupyter Lab, Nteract, Spyder, PyCharm, PyScripterなど)も便利である.

Python のまとめ: 別ページ »にまとめ

プログラムを e.pyのようなファイル名で保存したので, 「python e.py」のようなコマンドで行う.

python e.py

ファイル選択画面が出るので,画像ファイルを選択する.ファイルは複数選択可能である.

![[image]](../../ai/win/240.png)

テキストのプロンプトは,「building . car . signal . traffic sign」のように入れること.英語のみ.

![[image]](../../ai/win/241.png)

![[image]](../../ai/win/243.png)

![[image]](../../ai/win/244.png)