3. OpenCVによるコンピュータビジョン

OpenCV(オープンソースのコンピュータビジョンライブラリ)を用いた種々の処理である。

前準備

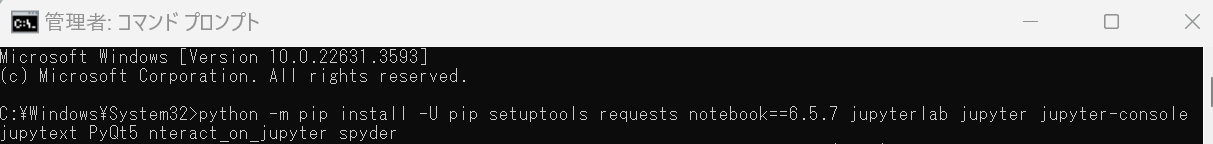

Python 3用opencv-python、matplotlib(Pythonのグラフ描画ライブラリ)、numpy(Pythonの数値計算用コアライブラリ)パッケージのインストールを行う。

Windowsパソコンで、コマンドプロンプトを開き、次のように操作する。

python -m pip install -U opencv-python matplotlib numpy

濃淡画像処理

Python + OpenCVで濃淡画像を使う。

トピックス:カラー画像から濃淡画像への変換、イメージヒストグラム(画像の輝度値分布グラフ)、ヒストグラム平坦化(画像コントラスト強調手法)、濃淡画像のノイズを加える、ノイズを除去する、OTSUの方法(大津の二値化、自動閾値決定法)による2値化、輪郭抽出(画像の物体境界線を見つける処理)。

説明資料: Python + OpenCVで濃淡画像を使う

点や線の描画

Python + OpenCVで点や線の描画を行う。

説明資料: OpenCVで点や線の描画(OpenCV 4.5対応)(Pythonを使用)

マウスイベント

説明資料:マウスイベント

ビデオカメラ画像処理

Python + OpenCVでビデオカメラ画像の表示、ファイル書き出し、濃淡画像処理を行う。

説明資料: Python + OpenCVでビデオカメラ画像の表示、ファイル書き出し、濃淡画像処理

フレーム間差分、トラッキングビジョン、オプティカルフロー

Python + OpenCVでビデオのフレーム間差分、トラッキングビジョン、オプティカルフロー(動画内の物体の見かけ上の動き)などを行う。

説明資料: Python + OpenCVでビデオのフレーム間差分、トラッキングビジョン、オプティカルフローなど

![[kaneko lab.]](https://www.kkaneko.jp/info/logo_png.png)